-

AI 是如何”读懂”文字的?Embedding白话解析

一、什么是 Embedding?简单来说:Embedding(嵌入),就是把词语、句子或任何类型的信息转化成一组数字(向量),使计算机能够理解并处理它们。就好像,把每个词汇或概念都“放置”(嵌入)到一个巨大的空间里,每个词都有自己独特的“位置”坐标(数字向量),距离越近的词含义越相似,距离越远则含义差别越大。举个例子:「猫」→ [0.5, 1.2, 0.3, …]「狗」→ [0.51, 1.19,…- 1

- 0

-

改进RAG:利用混合搜索与重排序优化检索效果(含代码示例)

RAG 通过结合信息检索和语言生成能力,让模型在生成文本时能够参考相关的外部知识,从而生成更准确、更具针对性的内容。然而,在实际应用中,RAG(企业 RAG 准确性提升全流程指南:从数据提取到精准检索) 面临着诸多挑战,其中准确检索相关信息是关键问题之一。本文将围绕如何通过混合搜索与重排序技术来提升 RAG 的检索效果展开深入探讨。一、RAG 检索面临的挑战在 RAG 的实际应用中,检索环节存在诸…- 9

- 0

-

检索增强生成(RAG)深度教程

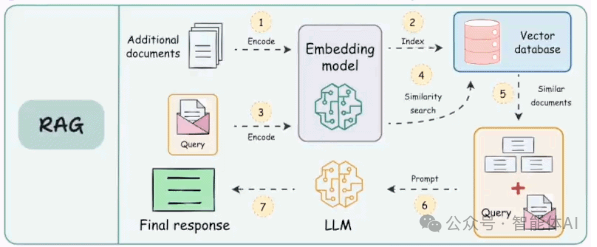

引言检索增强生成(Retrieval-Augmented Generation,简称 RAG)指在大型语言模型(LLM)的生成过程中,引入外部知识检索,以提高回答的准确性和可靠性。通过让LLM在生成回答时参考外部知识库的信息,RAG技术可以有效减少模型产生事实性错误(即所谓的“幻觉”)并提升答案的事实正确性。典型的RAG系统包含四个基本组件:嵌入模型、向量数据库、提示模板以及生成式LLM…- 6

- 0

-

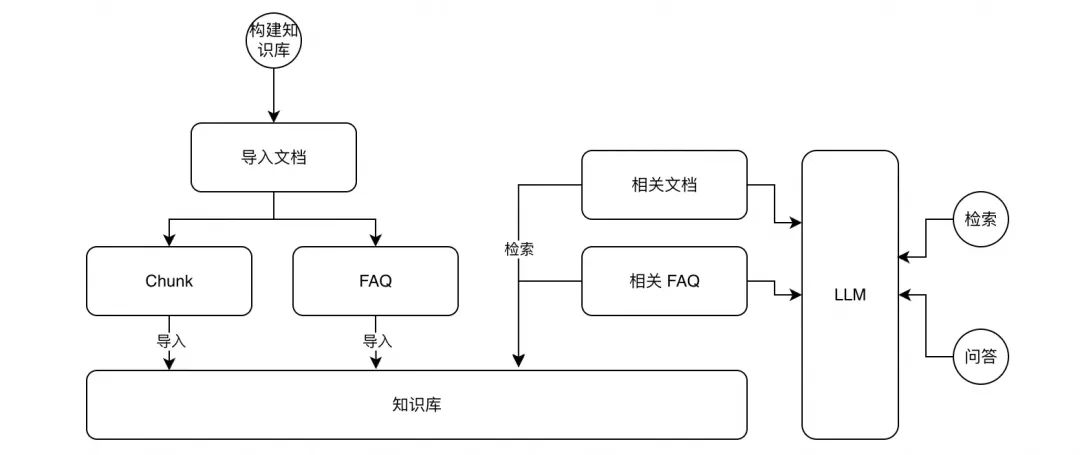

MCP 实践:基于 MCP 架构实现知识库答疑系统

前言业界推测 2025 年是 AI Agent 的元年,从目前的技术发展速度看确实是有这个趋势。从年初 DeepSeek 的爆火开始,目前开源大模型的能力基本与商业大模型拉齐甚至是超越,完全开放的开源策略让大模型的使用彻底平权。这个可以说在某种程度上改变了 AI 应用的商业模式,基于自训练的闭源模型的优势被显著削弱,商业竞争从模型性能转向对应用场景的创新。AI 应用的形态不断演进,从早期的 Cha…- 4

- 0

-

谈谈RAG 的四个级别

选择正确的 RAG(检索增强生成)架构主要取决于具体的用例和实施要求,确保系统符合任务需求。Agentic RAG 的重要性将日益增加,与Agentic X的概念相一致,其中代理能力嵌入个人助理和工作流程中。这里的“X”代表代理系统的无限适应性,能够实现无缝任务自动化和跨不同环境的明智决策,从而提高组织效率和自主性。综合不同的文档来源对于有效解决复杂、多部分的查询至关重要。一 概述提供准确的 RA…- 4

- 0

-

大模型能像专业分析师一样提取用户需求吗?

用户洞察从业人员经常把探索/洞察用户需求作为自己的核心价值,而且是比定量研究更难、更能体现用研能力。定性更能看出水平,对吧。现在看来,因为大模型擅长语言、文本理解,对于用户洞察常用的定性和定量研究方法来说,大模型能先做好的反而是定性研究。而定量研究,则因为需要看的维度不统一、要生成表格、图的格式也不统一等,反而在工作流上不如定性研究那么顺畅。今年 2 月份美国西北大学、MIT 预发表在arXiv …- 10

- 0

-

基于Embedding分块 – 文本分块(Text Splitting),RAG不可缺失的重要环节

-正文-SemanticChunker 是一种文本分块策略,旨在保持语义连贯性。它通过嵌入模型理解文本语义,与传统的字符分割方法相比, 更能保持段落的完整性。本文详细介绍了其原理、使用场景、优缺点及应用建议,帮助开发者选择最合适的文本分块策略,提升RAG应用的效率和准确性。1. SemanticChunker的主要用途2. 核心原理3. 流程图4. SemanticChunker的使用1. 初始化…- 14

- 0

-

RAG升级-基于知识图谱+deepseek打造强大的个人知识库问答机器人

近年来,RAG(Retrieval-Augmented Generation,检索增强生成)技术在人工智能领域掀起了一股热潮。随着大模型的快速发展,传统的纯生成式方法在面对复杂、多变的信息需求时,往往面临上下文有限、事实准确性不足等挑战。而RAG通过结合信息检索(Retrieval)与文本生成(Generation)两大核心能力,使模型能够在实时获取外部知识的基础上生成更精准、可信的内容。这一技术…- 7

- 0

-

RAG vs. CAG vs. Fine-Tuning:如何为你的大语言模型选择最合适的“脑力升级”?

每个使用过LLM的人都会发现一个残酷的现实:这些看似全能的模型,有时会给出过时的信息,偶尔会“自信满满”地编造事实(即“幻觉”问题),甚至对某些专业领域的问题表现得一窍不通。面对这些局限,人工智能领域提出了三种主流解决方案——检索增强生成(RAG)、缓存增强生成(CAG)和微调(Fine-Tuning)。它们就像给LLM安装不同的“外接大脑”,但各自的运作逻辑、适用场景和成本代价却大相径庭。本文将…- 8

- 0

-

低代码 RAG 只是信息搬运工,Graph RAG 让 AI 具备垂直深度推理能力!

在现实世界中,数据往往不是零散的文字,而是以图结构的形式交织在一起——实体(如人、物、事件)是节点,语义关系(如“购买”、“发现”、“属于”)是连接它们的边。这种结构化的数据在电商、社交网络等场景中无处不在,也为人工智能注入了新的灵感。传统RAG通过从外部数据库检索知识并注入大模型,已显著提升了生成内容的质量,但它有个致命短板:擅长处理独立的文本片段,却无法理解这些片段之间的深层联系。比如,当你问…- 8

- 0

-

微软PIKE-RAG全面解析:解锁工业级应用领域知识理解与推理

近一年来,虽然检索增强生成(Retrieval Augmented Generation, RAG)系统在通过外部检索扩展大语言模型(LLMs)能力方面取得了一定的进展。但它主要依赖于文本检索和LLMs的理解能力,缺乏对多源数据知识的提取、理解和利用,尤其在专业知识较强的领域(如工业应用中)表现出显著的不足。为了解决这一问题,微软亚洲研究院提出了 PIKE-RAG(sPecIalized Know…- 14

- 0

-

AI 记忆不等于 RAG:对话式 AI 为何需要超越检索增强

检索增强生成(RAG)已成为构建智能系统的标配技术。它通过 “检索 - 融合 - 生成” 的三段式流程,将外部知识库与大语言模型(LLM)结合,显著提升了 AI 回答的准确性和时效性。然而,当我们尝试构建具备类人交互能力的对话代理时,RAG 的局限性逐渐显现 —— 它本质上仍是信息检索工具,而非真正的记忆系统。理解这种差异,是突破当前 AI 交互瓶颈的关键。一、RAG 的技术本质与应用边界RAG …- 10

- 0

-

Firecrawl:颠覆传统爬虫的AI黑科技,如何为LLM时代赋能

FireCrawl是什么FireCrawl是由Mendable.ai开发的一款强大的AI网络爬虫工具,能够智能爬取网站及其所有可访问的子页面数据,并将收集的内容转换为Json,Markdown,Html等多种格式数据。它具备强大的抓取能力,无论是静态页面还是复杂的动态页面,甚至JavaScript呈现的内容都能抓取到。FireCrawl特别适用于AI模型训练、检索增强生成(RAG)和数据驱动的…- 11

- 0

-

什么是RAG与为什么要RAG?

检索增强生成(RAG)是一种流行的技术,通过在生成答案之前从知识库中检索相关的外部知识来增强 LLM 的响应。RAG 提高了准确性,减少了幻觉,并使模型能够提供更符合上下文和更新的信息。RAG 包括三个步骤:检索、增强和生成。检索 - 在此步骤中,系统会在外部知识源(例如向量数据库)中搜索相关信息,以基于用户查询找到相关的信息。增强 - 检索到的信息随后与原始用户查询结合,形成…- 3

- 0

-

Anthropic工程师揭秘高效AI Agent的三大秘诀

Anthropic 工程师 Barry Zhang 在 AI Engineer 工作坊上的一个分享 “如何构建有效的 Agent”,其中印象最深的一个观点:Don't build agents for everything,反过来理解就是别做什么都能干的 Agent,那是我们大模型要干的事情?构建有效 Agent 的三大要点:1. 明智选择应用场景,并非所有任务都需要 Age…- 6

- 0

-

Fireworks AI 分析

罗同学让我帮忙看看 fireworks.ai,之前没关注过这个产品,今天看看。他们应该是做 RAG 起家,卖点是比别人快。专注于为生成人工智能 (AI) 模型提供高性能、经济高效的推理解决方案;包括与 Groq 等既定基准和利用 vLLM 库的平台相比,推理速度要快得多,特别是对于检索增强生成 (RAG) 和使用 Stable Diffusion XL 等模型生成图像等任务。除了速度之外,Fire…- 3

- 0

-

文本向量的长度偏差及其在搜索中的影响

向量模型的核心功能是测量语义相似度,但这个测量结果很容易受到多种干扰因素的影响。在本文中,我们将着眼于文本向量模型中一个普遍存在的偏差来源:输入内容的长度。通常情况下,当与其它文本向量进行比较时,长文本向量往往得分更高,哪怕它们的实际内容没那么相似。当然,内容真正相似的文本,得分还是会比不相关的文本高。但是,长文本本身就会带来一种偏差:仅仅因为文本更长,它们的向量看起来(平均而言)就好像更相似。这…- 4

- 0

-

效率提升30%,Token减少 98%!LightPROF加速GraphRAG落地

本公众号主要关注NLP、CV、LLM、RAG、Agent等AI前沿技术,免费分享业界实战案例与课程,助力您全面拥抱AIGC。在GraphRAG落地实践过程中,高昂的推理成本,以及无法忍受的延时,是当前亟待解决的问题。本文此分享一个LightPROF(Lightweight and efficient Prompt learning-ReasOning Framework for KGQA)的轻量级…- 4

- 0

-

论文解读:微软发布 Graph RAG 的下一代 KBLAM 方案,利用注意力机制进行搜索排序

微软研究院和约翰霍普金斯大学的研究团队在这篇论文中提出了一种名为 KBLAM (Knowledge Base augmented Language Model) 的新方法,看起来是 Graph RAG 的进一步升级,解决了一些传统 RAG 的弊端。从工程角度看,KBLAM 的核心创新在于将知识库中的信息压缩成 "知识卡片"(knowledge tokens)…- 6

- 0

-

MCP与RAG,and 让我们用MCP的Tool莽穿一切!

MCP三大核心概念拆解:如何让LLM从"空谈家"变"实干派"1. Resources(资源管理器)—— 给LLM装上"记忆外挂"核心作用:RAG式数据供给:像图书馆管理员,告诉LLM**"这里有什么数据可用"**(数据库/文件夹/API等)。动态通知机制:当资源更新时,主动通知Client端(如新增了一份产品文档,实时…- 4

- 0

-

真实场景下落地RAG的十条建议及RAG中如何提升个性化?

本文先来看老刘关于RAG落地的十条建议,这是这两年来做RAG相关工作得到的一些启发,写出来供大家参考。另外,RAG有一个发展方向,就是朝向个性化走,刚好也有一个技术总结,我们也来看看。抓住根本问题,做根因,专题化,体系化,会有更多深度思考。大家一起加油。一、真实场景下落地RAG的十条建议 RAG无处不在、无孔不入,却又缝缝补补,且出现了诸如GraphRAG、多模态RAG、Deeprese…- 4

- 0

-

超越 RAG 的 AI 记忆增强:在 2025 年加速对话代理的上下文理解

引言引言每周,我们都会看到有关检索增强生成(RAG)的新论文和新方法。RAG架构无处不在:图形RAG、GraphRAG、HybridRAG、HippoRAG,以及无数其他变体。AI社区已经将RAG视为解决大型语言模型(LLMs)许多局限性的潜在方案。然而,随着我们构建更复杂的AI系统,特别是与用户以复杂方式互动的对话代理,我们发现单靠RAG是不够的。本文探讨了尽管RAG具有实用性,但其本质上与真正…- 3

- 0

-

深度拆解RAGFlow分片引擎之切片实现

上一篇深度拆解RAGFlow分片引擎!3大阶段+视觉增强,全网最硬核架构解析 讲了切片的整体流程,今天我们来拆下切片的实现。我们在设置的时候,可以选择切片方法。这个参数是parser_id在创建知识库的时候,选择对应的切片方法以后,我们可以看到右侧的切片介绍。async def build_chunks(task, progress_callback): …- 8

- 0

-

OneFileLLM:一键整合海量数据源

OneFileLLM的最大作用是融合多路数据源,以统一格式输出,整理成LLM的上下文资料。来源不限于本地文件/目录、GitHub仓库、GitHub PR、GitHub Issues、ArXiv学术论文、YouTube视频字幕、网页文档、通过DOI或PMID标识的Sci-Hub论文等等。不管是你哪来的数据,最终都会将它们编译整理成单个文本文件,然后方便复制到LLM中使用。OneFileLLM简直就是…- 7

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!