罗同学让我帮忙看看 fireworks.ai,之前没关注过这个产品,今天看看。

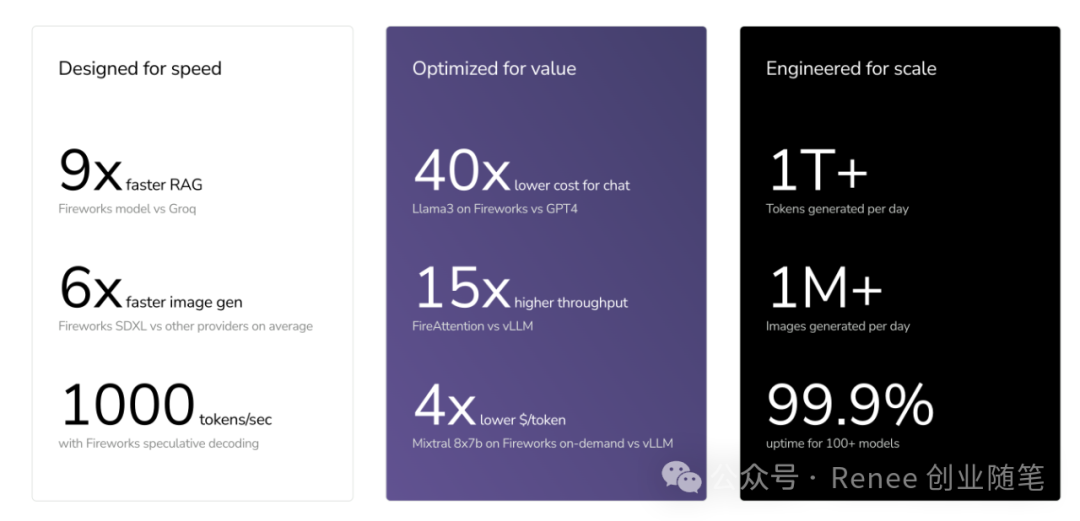

他们应该是做 RAG 起家,卖点是比别人快。专注于为生成人工智能 (AI) 模型提供高性能、经济高效的推理解决方案;包括与 Groq 等既定基准和利用 vLLM 库的平台相比,推理速度要快得多,特别是对于检索增强生成 (RAG) 和使用 Stable Diffusion XL 等模型生成图像等任务。

除了速度之外,Fireworks.ai 还强调与 OpenAI 的 GPT-4 等替代方案相比,对于某些任务而言可节省大量成本,并且吞吐量效率高。

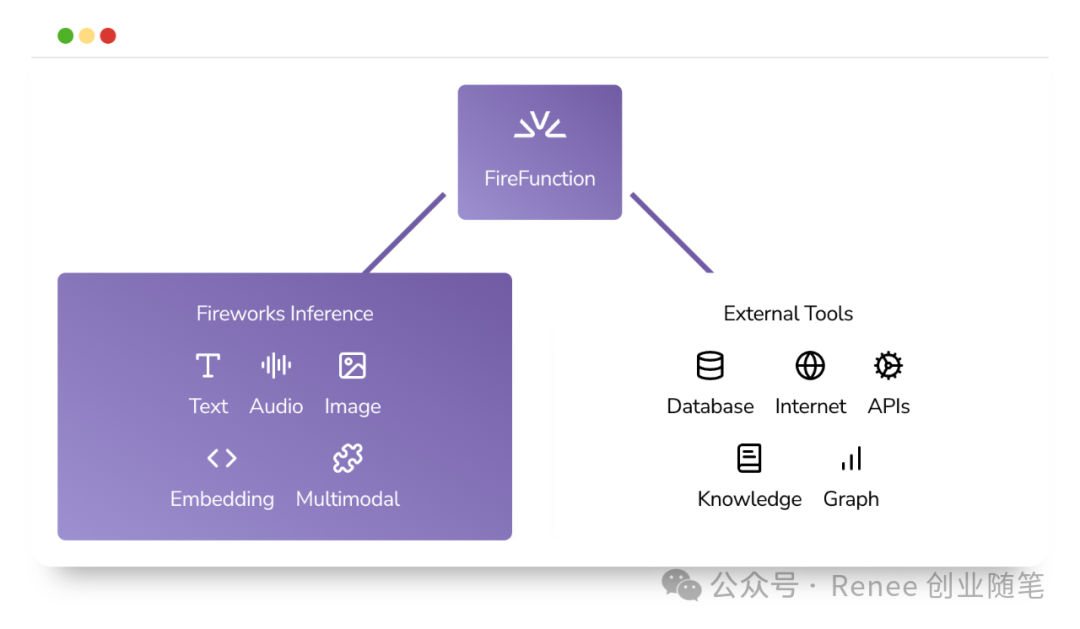

Fireworks.ai 的一个关键战略优势在于其专注于实现“复合人工智能系统”。这个概念涉及编排多个模型(可能跨不同模式)以及外部数据源和 API 来处理复杂的任务。“FireFunction”模型是该策略的核心,专为高效且经济高效的函数调用而设计,以促进 RAG 系统、代理和特定领域 copilot 等复杂应用程序的创建。

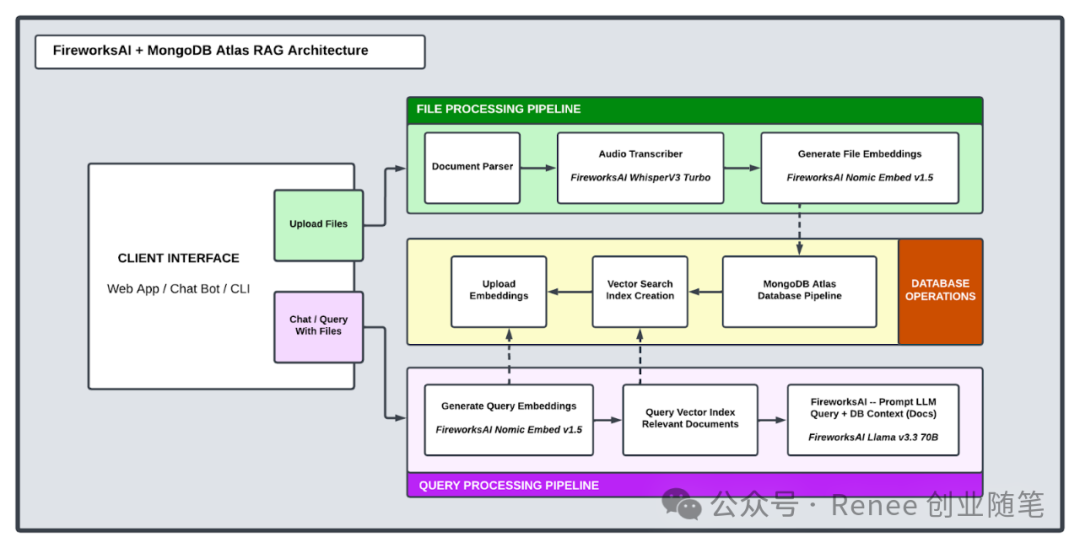

比如,他们最新的关于 RAG 的一个方案:

帮助企业从非结构化数据——从财报电话会议、财务报表,到法律文件和内部 PDF——在速度与规模上高效提取洞见。企业可以基于 Fireworks AI + MongoDB Atlas,从零搭建了一套企业级可落地系统:

-

实时语义搜索:支持 PDF、DOCX、音频等多种格式 -

Whisper V3 Turbo:音频转录速度提升 20 倍 -

Fireworks AI + MongoDB Atlas:低延迟、高吞吐、成本高效的推理能力 -

透明度与可追溯性:内置置信度评分与链路追踪 -

可扩展架构:后续 roadmap 将引入 multi-Agent orchestration、table parsing 及跨公司基准测试

和其他家的对比:

|

|

|

|

|---|---|---|

| Groq |

|

|

| vLLM |

|

|

| vLLM |

|

|

| vLLM |

|

|

| OpenAI (GPT‑4) |

|

|

| OpenAI (GPT‑4o) |

|

|

| OpenAI (Whisper) |

|

|

| 其他提供商 (SDXL) |

|

|

| 其他提供商 |

|

|