Qwen2.5-Omni-7B:开启多模态 AI 新时代的全能模型

最近,通义千问团队推出的 Qwen2.5-Omni-7B 模型,是集文本、图像、音频、视频处理以及实时文本、语音回复生成于一体的多模态系统,大幅拓展了 AI 能力边界。接下来,带读者深入了解 Qwen2.5-Omni-7B 模型。

一、Qwen2.5-Omni-7B概述

Qwen2.5-Omni是一款拥有70亿参数的多模态模型,它将视觉、语音和语言理解集成到统一的系统中。与传统的单模态专业模型(如用于文本的GPT、用于音频的Whisper)不同,Qwen2.5-Omni能够无缝地同时处理和生成多种数据类型。

关键特性:

-

多模态感知——理解文本、图像、音频和视频。 -

实时生成——以流的形式生成文本和语音回复。 -

类人交互——凭借其思想者 – 表达者架构模拟人类认知。 -

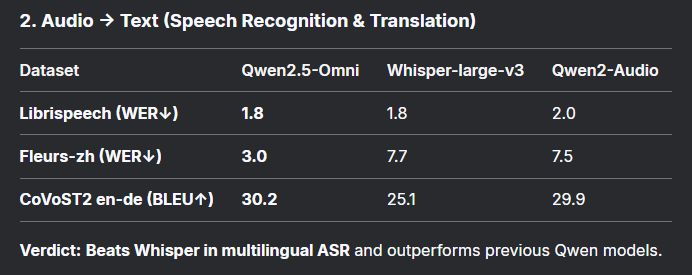

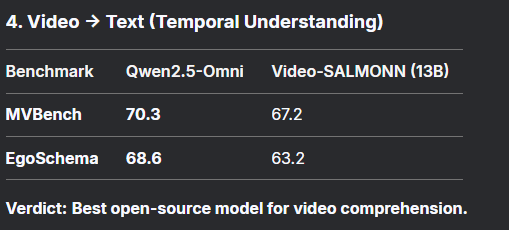

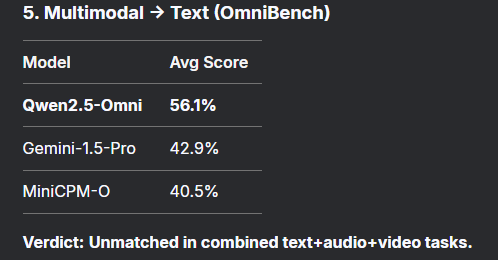

领先的基准测试表现——在自动语音识别(ASR)、光学字符识别(OCR)、视频理解等方面优于专业模型。

二、突破性创新

受人类认知启发,Qwen2.5-Omni将任务分为: – 思想者(大脑):处理输入(文本、音频、视频)并生成高级推理结果。 – 表达者(嘴巴):将思想者的输出转化为自然流畅的语音。

这种分离避免了不同模态之间的干扰,实现了如人类边思考边说话般流畅的实时交互。

多模态人工智能面临的最大挑战之一是音频和视频的同步问题。Qwen2.5-Omni通过TMRoPE这一新颖的位置编码方法解决了该问题:

-

在时间上对齐音频和视频帧。 -

动态适应可变帧率。 -

确保不同模态的无缝融合。

这让Qwen2.5-Omni在处理视频 – 音频任务(如对话转录或实时流分析)时表现优秀。

为了实现实时响应,Qwen2.5-Omni以2秒为单位处理数据块,减少了以下环节的延迟:

-

音频/视频编码 -

语音生成 -

文本回复流

这使其非常适合实时交互场景,如语音助手或基于视频的人工智能辅导。

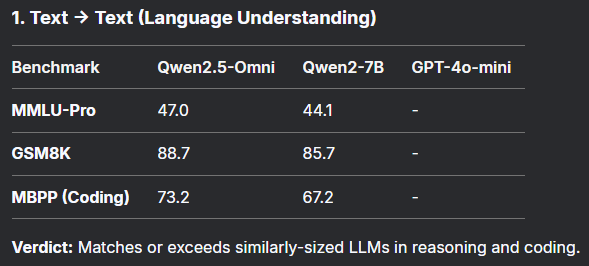

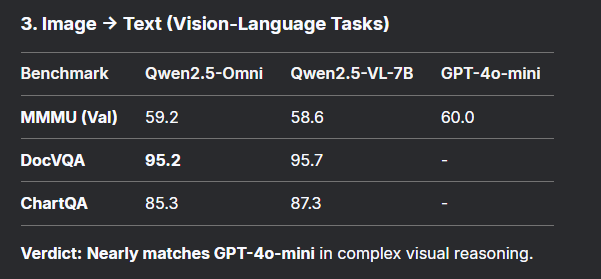

三、基准测试优势:Qwen2.5-Omni的表现

四、实际应用

-

下一代语音助手

-

对语音指令的理解和回复与对文本指令的处理一样精准。 -

生成近乎人类水平的语音(在SEED-zh数据集上词错误率为1.42% ,接近人类语音质量)。 -

视频分析与实时翻译 -

对会议、讲座或视频进行实时转录。 -

实现多语言语音转文本(例如,中文到英文的BLEU评分达到29.4 )。 -

人工智能辅导与客户支持 -

基于图像、PDF或视频回答问题(在文档视觉问答(DocVQA)任务上准确率超过95%)。 -

以可控的语气和情感自然地进行对话。 -

内容创作与无障碍服务 -

自动生成带有同步字幕的视频摘要。 -

为视障人士提供带有实时图像描述的语音旁白。

五、多模态人工智能的未来

Qwen2.5-Omni不仅仅是一次渐进式的升级,更是迈向通用人工智能(AGI)的一次飞跃。借助跨模态统一感知和生成技术,Qwen2.5-Omni-7B 有效缩小了人工智能与人类交互方式之间的差距,为多模态人工智能的发展开辟了新方向。

展望未来,Qwen2.5-Omni-7B 有着诸多值得期待的发展方向,其中拓展输出模态便是重要一环。未来,它很可能实现图像、视频等内容的生成。这一拓展不仅能丰富其应用场景,还将为相关领域带来更多创新可能,进一步推动人工智能与人类生活的深度融合。