-

在 RAGFlow 中实践 GraphRAG

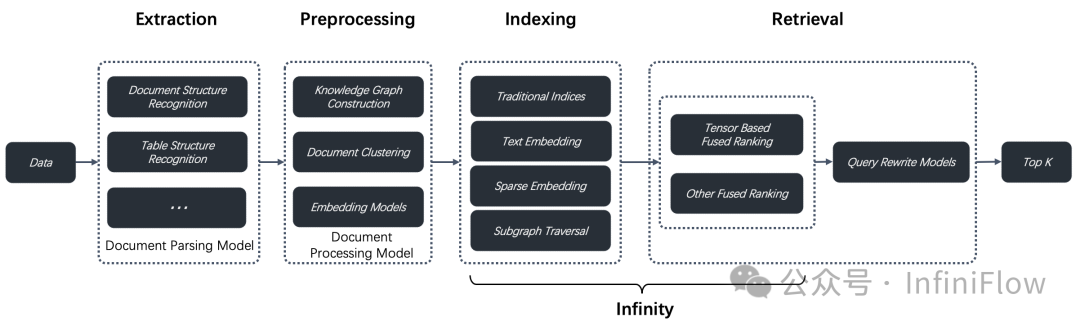

RAGFlow 0.9 版本发布,正式引入了对 GraphRAG 的支持。GraphRAG 由微软近期开源【参考文献1】,被称作下一代 RAG,并且在更早时间发表了相关论文【参考文献2】。关于下一代 RAG,在 RAGFlow 体系的定义更加完整,就是如下图所示的 RAG 2.0, 这是一个以搜索为中心的端到端的优化系统,分为 4 个阶段,除了后边 2 个阶段——索引与检索,这个大部分是需要一个专…- 4

- 0

-

搞大模型,没有重排工具怎么行?

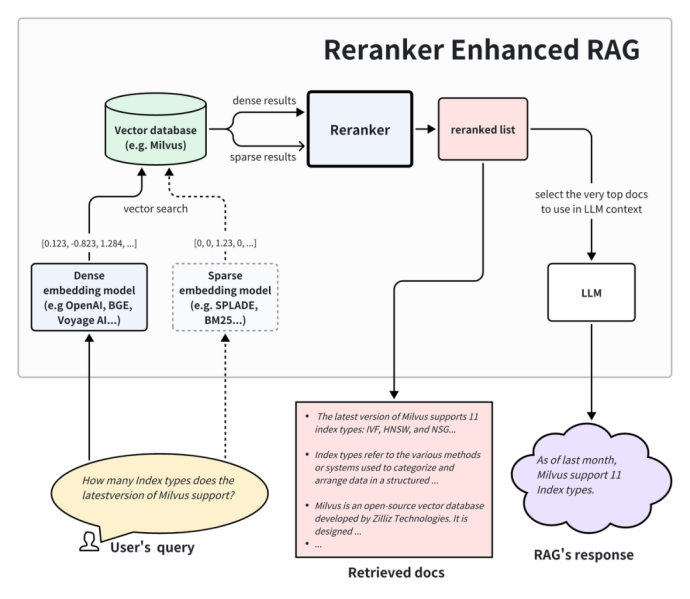

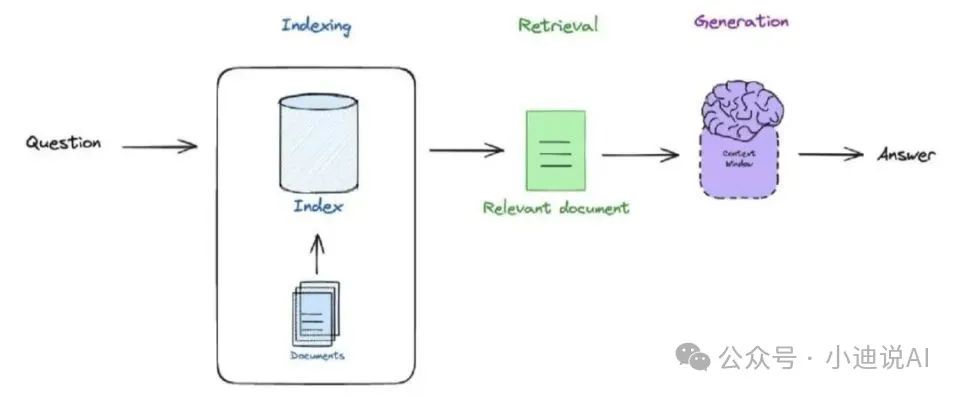

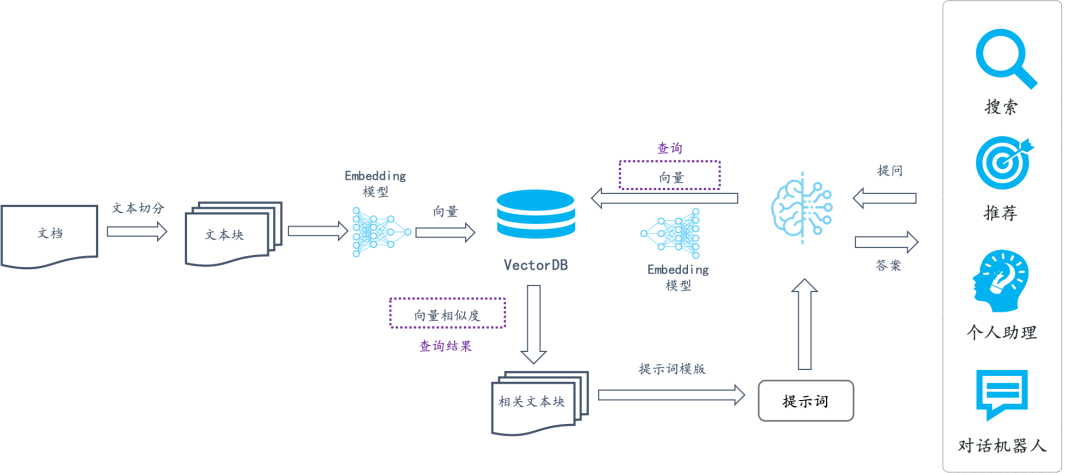

在说重排工具之前,我们要先了解一下 RAG。检索增强生成(RAG)是一种新兴的 AI 技术栈,通过为大型语言模型(LLM)提供额外的 “最新知识” 来增强其能力。 基本的 RAG 应用包括四个关键技术组成部分: Embedding 模型:用于将外部文档和用户查询转换成 Embedding 向量 向量数据库:用于存储 Embedding 向量和执行向量相似性检索(检索出最相关的 Top-K 个信息)…- 10

- 0

-

造原子弹的也来整活RAG了:RAG + Few Shot提升代码翻译效果

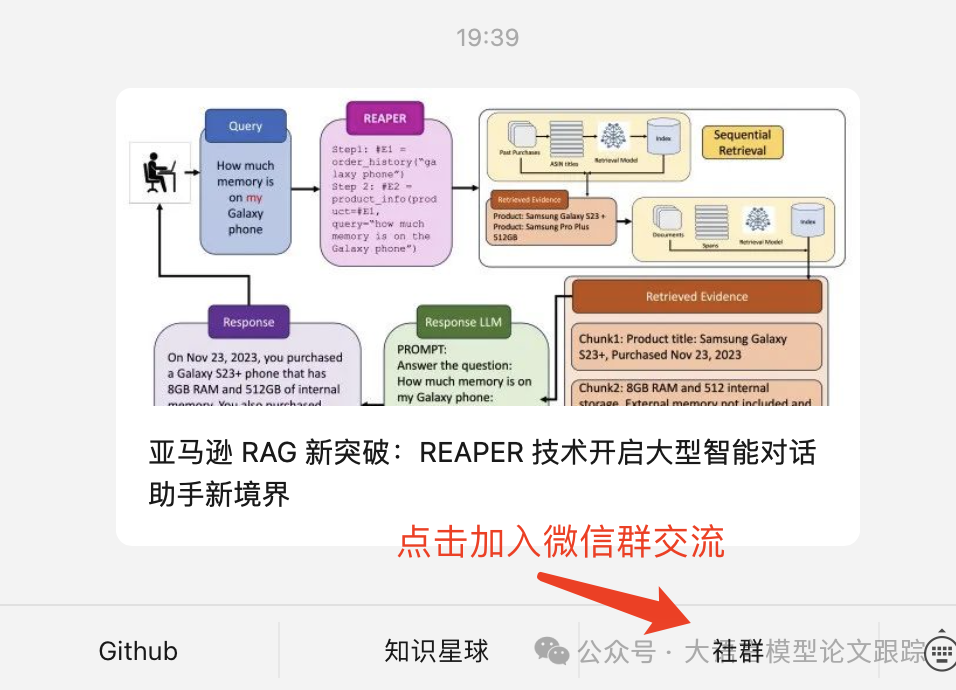

Enhancing Code Translation in Language Models with Few-Shot Learning via Retrieval-Augmented Generation大型语言模型 (LLM) 的兴起极大地推动了代码翻译领域,实现了编程语言间的自动化转换。然而,这些模型在处理复杂任务时,因上下文理解不足而常显疲态。本文提出了一种创新方法,结合少样本学习和基于检…- 8

- 0

-

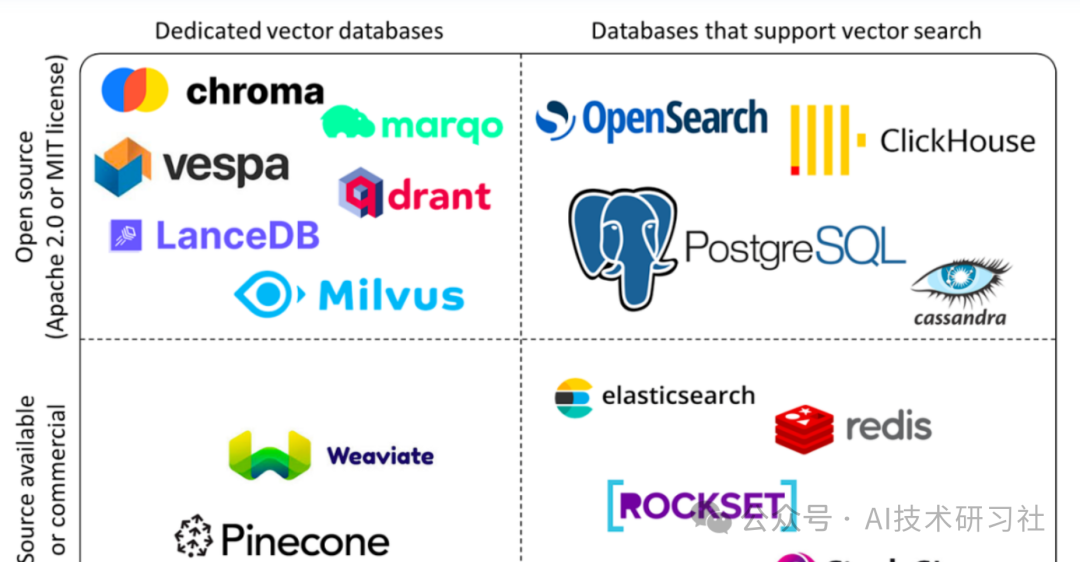

RAG 向量数据库:掌握 Elasticsearch 作为向量数据库的终极指南

在不断发展的数据管理环境中,Elasticsearch 已成为一个突出的参与者,通过其向量数据库引入了突破性的功能,为数据搜索和检索领域带来的变革性影响。从本质上讲,Elasticsearch 的向量数据库是一种尖端解决方案,旨在利用向量嵌入的潜力实现高效且可扩展的搜索操作。Elasticsearch Vector DB是一种先进的数据存储和检索技术,它结合了Elasticsearch的全文搜索功…- 7

- 0

-

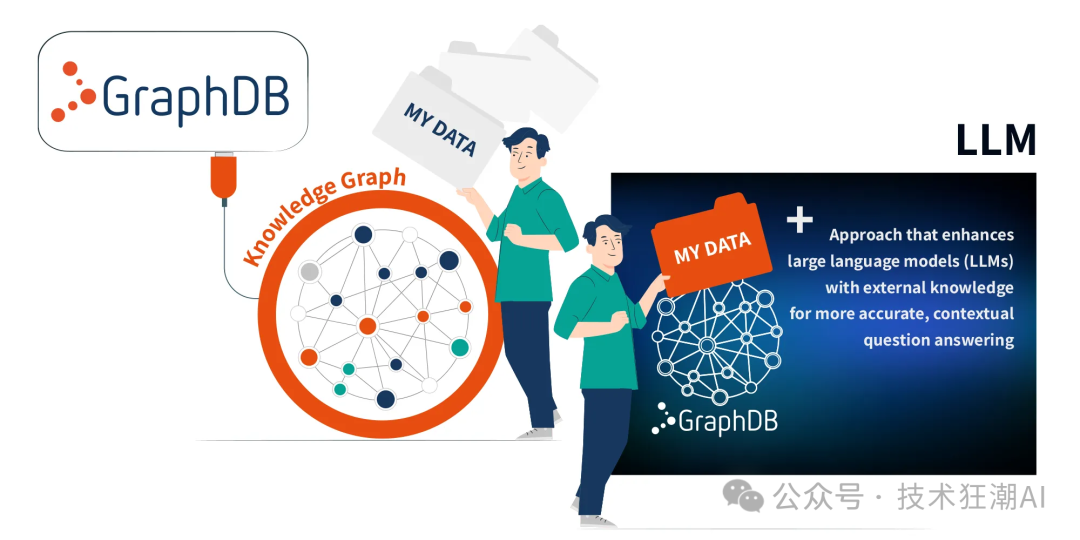

微软GraphRAG技术背后的秘密:图谱化文本数据的新方法

在当今信息爆炸的时代,如何有效地利用大型语言模型(LLMs)来处理未见过的数据是一项重大挑战和机遇。微软研究院提出的GraphRAG技术,通过创建知识图谱并结合图机器学习,显著提高了LLMs在复杂文档分析中的问答性能。GraphRAG是一种结合了文本提取、网络分析和LLM提示与摘要的新型技术,旨在通过一个端到端的系统来丰富理解文本数据集的能力。微软近期宣布将GraphRAG开源,并在GitHub上…- 6

- 0

-

GraphRAG: 知识图谱关系问答,提升 LLM 总结精准性,避免笼统(架构说明+用户反馈)

本文介绍上个月很火的微软开源的GraphRAG 项目, 当时出来时就只是简单看了看, 这等了快 1 月等有人落地验证后我再继续看, 这样效率会很高根据之前的经验, 像我本来就不是技术出身, 面对新的技术的试错成本太大,刚出来的项目社区,教程都还不成熟接下来看看 GraphRAG 的架构和目前用户的部署反馈架构背景是解决之前的 RAG文本回答,不能对整体文档的总结性内容进行回答, 只能回答文档里有的…- 7

- 0

-

5分钟带你了解:AI联网搜索与RAG如何选择与应用

众所周知,LLM 的训练数据存在时效性和通用性问题。在面对时效性或是专业性较强的提问时,如果只依赖于内在知识,LLM 就无法很好地回答。为了解决这些问题,让 LLM 搜索信息后再生成的方法应运而生。而搜索信息的方法又可以简单地分为网络搜索与本地搜索两种。网络搜索可以在一定程度上缓解 LLM 的时效性问题,而依赖于本地知识库的 RAG 方法可以较好地解决 LLM 在某专业领域知识不足的情况。如果要打…- 8

- 0

-

如何在生成式AI里使用 Ray Data 进行大规模 RAG 应用的 Embedding Inference

检索增强生成 (RAG,即Retrieval Augmented Generation) 是企业级生成式 AI(GenAI)应用的热门案例之一。多数 RAG 教程演示了如何利用 OpenAI API 结合 Embedding 模型和大语言模型(LLM)来进行推理(Inference)。然而,在开发过程中,如果能使用开源工具,就可以免去访问自己数据的费用,同时也能加快迭代。在 Embedding 步…- 4

- 0

-

延迟交互模型,为什么是下一代RAG的标配?

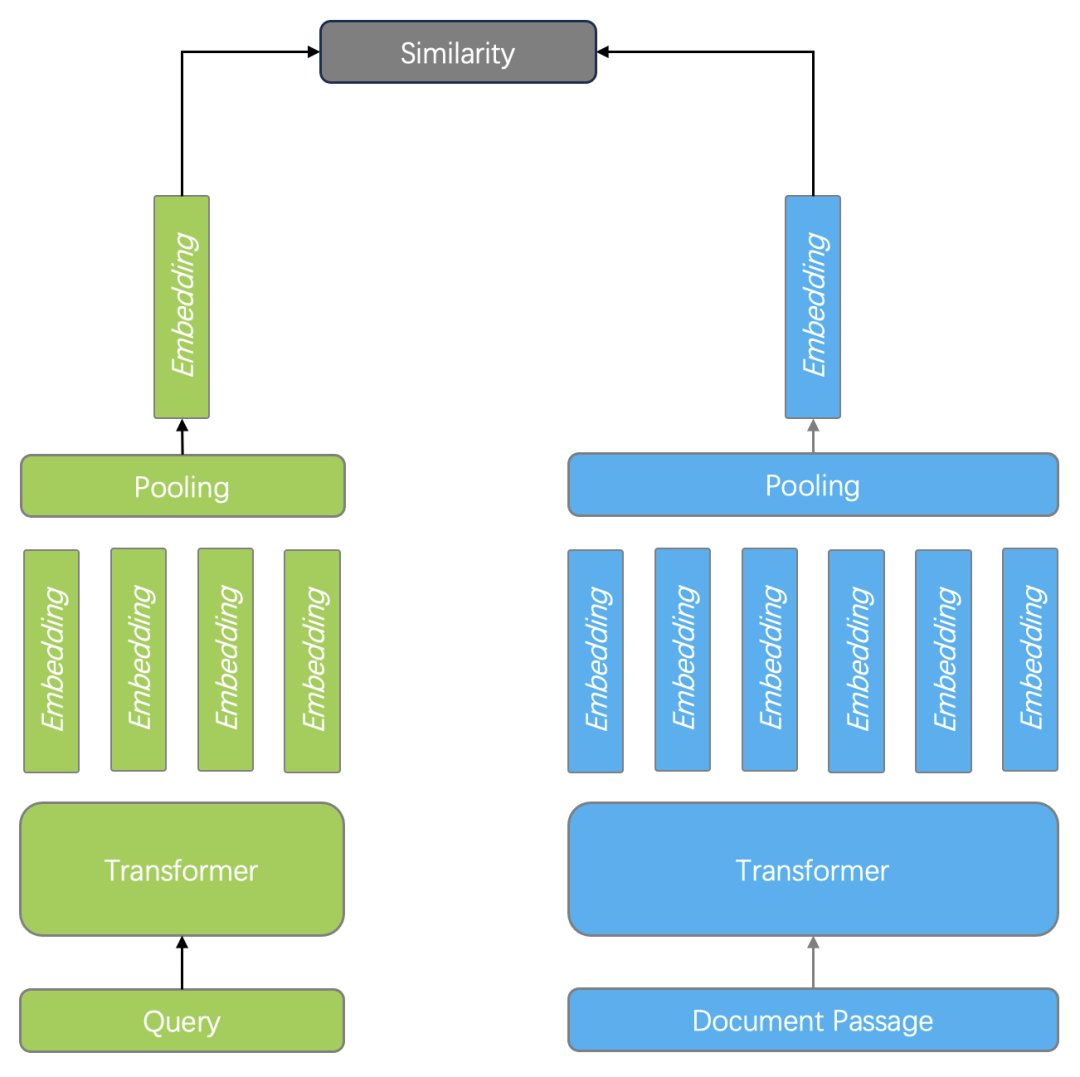

张颖峰:英飞流联合创始人,多年搜索、AI、Infra基础设施开发经历,目前正致力于下一代 RAG 核心产品建设。在 RAG 系统开发中,良好的 Reranker 模型处于必不可少的环节,也总是被拿来放到各类评测当中,这是因为以向量搜索为代表的查询,会面临命中率低的问题,因此需要高级的 Reranker 模型来补救,这样就构成了以向量搜索为粗筛,以 Reranker 模型作精排的两阶段排序架构。目前…- 4

- 0

-

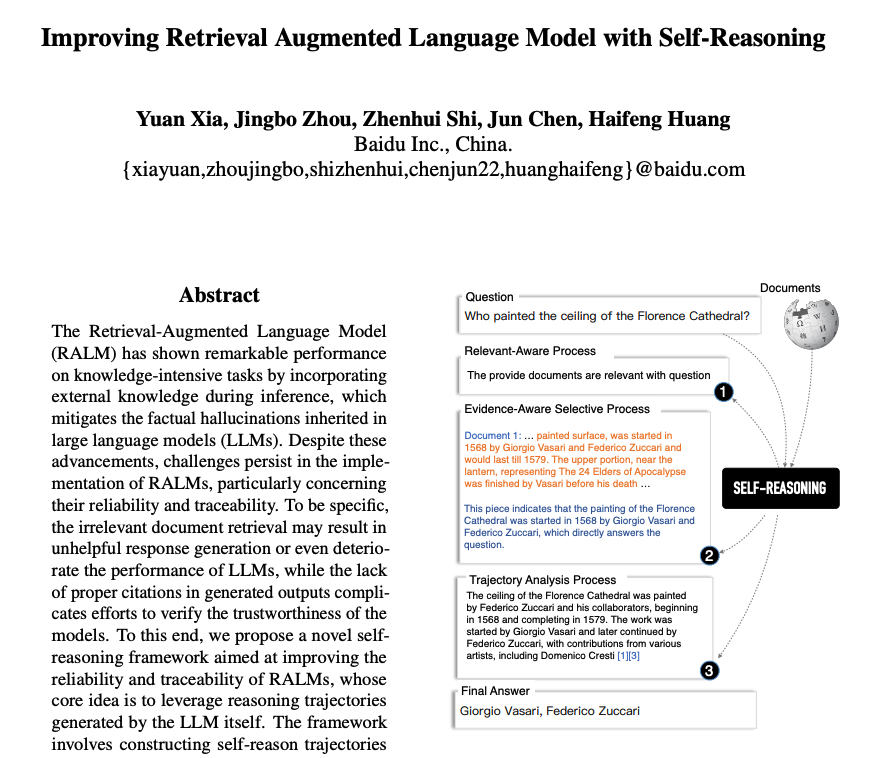

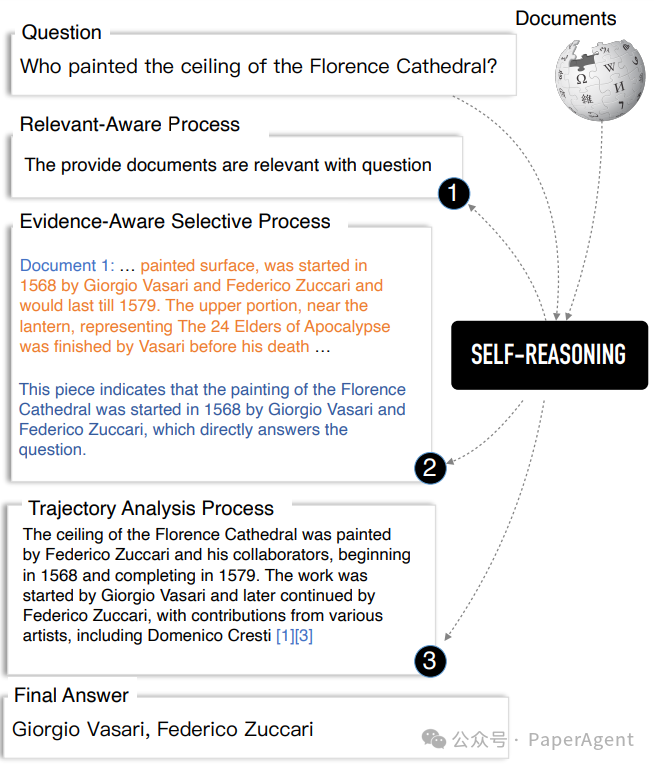

百度推出自推理RAG框架

百度终于整了点大活!他们最近搞出了一个叫"自推理"的框架,号称能让RAG系统更靠谱、更易追踪。说白了,就是让大模型自己问自己答,自己给自己出题还自己改卷,这操作也是没谁了!这个框架主要分三步走:相关性判断:让模型自己判断检索到的文档和问题是否相关。证据提取:模型自己挑选相关文档,然后从中提取关键句子作为证据。轨迹分析:模型根据前两步生成的推理轨迹,给出最终答案。听起来好像很高大…- 5

- 0

-

大模型RAG实战|混合检索:BM25检索+向量检索的LlamaIndex实现

ThinkRAG大模型RAG实战系列文章,带你深入探索使用LlamaIndex框架,构建本地大模型知识库问答系统。本系列涵盖知识库管理、检索优化、模型本地部署等主题,通过代码与实例,讲解如何打造生产级系统,实现本地知识库的快速检索与智能问答。此前,我介绍了使用Elasticsearch实现混合检索。本文我将介绍一种效果更好的混合检索方法,在实际问答场景中,优于向量数据库自带的混合检索功能。&nbs…- 16

- 0

-

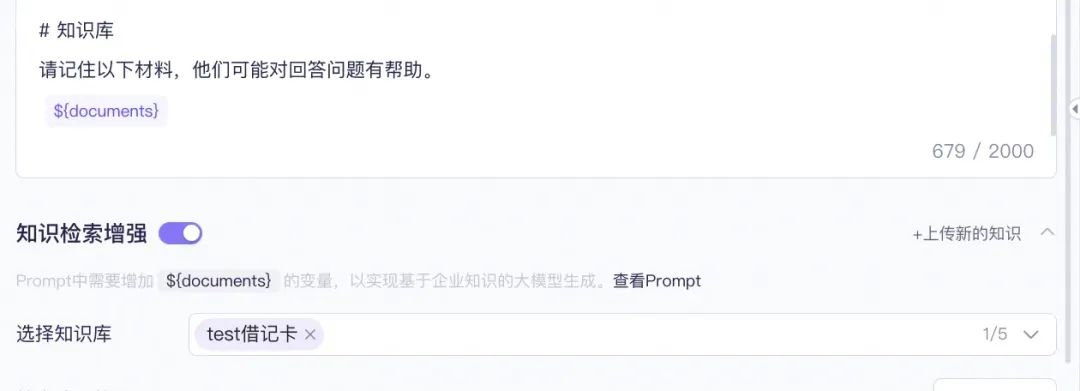

如何速成RAG+Agent框架大模型应用搭建

阿里妹导读本文侧重于能力总结和实操搭建部分,从大模型应用的多个原子能力实现出发,到最终串联搭建一个RAG+Agent架构的大模型应用。一、概况目前有关大模型的定义与算法介绍的文章已经很多,本文侧重于能力总结和实操搭建部分,从大模型应用的多个原子能力实现出发,到最终串联搭建一个RAG+Agent架构的大模型应用,让个人对于大模型应用如何落地更加具有体感。二、大模型发展现状目前大模型发展笼统的可以分为…- 9

- 0

-

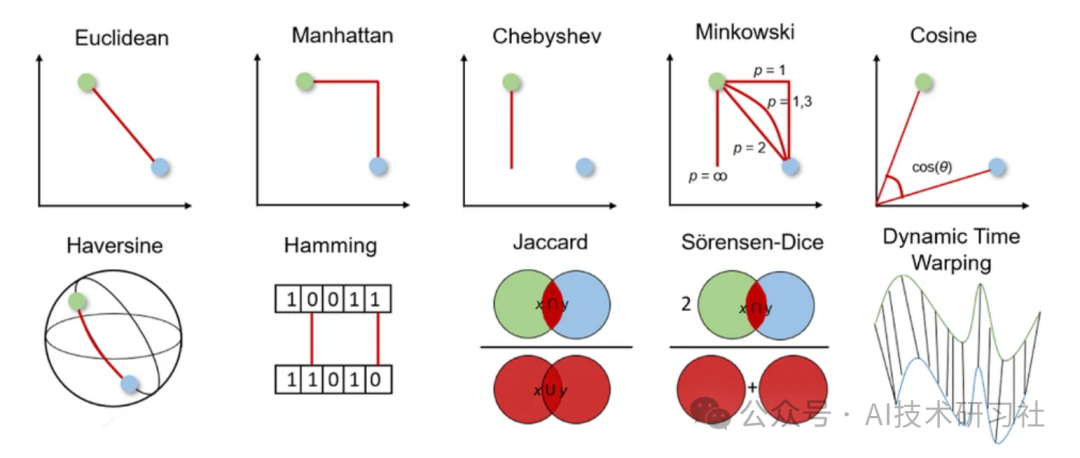

RAG必懂知识:什么是向量数据库的距离?一文详解向量距离

向量距离在数学、物理学、工程学和计算机科学等多个领域都至关重要。它们用于测量物理量、分析数据、识别相似性以及确定向量之间的关系。本文将提供向量距离及其在数据科学中应用的概述。什么是向量距离?向量距离,也称为距离度量或相似度度量,是一种数学函数,用于量化两个向量之间的相似性或差异性。这些向量可以代表各种数据集,向量距离有助于理解向量在特征空间中的接近程度或远离程度。因此,向量距离在各种机器学习算法中…- 7

- 0

-

一文详谈20多种AI大模型RAG优化方法

大规模语言模型(LLMs)已经融入了我们的日常生活和工作中,它们以卓越的多功能性和智能化改变了我们与信息互动的方式。尽管LLMs的能力令人赞叹,但它们并非完美无缺。这些模型可能会产生误导性的“幻觉”,依赖的信息可能已过时,处理特定知识时效率不高,缺乏对专业领域的深入理解,同时在推理方面也存在不足。在实际应用中,数据需要持续更新以反映最新发展,生成的内容必须是透明和可追溯的,以控制成本并保护数据隐私…- 6

- 0

-

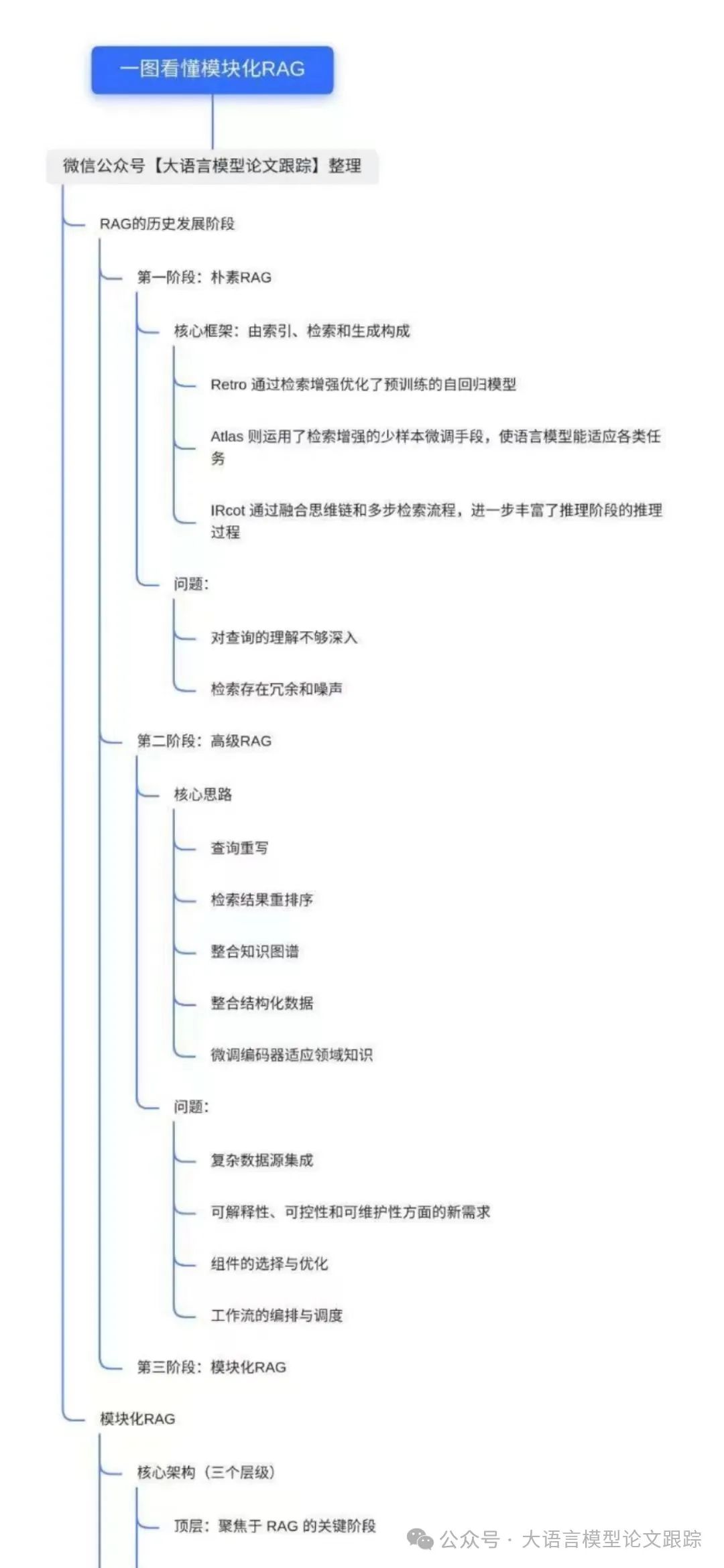

模块化RAG:RAG新范式,像乐高一样搭建 万字长文

模块化RAG:RAG新范式,像乐高一样搭建发布时间:2024 年 07 月 25 日RAGModular RAG: Transforming RAG Systems into LEGO-like Reconfigurable FrameworksRAG 技术通过增强检索能力,显著提升了 LLM 在知识密集型任务中的表现。随着应用需求的增加,RAG 不断进化,整合了尖端检索技术、LLM 及其他互补技…- 4

- 0

-

百度也来卷RAG了,Self-Reasoning比Self-RAG最高提升11.8%

检索增强型语言模型(Retrieval-Augmented Language Model, RALM)通过在推理过程中整合外部知识,减轻了LLM固有的事实幻觉问题。然而,RALMs仍面临挑战:检索到的不相关文档可能导致无效的回答生成、生成的输出中缺乏适当的引用,使得验证模型的可信度变得复杂。一个示例,展示了百度自我推理(Self-Reasoning)框架如何通过相关意识过程、证据意识选择过程和轨迹…- 4

- 0

-

揭开RAG的秘密:向量数据库如何引领智能检索革命

在过去的一年里,大型语言模型的发展以及人工智能生成浪潮在全球范围内引起了广泛关注。然而,这些大型语言模型面临一个众所周知的挑战:一旦训练完成,它们就无法理解最新的或某些未经过训练的专业领域知识。为了解决这个问题,检索增强生成(Retrieval-Augmented Generation, RAG)技术应运而生。RAG的核心之一是向量数据库,这种数据库专门用于处理向量数据,为机器学习和人工智能等领域…- 7

- 0

-

从“一本正经地胡说八道”到“更懂你”:Graph RAG 如何让 AI 真正拥有知识?

一、前言大模型技术在经过一年多的飞速迭代和发展,以 ChatGPT 为代表的大语言模型(LLM)凭借其强大的文本生成能力,在各个领域掀起了一场 AI 应用的革命。然而,狂欢过后,人们逐渐意识到 LLM 并非无所不能。由于训练数据的限制,LLM 常常会“一本正经地胡说八道”,给出过时、不准确甚至完全虚构的信息。为了解决这个问题,检索增强生成(RAG)技术应运而生。RAG 就像为 LLM …- 5

- 0

-

从0-1构建一个RAG(检索增强)系统

昨日,Openai 推出Searchgpt,将 AI 与实时网络信息结合提供生成式UI结果.其背后的技术就是RAG. RAG(Retrieve Augment Generation,检索增强)是“驯服”大语言模型的主要手段之一。它允许大语言模型在从固定的数据库中抽取相关内容的基础上生成答案,从而限制随意发挥,提升答案的可靠性。核心组件:RAG(检索增强生成)系统的核心组件主要包括以下三个部分:检索…- 8

- 0

-

可视化分析RAG大模型系统数据处理流程

RAG写在前面欢迎大家关注我最近开发项目:LangChat是Java生态下企业级AIGC项目解决方案,在RBAC权限体系的基础上,集成AIGC大模型功能,帮助企业快速定制AI知识库、企业AI机器人。开源地址:https://github.com/TyCoding/langchat产品官网:http://langchat.cn/Baptiste Adrien分享了使用 Vercel和NextJS 开…- 6

- 0

-

揭开RAG重排序(Rerankers)和两阶段检索(Two-Stage Retrieval)的神秘面纱

一、为什么需要重排序?检索增强生成(Retrieval Augmented Generation,RAG)技术看似充满无限可能,但在实际应用中,许多人发现构建的RAG系统结果并不尽如人意。尽管RAG相对容易入门,但要真正掌握其精髓却相当困难。实际上,建立一个有效的RAG系统远不止将文档存入向量数据库并叠加一个大语言模型那么简单。虽然这种方法有时会有效,但并非总能保证成功。我们知道,RAG 通过在大…- 5

- 0

-

GraphRAG + AutoGen + Ollama + Chainlit = 本地和免费的多代理 RAG 超级机器人

Rag (RAG) 是一种强大的工具,它使大型语言模型 (LLM) 能够访问真实世界的数据以获得更明智的响应。这是通过将模型与矢量数据库集成以实现实时学习和适应来实现的。此功能使 RAG 成为聊天机器人和虚拟助手等应用的首选,在这些应用中,对实时准确和明智的响应的需求很高。其中一种高级变体,称为图检索增强生成(GraphRAG),将基于图的知识检索与LLMs的优点相结合,进一步增强了自然语言处理的…- 6

- 0

-

RAG 实践- Ollama+RagFlow 部署本地知识库

本文我们介绍另一种实现方式:利用 Ollama+RagFlow 来实现,其中 Ollama 中使用的模型仍然是Qwen2我们再来回顾一下 RAG 常见的应用架构RagFlow的安装和部署前置条件CPU >= 4 核RAM >= 16 GBDisk >= 50 GBDocker >= 24.0.0 & Docker Compose >= v2.26.1安装克隆仓…- 5

- 0

-

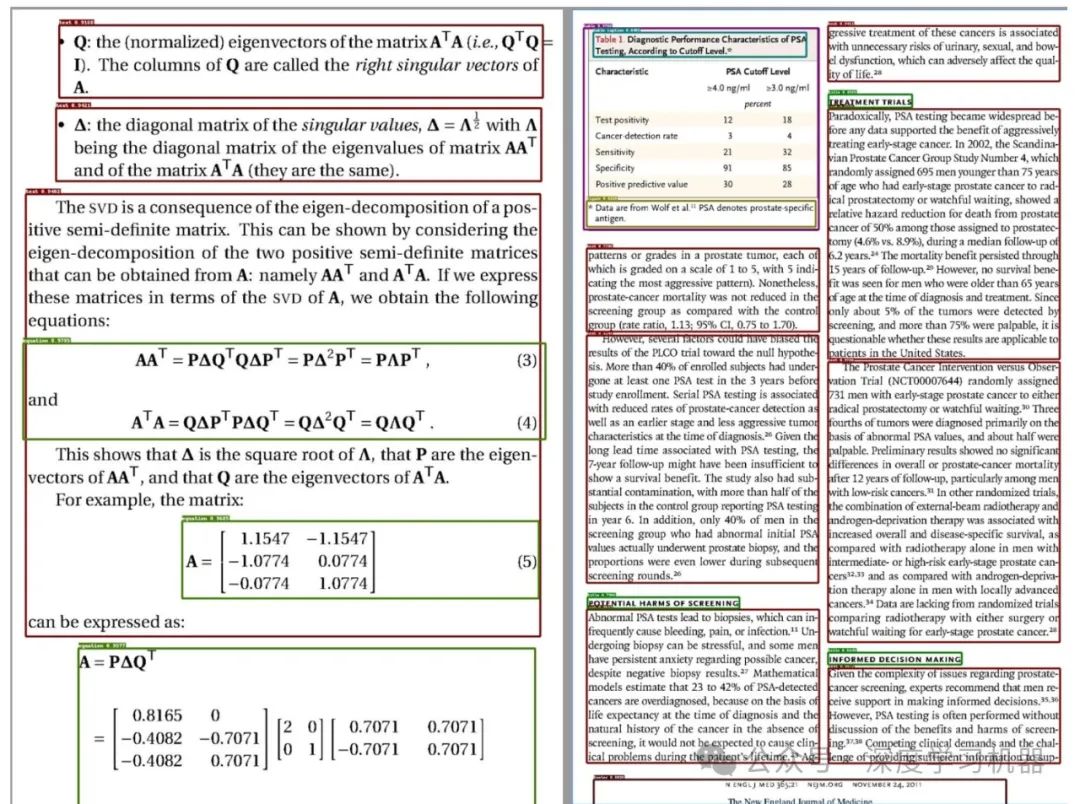

RAG文档解析利器:Deepdoc

项目结构|--deepdoc|--parser|--resume|--entities|--step_one.py|--step_two.py|--docx_parser.py|--pdf_parser.py|--excel_parser.py|--html_parser.py|--json_parser.py|--markdown_parser.py|--ppt_parser.py|--visi…- 5

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!