百度终于整了点大活!

他们最近搞出了一个叫"自推理"的框架,号称能让RAG系统更靠谱、更易追踪。

说白了,就是让大模型自己问自己答,自己给自己出题还自己改卷,这操作也是没谁了!

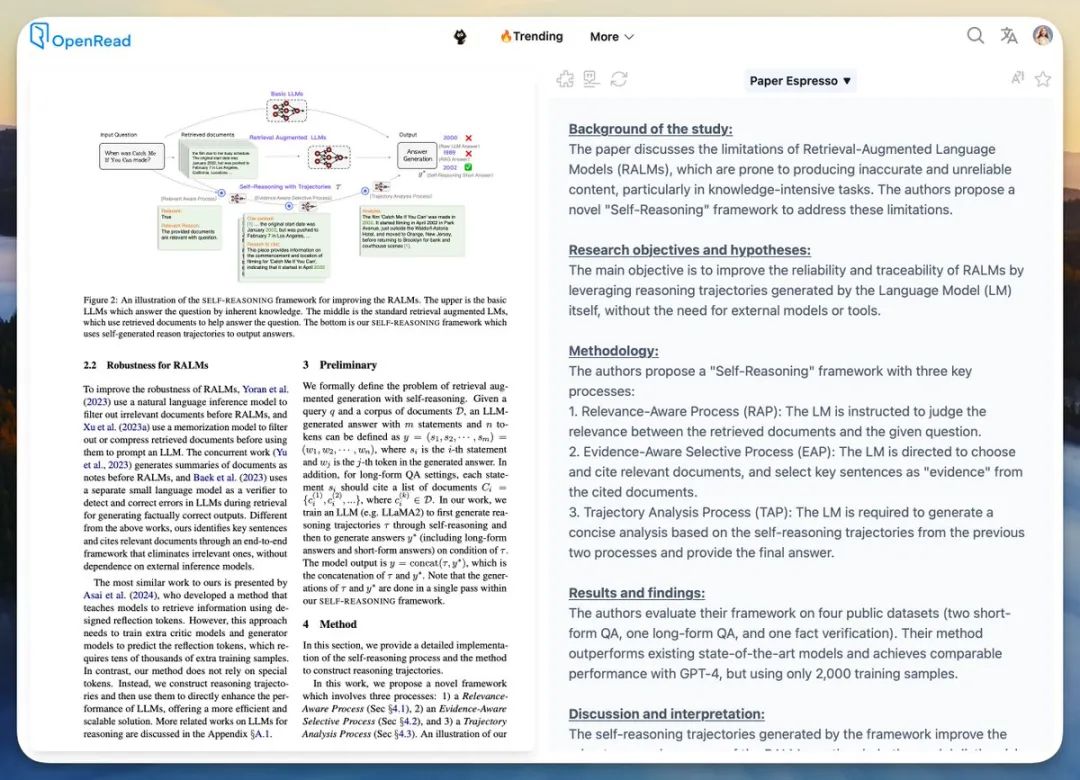

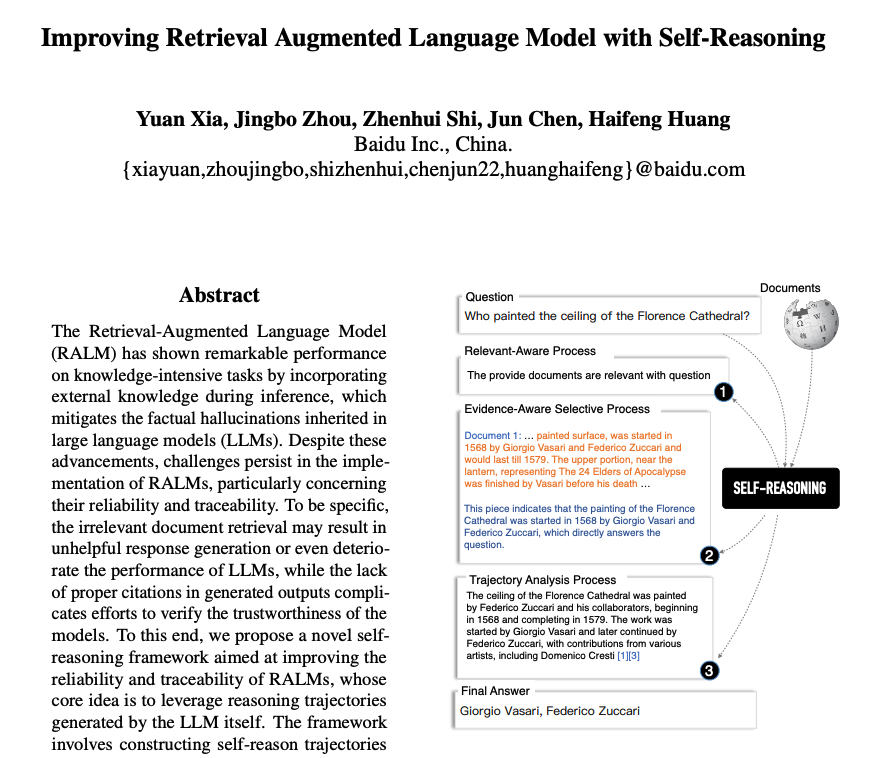

这个框架主要分三步走:

-

相关性判断:让模型自己判断检索到的文档和问题是否相关。

-

证据提取:模型自己挑选相关文档,然后从中提取关键句子作为证据。 -

轨迹分析:模型根据前两步生成的推理轨迹,给出最终答案。

听起来好像很高大上?

其实就是让模型自己当自己的老师,自己教自己怎么思考。可以说是既当爹又当妈了!

离谱的是,这玩意儿只用了2000个训练样本(还是GPT-4生成的),就能和GPT-4打个平手。

Lihua(@yZHxkVi1aTjSJmJ) 对百度这波操作表示赞叹:

这种利用大模型自身推理轨迹的方法很有意思。它可以提高模型的透明度和可解释性,让我们更好地理解模型是如何得出结论的。

这种让模型自己解释自己的做法,可以说是非常鸡贼了。不仅能提高准确率,还能让我们更好地理解模型的思考过程。

还有网友Zoe Wang(@zoewangai)更是直接上手研究了一波,她总结道:

作者提出的"自推理"框架包括三个关键过程:

相关性感知过程(RAP):指导语言模型判断检索文档与问题的相关性。

证据感知选择过程(EAP):引导语言模型选择和引用相关文档,并从中选取关键句子作为"证据"。

轨迹分析过程(TAP):要求语言模型基于前两个过程中的自推理轨迹生成简明分析,并给出最终答案。