-

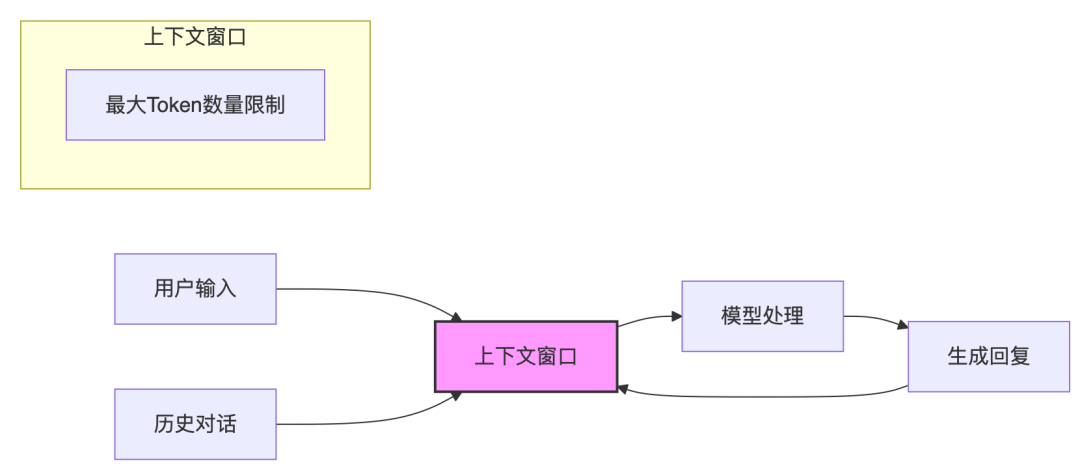

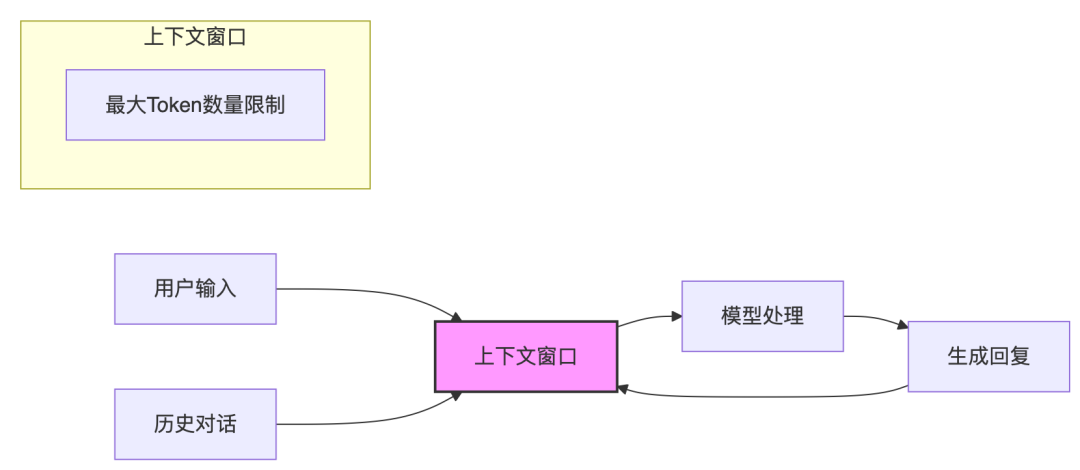

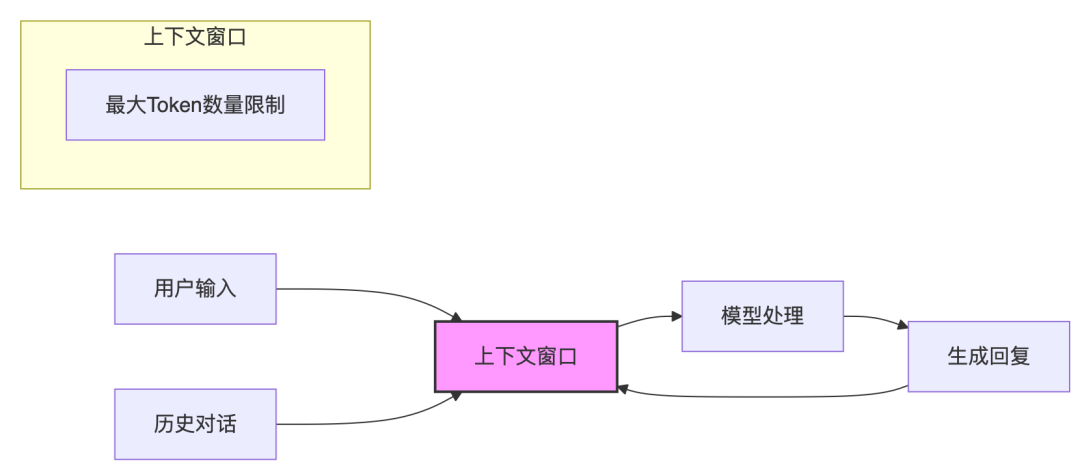

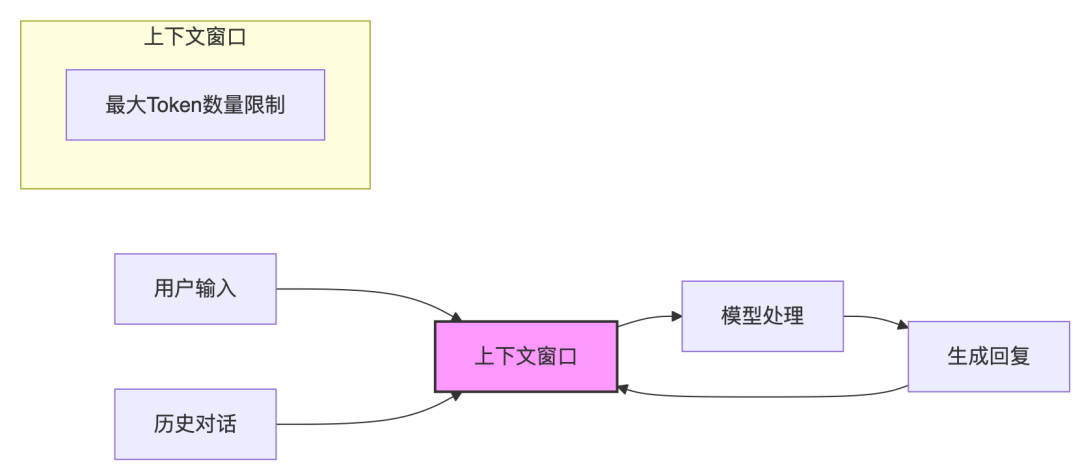

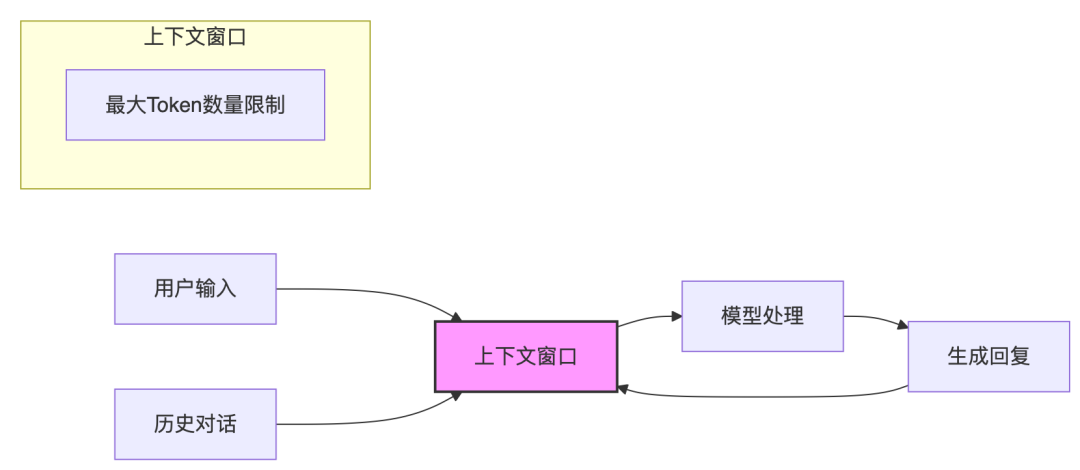

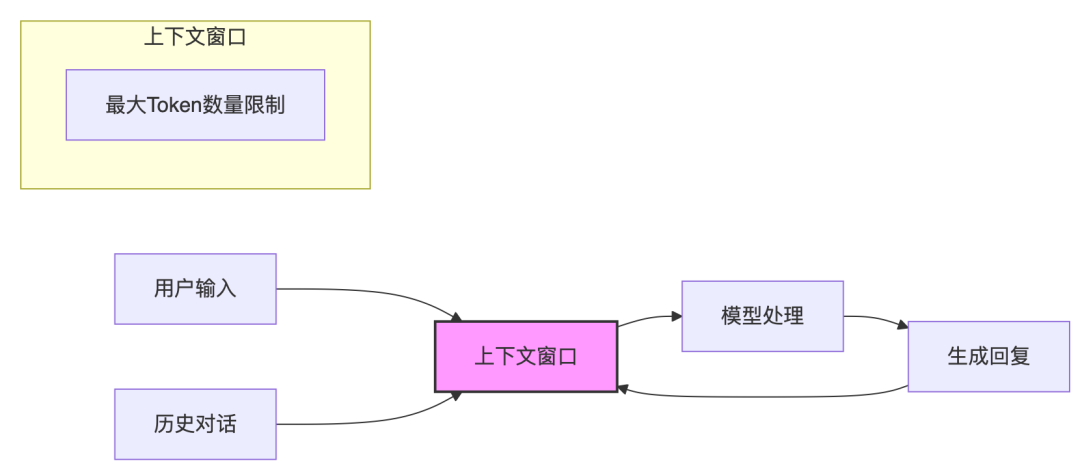

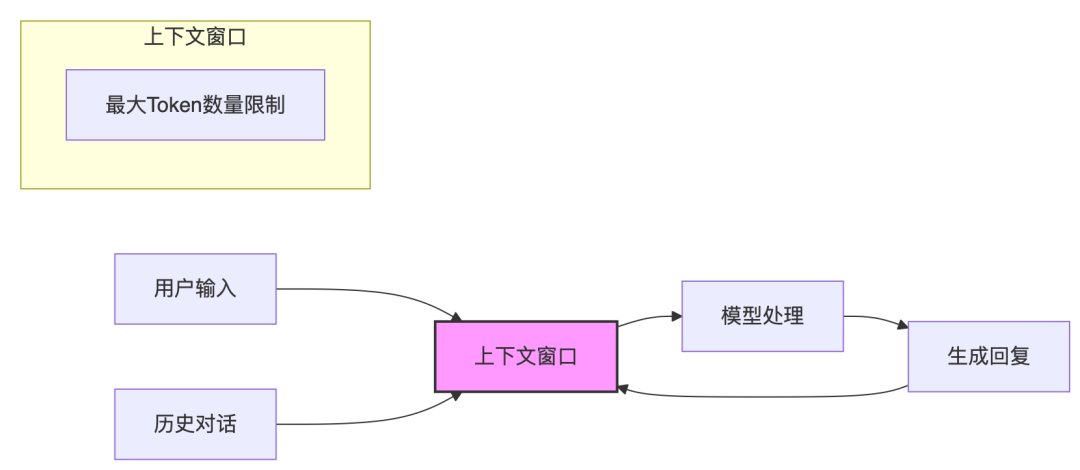

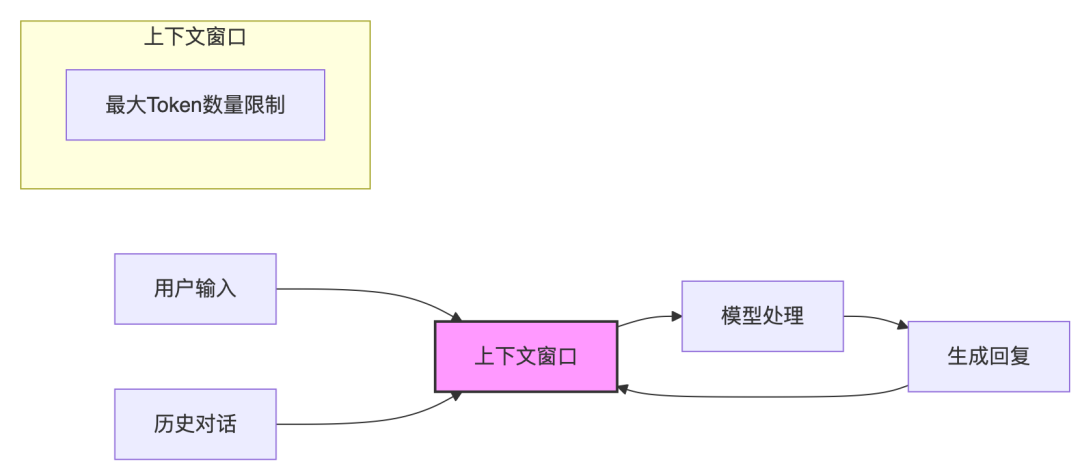

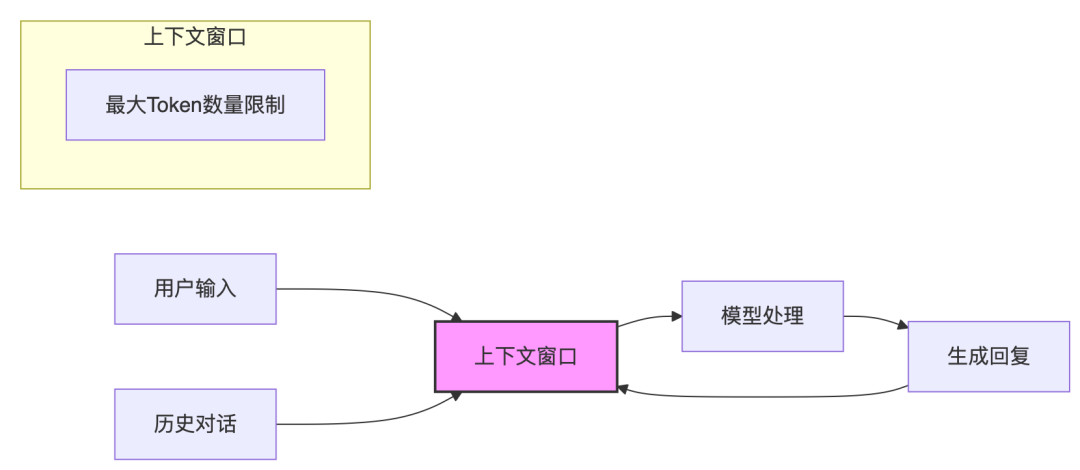

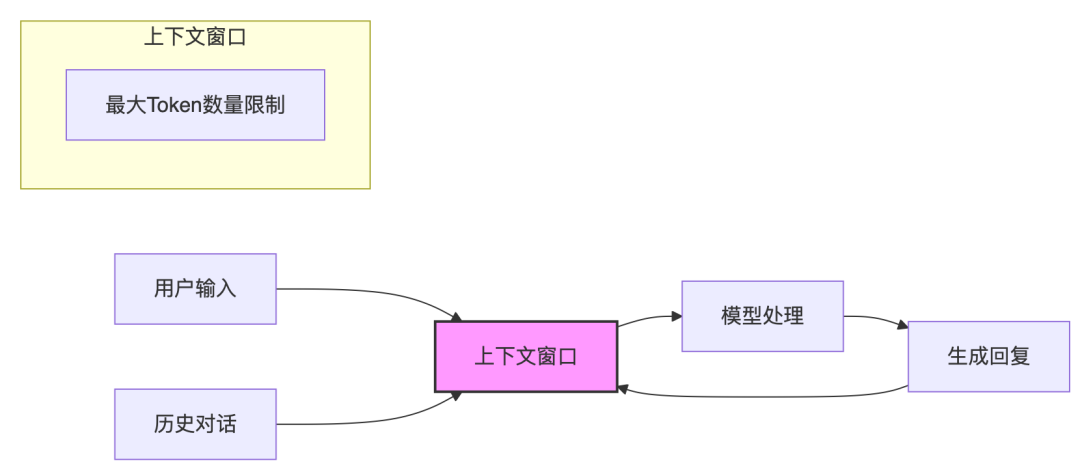

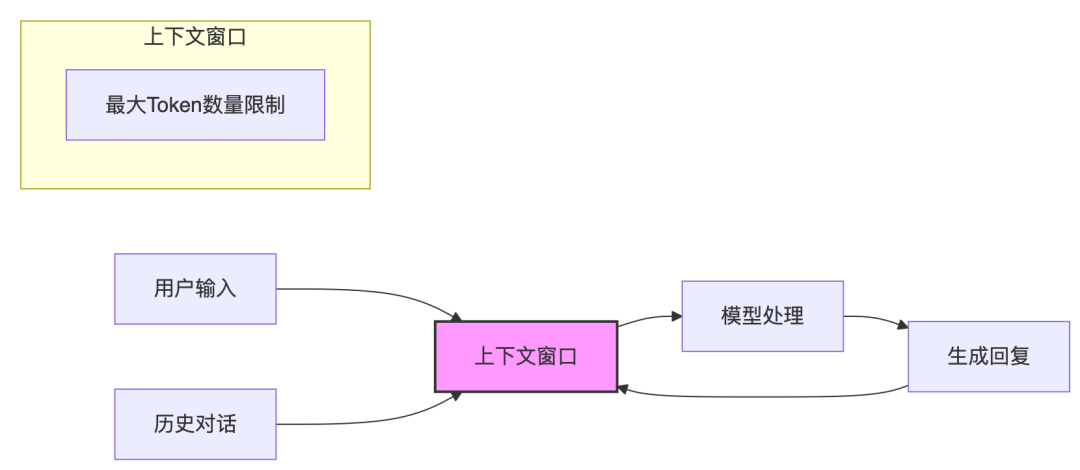

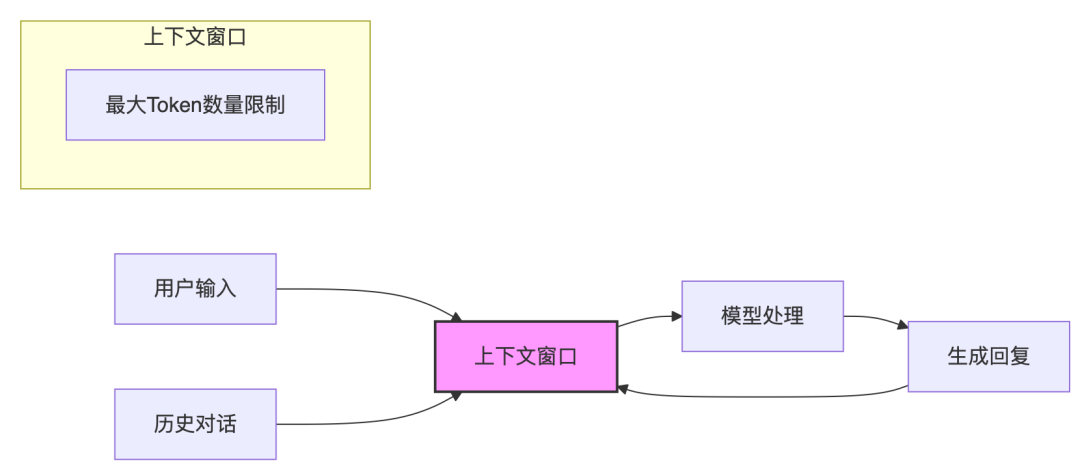

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

把无聊工作交给Agent,10倍效率归还人类

北大元培实验班出身、康奈尔大学毕业、阿里达摩院前产品总监的硬核技术创业者——杨劲松。 在他看来,AI 大模型是“大脑”,而 Agent 是赋予其行动力的“手脚”。如何让模型从“会说话”进化为“能干活”,正是他和团队正在解决的“最后一公里问题”。 一、从北大元培到达摩院,他为何选择创业? 杨劲松的人生履历并不缺光环:北大元培实验班、康奈尔大学计算机硕士、阿里达摩院 AI 产品总监。他坦言,自己一直是…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

企业级 RAG Agent 开发指南:RAG Agent 开发的 10 条实战准则

在生成式人工智能浪潮席卷全球的时代,企业与开发者们在追求高效智能解决方案的过程中,逐渐意识到单纯依赖大语言模型存在的局限性 —— 知识更新滞后、领域专业性不足、对噪声数据的脆弱性等问题日益凸显。检索增强生成(RAG)技术的出现,犹如一剂良药,通过将外部知识库检索与模型生成能力相结合,为 AI 应用开辟了新的发展方向。而 Douwe Kiela,这位被业界尊称为 “RAG 之父” 的资深研究者,凭借…- 3

- 0

-

人工智能也许是人类社会最后一次技术革命

“人工智能也许是人类社会最后一次技术革命,当然可能还有能源的核聚变。人工智能发展要经历数十年、数百年”。以上出自《人民日报》与任正非的对话。01AI NEWS如何理解看似武断的观点?我把工作交给DeepSeek,得到有价值的两点:一、人工智能发展的长期性,预示AI将具备自我优化能力,未来技术突破或由AI主导完成,人类直接参与技术创新的必要性降低;二、基于第一点,人类可能转…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

为什么说『RAG开箱即用』是最大的AI技术谎言?

近年来,随着大语言模型(LLM)的飞速发展,RAG(Retrieval-Augmented Generation,检索增强生成)技术逐渐成为处理复杂问题和生成高质量内容的“杀手锏”。它通过结合检索和生成两者的优势,让系统能够从海量数据中提取相关信息并生成准确、自然的回答。然而,RAG并非“开箱即用”的完美工具,要让它真正发挥威力,优化是关键。本文将带你深入探讨RAG技术的五大优化手段:索引优化、检…- 6

- 0

-

NVIDIA recsys-examples: 生成式推荐系统大规模训练推理的高效实践(上篇)

引言 在生成式 AI 浪潮的推动下,推荐系统领域正经历深刻变革。传统的深度学习推荐模型 (DLRMs) 虽已展现出一定效果,但在捕捉用户兴趣偏好和动态行为序列变化时,常面临可扩展性挑战。生成式推荐系统 (Generative Recommenders, GRs) 的出现,为这一领域带来了全新思路与机遇。 本文将介绍 NVIDIA recsys-examples 中针对生成式推荐场景设计的高效实践参…- 10

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

五大AI平台终极PK:Dify、RAGFlow、FastGPT深度实测,谁才是企业知识库Agent首选?

AI平台爆发时代,选型成关键难题 2025年,生成式AI技术已渗透到企业服务、知识管理、智能客服等核心场景。随着dify、RAGFlow、FastGPT、Coze、文心智能体等平台的崛起,企业面临一个新难题:如何从功能相似的产品中选出真正适配自身需求的工具 ?本文基于对五大平台的深度实测(包括本地部署、数据导入、RAG检索、工作流编排等核心功能),结合技术细节与落地场景,从易用性、扩展性、性能表现…- 33

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

RAG工程落地:回答内容和检索片段(chunk)对应关系追踪

在 RAG(检索增强生成)应用中,回答内容与检索片段(Chunk)的对应关系追踪是实现回答可解释性、准确性验证和错误溯源的关键环节。以下从追踪目的、技术实现等维度展开详细说明: 先看下效果,如下: 看一看到,大模型的回答中每句话都带有溯源标签。今天我们要实现该效果。一、为什么需要追踪回答与检索片段的对应关系? 事实性验证:确保回答中的信息来自可信的检索片段,避免大模型 “幻觉”(编造错误信息)。 …- 4

- 0

-

GraphRAG系统:利用LangChain、Gemini和Neo4j构建智能文档检索与生成解决方案

点击“蓝字” 关注我们在人工智能领域,基于私有文档的问答系统一直是研究和应用的热点。传统的检索增强生成(RAG)技术虽然已经取得了显著的进步,但由于其单纯依赖向量相似度,往往难以捕捉实体之间的重要上下文关系。为了突破这一局限,GraphRAG应运而生,它将向量搜索与知识图谱相结合,不仅能够理解语义相似性,还能深入把握概念之间的关系,为文档检索与生成带来了革命性的变革。本文将详细介绍如何使用Lang…- 5

- 0

-

实测百万token上下文模型MiniMax-M1:RAG真的要被淘汰了?

昨晚12点,我还在电脑前测试一个新模型,突然意识到一个问题让我兴奋得睡不着觉。 你有没有想过,如果AI能"记住"一整本书的内容,会发生什么?不是那种似是而非的"记住",而是真正的、完整的、一字不漏的记住。 前两天,MiniMax发布了最新模型——MiniMax-M1,直接把上下文拉到了一百万token! 这是什么概念?我花了一晚上测试,发现它相当于能一次性&…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

大厂经验,AI Agent 的进化:从“单挑”到“群殴”

大厂经验,AI Agent 的进化:从“单挑”到“群殴” 咱们今天聊一个硬核话题:AI 公司 Anthropic 最近公布了他们是如何构建 Claude 的“研究”功能的。这不仅仅是让模型能上网搜索信息那么简单,它背后是一套复杂的“多智能体系统”。 说白了,就是让一群 AI“打群架”。 如果你用过最新的 Claude,你可能会发现它能处理一些特别复杂的任务,比如让你“把标普500信息技术板块里所有…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 1

- 0

-

苏格拉底提问教销售更好使用Deepseek

导言葛光祥,公众号:价值销售晓之以理--主动连接产品与业务 在我们价值销售的理念中无数次提到销售提问在需求激发和动机激发的作用,特别是上面的《晓之以理--主动连接产品与业务》一文中提到10个提问技巧。 AI发展特别是Deepseep的出现改变了包括销售在内的所有行业,DeepSeek的提示词设计就是提问技巧的应用,今天我们将苏格拉底提问应用到Deepseek的使用中,将DeepSeek打造成24小…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!