-

RAG工程落地:处理文档中表格数据

在 RAG(Retrieval-Augmented Generation)工程落地过程中,处理文档中的表格数据 是一个非常重要但复杂的问题,特别是针对技术文档、报告、论文等结构化强的资料。比如PDF文档里的表格数据,如下: RAG处理表格数据的难点 所携带的语义信息是不足的,不利于后面的语义检索; 标题与数据割裂; 缺少上下文语义; Embedding 不适配结构化数据; 转换成纯文本后,行列关系…- 7

- 0

-

聊过 200 个团队后的暴论:不要拿 AI 造工具,要建设「新关系」

本文根据极客公园创始人&总裁张鹏在 Founder Park AGI Playground 2025 上的演讲整理而成。 今天团队给我的任务是「你这几年聊了所有 AI 领域的先锋创业者,能不能分享一下你的观察和收获」。 我先说说自己的感受吧,过去三年真的很「酸爽」。技术的进步和产品的创新,一开始是赏心悦目,转眼就成了应接不暇。跟上时代不被「拉爆」,需要加倍努力,其实每个人都很辛苦。 但这又…- 6

- 0

-

Dify1.5.0神级更新:变量监视+状态缓存,开发效率暴增200%!

现在dify的更新还是真快啊,感觉刚刚更新了1.4.3,现在又发布了1.5.0了。这次算是一个大版本的更新了,让我们来看一下这次的更新代理了哪些改善吧。 AgentLight" data-from="0" data-headimg="https://api.ibos.cn/v4/weapparticle/accesswximg?aid=116362&…- 9

- 0

-

从“一问一答”了解大语言模型的工作原理

你是否有过这样的疑惑: 当你问AI一个问题,它会思考片刻,然后开始逐字逐句往外“蹦出”答案。 AI这个“黑盒子”后面,到底发生了什么? 它真的在“思考”问题吗? 这个数字大脑是如何工作的? 让我们从一个简单的问答过程出发,来揭开大语言模型技术的神秘面纱。 第一步: 理解“输入” 想象一下,当模型看到你输入的文字,第一步不是像人一样直接理解语义,而是像处理一道复杂的数学题,需要先拆解、编码。 它把你…- 7

- 0

-

小模型也能“偷师”顶尖水准?详解三种蒸馏术,效果不输本尊!

你知道吗?大型语言模型(LLM)不仅能从海量的文本数据中学习,还能从其他LLM那里“偷师”!比如,Llama 4 Scout 和 Maverick 就是通过 Llama 4 Behemoth 这个更强大的模型训练出来的。谷歌的 Gemma 2 和 Gemma 3 也利用了自家 Gemini 模型的“经验”。这种模型之间的互相学习,靠的是一种叫做“知识蒸馏”的技术。今天,我们就来聊聊三种流行的知识蒸…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

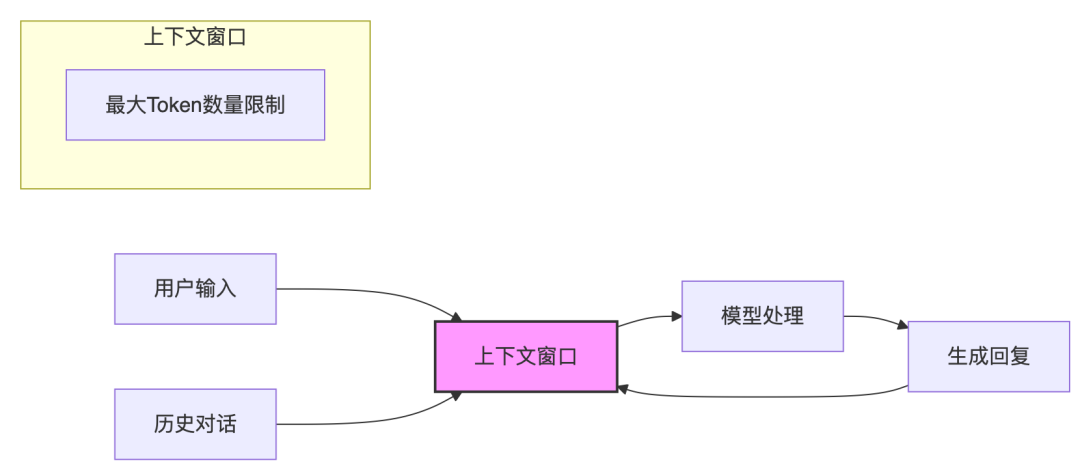

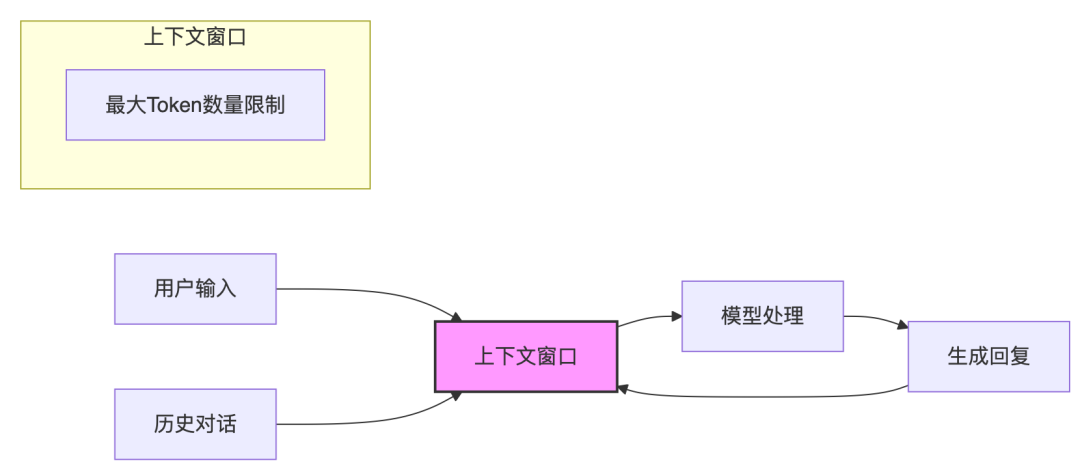

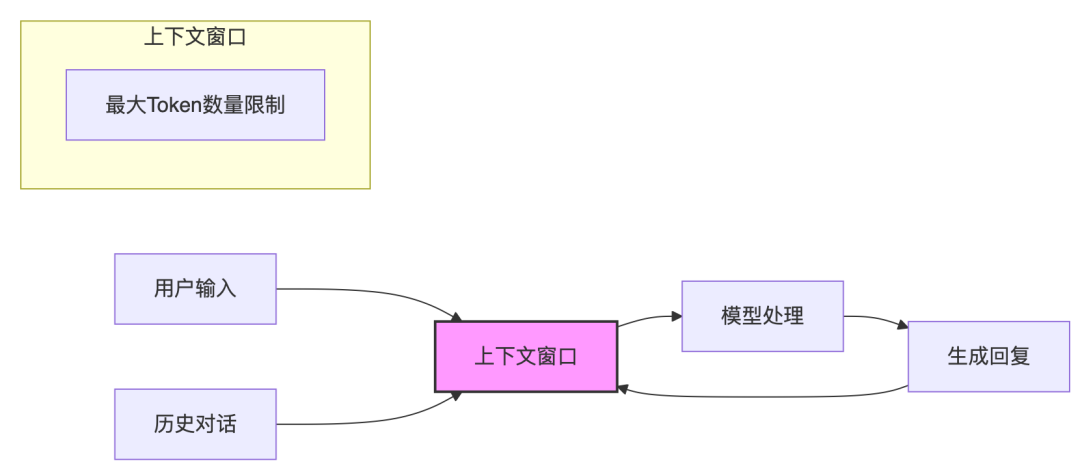

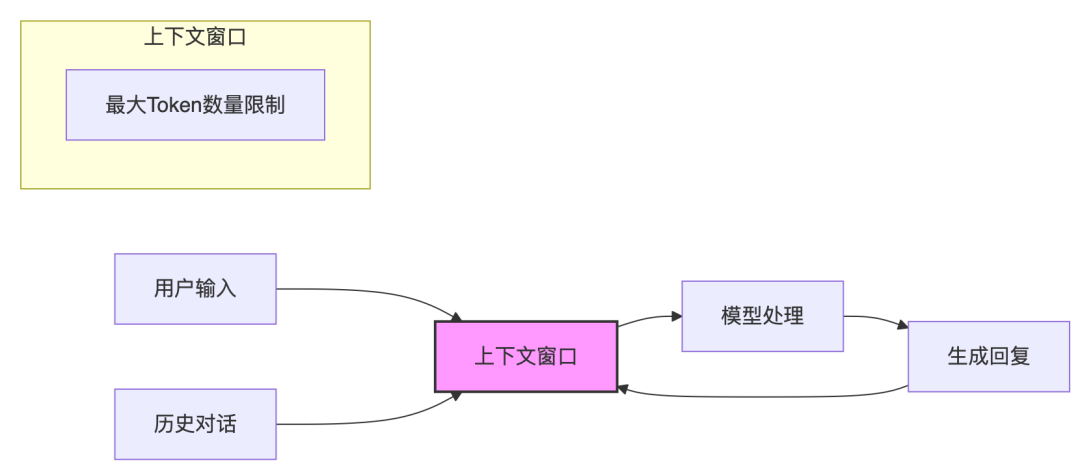

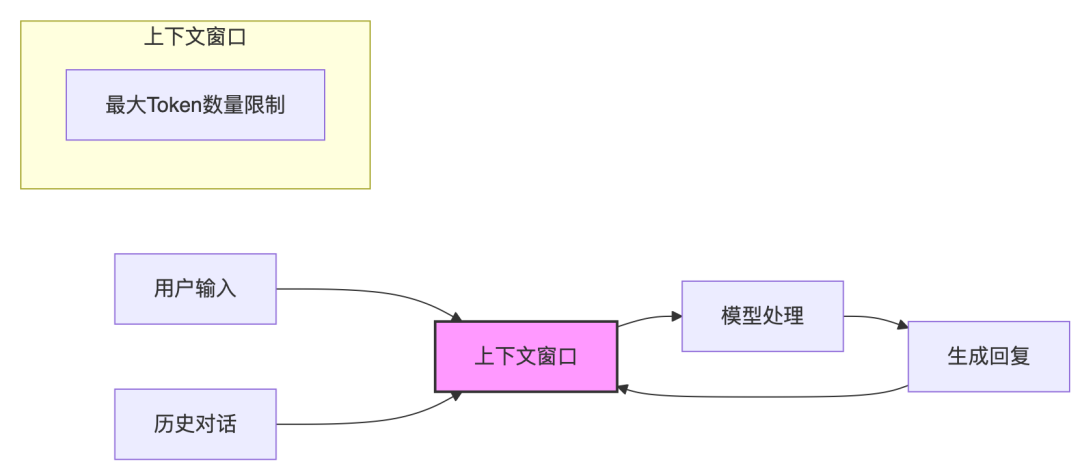

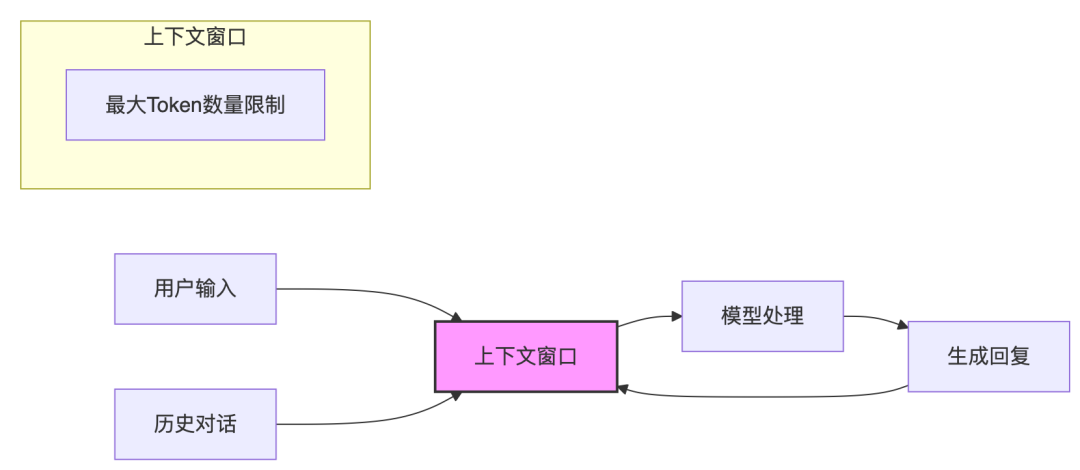

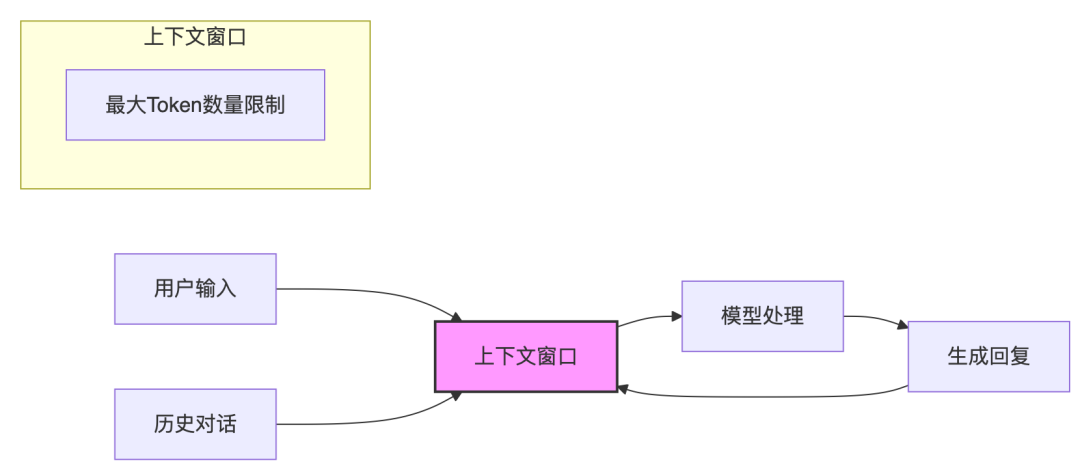

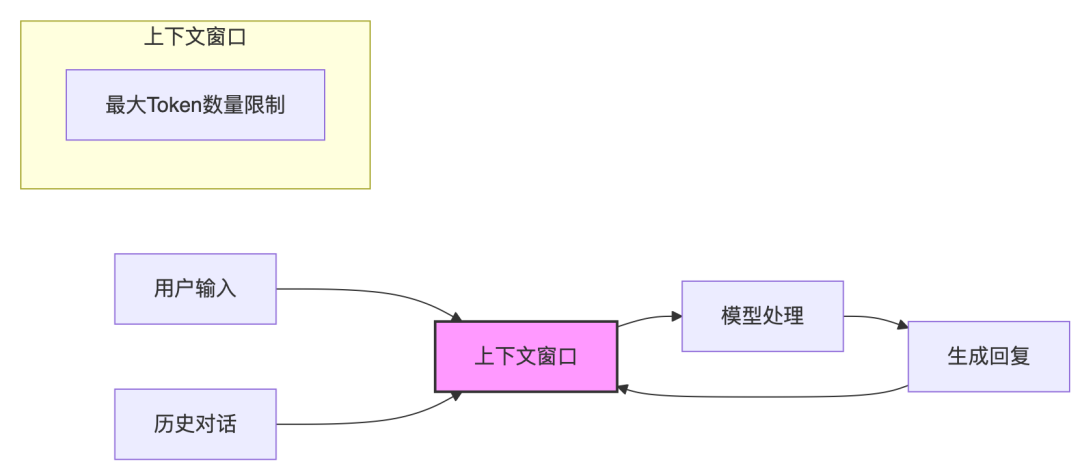

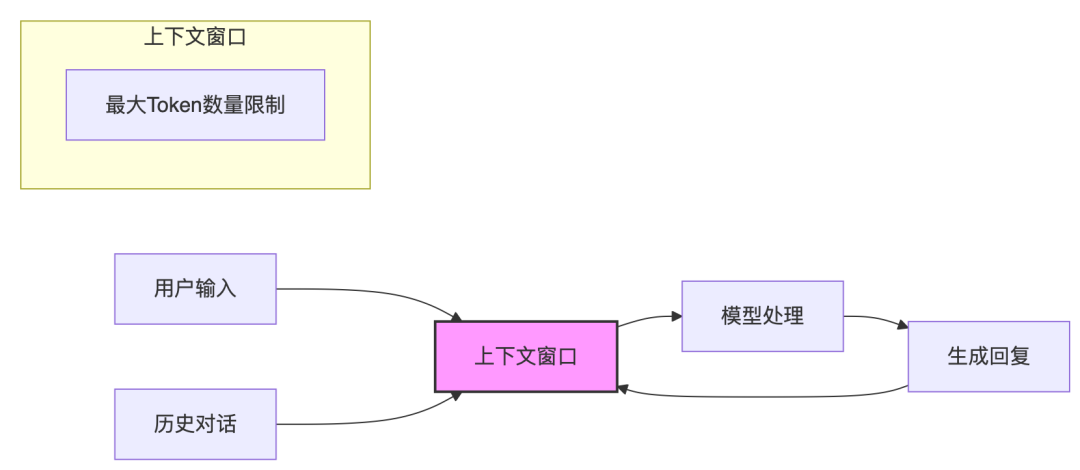

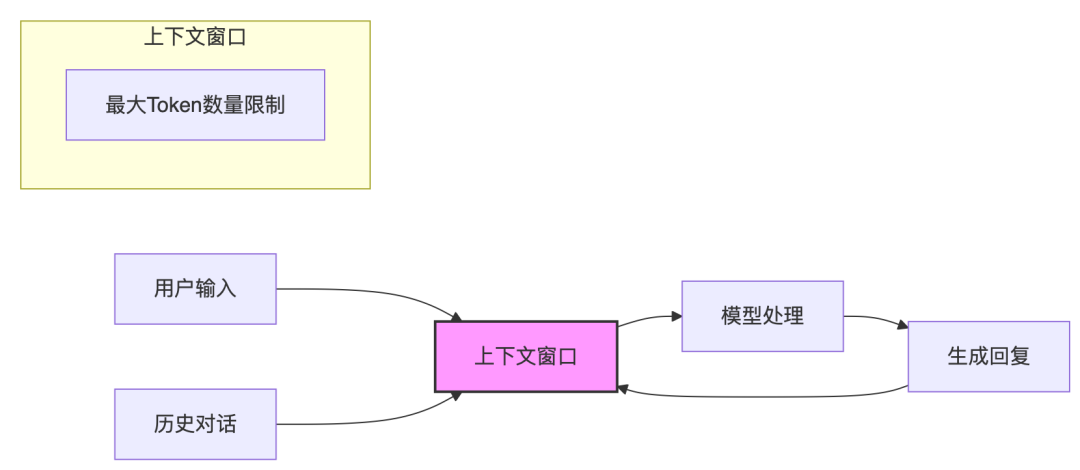

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

两小时给公司开发个新官网,来自 MiniMax 的震撼

说起官网就发愁 我们公司一直很“低调”,尤其是官网。其简陋程度,和公司在安全验证赛道的地位,形成了较大落差,以至于 Gartner 分析师一度以为这是个骗子公司。 于是,很多朋友私下提醒,你们该换换官网啦 看你们新的产品(陆吾),在官网都查不到 发布会都开完了,官网也没看到任何信息更新 你们也不做 SEO,搜索有效性验证都找不到知其安 官网好比人的脸,这看起来给人感觉不正规 用的商业图片,小心侵权…- 7

- 0

-

Doc2Agent“爬”了所有API文档,一键API,MCP简单了

我想问您一个问题:上次为了让AI代理调用某个第三方API,您花了多长时间写包装代码?一天?三天?还是一周?不过现在,Brandeis大学的研究者们带来了一个让人眼前一亮的解决方案——Doc2Agent,它能从API文档直接生成可执行,MCP可调用的Python工具,而且成功率还挺不错。 链接:https://github.com/coolkillercat/Doc2Agent [1] 真实世界的A…- 10

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

开发Agent,有哪些值得做的脏活累活?

做Agent,并不只是在那里摆弄大模型,有很多吃力但能显著改善用户体验的部分,才是我们应该重点关注的对象。最近吴恩达与LangChain 联合创始人的对话,聊到了目前最需要的Agent开发技能。我摘抄、总结、注解成文章。 https://www.youtube.com/watch?v=4pYzYmSdSH4 一、自动化已有业务流程的能力 把现实流程(如查询、审核、数据检索)拆成清晰、有序的子任务并…- 8

- 0

-

API对接AI Agent最佳实践

AI智能体将成为API的主要消费者。为应对这一趋势,企业需优化API,使其更易于机器读取。关键策略包括:完善OpenAPI规范,创建MCP服务器,定义清晰的错误响应,记录工作流程,考虑AI到API的标准,提供LLM优化的元数据,采用清晰的API设计,发展流量控制,构建丰富的开发者资源,加强安全性,遵循道德标准,找出货币化方法,并从DevRel转向AgentRel。 译自:How To Prep…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

Grok 4 来了! !7月4日后发布!专门针对编程模型进行大规模训练

Grok 3.5原计划于2025年5月上线,但被跳票直接被Grok 4取代了! 而且这次卷的方向很明确,就是编程模型! 6月27日,Elon Musk在X发文宣布,xAI团队正全力冲刺Grok 4版本,预计将在7月4日后正式发布。 Musk本人表示,Grok 4还需要一次大规模训练,尤其针对专用编程模型进行优化。 我个人感觉Musk和Grok团队终于醒悟了!开始大量参照借鉴Claude的成功经验,…- 22

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

落地角度看Agent搭建的稳妥到激进路线及VLLM图片分辨率策略

今天是2025年6月27日,星期五,重庆,晴 我们来看两个问题。 一个是Agent,看看推理大模型规划能力搭建Agent应用的一些变化,那些是稳妥、次稳妥、激进的思路。 一个是技术侧看文档智能,主要看多模态大模型的分辨率处理策略,看目前有哪些主流应对方案。 一、Agent应用搭建的5个问题 Agent的东西已经讲了很多了,Agent已经成为互联网的新流量入口。我们站在现在众多智能体产品,如Manu…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

AI+Agent的国家博弈与兵棋推演

编者荐语:本研究深入探讨了人工智能在政治—军事建模、仿真与兵棋推演中的应用,特别关注其在多国对抗场景(如大规模杀伤性武器、太空与网络战)中的潜力。AI不仅可用于重建敌方在不确定性下的决策逻辑,更有助于预测冲突升级路径与可能结局,提示灾难性后果的战略风险。作者融合理论推演、历史案例与模拟实验,提出集成多种AI能力的模型架构,展现出计算社会科学在军事博弈建模中的方法创新与战略价值,对未来AI辅助决策系…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 15

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!