-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

RAG 检索四件套全解析:模型、向量库、检索方式、排序器,一文选型不踩坑

想做智能客服、企业知识库、RAG 应用?你绕不开的问题是:该用什么向量模型?用什么库?用什么排序器?本篇一次讲清 一、向量模型 向量模型是整个语义检索链路的第一步,选错模型,后面再怎么优化都救不回来。 1.什么是向量模型?核心关注点有哪些? 一个文本 embedding 模型的核心目标是: 把文本映射成一个能表达语义的向量,供向量库做检索、排序或相似度计算。 我们选模型时,主要看这几个维度: 指标…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 7

- 0

-

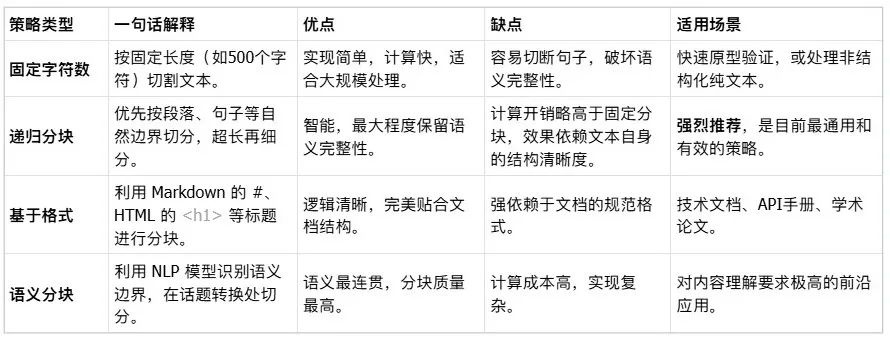

从0到1,彻底搞懂 RAG 分块的艺术(附开源代码)

你是否也曾困惑:为什么我的 RAG 系统总答非所问?明明喂给它了完整的文档,为什么还是抓不住重点? 答案可能藏在最基础、也最容易被忽视的一环 —— 分块(Chunking)。 分块是 RAG 系统的“数据预处理器”,它连接着原始文档和语义检索,是决定模型能否“读懂”资料、并给出精准回答的命脉。今天,我们就来一场深度探索,彻底搞懂 RAG 分块这门艺术。 为什么分块如此重要? 想象一下,让一个嵌…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

-

大规模RAG实施蓝图

RAG对于大型语言模型应用至关重要,它通过检索相关信息并传递给LLM来提高准确性和减少幻觉。大规模RAG面临扩展挑战,需要关注可搜索单元定义、检索策略选择、排序策略定义以及多个用例的影响,AI搜索平台需支持自动分块、高查询量处理和灵活的索引管道。 译自:A Blueprint for Implementing RAG at Scale[1] 作者:Kai Borgen 检索增强生成(RAG)[…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 2

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 1

- 0

-

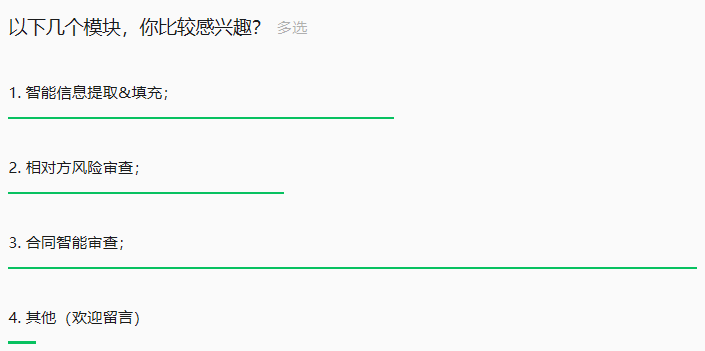

AI+合同审查落地分享(下-1- 合同智能审查)

按照AI+合同审查项目落地分享(中)文末投票结果,后续关于项目的分享会依照投票结果顺序进行。合同智能审查,我准备按照以下几个部分进行分享:一、产品设计 主要围绕几个问题展开: 1. 审查规则库的表结构? 2. 审查规则库在何时调用? 3. 审查规则的内容怎么写? 4. 如何在审查执行时最大限度抑制AI幻觉? 5. 这种方式…- 9

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 3

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!