-

关于一个RAG功能需求分析案例——、怎么优化RAG的检索精确度

“ RAG系统中,高质量的文档处理才是RAG系统的核心。” 手上有一个基于自然语言对话的系统,其功能就是根据提供的文档,能通过自然语言对话的方式去询问需要的文档和资料;其本质上来说就是一个RAG系统。 在之前一直强调说,RAG开发是一个入门五分钟,但要做好可能要五个月,甚至更久的一项技术;在之前对这句话还没有特别深刻的体会,但经过这个项目算是深有体会了。 RAG功能优化 刚开始做这个项目的时候,觉…- 28

- 0

-

踩了无数坑后,我终于搞定了RAG系统的”胡说八道”问题

去年接手公司的智能客服项目时,我以为RAG系统搭建起来就万事大吉了。结果上线第一天就被用户投诉轰炸: "问个信用卡年费,给我说了半天房贷利率?" "明明问的是申请流程,回答得乱七八糟,还缺了好几个步骤!" "这AI是不是在编故事?说什么限时优惠活动,我们银行根本没有!" 经过3个多月的摸爬滚打,总算把这些问题彻底解决了。今天把完整的解决方…- 31

- 0

-

dify案例分享-揭秘!如何用 Dify 实现多语言 PDF 文档原格式翻译

1.前言 支持PDF原文件文档翻译是指能够将PDF文件中的文本内容自动翻译成另一种语言,并且在翻译过程中保留原始文档的格式、布局和排版。这种翻译方式不仅提高了翻译效率,还确保了翻译后的文档在视觉上与原文档保持一致,便于阅读和使用。 支持PDF原文件文档翻译的工具通常具备以下特点: 1. 保持格式和排版:许多工具在翻译PDF时会尽量保留原文档的格式,包括字体、颜色、图片位置等。例如,SDL Tr…- 31

- 0

-

精准与效率:RAG应用PDF文档图文提取OCR策略

在RAG应用中通常需要对各种文档进行文本提取,如果稳定是纯文本那文档提取会简单很多,但通常文档中会存在各种图片信息,这时就需要使用OCR在提取文档文本信息的同时对图片进行OCR获取图片中的文本内容。本文只介绍PDF文档中OCR技术方案。PDF文档解析目前有不少开源框架亦可支持对PDF中的图片进行OCR,但此类框架通常比较重如Marker、Unstructured等。 这里只使用PyMuPD…- 12

- 0

-

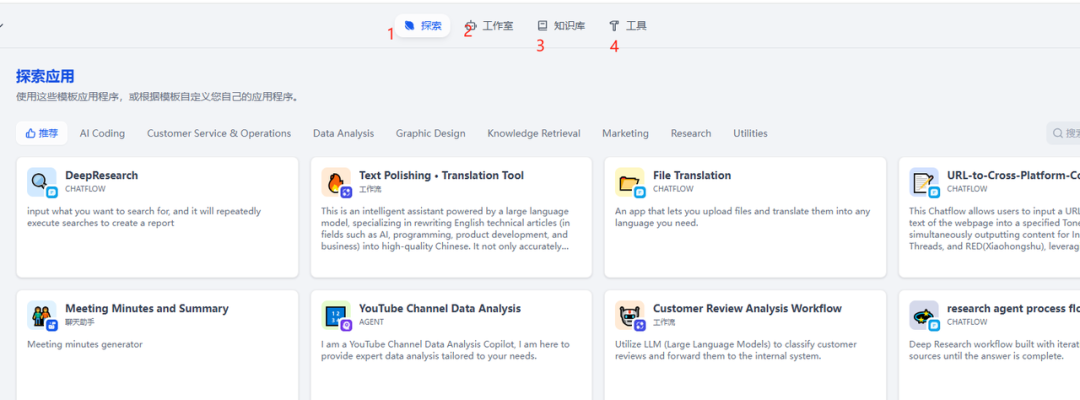

Dify知识库新手初体验行业知识库

字数 628,阅读大约需 4 分钟 知识库可以嵌套在dify流程中使用,出于快速验证知识库的使用,选择一个最简单的应用来进行实验。 Dify主界面介绍 下面这个是进入Dify的主界面,社区版本的所有功能都在这里。红色数字标识的地方,就是Dify提供的主要功能。dify主要功能简介 探索:官方提供的模版。个人不推荐新手使用,官方模版细节很多,需要调配的东西很多,需要学习解决的问题太多。工作室:这…- 23

- 0

-

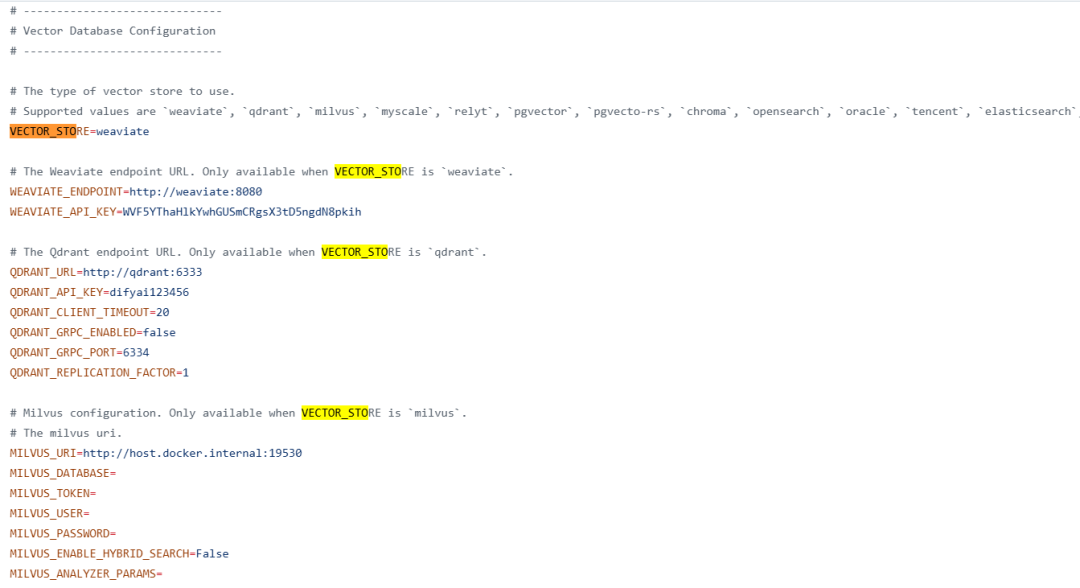

聊聊Dify如何集成Milvus向量库做RAG

概述 在dify集成Milvus向量库,做RAG知识库的存储与检索。 Dify[1]是一个开源平台,旨在通过将 Backend-as-a-Service 与 LLMOps 相结合来简化人工智能应用程序的构建。它支持主流 LLMs,提供直观的提示协调界面、高质量的 RAG 引擎和灵活的 AI Agents 框架。凭借低代码工作流、易用的界面和 API,Dify 使开发人员和非技术用户都能专注于创建创…- 14

- 0

-

RAG + Claude的1TB大文档问答系统实战操作

最近我和一个律师亲戚聊AI时,问了我应该怎么对现在律师事务所庞大的文档做AI检索,从技术上讲用现在的LLM+RAG可以满足需求,但细想不太对劲,因为这里面涉及到很多专业知识,还有律师的专有思维路径,一个不懂律师业务的程序员肯定是做不好的,于是有幸跟他们合伙人进行了深入沟通,合伙人说了一堆但我总结下来就这么一句话 “一个能回答我们所有文档相关问题的工具”。 比如:1)描述法庭上发生的事件,2)提…- 15

- 0

-

RAG召回质量翻倍的两个核心技术:我是这样解决”找不准”问题的

最近在优化公司的知识问答系统时,遇到了一个让人头疼的问题:明明知识库里有相关内容,但LLM总是回答"我不知道"或者答非所问。经过深入分析发现,问题出在RAG的召回环节——检索到的文档片段要么不够相关,要么上下文支离破碎。 经过一番折腾,我找到了两个特别有效的解决方案:索引扩展和Small-to-Big策略。今天就来分享一下这两个技术的原理和具体实现,希望能帮到有同样困扰的朋友。…- 7

- 0

-

测试不同的RAG技术以找到最佳方案

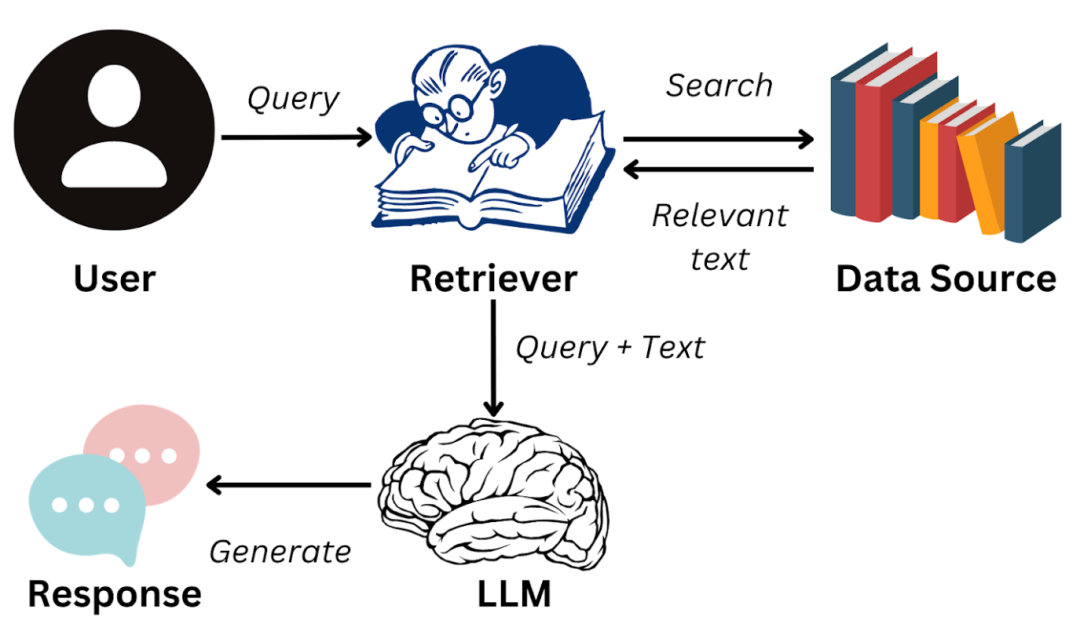

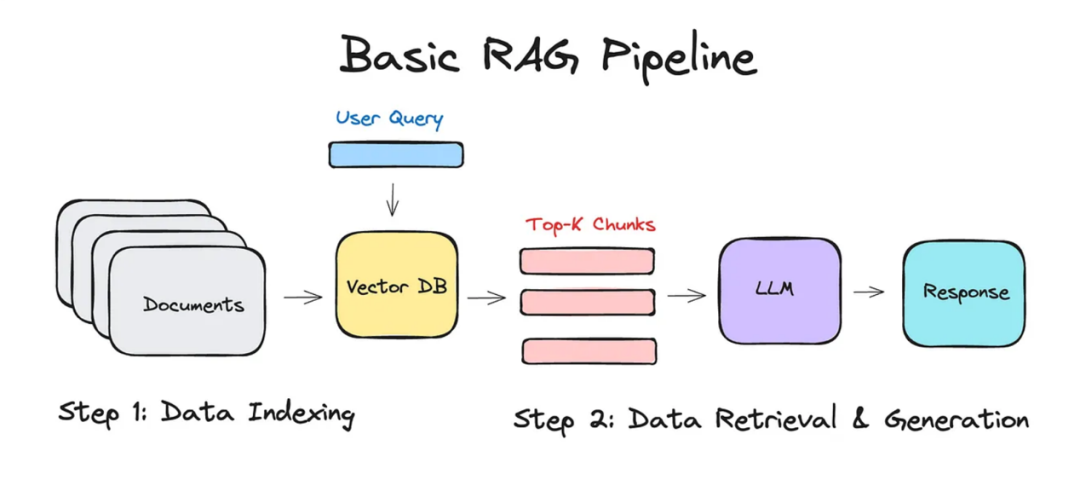

点击“蓝字” 关注我们检索增强生成(RAG)技术通过结合大型语言模型(LLMs)与外部数据检索能力,能够提供准确且富含上下文的答案。无论是构建客户支持聊天机器人还是研究助手,RAG都能通过从数据库中提取相关信息来增强AI的性能。然而,不同的RAG技术在性能上存在差异,选择最佳技术需要进行测试。本文将全面探讨各类RAG技术,包括基础方法和高级手段,并对它们进行评估,以帮助您根据需求选择最合适的技术。…- 9

- 0

-

Spring AI + Milvus 实现 RAG 智能问答实战

引言 “公司的文档太多,查找信息太慢!”、“客服回答总是千篇一律,不能精准解答用户问题!” —— 这些痛点背后,是传统关键词搜索和规则引擎的局限。如今,语义搜索(Semantic Search) 和 检索增强生成(Retrieval-Augmented Generation, RAG) 正成为解决这些问题的利器。它们能让应用“理解”用户问题的真正意图,并从海量资料中精准找出相关信息,甚至生成自然流…- 12

- 0

-

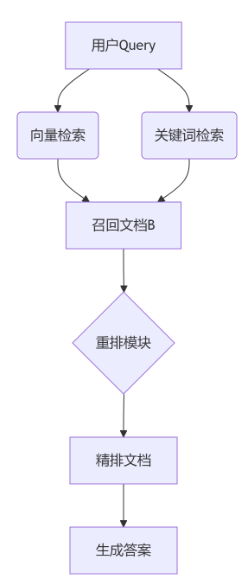

AI问答系统崩溃?这篇RAG优化实战指南,教你解决90%的检索问题

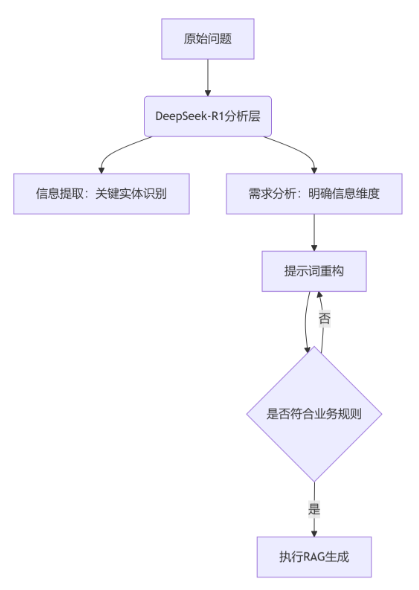

在人工智能快速发展的今天,RAG(检索增强生成)技术已经成为企业级AI应用的核心组件。然而,很多团队在实际应用中都会遇到一个共同的痛点:用户提问模糊不清,系统检索效果差,最终生成的答案质量堪忧。 经过大量实践验证,我总结出了一套完整的RAG知识检索优化方案。今天就来分享这套从查询理解到结果重排的完整技术路径,帮助大家打造高质量的知识问答系统。 问题的根源:为什么RAG效果不理想? 在深入解决方案之…- 11

- 0

-

Dify 技术文档工程实践:如何构建面向 AI 时代的知识系统?

如果文档是产品的一部分,你希望获得怎样的阅读体验?文档又应该以何种姿态面向新读者——即无所不在的 LLM? 大家好,我是 Allen,来自 dify 的技术文档工程师。 从 2025 年 4 月开始,我主导并完成了 Dify 帮助文档框架的一次全量迁移工程——从 Gitbook 到 Mintlify。完成从调研选型、Demo 实测、样式兼容、链接重构到最终上线的全过程。这不只是技术栈的替换,更是一…- 15

- 0

-

抢先体验 Deep Research 预览版

我们很高兴地宣布,在企业级 AI 智能体平台 Azure AI Foundry 中,正式推出 Deep Research 公共预览版。这是一项新功能,提供 API 和 SDK 的调用形式,可助力开发者轻松构建具备“深度研究”能力的智能体。借助 Deep Research,智能体可以实现从海量网页中自动规划、抓取、分析并整合信息,实现真正完成一整套复杂的研究任务。不仅如此,整个过程透明可追溯,结果也…- 12

- 0

-

基于MCP-RAG的大规模MCP服务精确调用方法

编者荐语Model Context Protocol(MCP)作为连接LLM与现实世界的“万能接口”,其重要性日益凸显。然而,在面对海量用户请求和动态变化的MCP服务集群时,如何高效、精准地获取所需服务,并突破LLM同时管理和调用大量MCP服务的“提示膨胀”瓶颈,成为摆在技术团队面前的一大挑战。本文创新性地提出将检索增强生成(RAG)理念,构建“MCP-RAG”系统,引入MCP服务发现领域,深入探…- 6

- 0

-

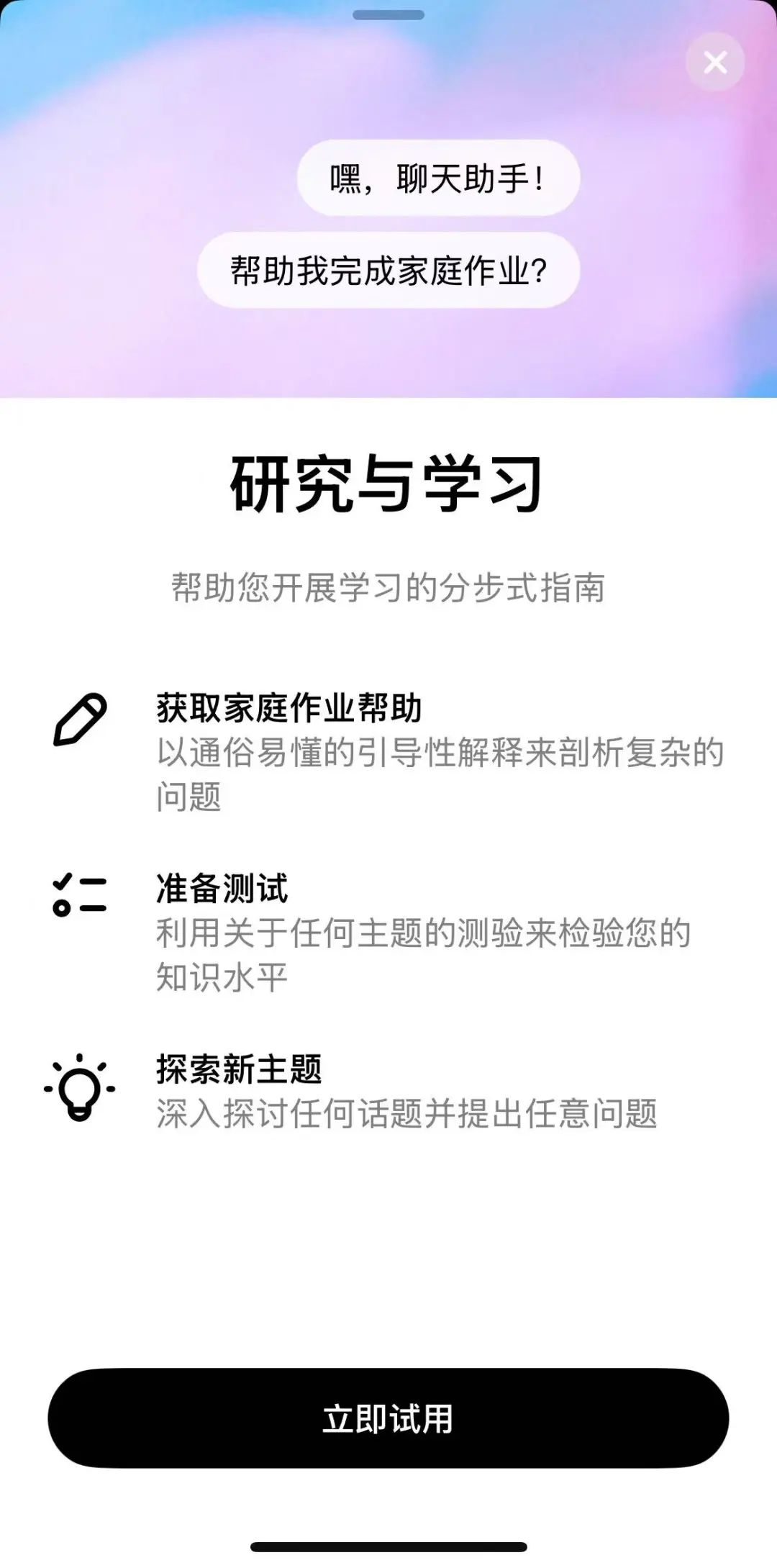

实测ChatGPT“学习模式”,它能成为你的专属AI家教?

今日,OpenAI推出了ChatGPT学习模式,学习模式专为大学生设计。 该模式主要面向教育领域,提供交互式提示、支架式回应、个性化教育、知识点检查四种方法,可以深度解读每一道难题的解题思路和流程,而不是仅仅给出答案。 当学生使用学习模式时,系统会提供引导性问题,根据他们的学习目标和技能水平调整回答内容,从而帮助他们建立更深入的理解。学习模式生动有趣且互动性强,旨在帮助学生真正掌握知识——而不仅仅…- 9

- 0

-

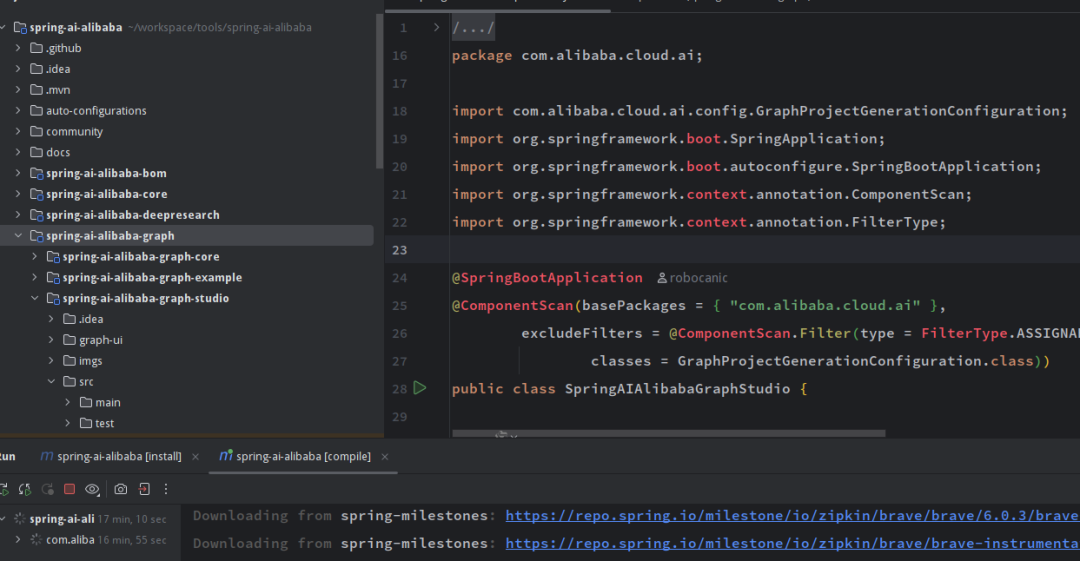

零改造实现 DIFY 性能提升 10 倍的一次实践

通过将 dify 可视化开发的应用转换为 Spring AI Alibaba,既能充分的利用 Dify 可视化界面高效搭建 AI 应用的优势,又能充分利用 Spring AI Alibaba 框架带来的灵活性与高性能,可以更灵活的应对更复杂多变的 AI 业务开发场景。 经过压测,与直接在 …- 31

- 0

-

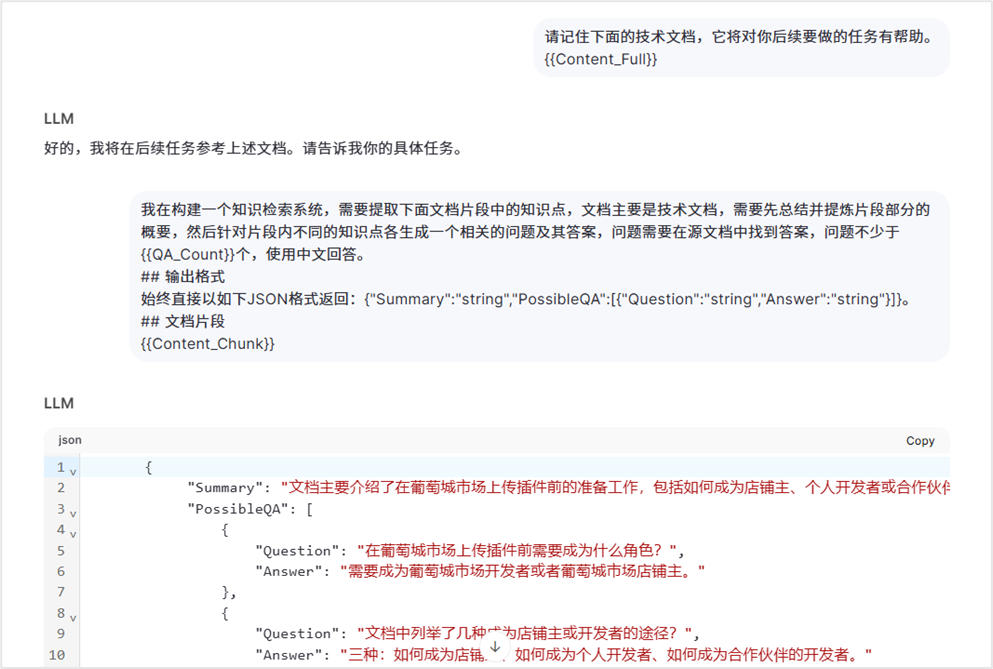

优化 AI 问答准确率:知识库实践与避坑指南

上次分享了关于知识库切片方案后,收到了很多朋友的反馈和讨论,甚至还发生了一些小插曲,但大家的关注和认可让我更加坚信这个方案的价值。这次,我将延续上次的内容,深入探讨如何将知识库切片方案优化为问答对模式,以及我们在实际落地 RAG (Retrieval Augmented Generation) 过程中遇到的常见难点和具体的解决方案。希望我的经验能帮助大家少走弯路!一、附件与图片如何存储?告别“污染…- 12

- 0

-

All in AI 现状盘点|口号、投入与落地的真相

长文拆解 7 家来自消费电子、医疗体检、广告营销、互联网、运动健身、在线教育、电视终端等行业的“AI宣言”与落地成果,一起来看看这场AI大跃进的真实进展。 2023 年是 AI 爆发元年,2024 年则是“All in AI”的集体狂欢年。从科技公司到教育平台,从银行到建筑业,几乎所有行业的头部玩家都在押注 AI、喊出“全力投入”的口号。一时间,“AI”从前几年还属于CTO范畴的“技术投资”,迅速…- 7

- 0

-

RAG召回优化完全指南:从理论到实践的三大核心策略!

在构建RAG(检索增强生成)系统时,我们经常遇到这样的问题:明明知识库里有相关内容,但检索出来的结果却不够准确。用户问"如何提高深度学习训练效率?",系统却返回了一堆关于深度学习基础理论的文档,真正有用的优化技巧反而被埋没了。 这个问题的根源在于召回环节的不足。召回是RAG系统的第一道关卡,它决定了后续生成的质量上限。今天我们就来深入探讨三个核心的召回优化策略,并提供完整的代码…- 7

- 0

-

dify 1.7.1版本全面解析:新特性、改进与升级指南

2025年7月28日,dify发布了1.7.1版本。这次更新不仅修复了多个关键问题,还带来了许多新功能和性能优化,极大地提升了用户的产品体验与开发效率。本文将从新特性介绍、主要修复与改进、升级指南等多角度详细解读dify 1.7.1版本,帮助开发者和用户深入理解和快速上手新版本。 一、dify 1.7.1新特性剖析 1. 默认值支持:Select输入框新增默认值选项 在表单设计中,灵活设置选择…- 21

- 0

-

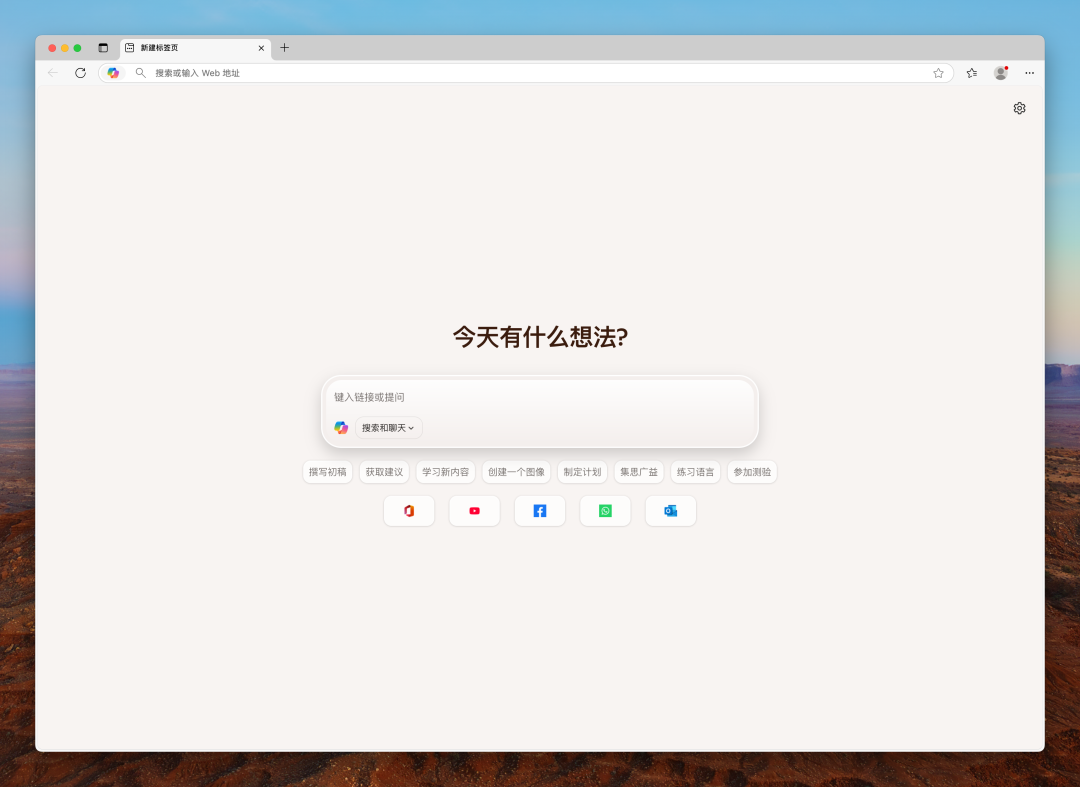

微软进军 AI 浏览器,维持巨头的平庸

Edge 能读懂网页了,仅此而已。 作者|薛星星编辑|蒋浇封面|Edge 截图 经过了两年对 Edge 浏览器 AI 功能的小修小补之后,微软在今天为 Edge 浏览器加入 Copilot 模式,正式进军 AI 浏览器市场。 具体来说,Edge 浏览器中的 AI 功能不再像以前一样只是一个聊天侧边栏,新推出的 Copilot 模式可以让 AI 阅读和理解网页内容,比如帮你做一个技术文档页面的解读或…- 9

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 7

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 5

- 0

-

🧠 大模型到底厉害在哪?看完这篇你就懂了!

你有没有想过:我们每天用的 AI 大模型,比如 ChatGPT、文生图的 Stable Diffusion,到底“脑子里”是什么?今天,我们不讲代码、不讲数学,用最通俗的语言带你看懂大模型的“思考空间”到底是什么!⸻🌟 01 | 大模型的大,到底大在哪里?我们说 GPT-3、GPT-4 是“千亿参数的大模型”,这并不只是说“它很复杂”——而是它的“思考空间”特别大。举个例子:人脑里有很多神经元,而…- 4

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!