书接上文,我们上一篇文章实操了如何在本地来部署RAGflow,那如何将RAGflow作为知识库接入到dify,作为 Dify的外挂知识库?那这一篇文章,我们就来分享一下,如何操作的。

正式开始之前我们还要解决一个小问题,安装好的Dify,忽然就不能加载了。通过分析,应该是我们当时装RAGflow的时候,删除了Docker。这里应该也包含着Dify的docker。

那进入Dify的Docker目录下,执行docker compose up -d, 重新进行加载,然后再访问Dify,这次没有问题了。

那下面我们正式开始这次的正式介绍了。

RAGflow 添加模型

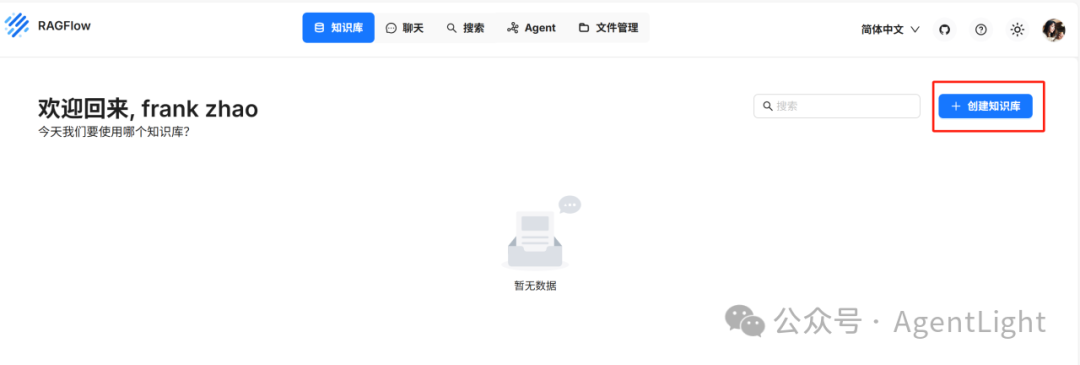

1. 首先来创建知识库。

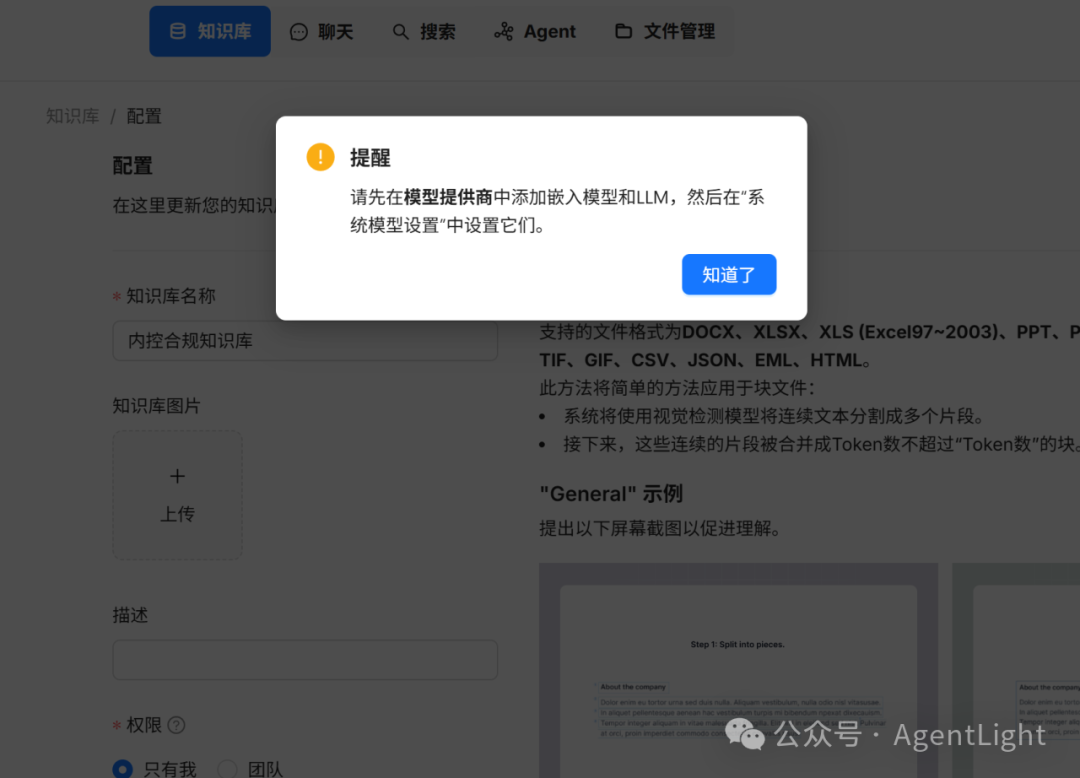

2. 首次使用提示我们先添加嵌入模型和LLM。

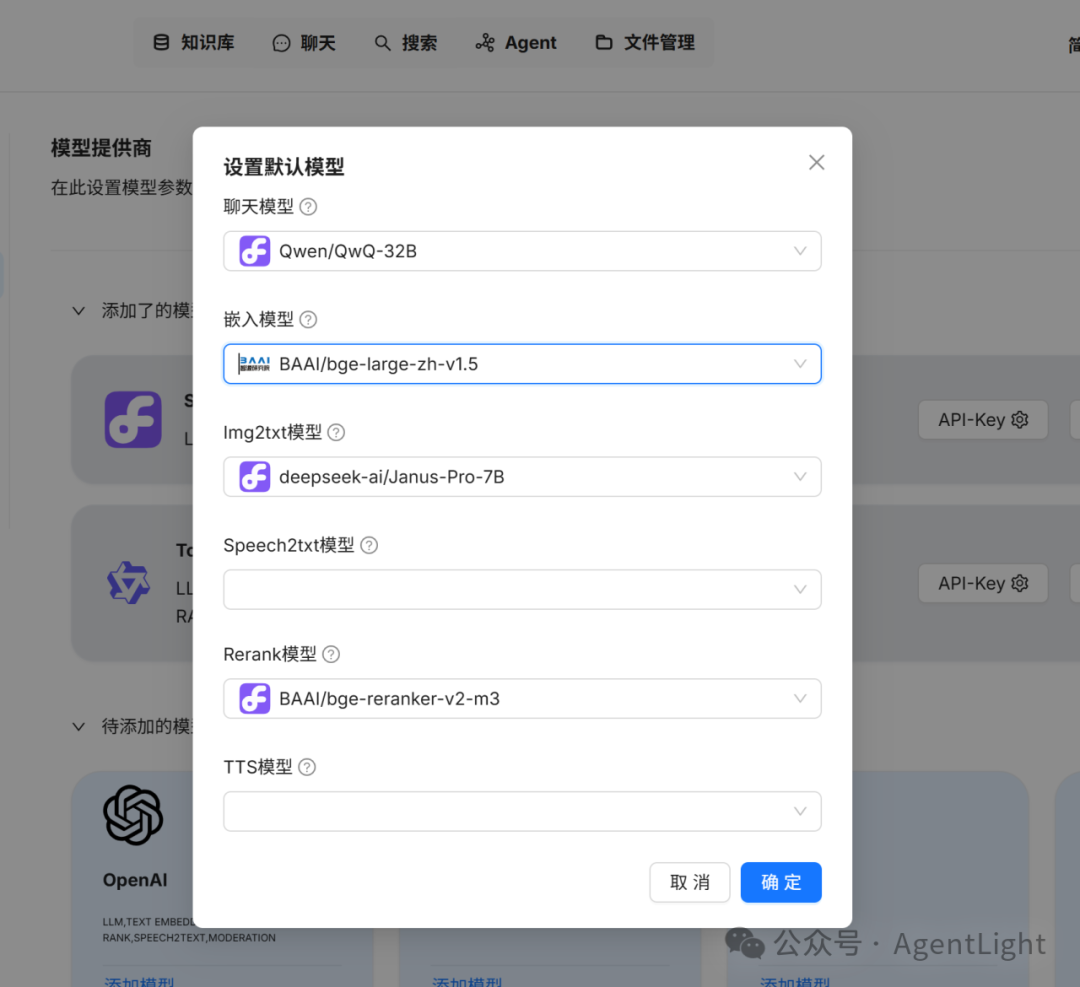

3. 通过配置Siliconflow的API key,添加上模型。

4. 设置默认模型,选择硅基内的一个LLM。

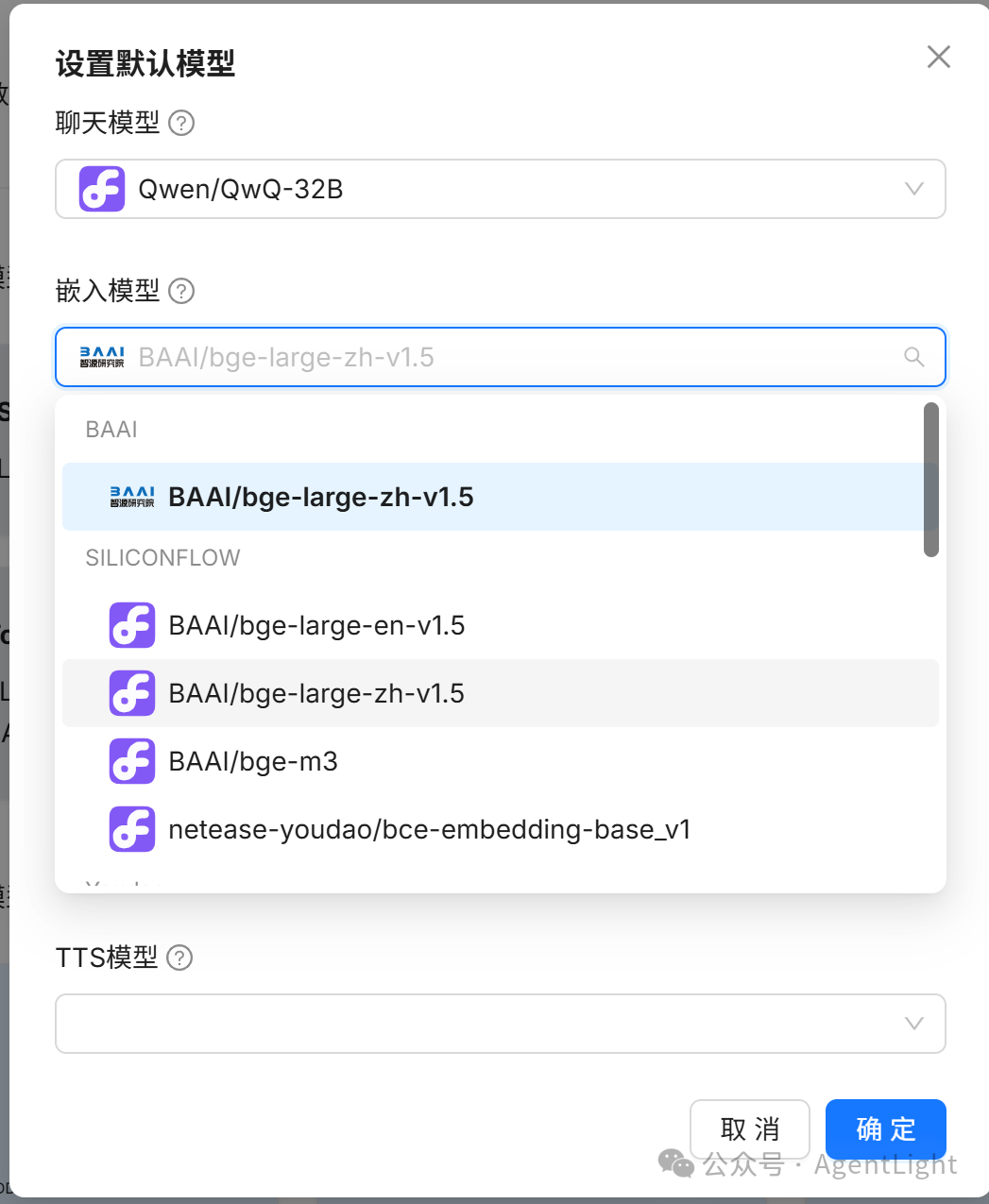

嵌入模型,包括有bge-large-zh/en 1.5, bge-m3, 还包括有网易有道的bce Embedding。

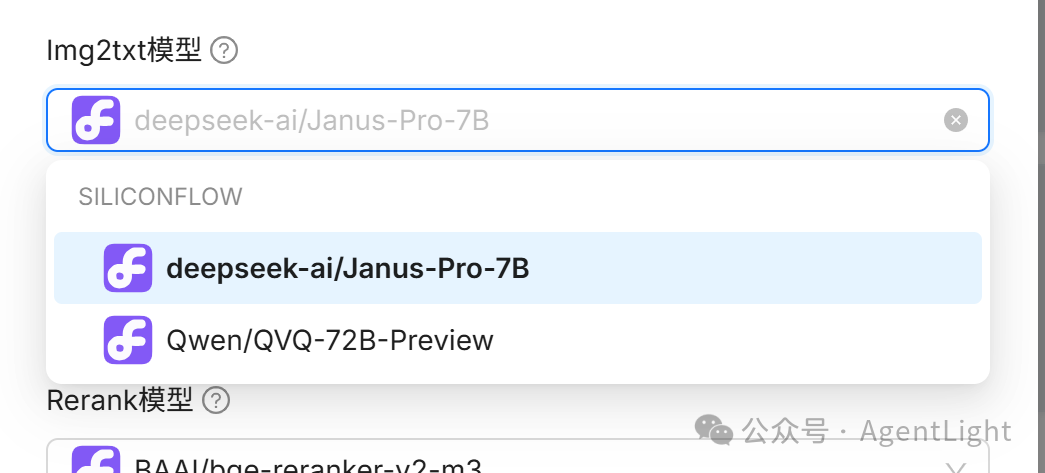

默认的图像转文字模型,内置的有Janus-pro,有优秀的文本生成图像和多模态理解能力。还有Qwen的QVQ-72B。

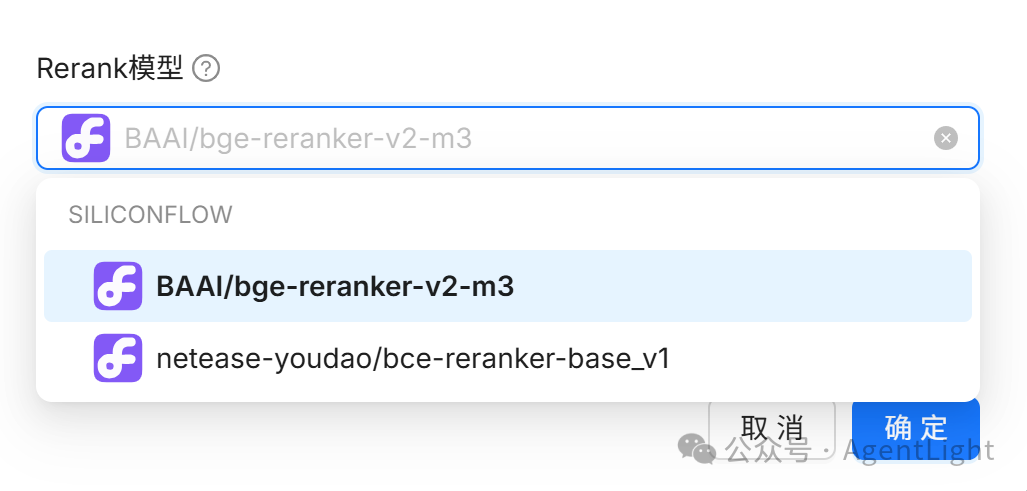

Rerank模型,默认选择bge-reranker-v2-m3即可。

RAGflow 新增知识库

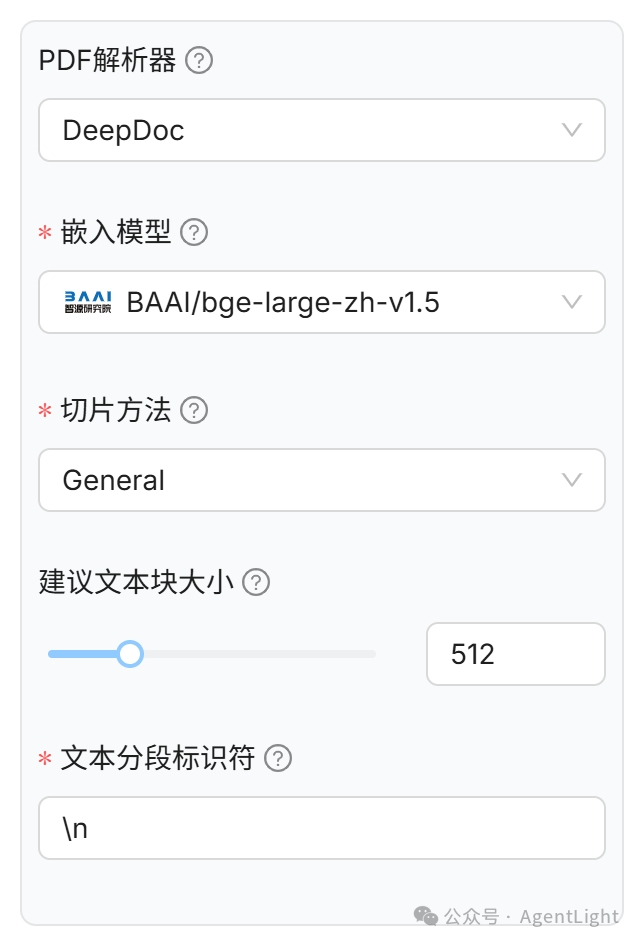

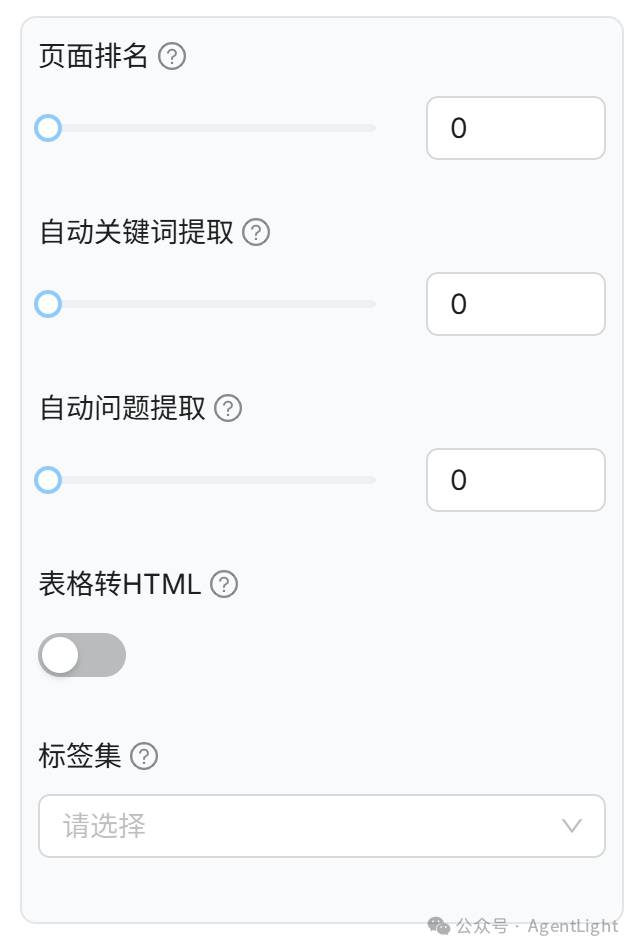

我们可以看到在添加的知识库中,所需要的配置还是比较多的,我们这里先进行Dify与RAGflow的关联调取。后面再详细的来介绍具体RAGflow的参数配置的含义。

有关配置

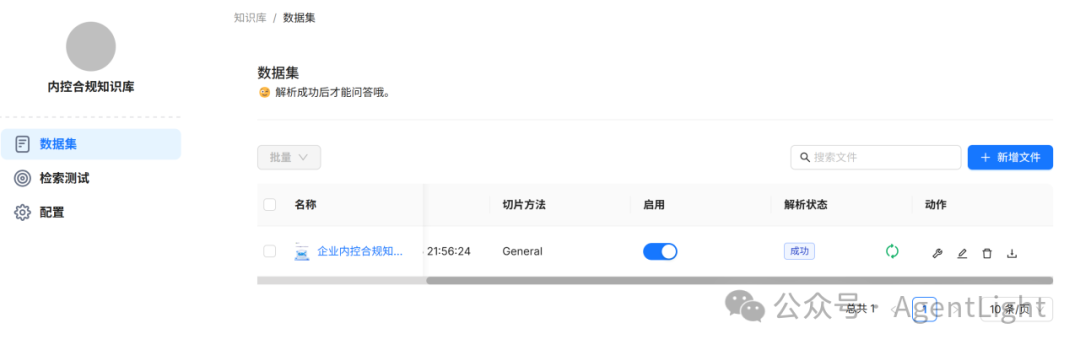

我们在添加具体的文件,上传我们需要解析的知识库文档。

上传文件时,可同步进行解析。

同时提供单个文件解析,同时也提供批量解析

忘记选择也没有关系,上传后可在进行解析。

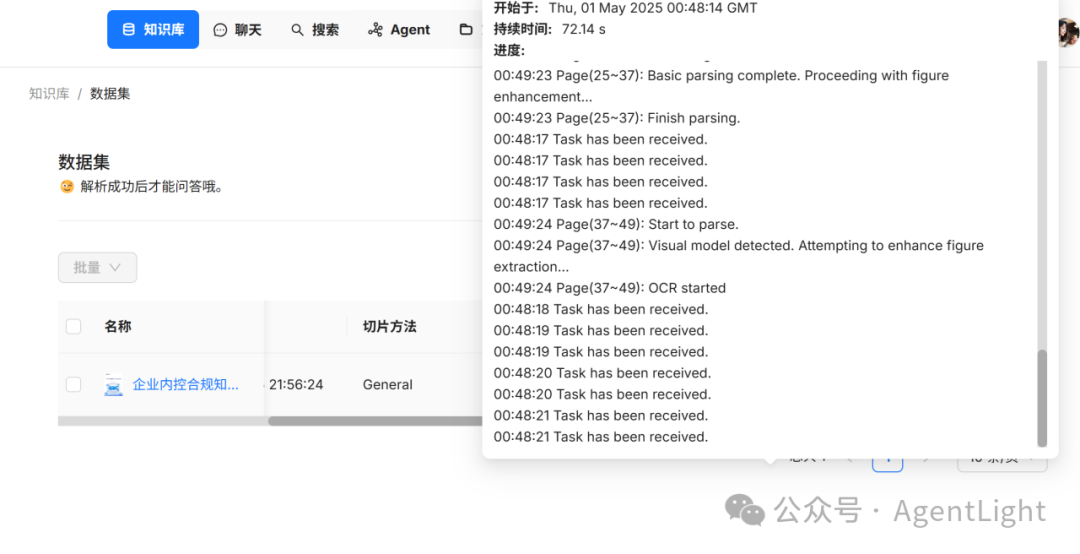

通过观察,发现整体的解析速度不是很快,然后等待了一段时间,发现整体文档的解析进度一点没有变。当时就怀疑肯定是有问题的,我们的文档10M都不到,不应该解析很慢。

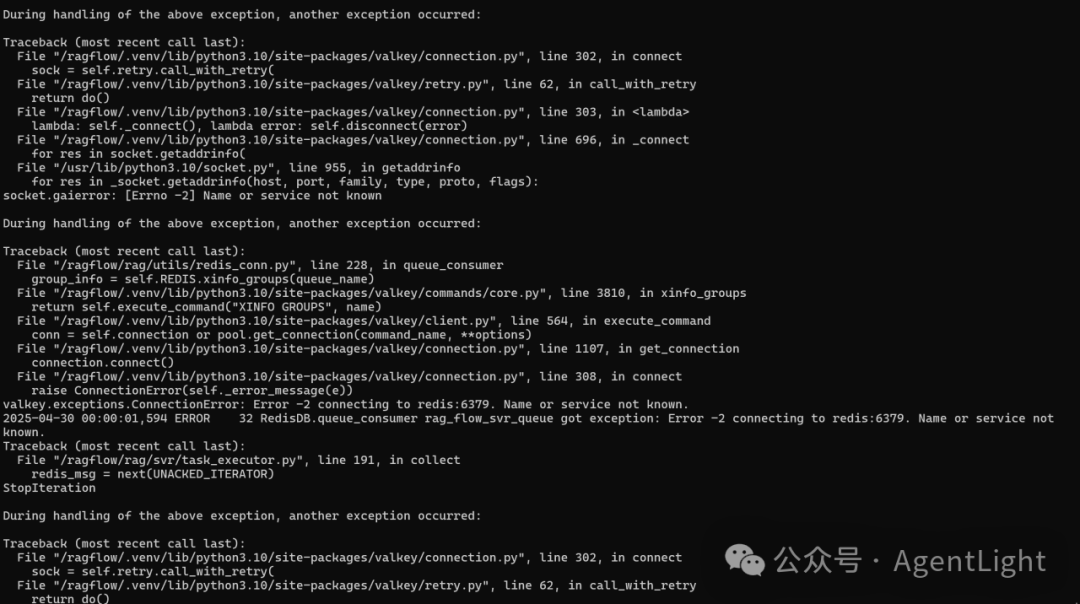

在docker中查看运行日志,发现有exception。

通过日志的查看,发现是无法连接到 Redis 服务,导致任务队列系统崩溃。

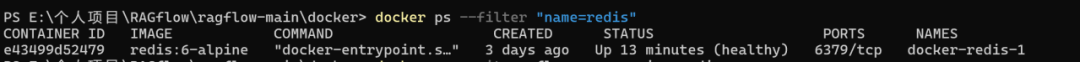

通过查询,docker的状态是up的。应该没有问题。

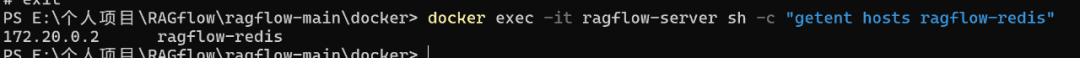

查看Redis 容器的 IP 地址,将这个地址在配置文件中进行修改。

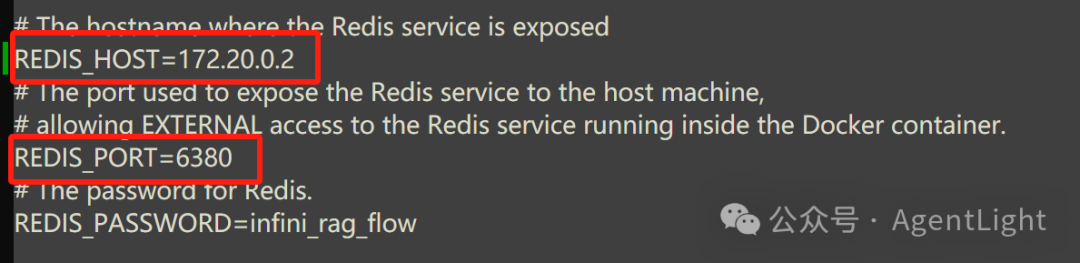

修改.env文件,一个是修改HOST,改为本地的IP,还有就是端口和dify的redis冲突了,这里也改为6380。

修改后,重新将docker重新加载,终于没问题了。

pdf文件的内容形式还是比较复杂的,有文字,有图片,有表格。解析的时间大概2分钟吧,不算很快。

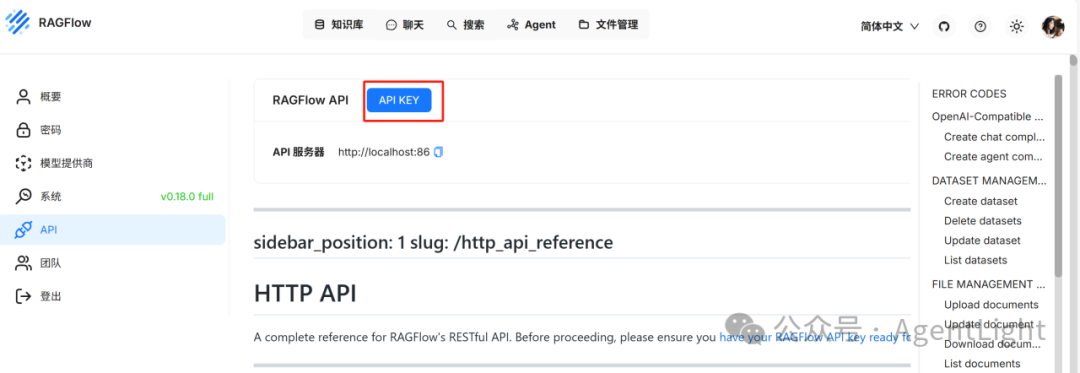

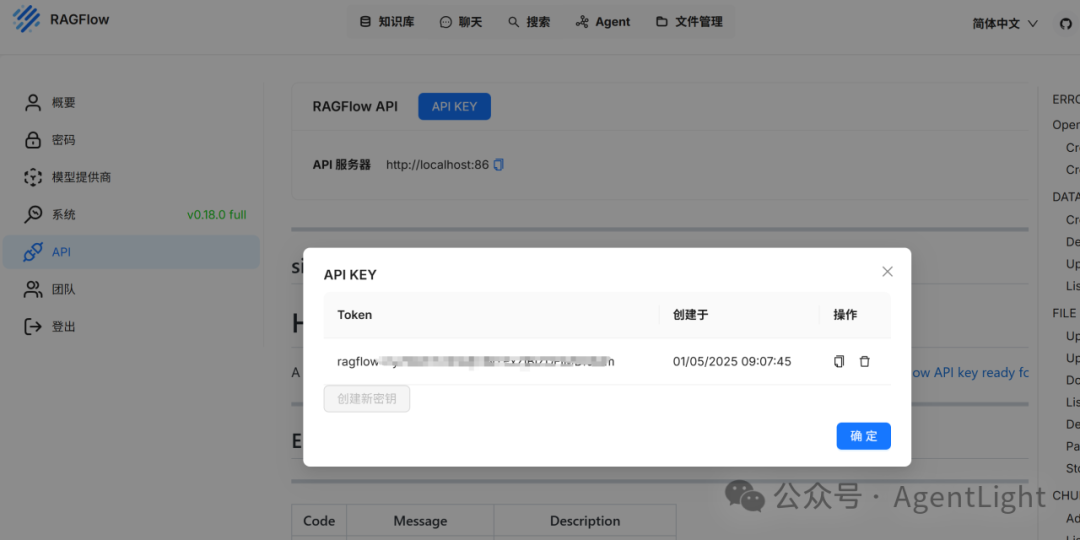

RAGflow API

在RAGflow的设置中,我们创建一个新的秘钥。

今天的文章先更新到这里,后续在介绍DIfy的功能配置。这里发现有一个大坑,redis有冲突,而且dify和ragflow会互相覆盖,这里有个明显的问题。后面就是攻克这个难题了。同时大家是如何配置的,也可以留言进行交流。