MCP 作为 AI 大模型的标准化工具箱,类似于 “通用语言” 或 “万能插座”,能够帮助大模型访问和操作外部工具,完成具体任务。如果我们能够灵活运用其中的多个 MCP 去解决一些任务,可能会达到事半功倍的效果。sequential-thinking 和 tavily

可能很多人都没听过 sequential-thinking 这个 MCP 服务,它能够让普通模型也能思考,而且不是一般的思考,它的最大价值在于,支持复杂问题的分步拆解、动态调整、分支推演和多方协作,适用于任何需要系统性思考、流程优化和创新探索的领域。其分支与反思机制,尤其适合面对不确定性高、路径多变、协作复杂的实际场景。

tavily 是一个为大型语言模型(LLMs)和检索增强生成(RAG)优化的搜索引擎,旨在提供高效、快速且持久的搜索结果,而且每月 1000 次免费额度使用

可到官网获取 API KEY 。https://app.tavily.com/

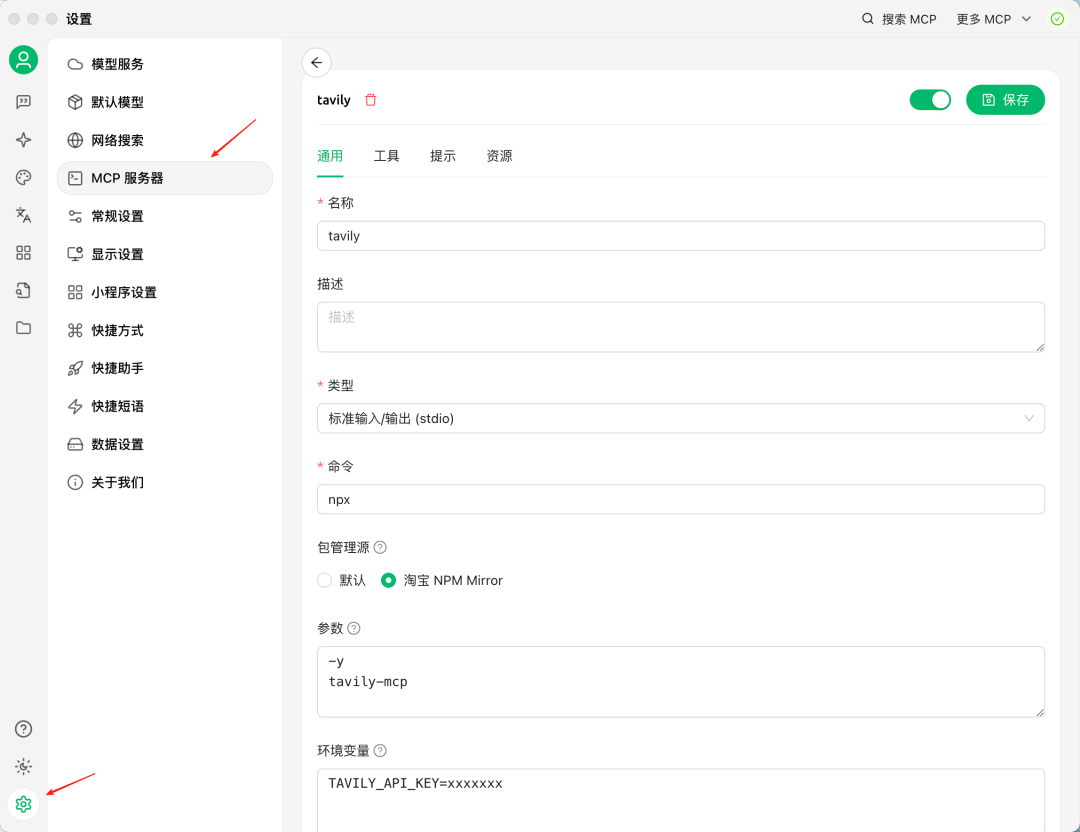

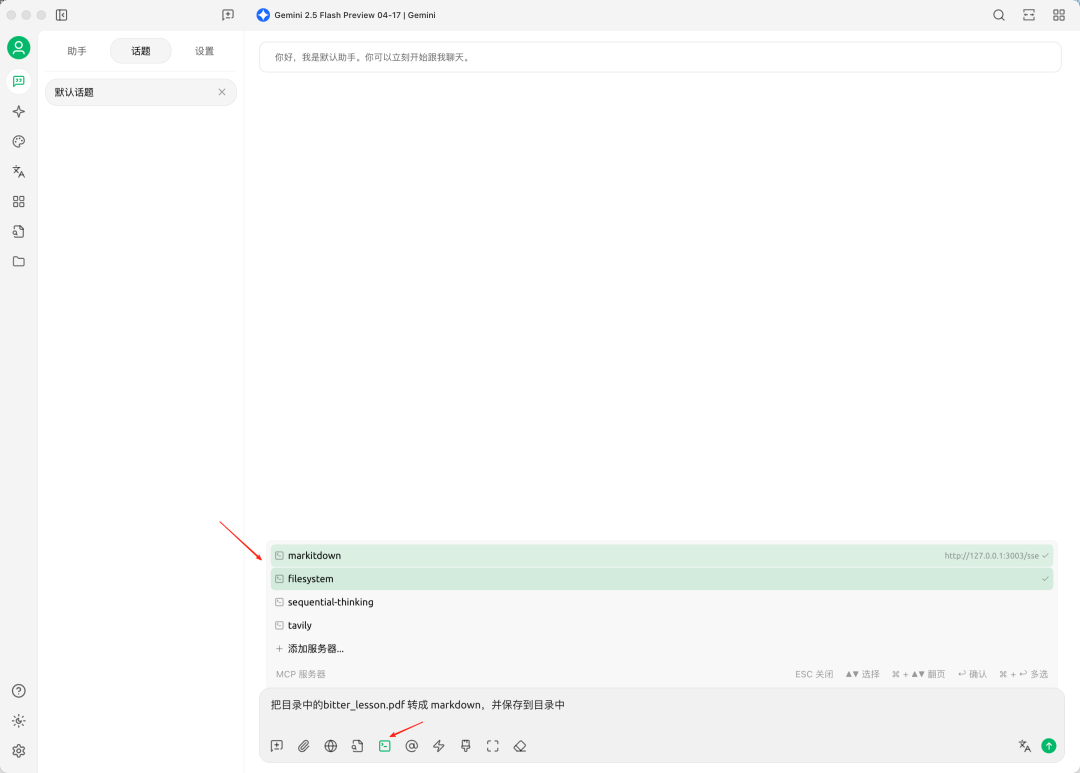

配置 MCP 服务器

配置 sequential-thinking,如下图所示

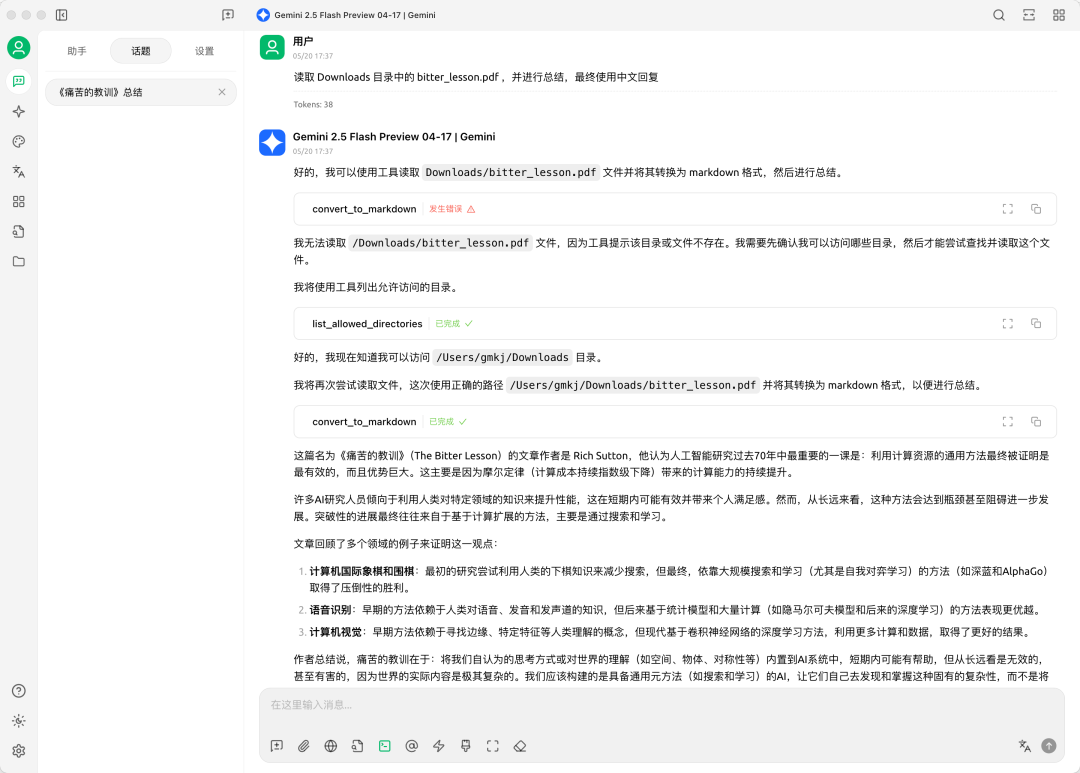

tavily,如下图所示

测试效果

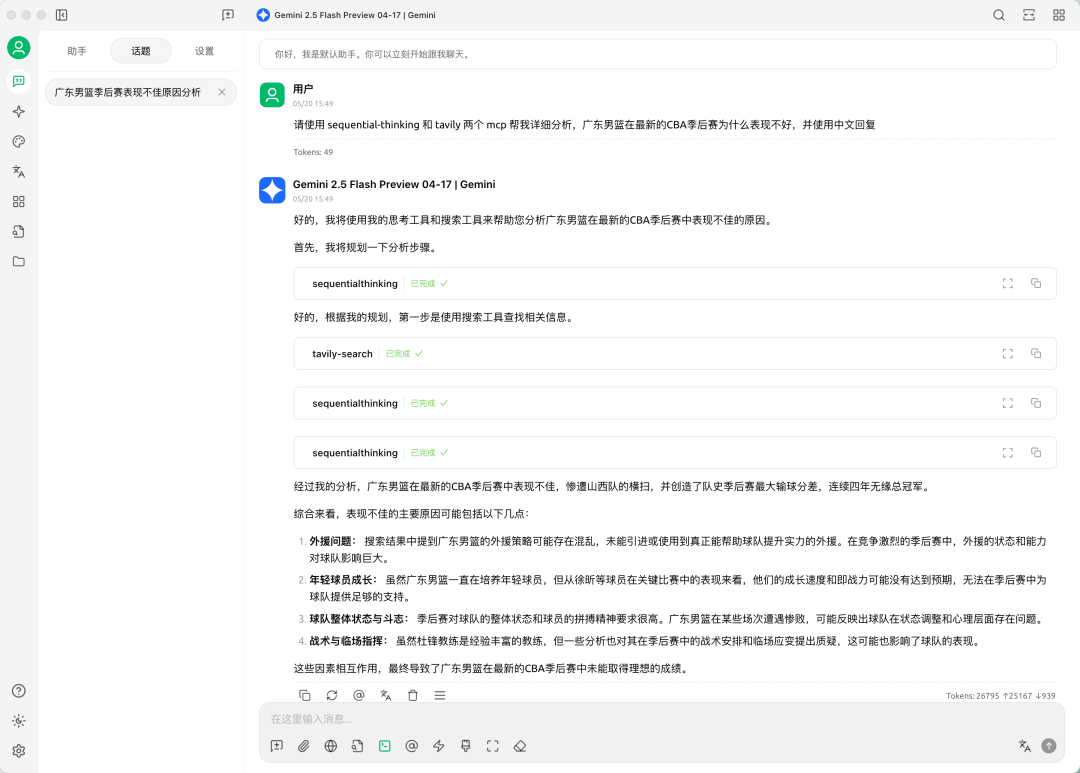

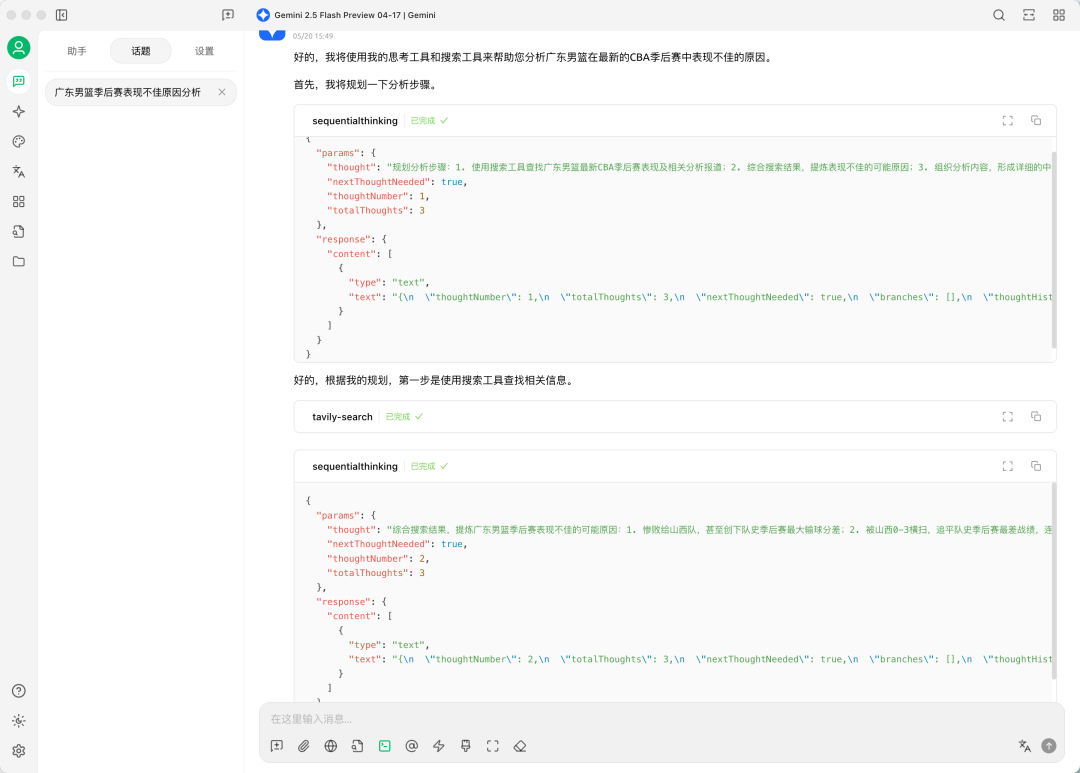

我们选择使用 Gemini 2.5 Flash 模型,然后配合上面添加的 sequential-thinking 和 tavily ,让它们帮我分析一下 "广东男篮在最新的CBA季后赛为什么表现不好" 的原因

从上图可以看到,模型先进行了一次 sequential-thinking,然后就开始调用 tavily 进行搜索,最后又连续调用了三次的 sequential-thinking,接着最终给到了我们分析的结果

sequential-thinking 进行了问题的分步拆解,然后再进行总结分析总结

凡是用 Workflow 的地方,都适合用 SequentialThinking。只要一个任务有 Workflow,我们都可以让 SequentialThinking 来分步拆解、规划、执行

它还能够配合很多不同的 MCP,实现更加强大的工能。例如使用 Sequential Thinking + Software Planning Tool,分别扮演项目经理和技术经理的角色,然后帮你生成完美的软件开发计划等等

markitdown 和 filesystem

markitdown 其实是后台使用微软的 MarkItdown 库,它支持多种格式转换为 markdown 格式,例如常见的 Microsoft Office 文档(Word,PowerPoint,Excel)

不过它需要服务器托管一个 RESTful API,所以要使用这个 MCP 的话,我们需要额外先安装它

具体的安装方式可以参考官网的说明

https://github.com/Klavis-AI/klavis/tree/main/mcp_servers/markitdown

filesystem 是一个允许工具去操作本地目录文件的 MCP,使用起来也比较简单配置 MCP 服务器

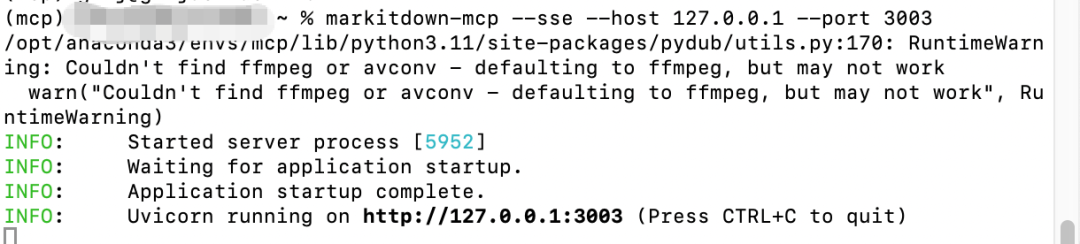

配置 Markitdown,我们需要先启动 API 服务,我这边是使用 conda 虚拟环境来安装运行服务,端口是 3003,这些信息稍后配置需要用到

Cherry Studio 中的配置,如下图所示

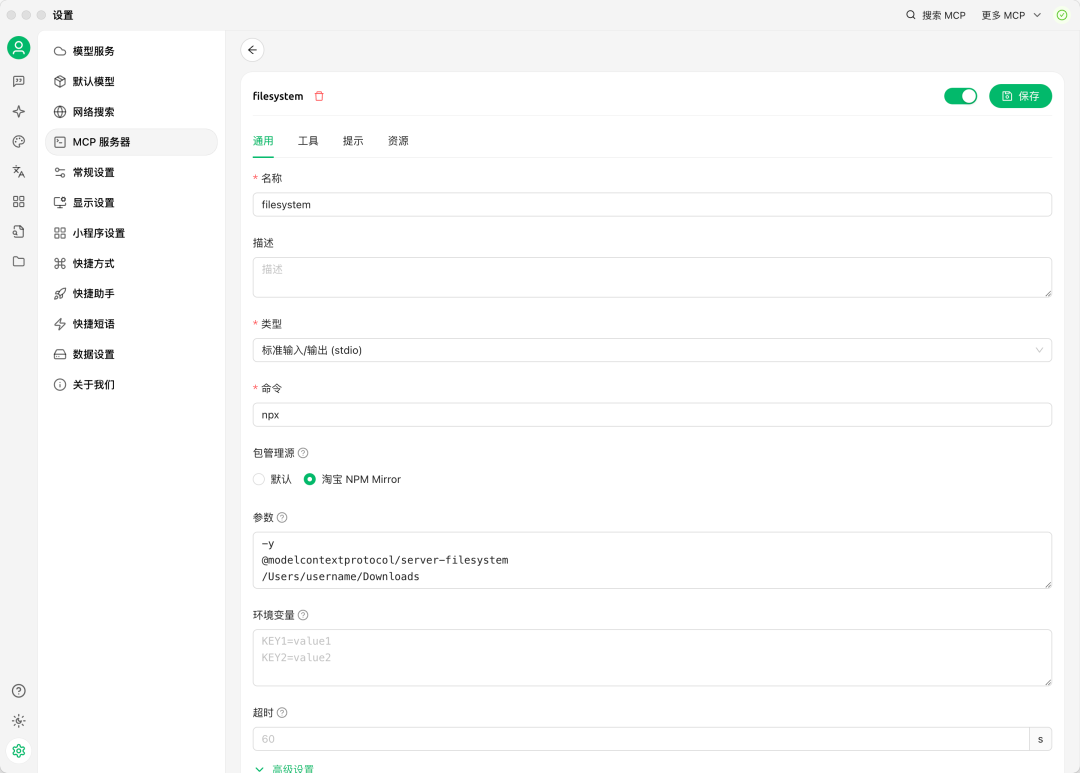

filesystem 需要填入一些允许访问的本地目录,如下图所示

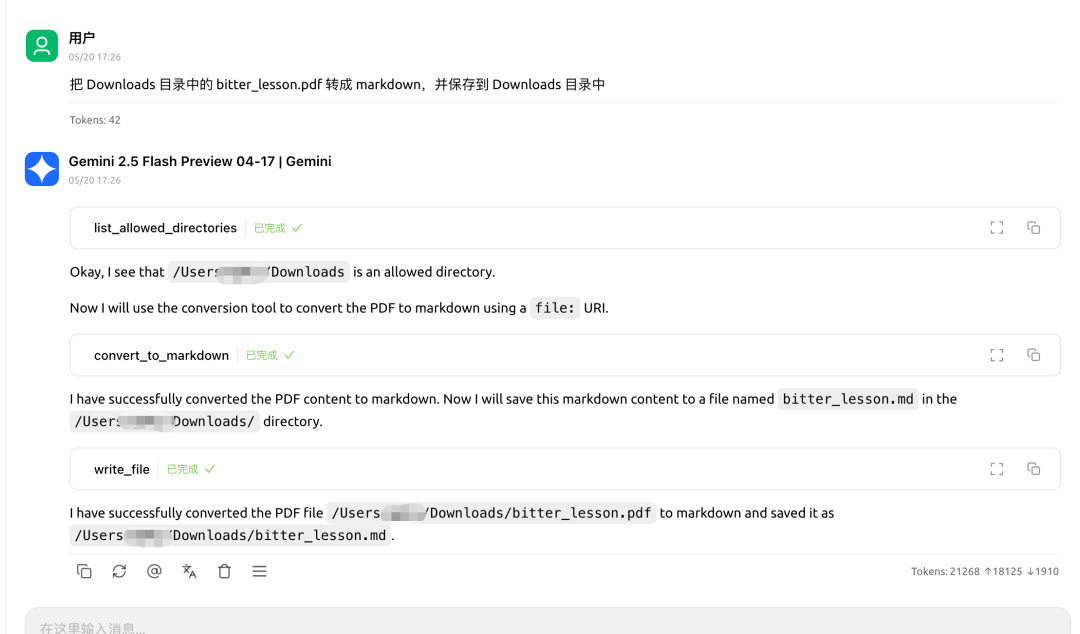

测试效果

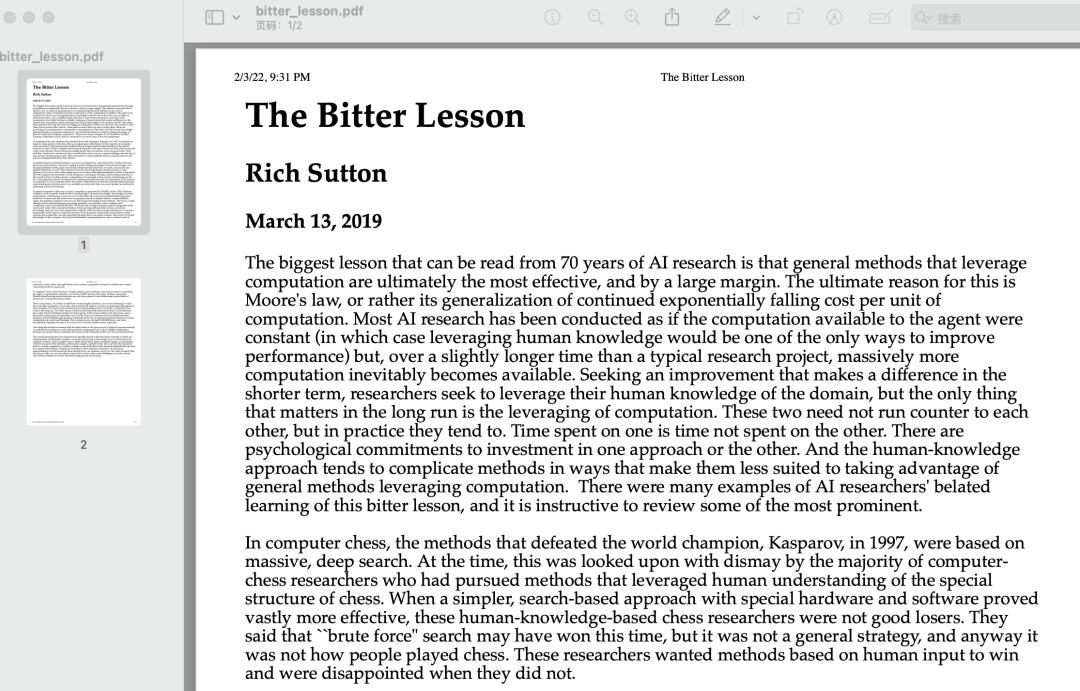

我们尝试将本地的 PDF 文件,转为 markdown 格式,并让模型进行总结

MCP 服务,然后就可以开始执行了

Downloads 目录下多了一个 bitter_lesson.md 文件,打开看一下效果