导读 本次分享聚焦于多模态 RAG 的实现路径与发展前景。

1. 基于语义抽取的多模态 RAG

2. 基于 VLM 的多模态 RAG

3. 如何 Scale 基于 VLM 的多模态 RAG

4. 技术路线的选择

5. 问答环节

分享嘉宾|金海 Infiniflow 联合创始人

编辑整理|王红雨

内容校对|李瑶

出品社区|DataFun

基于语义抽取的多模态 RAG

-

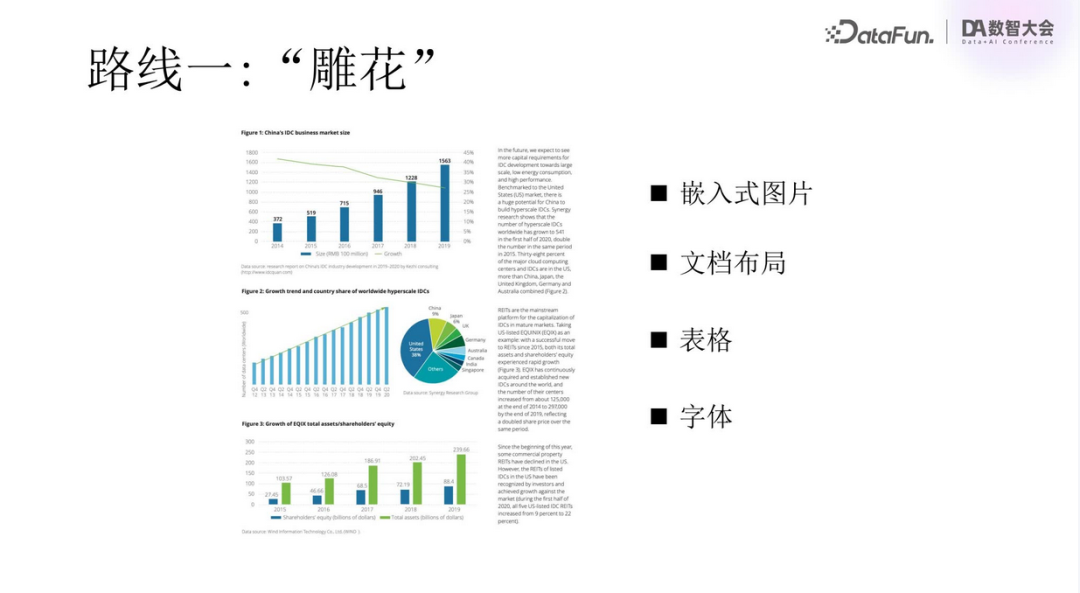

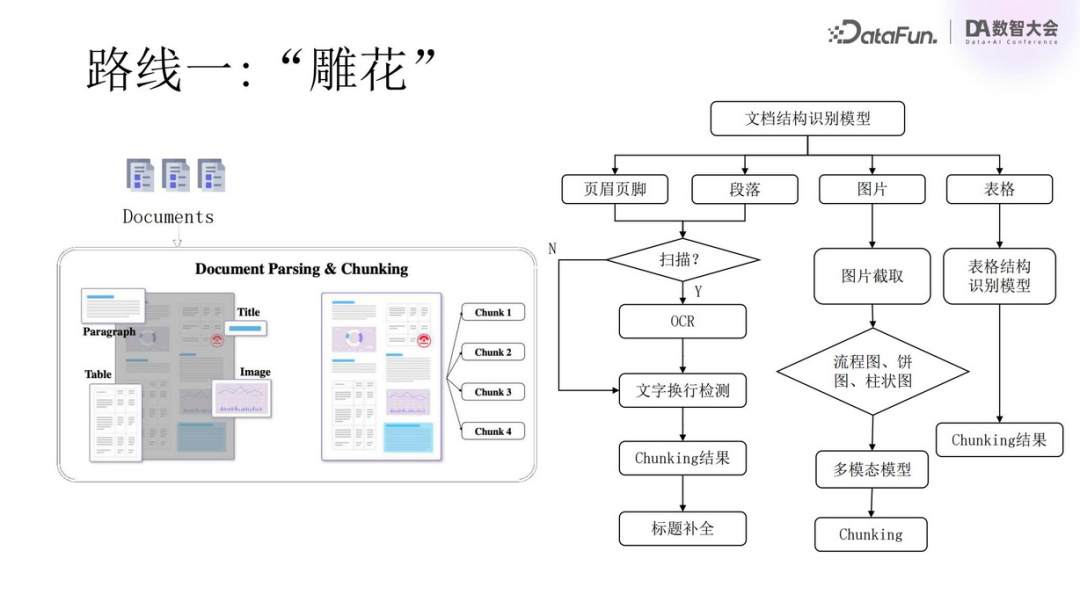

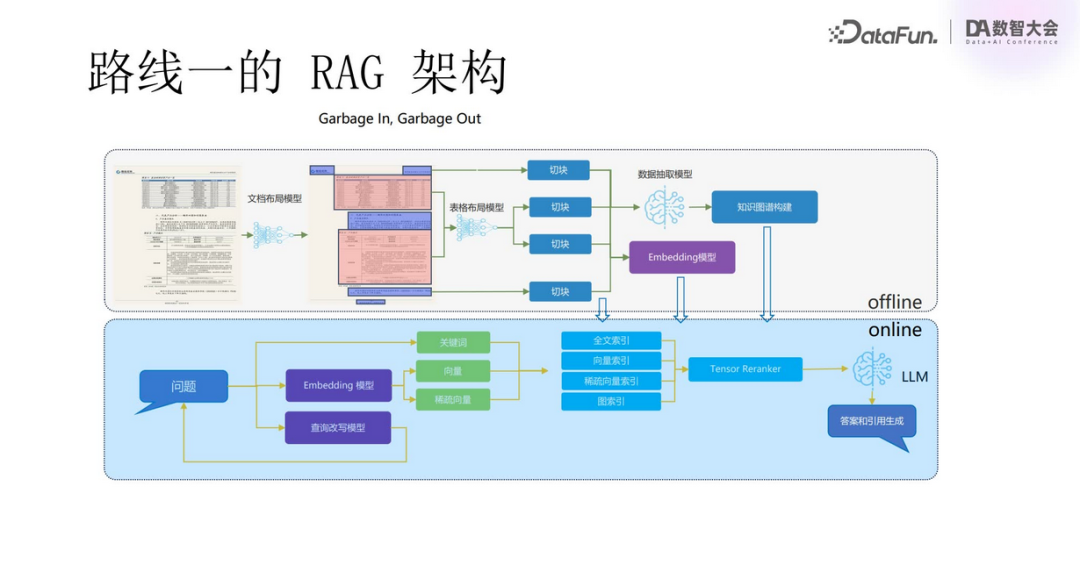

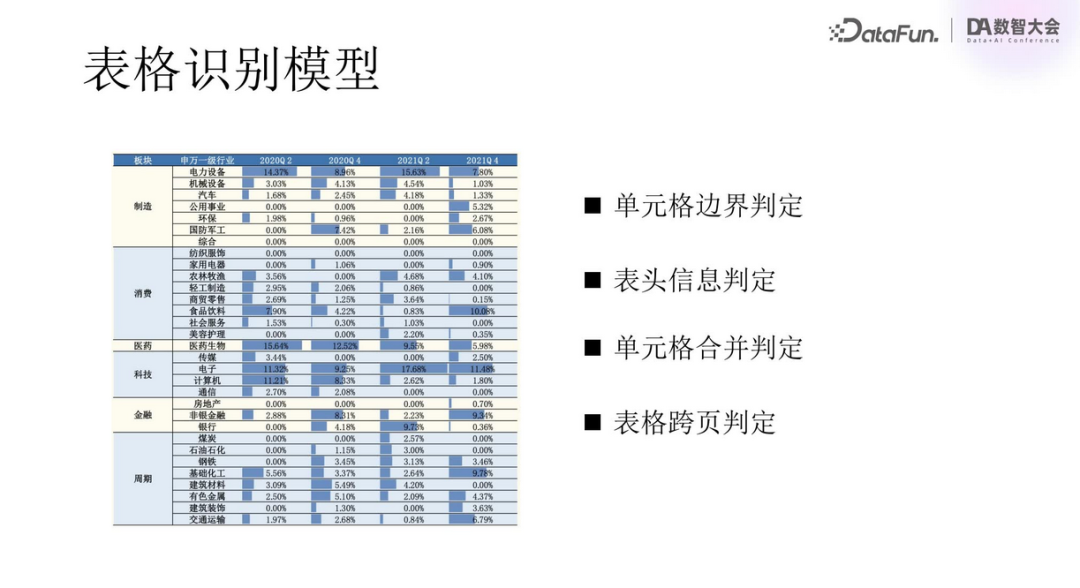

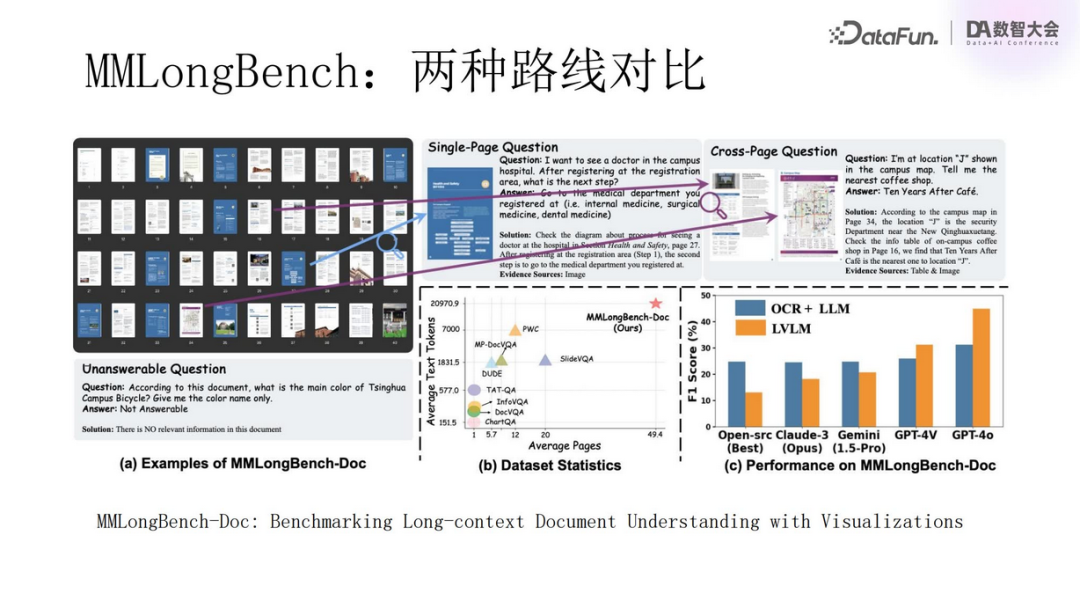

传统对象识别与解析(雕花路线) 传统的多模态文档处理首先会运用图像识别技术,如 OCR(Optical Character Recognition,光学字符识别),从图像中抽取出文字、表格和图片等元素。之后,这些独立的对象会被进一步解析,转换成文本格式,以便于后续的信息检索与分析。

-

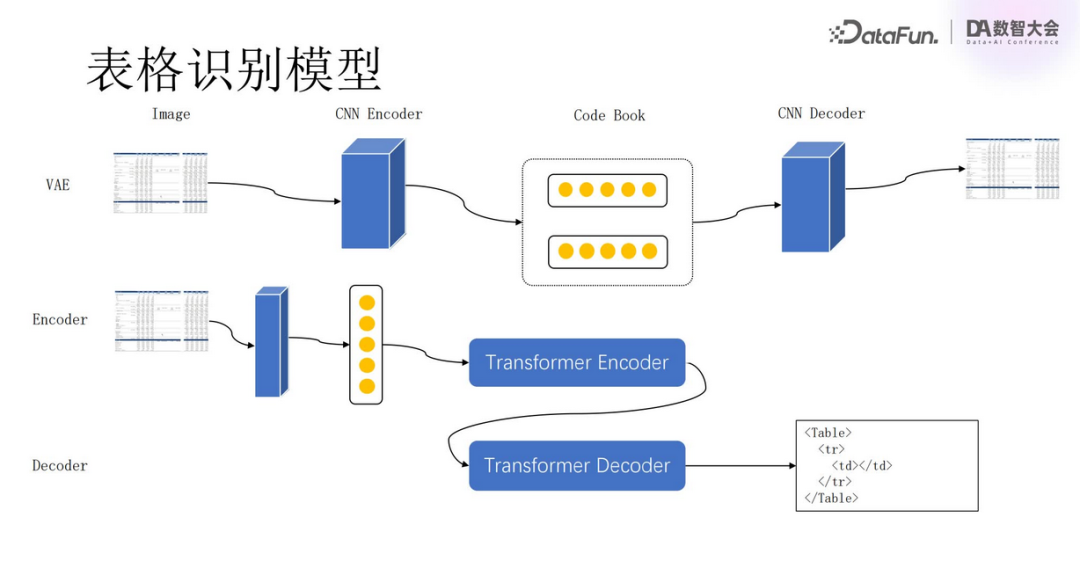

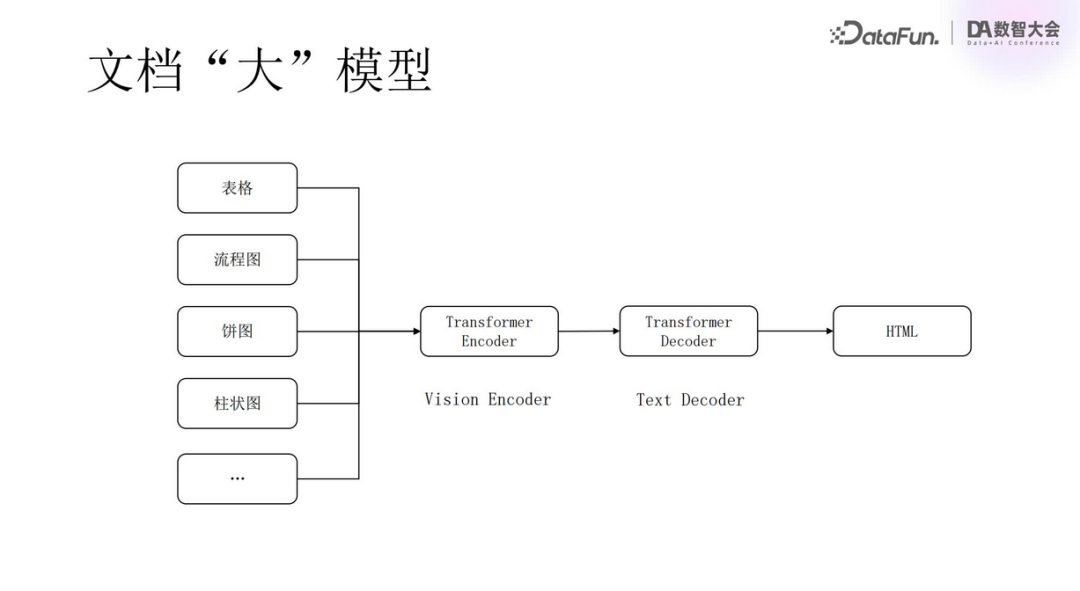

采用 Transformer 架构 近年来,深度学习模型,特别是 Transformer 架构,在自然语言处理领域取得了巨大成功。在多模态 RAG 上,这种方法涉及使用编码器(Encoder)对整个文档进行编码,再由解码器(Decoder)将编码后的信息转化为可读文本。这种方法与第一种类似,只是模型不同,第一种用的是 CNN,这种是 Transformer。此法的优势在于可以更好地捕捉上下文依赖关系,提高信息的连贯性和一致性。

-

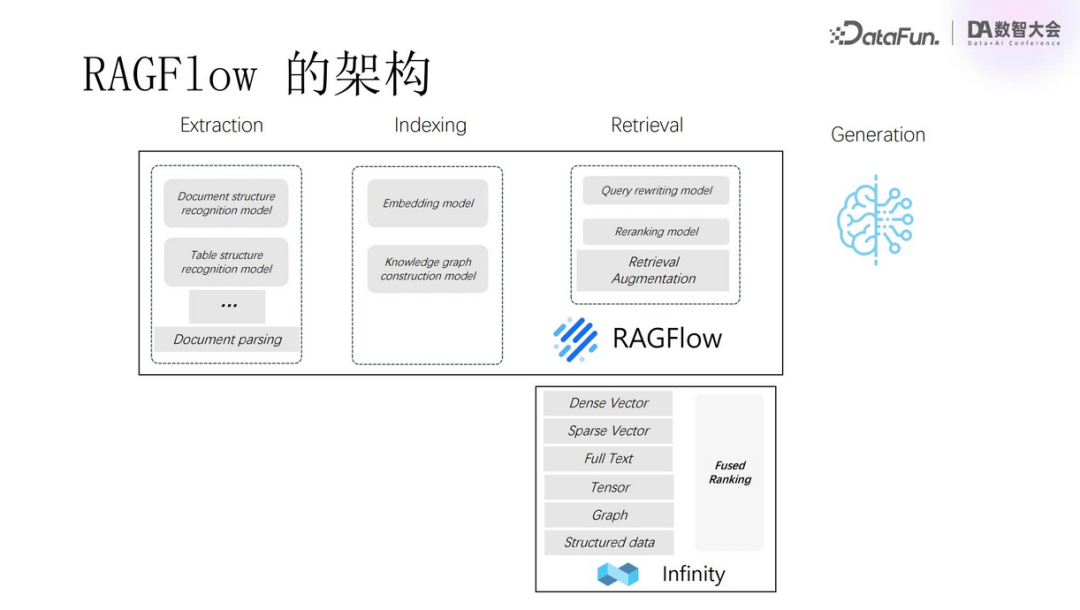

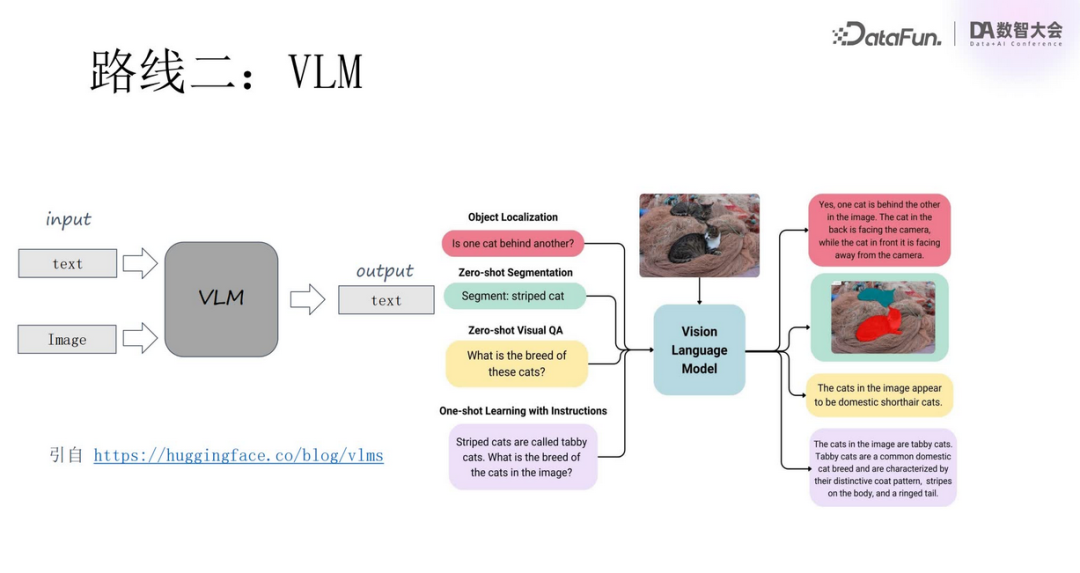

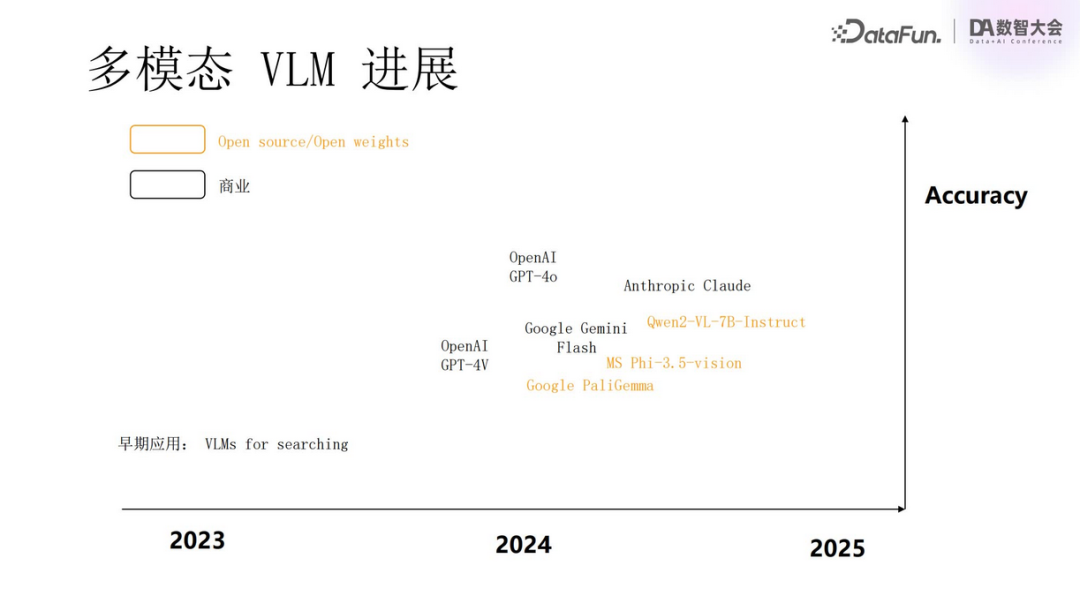

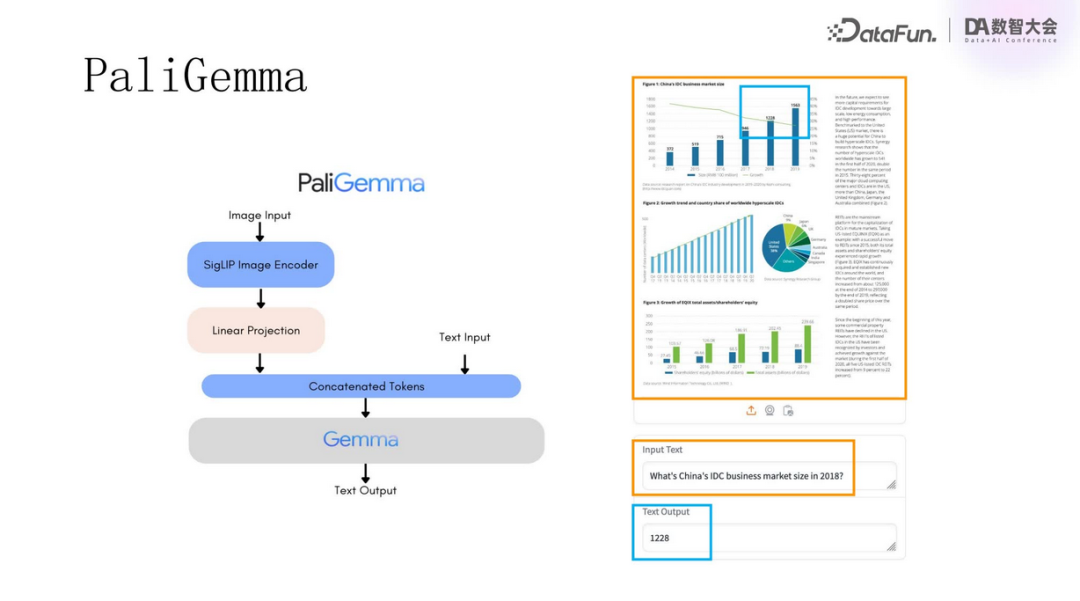

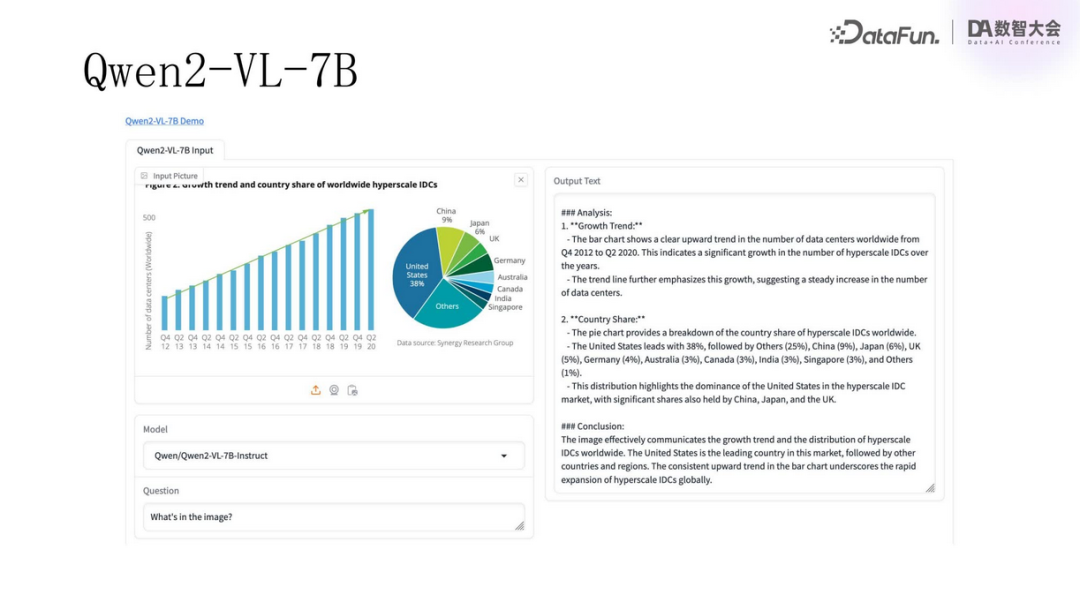

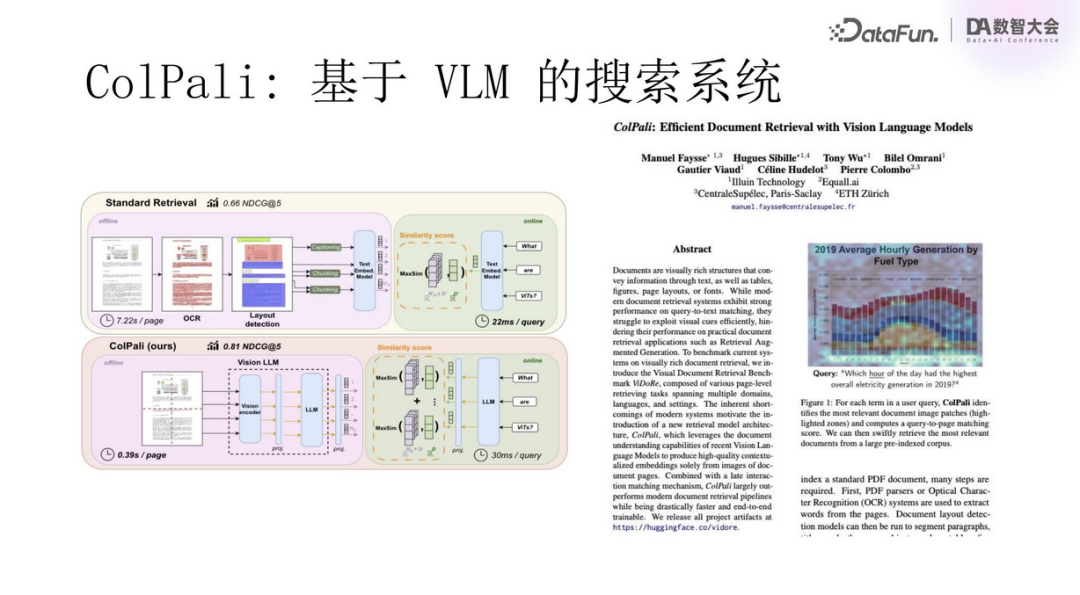

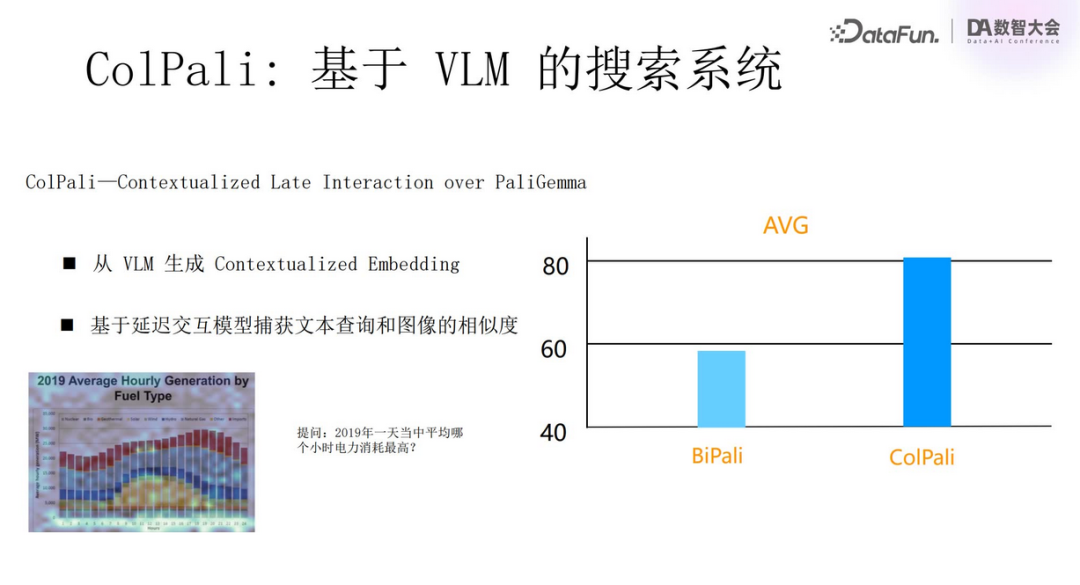

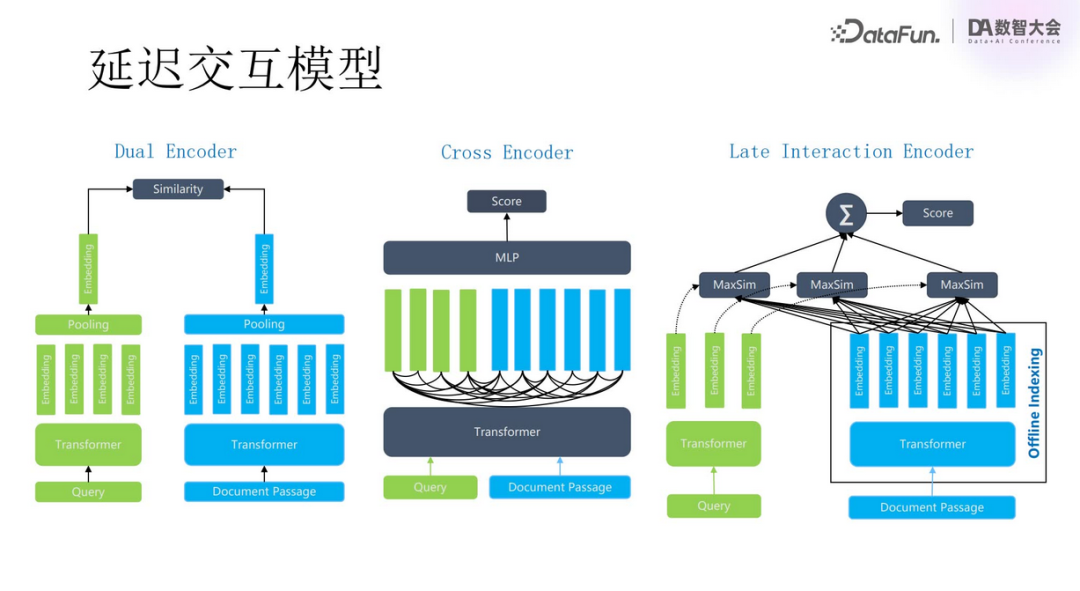

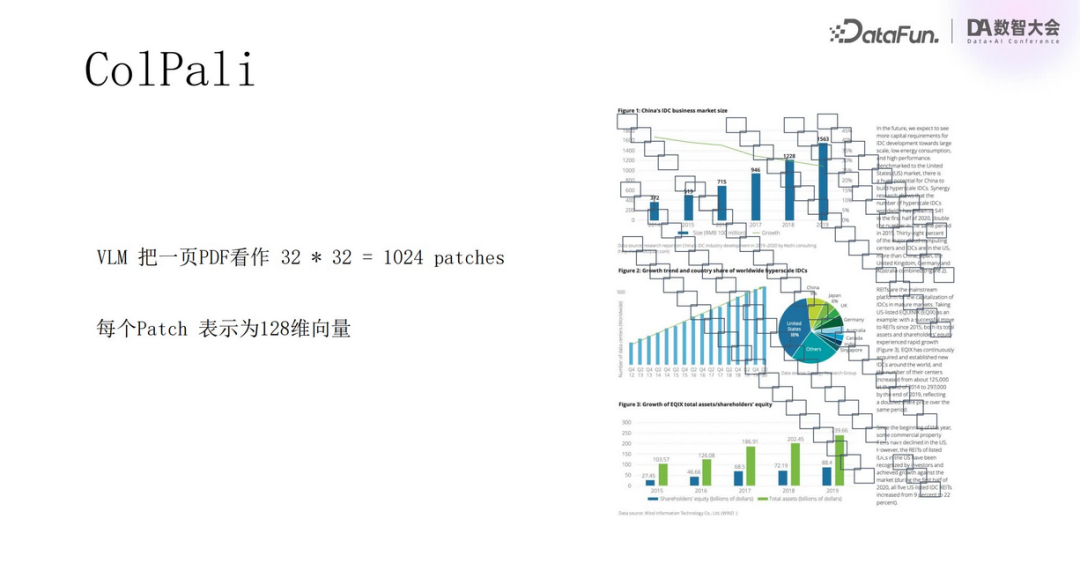

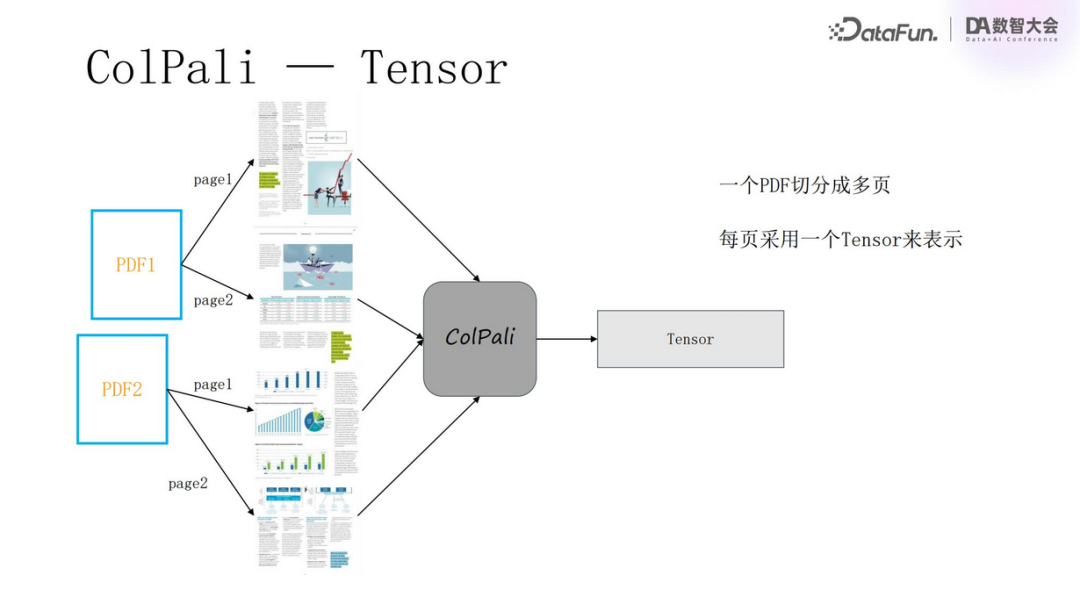

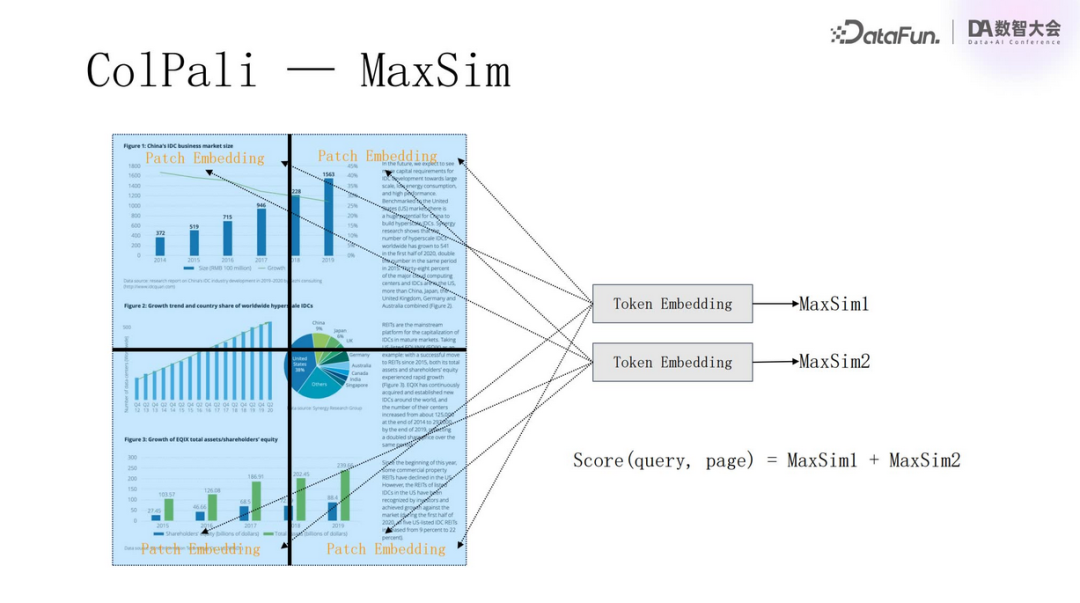

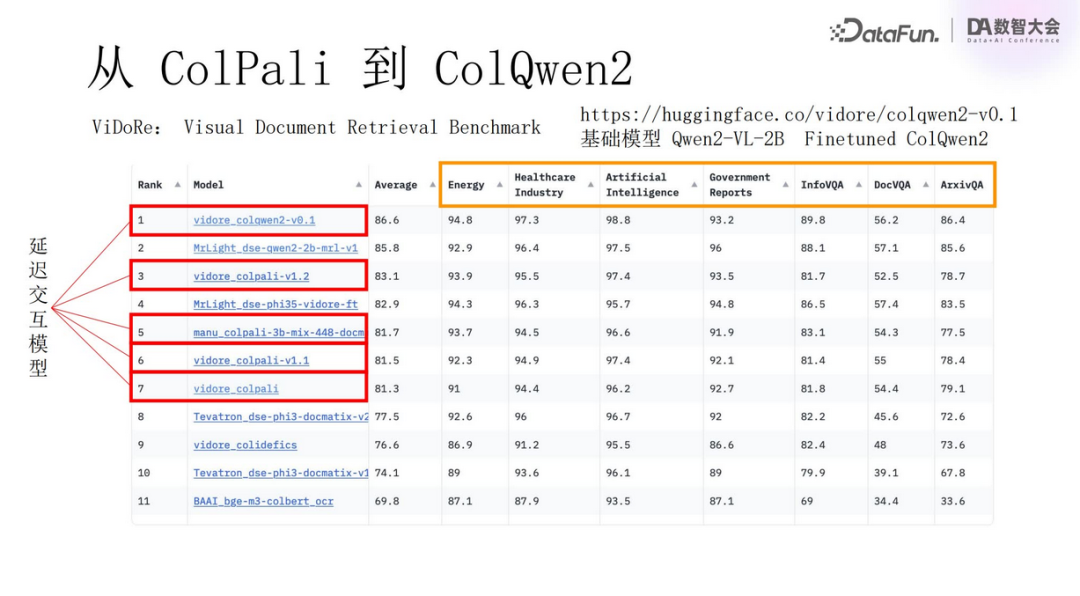

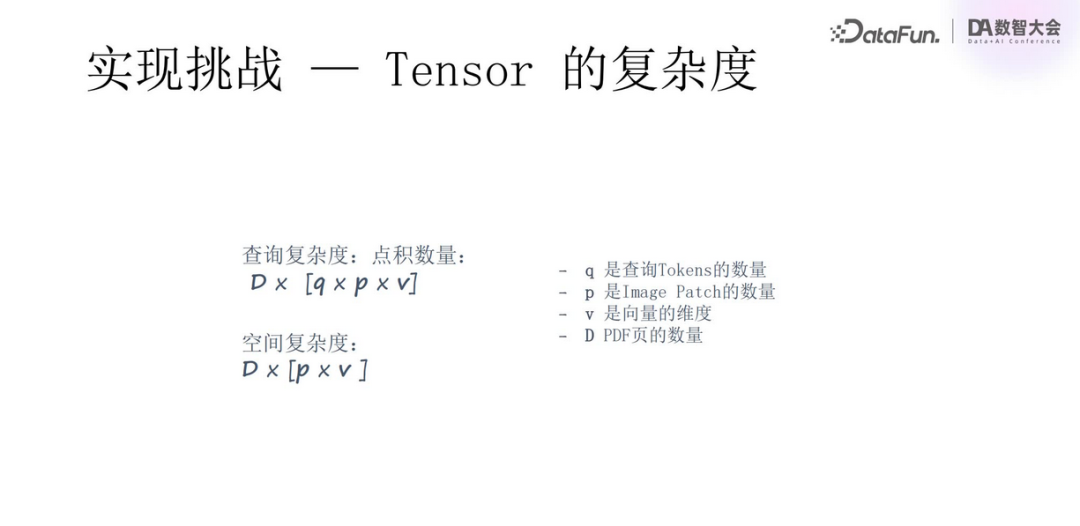

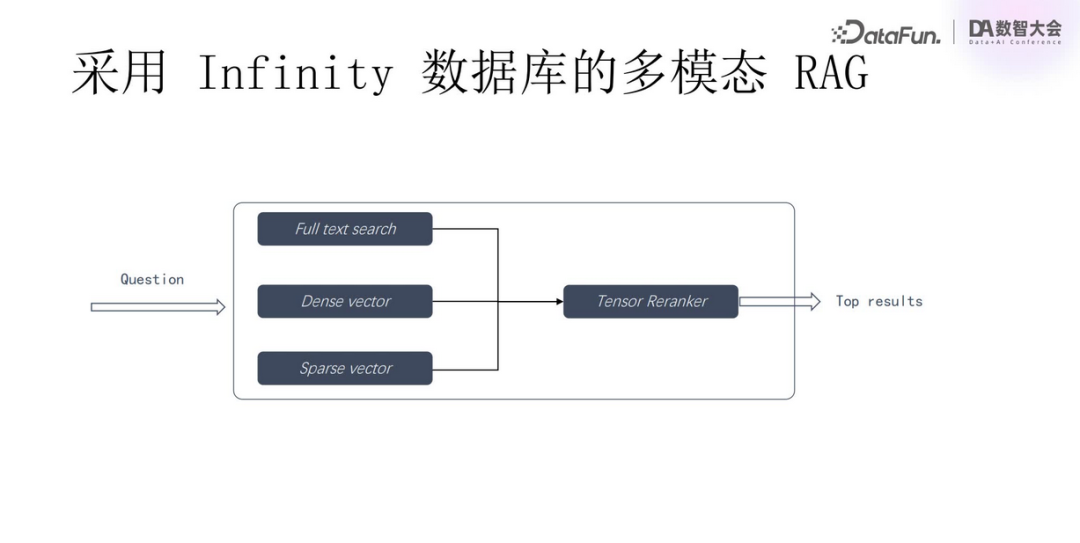

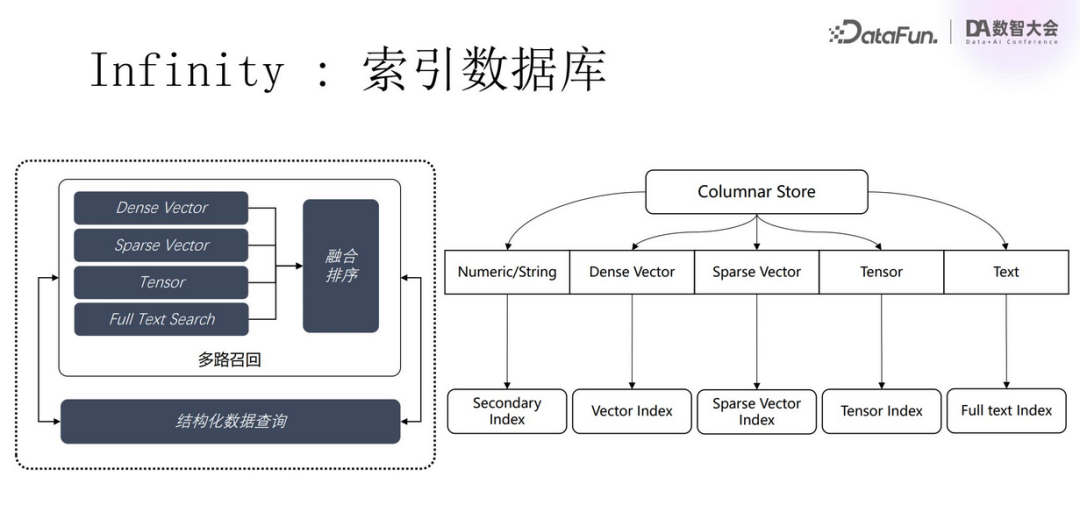

采用视觉语言模型 第三种方式是直接利用视觉语言模型(Visual Language Model, VLM)处理多模态数据。此类模型可以直接接收文档、图片或视频等形式的原始输入,将其转化为向量(Patch Embedding)。这些向量可用于构建更加精细的文档嵌入,有助于增强 RAG 系统的检索和生成能力。尤其值得一提的是,由于单一向量难以充分反映复杂文档的所有方面,使用多向量(或称为张量)成为了优选方案,以减少信息丢失,更全面地代表文档含义。

基于 VLM 的多模态 RAG

如何 Scale 基于 VLM 的多模态 RAG

如何选择技术路线

-

基于 Transformer 的新一代 OCR,针对多模态文档的提取精度更加准确。 -

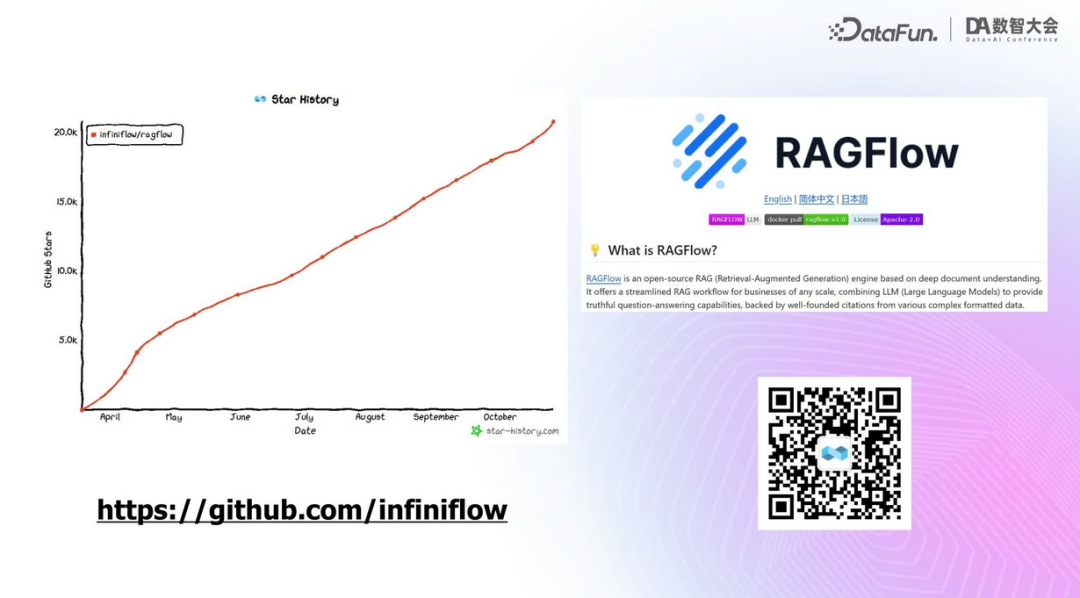

OCR 和 VLM 可以长期共存。 -

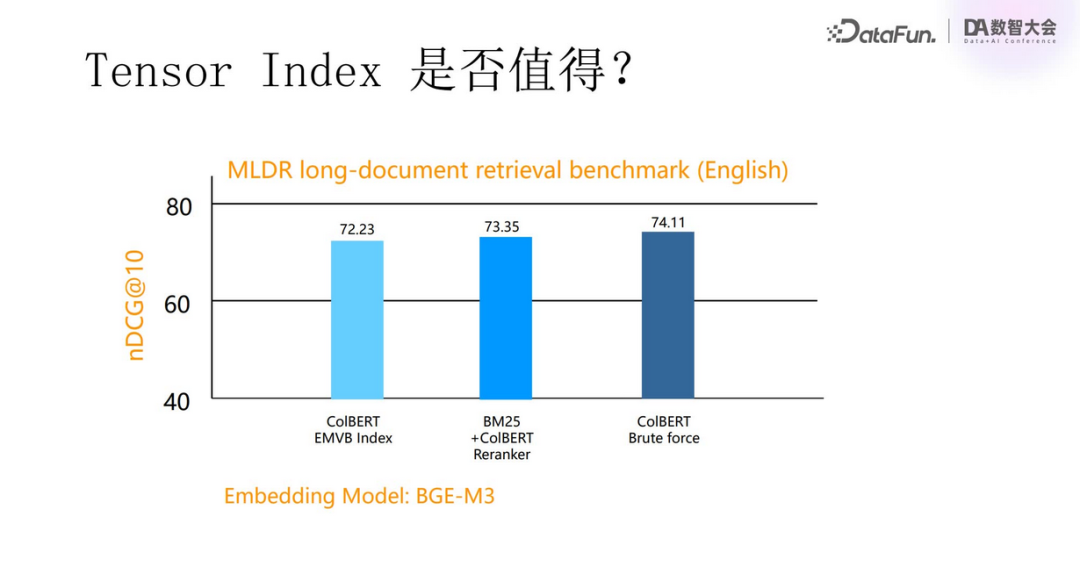

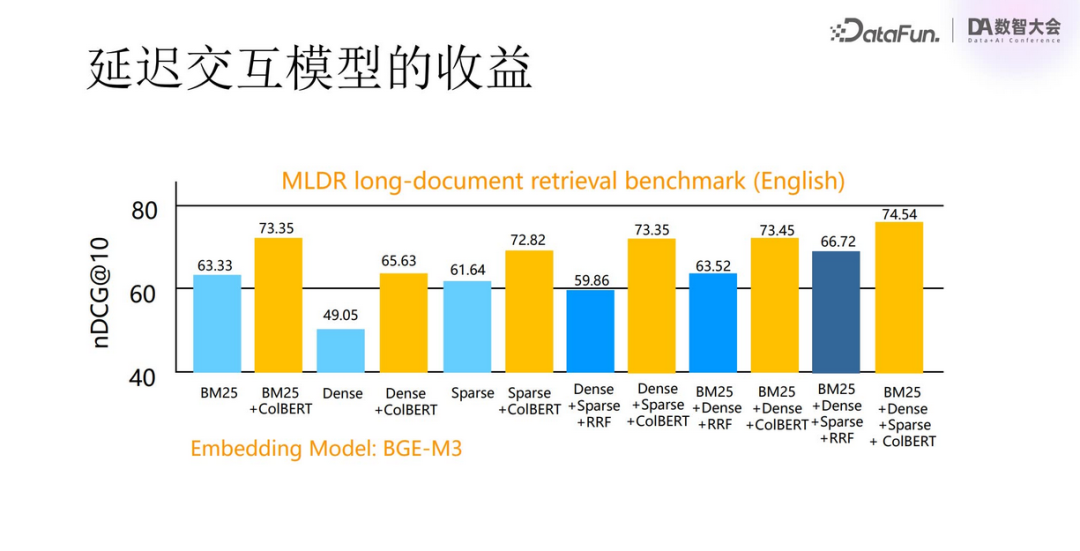

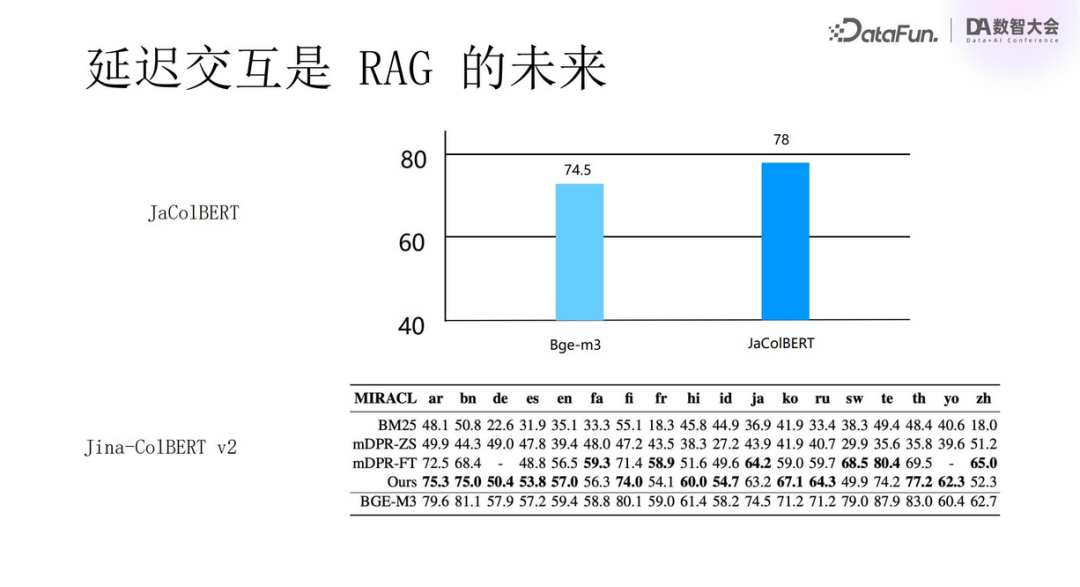

支持 Tensor 的延迟交互将是未来多模态 RAG 的标配选择。

问答环节