“ 2024年11月6日,Ollama发布了0.4版本,新增支持在本地加载和运行Llama3.2视觉模型,包括11B和90B两个大小的版本。” 01

1. 下载安装Ollama 0.4版本

下载地址: https://ollama.com

2. 运行Llama3.2视觉模型:

ollama run llama3.2-vision

3. 如果你的电脑配置足够强大,通过以下命令运行90B模型:

ollama run llama3.2-vision:90b

4. 要将一张图片添加到提示词中,可以拖动并释放它到终端中(Windows),或在Linux上将图片的路径添加到提示词中。

注意:Llama3.2视觉模型11B需要至少8GB的VRAM,而90B模型则需要至少64GB的VRAM。

—

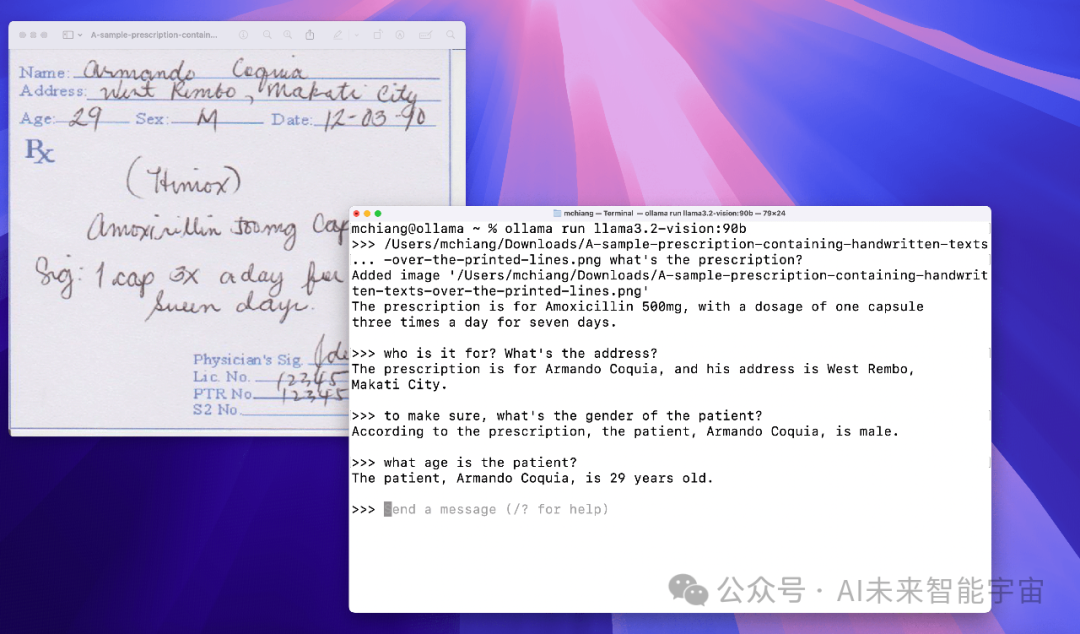

1. 手写识别

2. 光学字符识别(OCR)

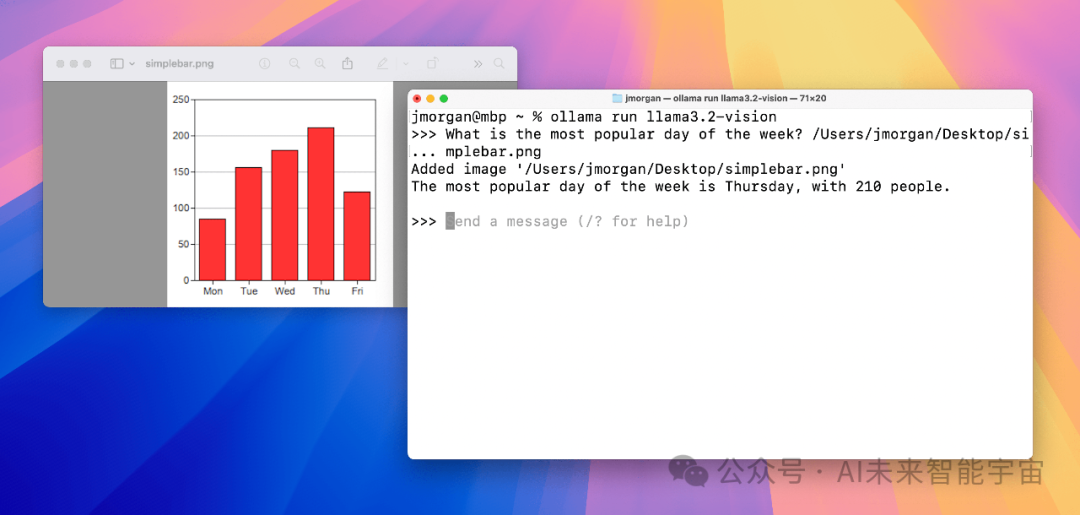

3. 图表和表格

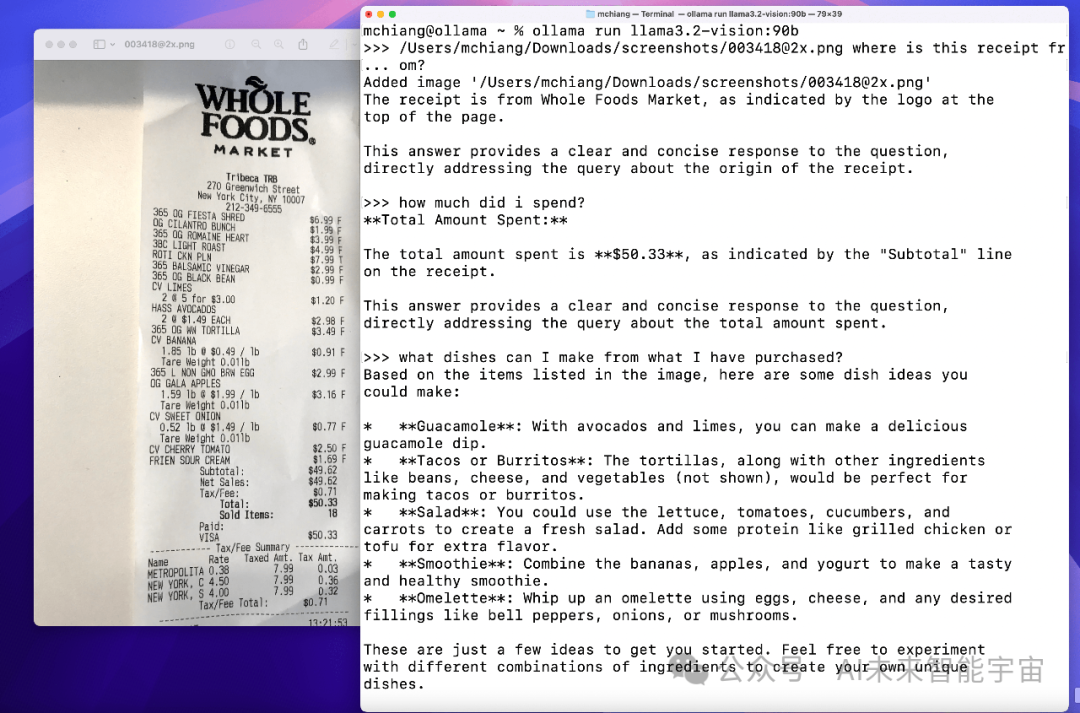

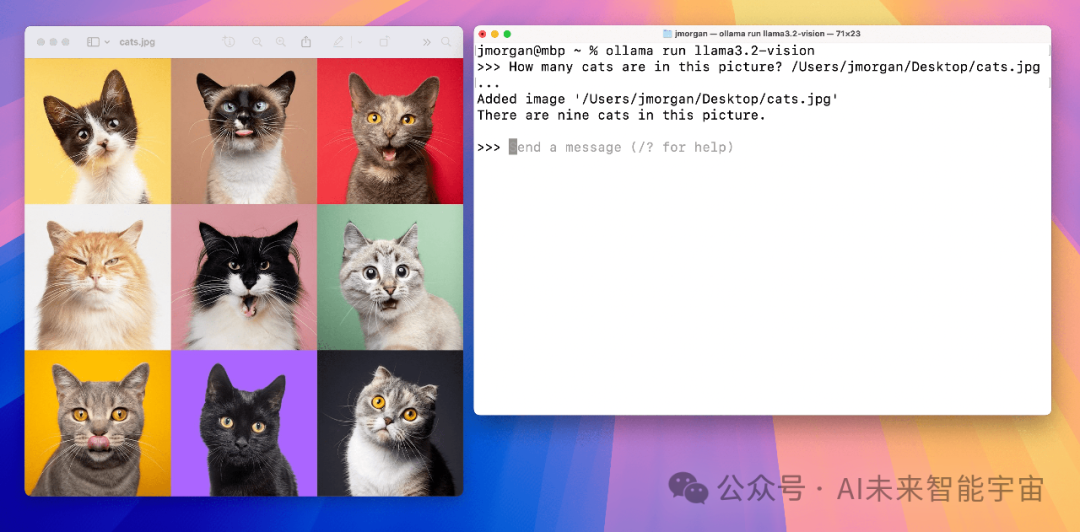

4. 图片问答

—

1. 首先拉取模型:

ollama pull llama3.2-vision

2. 调用Python库

可以通过Ollama Python库在代码中调用Llama3.2视觉模型

import ollamaresponse = ollama.chat(model='llama3.2-vision',messages=[{'role': 'user','content': 'What is in this image?','images': ['image.jpg']}])print(response)

3. 调用JavaScript库

也可通过Ollama JavaScript库在代码中调用Llama3.2视觉模型

import ollama from 'ollama'const response = await ollama.chat({model: 'llama3.2-vision',messages: [{role: 'user',content: 'What is in this image?',images: ['image.jpg']}]})console.log(response)

4. 通过cURL调用

还可以通过cURL命令在命令行中调用

curl http://localhost:11434/api/chat -d '{"model": "llama3.2-vision","messages": [{"role": "user","content": "what is in this image?","images": ["<base64-encoded image data>"]}]}'