使用 Ollama

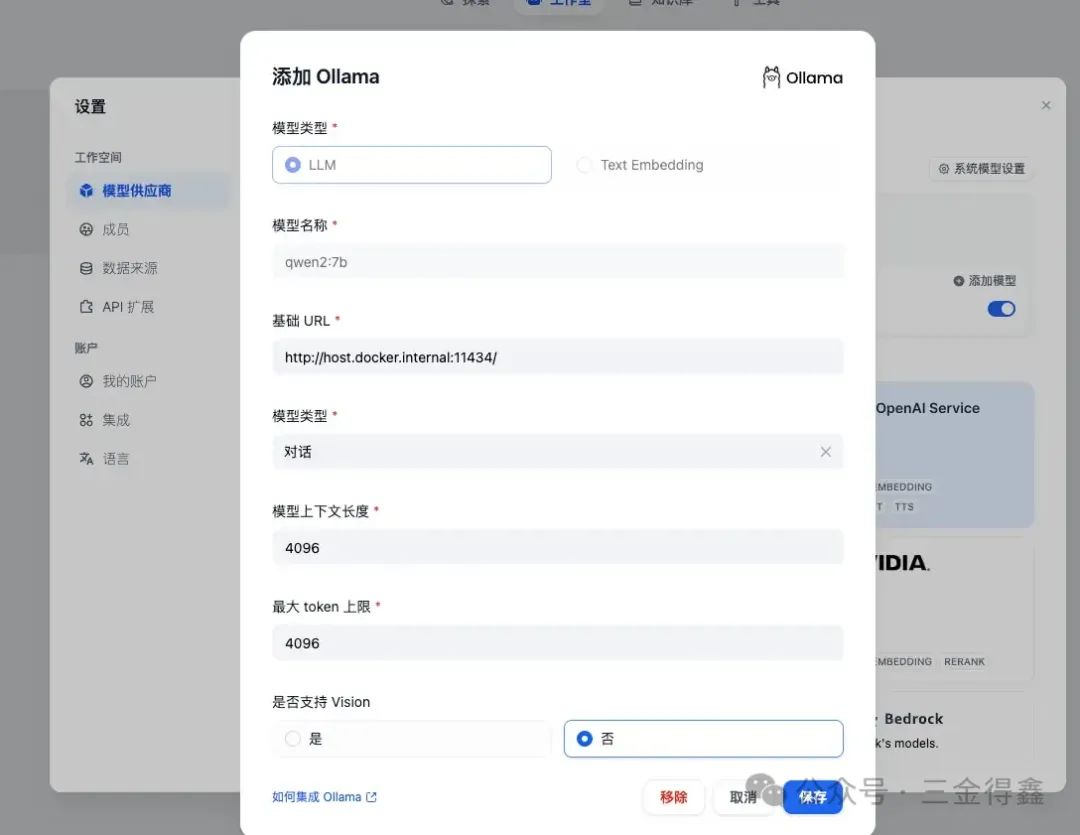

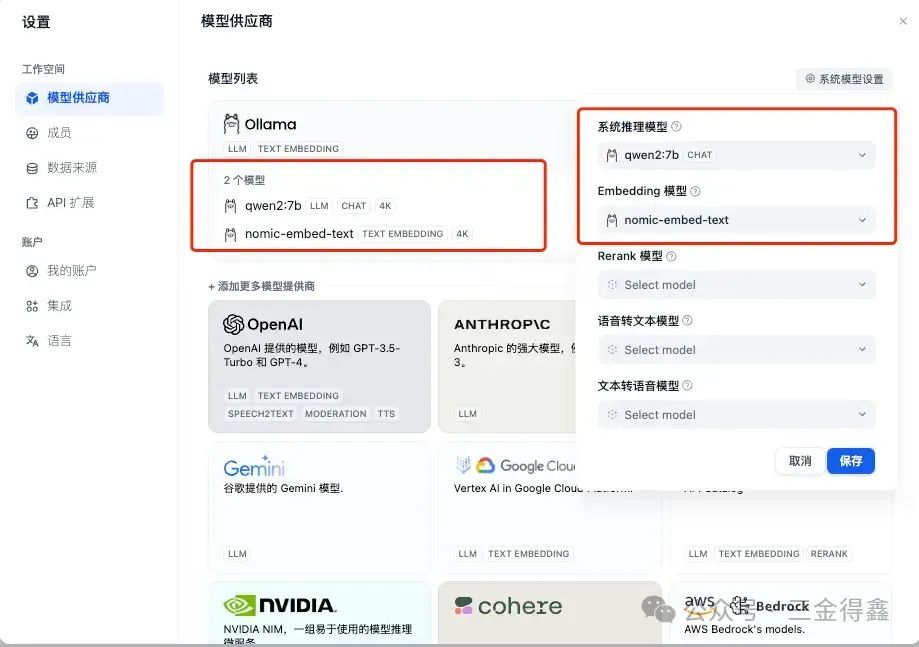

还是在设置的弹窗中选择「模型供应商」,这次我们选择 Ollama,以 qwen2:7b 模型为例:

-

模型名称我们填入

qwen2:7b -

基础 URL 填入

http://host.docker.internal:11434 -

其他选项可以根据自己的需求进行配置,或者也可以保持默认

-

然后保存即可

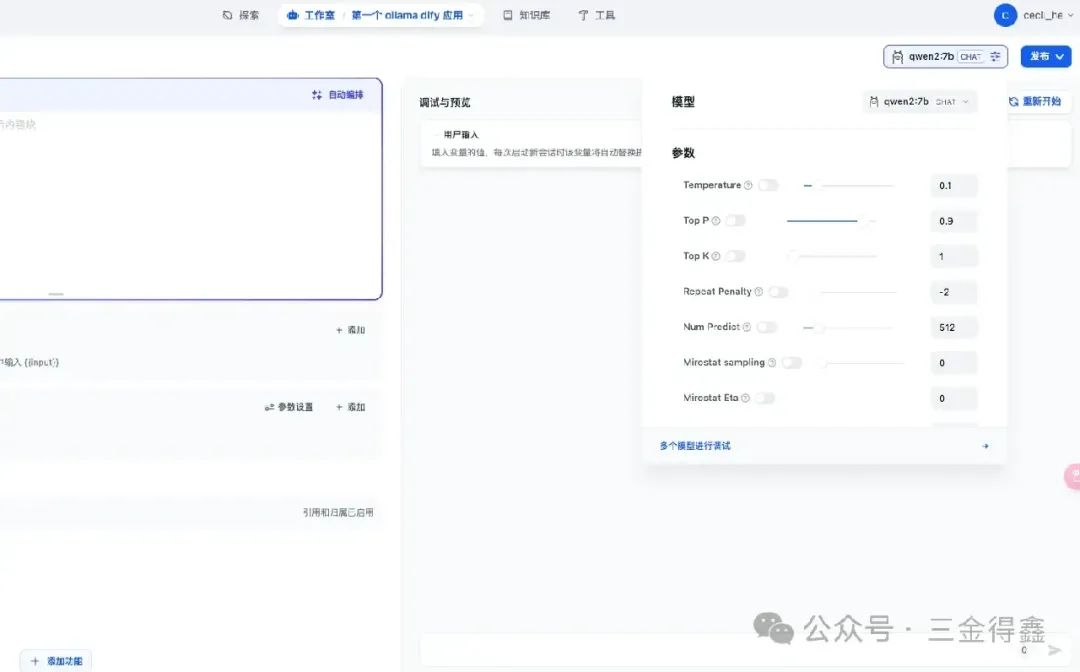

回到创建的应用中,在编排页面的右上角切换大模型为 qwen2:7b:

可以看到的,由于是本地大模型,所以响应速度非常快!

知识库配置嵌入模型

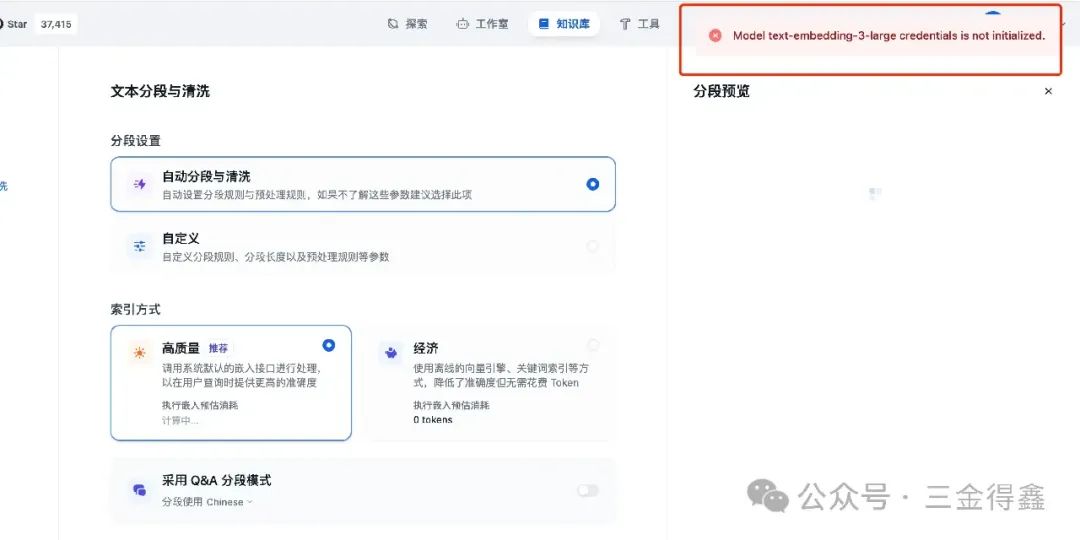

因为咱们本次使用 Ollama 来作为 Dify 的 AI 模型,所以在创建知识库时会有一些问题:

这是 因为 Dify 默认的系统 Embedding 模型是 OpenAI 的 text-embedding-3-large ,但是当我们使用本地大模型时,是无法连接到这个模型的,所以我们 还需要再拉取一个 Embeddinng 模型下来,这里以 nomic-embed-text 为例 :

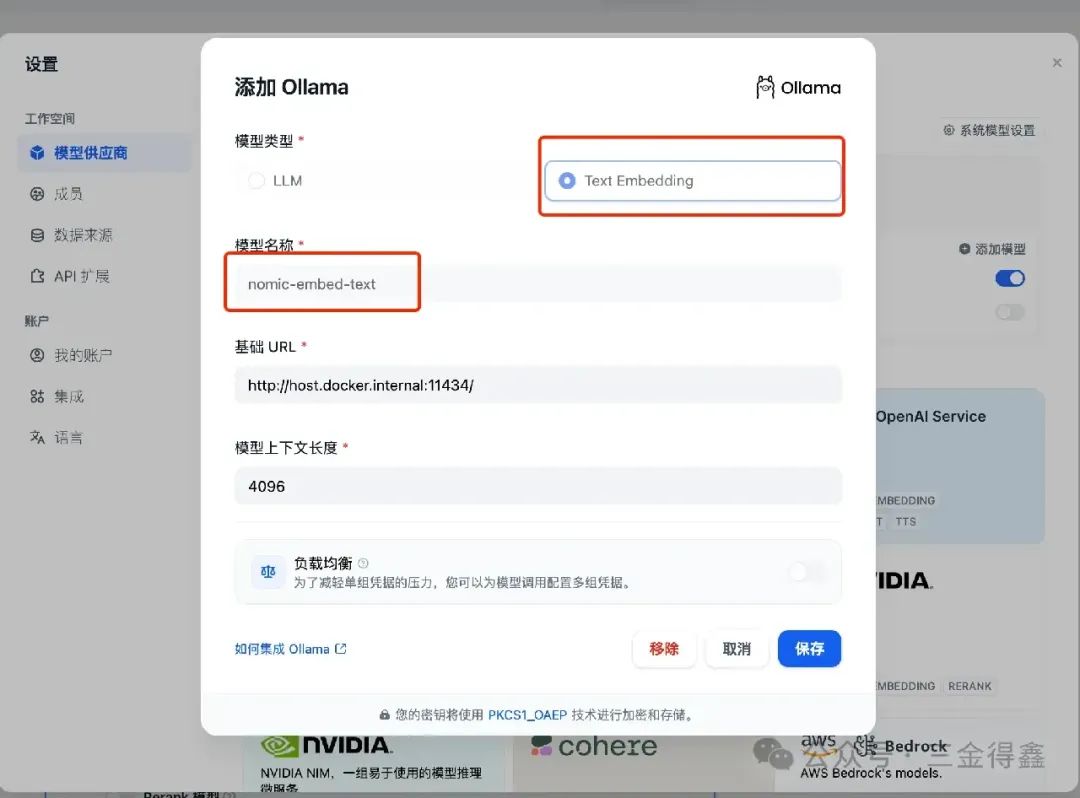

ollama pull nomic-embed-text

然后在 Ollama 模型设置中选择 Text Embedding:

保存之后,我们可以 修改 Dify 的默认系统模型,点击右上角的「系统默认设置」按钮进行设置 :

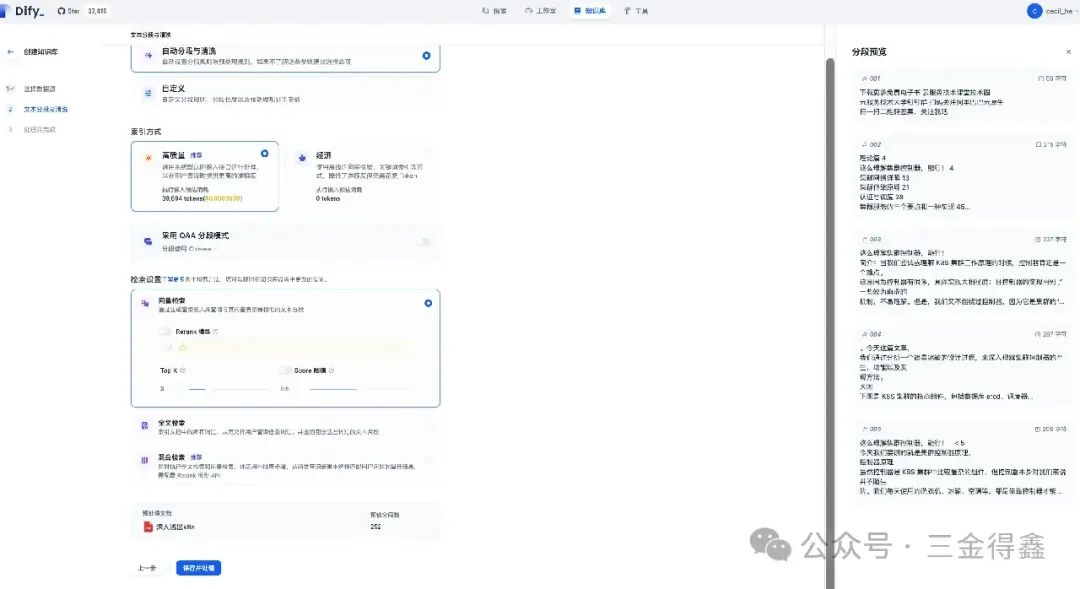

再创建一个新的知识库进行测试:

也可以成功嵌入:

测试应用

接下来我们将刚刚创建的知识库添加到应用中去,并给应用添加提示词。如果不知道怎么编写提示词,还可以点击右上角的自动编排让 AI 帮助我们完成:

点击右下角的「应用」按钮,就会自动为我们添加这些提示词和开场白到应用中了:

我们可以在知识库中添加大量的 K8s 相关的资料,打造一款 K8s 大师应用。是不是很棒?