-

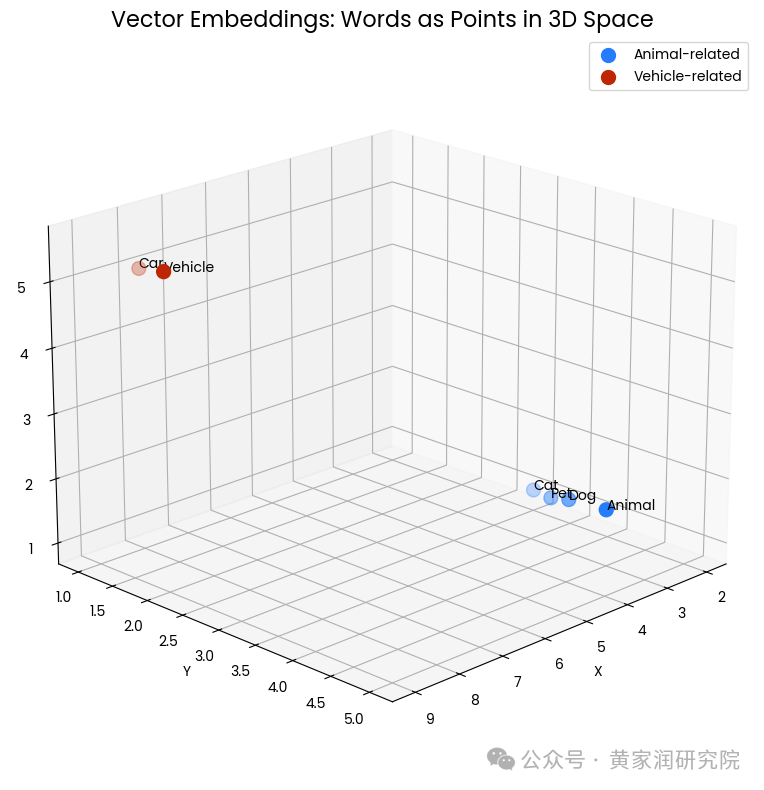

谈一谈向量嵌入(Vector Embeddings)

对于只能处理数字的计算机或者机器来说,区分苹果和梨并不是一件简单的事情。这时候就需要用到向量嵌入(Vector Embeddings)。它可以将文字、图像等数据转化为计算机可以理解和操作的数值表示形式。在有关于 Transformer 工作原理的文章中,我也有提到过向量嵌入的概念,我对它做过一些较为简单的解释。感兴趣可以点击阅读:你知道 GPT 代表什么意思吗?Transformer 架构深度解析…- 4

- 0

-

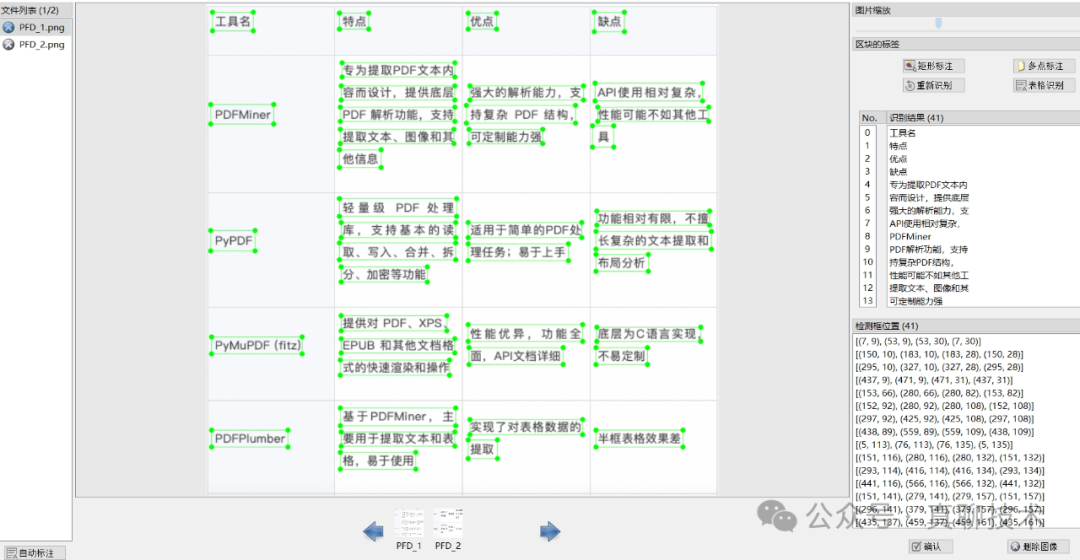

提升RAG系统的回答质量:高质量文档解析终极干货

在上一篇中,我们探讨了RAG系统的最大优势,即能够将企业内的各种文档知识快速转换为知识库,无需对接企业内部系统,并能够基于这些知识库,借助大模型快速打造AI助理。同时,我们也指出了企业内部文档种类繁多、形式多样的现实问题,并确定文档解析是RAG系统的最大挑战之一。在这一篇中,我们将继续深入探讨,寻找应对这一挑战的最佳文档解析方案。为什么RAG系统重点解析PDF?在RAG系统中,PDF文档成为重点解…- 6

- 0

-

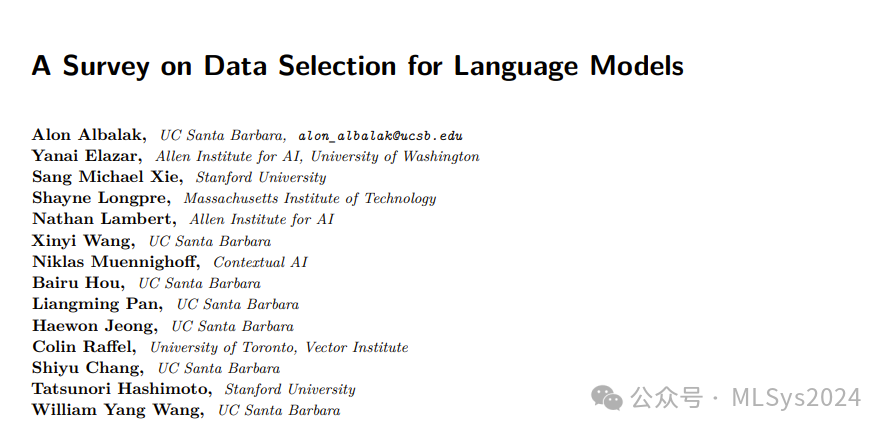

如何为大模型挑选”高质量”数据?【上】

摘要大型语言模型取得成功的一个主要因素是使用了大量不断增长的文本数据集进行无监督预训练。然而,简单地在所有可用数据上训练模型可能并不是最优的(或可行的),因为可用文本数据的质量可能各不相同。过滤掉数据还可以通过减少所需的训练量来降低训练模型的成本。数据选择方法旨在优化训练数据的选择和采样,改进这些方法可以显著提高模型性能。然而,由于深度学习研究主要依赖实证证据,大规模数据实验成本高昂,只有少数机构…- 7

- 0

-

大模型面经——以医疗领域为例,整理RAG基础与实际应用中的痛点

RAG相关理论知识与经验整理。谈到大模型在各垂直领域中的应用,一定离不开RAG,本系列开始分享一些RAG相关使用经验,可以帮助大家在效果不理想的时候找到方向排查或者优化。本系列以医疗领域为例,用面试题的形式讲解RAG相关知识,开始RAG系列的分享~本篇主要是理论知识与经验;后续会结合最新的优化方法给出详细的优化代码,和实践中衍生的思考。下面是本篇的快捷目录。1. RAG思路2. RAG中的prom…- 6

- 0

-

不要将你的 RAG 知识库限制在文本上

在构建知识库时,一个常见的挑战是将所有内容转换为纯文本。在处理幻灯片、PDF、图像等媒体源时,这可能会有限制。那么,我们如何充分利用非纯文本的数据呢?得益于最近的AI进展,现在变得比以往任何时候都更容易和便宜。通过使用具有视觉能力的大型语言模型(LLMs),我们可以转录成千上万的图像,不仅捕捉文本,还理解内容之间的关系。这些模型甚至可以在需要时描述图像中的视觉对象,提供比OCR更丰富、更详细的转录…- 8

- 0

-

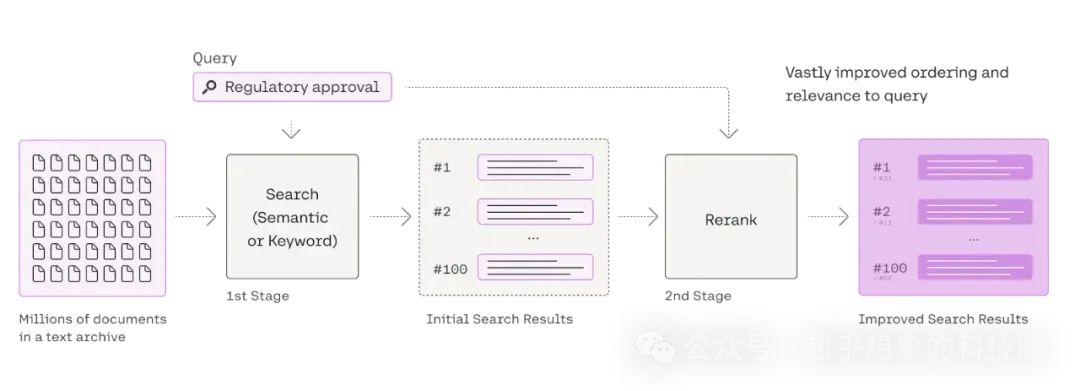

使用RAG技术构建企业级文档问答系统:检索优化(5) 常用Rerank对比

1 概述熟悉搜推的小伙伴可能知道,搜推中也有个叫Rerank的,因为在Rerank前面,一般还有粗排、精排,而RAG中就一个排序模型,怎么就是Rerank了呢。这是因为在RAG中,检索阶段一般只有Embedding一路召回,多的时候也只不过是稀疏+稠密的RRF集成,因此检索结果无论如何都是有顺序的,也就是说已经是排过序的了,所以此处的再次排序,叫Rerank。既然都是排序,加Rerank的意义在哪…- 7

- 0

-

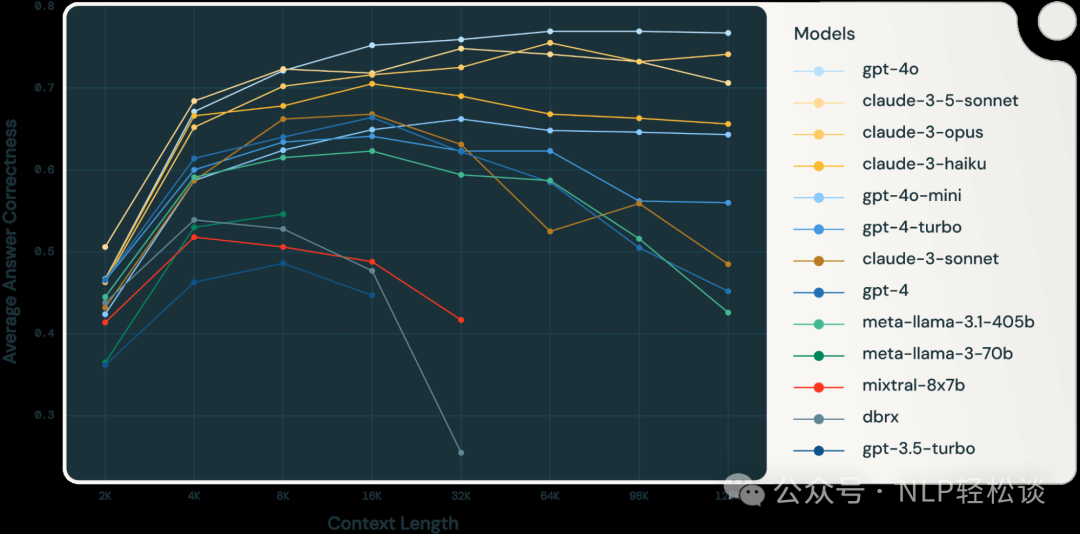

大语言模型的”续航力”大比拼 – 长文本RAG任务下的性能揭秘

检索增强生成 (RAG) 是使用最广泛的生成式 AI 应用之一。RAG 通过从外部来源(如非结构化文档或结构化数据)检索信息,来提升大语言模型 (LLM) 的准确性。随着拥有更长上下文长度的 LLM(例如 Anthropic Claude(200k 上下文长度)、GPT-4-turbo(128k 上下文长度)和 Google Gemini 1.5 pro(200 万上下文长度))的出现,开发者可以…- 7

- 0

-

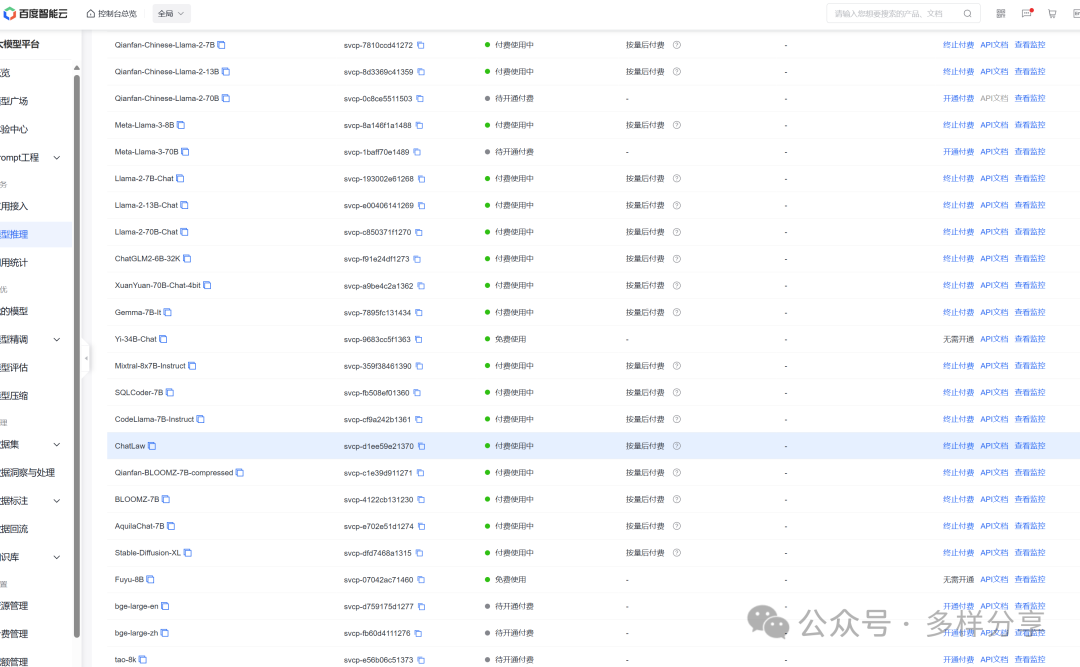

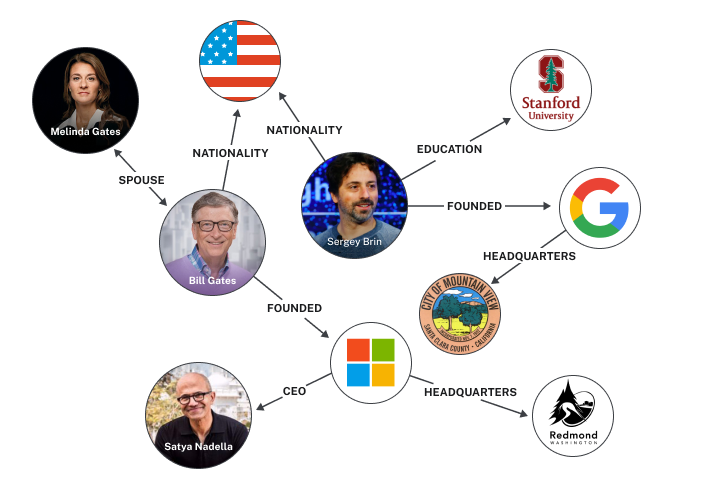

使用千帆完全免费的大模型,去构建Graph RAG,效果如何?

先简单说下 RAG 和 Graph RAG的区别。以把小说作为知识库为例。RAG,会把小说分块,然后把每块向量化,之后用户提问,根据提问的问题,找到最相似的分块,最后把这些分块,发送给AI模型,最后,AI模型给出答案。Graph RAG,会把小说中,拆分出节点和边。节点,可以理解为是一个人物,如:主角。边,可以理解为,节点和节点间的关系,用来连接节点。然后,找到最相似的节点,遍历这个节点…- 3

- 0

-

使用 Milvus、vLLM 和 Llama 3.1 搭建 RAG 应用

vLLM 是一个简单易用的 LLM 推理服务库。加州大学伯克利分校于 2024 年 7 月将 vLLM 作为孵化项目正式捐赠给 LF AI & Data Foundation 基金会。欢迎 vLLM 加入 LF AI & Data 大家庭!?在主流的 AI 应用架构中,大语言模型(LLM)通常与向量数据库配套使用,用于构建检索增强生成(RAG)应用,从而解决 AI 幻觉问题。本文将…- 6

- 0

-

大型语言模型使用令人惊讶的简单机制来检索存储的知识

大型语言模型,例如为流行的人工智能聊天机器人ChatGPT提供支持的模型,非常复杂。尽管这些模型正被用作许多领域的工具,如客户支持、代码生成和语言翻译,但科学家们仍然不完全理解它们的工作原理。为了更好地了解内部运作机制,麻省理工学院和其他地方的研究人员研究了这些庞大的机器学习模型在检索存储知识时所使用的机制。他们发现了一个令人惊讶的结果:大型语言模型(LLMs)通常使用一个非常简单的线性函数来恢复…- 7

- 0

-

GraphRAG 让生成式 AI 如虎添翼

我们即将意识到,要想用生成式AI做任何有意义的事情, 你不能仅仅依赖[1] 自回归语言模型[0] 来做决策。我知道你在想什么:"RAG就是答案。"或者是微调,或者是GPT-5。没错。像基于向量的RAG和微调这样的技术可以有所帮助。对某些用例来说,它们已经足够好了。但还有另一类用例,所有这些技术都会遇到瓶颈。基于向量的RAG - 就像微调一样 - 可以提高许多类型问题…- 8

- 0

-

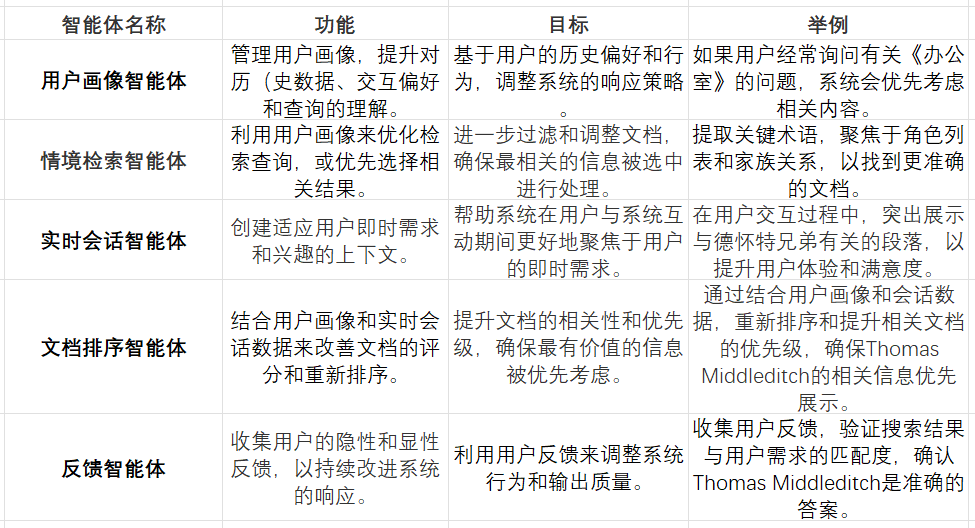

RAG领域出现技术创新,或将引领AI搜索重大变革?

引言最近,PersonaRAG引起我们团队的关注。AI研究者们发布了一篇名为《PersonaRAG: Enhancing Retrieval-Augmented Generation Systems with User-Centric Agents》的论文,其中探讨了名为PersonaRAG的新框架。该框架的目标是通过用户中心化智能体来增强RAG系统,以提高个性化和准确性。这篇文章中,我们将沿着技…- 6

- 0

-

RAG系统的7个检索指标:信息检索任务准确性评估指南

大型语言模型(LLMs)作为一种生成式AI技术,在近两年内获得了显著的关注和应用。但是在实际部署中,LLMs的知识局限性和幻觉问题仍然是一个挑战。检索增强生成(Retrieval Augmented Generation,RAG)通过为LLM提供额外的外部知识和上下文,有效地解决了这些问题。截至2024年RAG已经成为应用生成式AI领域中最具影响力的技术之一。事实上,几乎所有基于LLM的应用都在某…- 3

- 0

-

准确率提升17%!渊亭科技Graph-RAG技术迎来新突破

前言在大数据和人工智能的浪潮中,信息检索技术迎来了飞速发展。RAG(Retrieval-Augmented Generation)技术,作为这一浪潮中的创新成果,通过融合检索与生成技术,优化了搜索结果,使其更精准地满足用户需求。然而,面对海量数据和复杂文档的挑战,传统RAG技术在处理分散信息的整合、全面理解大量数据集或单个大型文档的摘要语义概念方面存在一定的局限性。针对这些限制,微软提出了Grap…- 5

- 0

-

Magic-PDF:端到端PDF文档解析神器 构建高质量RAG必备!

项目结构流程解析预处理的作用是判断文档内容是否需要进行OCR识别,如果是普通可编辑的PDF文档,则使用PyMuPDF库提取元信息。模型层除了常规的OCR、版面结构分析外,还有公式检测模型,可提取公式内容,用于后续把公式转化为Latex格式。但是目前暂无表格内容识别,官方预计1个月之内会放出。管线层主要是把上面模型的结果进行加工处理。比如把公式转化为Latex格式、图表保存起来成为图片、把文本框进行…- 5

- 0

-

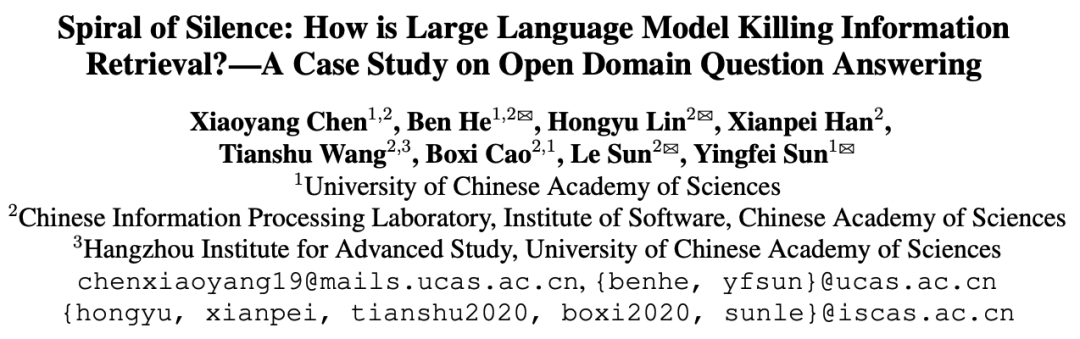

ACL2024 | LLM+RAG可能要毁了信息检索,一份深入研究

论文:[ACL2024] Spiral of Silence: How is Large Language Model Killing Information Retrieval?—A Case Study on Open Domain Question Answering地址:https://arxiv.org/pdf/2404.10496研究背景研究问题:这篇文章研究了大型语言模型(LLMs)…- 7

- 0

-

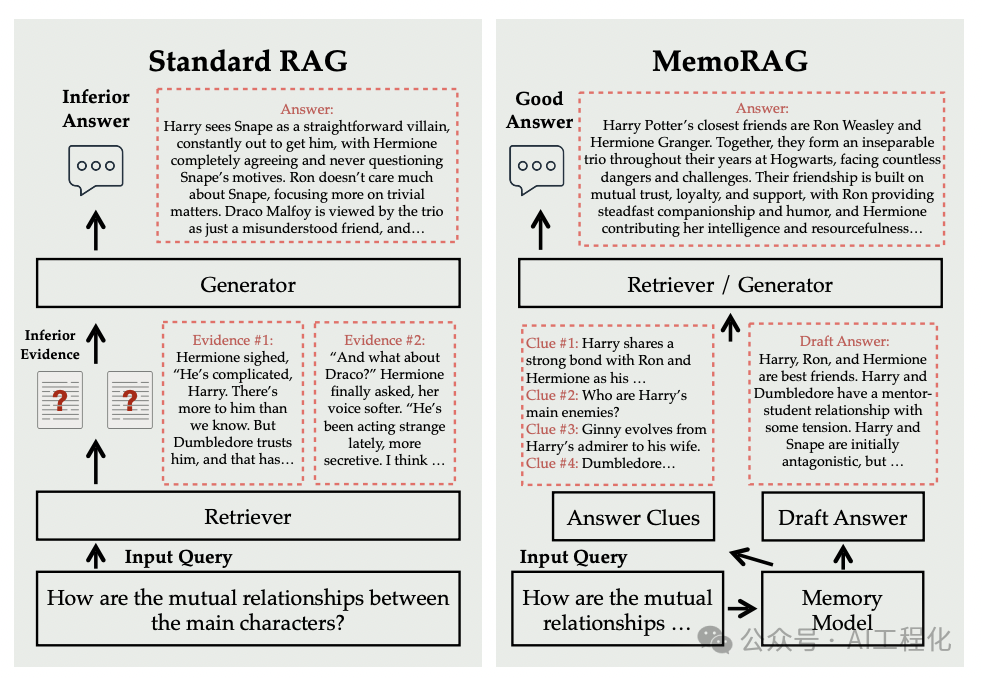

揭秘MemoRAG:AI记忆模块如何提升生成质量

RAG技术已经成为当下提升大语言模型(LLMs)生成质量的重要手段。然而,传统的RAG方法在处理模糊信息需求或非结构化知识时存在显著局限性。近期,一项名为《MEMORAG: MOVING TOWARDS NEXT-GEN RAG VIA MEMORY-INSPIRED KNOWLEDGE DISCOVERY[1]》的研究提出了一种创新的RAG框架——MemoRAG,通过引入长时记忆模块,显著提升了…- 6

- 0

-

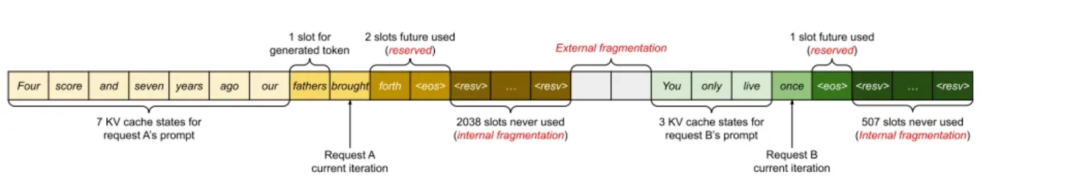

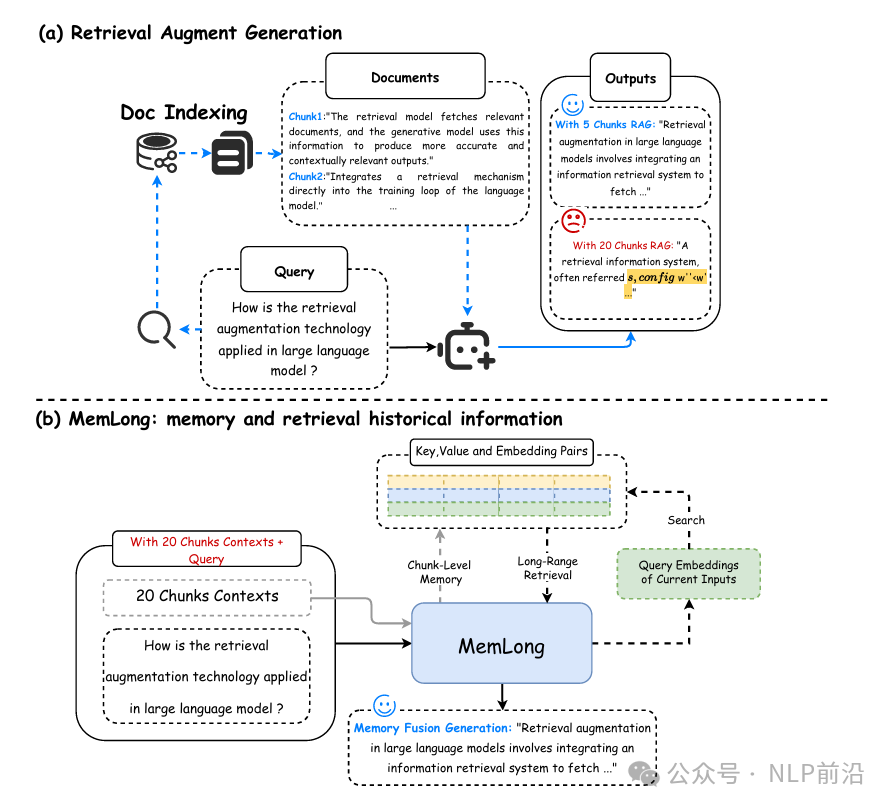

大模型RAG的下一形态,MAG

LLMs在处理长文本时,因为注意力机制二次时间和空间复杂度的问题,所以处理长文本时的内存消耗和计算成本有点恐怖。检索增强生成RAG自然就成了一个工业界成熟的解决方案,MemLong是一个新的解决方案,跟之前有些产品提到的RAG2.0有点类似(RAG 2.0有无数个版本~)。整体上来看,他跟RAG的对比图如下,主要是通过存储过去的上下文和知识在一个记忆库中,利用这些存储的信息来检索(K-V and …- 5

- 0

-

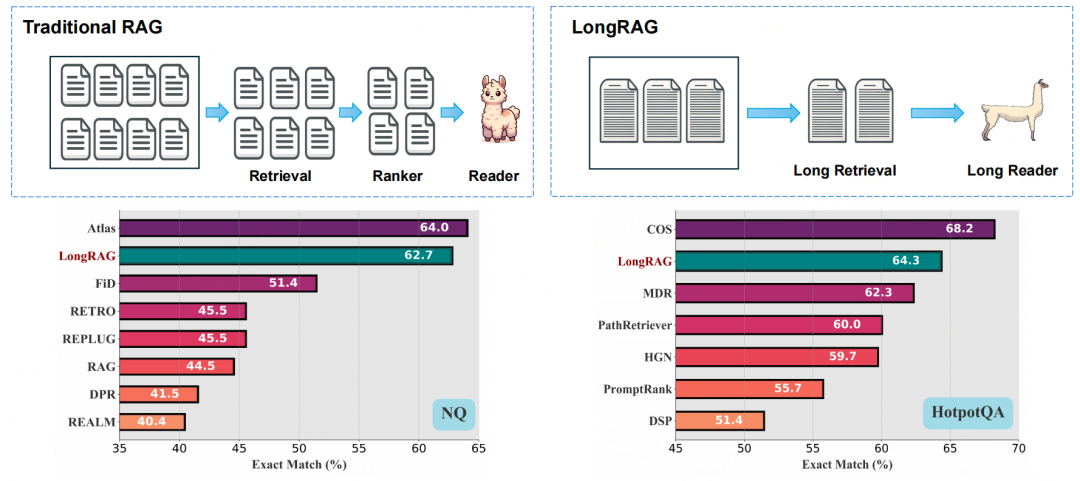

【RAG】LongRAG:利用长上下文LLMs增强检索增强生成

前言现有的RAG框架通常使用100词的短段落作为检索单元,这种设计使得检索器需要在大量语料库中搜索,增加了工作负担,并且容易引入难负样本,影响性能。LongRAG框架为了解决这一问题,该框架使用长检索单元(最多4K词),显著减少了语料库的大小(从22M减少到600K),从而减轻了检索器的负担,并提高了检索性能。一、方法LongRAG框架由两个主要组件构成:长检索器(Long Retriever)和…- 6

- 0

-

北航沙磊教授:当Agentic RAG照进现实|Agent Insights

WWDC 24 发布会上,苹果带来了全新的系统,除此之外,Apple Intelligence 作为压轴戏也终于上演,让我们看见了 AI 如何融入我们的日常生活。绿洲邀请到了一位在 NLP 领域有着学术背景和产业双重背景的专家——沙磊教授,他曾经也在美国湾区苹果公司 Siri 组工作。沙教授将在本期为我们介绍他的最新研究项目 ATM(Adversarial Tuning Multi-agent S…- 19

- 0

-

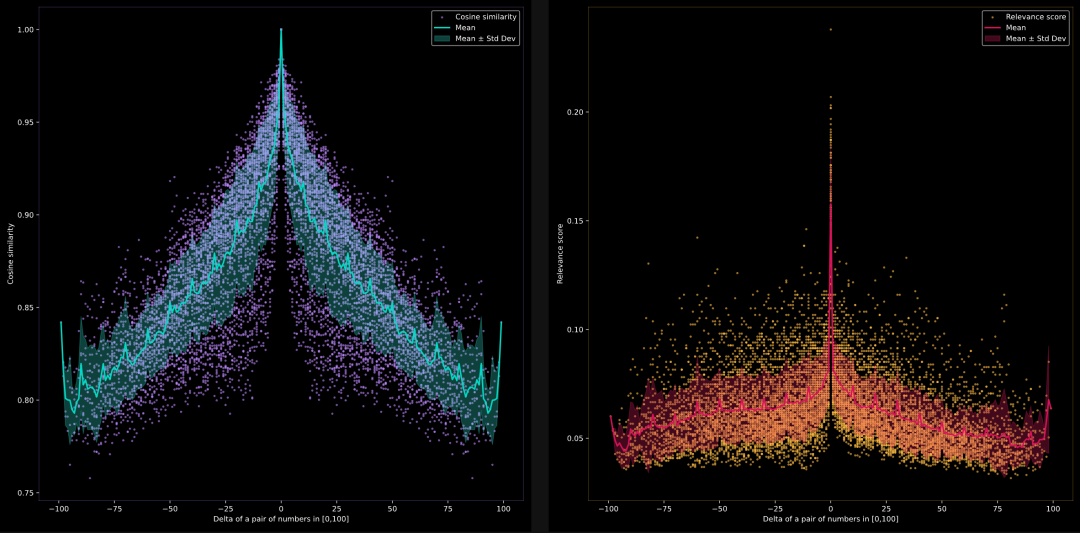

大模型分不清 9.9 与 9.11 谁大,那 Embedding 模型呢?

这是我在维也纳举行的 ICML 会议上被问到的问题。在茶歇期间,一位 Jina 用户向我提出了一个 LLM 社区最近热议的问题。他问我们 Jina Embedding 模型能不能判断 9.11 比 9.9 更小,很多大模型在这个小问题上栽了跟头。我说:“说实话,我也不确定。” 他接着详细阐述了这个问题对于他研究的重要性,并暗示:Tokenizer 可能是问题的根源,我若有所思点点头,脑海里开始构思…- 3

- 0

-

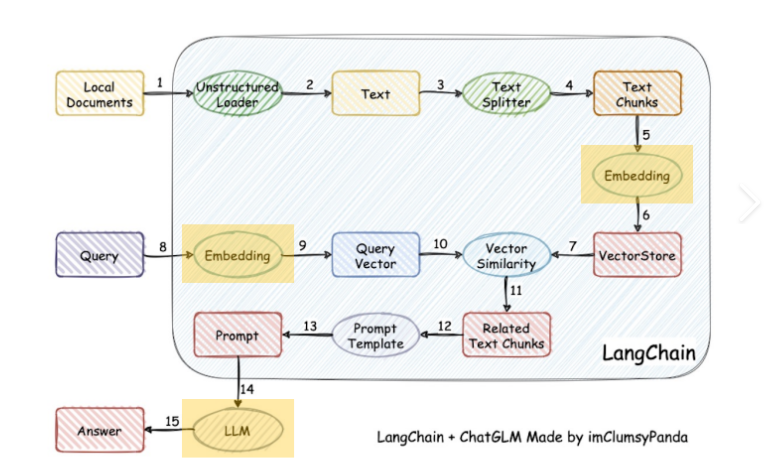

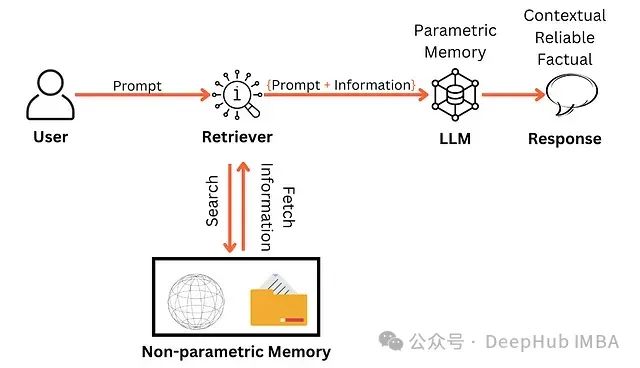

RAG系列|大模型之RAG扫盲

最近RAG在日常工作中出现的越来越频繁,网上相关资料很多,今天我们一起来初步认识RAG、了解RAG工作原理、RAG优化的关键技术、如何评估RAG的有效性以及RAG存在的问题挑战。认识RAG大型语言模型 (LLM) 已成为我们生活和工作中不可或缺的一部分,通过其惊人的多功能性和智能改变了我们与信息交互的方式。尽管它们的能力令人印象深刻,但它们并非没有缺陷。这些模型可能会产生误导性的“幻觉”,依赖可能…- 7

- 0

-

RAG实践|Rerank如何提升LLM查询效率与准确性

本文的核心议题是RAG中Rerank技术及其在提升语言模型(LLM)查询效率与准确性方面的应用。Rerank策略能够在不削弱查询精确度的前提下,实现实质上的查询加速效果,甚至有可能增强查询结果的准确性。该技术通过从给定的上下文中筛选并移除无关节点,同时对剩余的相关节点进行重新排序,从而达到优化查询性能的目的。点关注不迷路 背景二阶段检索器(Two…- 5

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!