-

AI Agent 记忆技术浅析

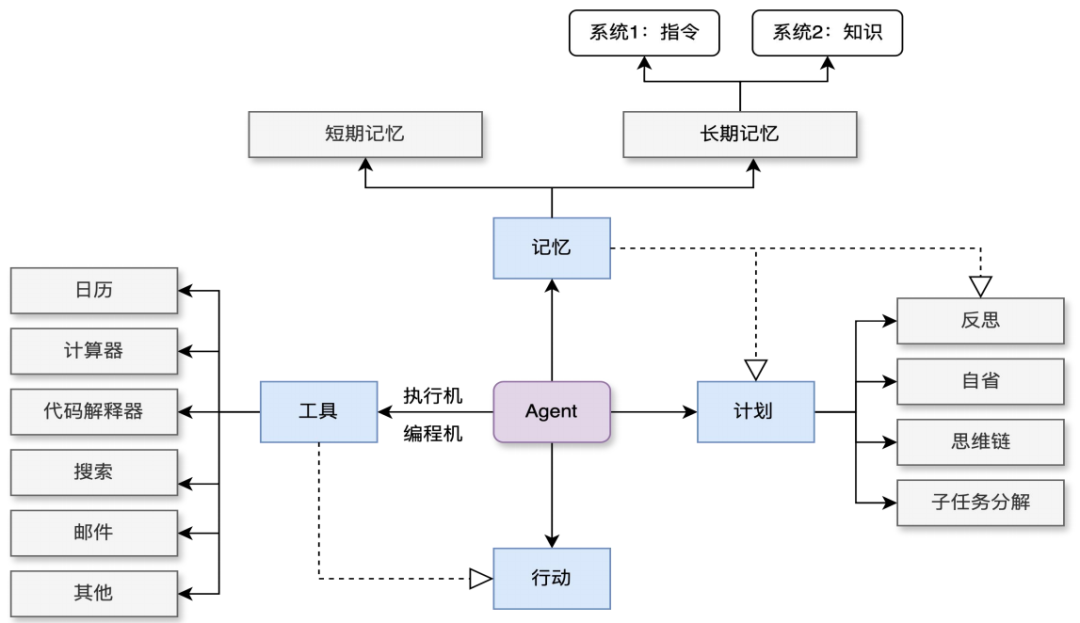

什么是Agent记忆?Agent记忆(Agent Memory)是指AI Agent在执行任务过程中存储和管理信息的能力和机制。它类似于人类的记忆系统,使Agent能够记住过去的交互、经验和知识,并在后续任务中利用这些信息做出更好的决策。这种记忆机制对于实现持续学习和处理长期任务至关重要。什么Agent需要记忆?从技术角度来看,Agent的记忆本质上是对大模型有限上下文的一种扩展。在Agent的生…- 7

- 0

-

一个MCP网站推荐&Demo验证

集成 AI 模型的痛点复杂性与集成成本:现有系统或第三方系统中嵌入 AI 模型往往需要大量定制化开发,过程复杂且容易出错。MCP 开放标准的意义开放生态的重要性:MCP 作为一个开放标准,这种开放性有助于形成良好的生态系统,推动技术和产品的持续发展。1、推荐MCP服务目录站https://www.pulsemcp.com/2、检索到一个RAG的站点MCP服务3、服务Serverhttps://gi…- 4

- 0

-

MCP 未来六个月展望

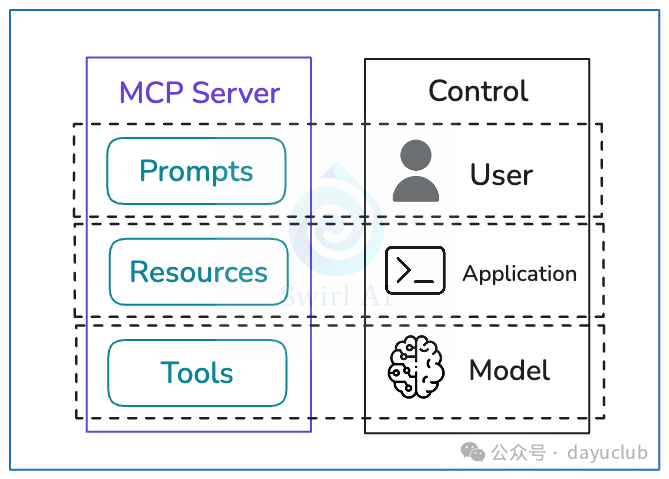

1、读到了一篇对MCP的分析,特别是在划分权限与控制方面有了一个独特的理解MCP 服务器将三种元素分配给不同的控制方:①提示(Prompts):由用户掌控,程序员提供选项,用户可注入到 LLM 中。②资源(Resources):由应用(AI 工程师)管理,决定数据使用方式,LLM 不自动干预。③工具(Tools):由 LLM 控制,服务器提供工具列表,LLM 自主选择并调用。2、这个是RAG 是当…- 7

- 0

-

Dify v1.1.0 发布:用元数据给知识库”贴标签”,RAG 检索效率翻倍

今天,我们很高兴地宣布发布 Dify v1.1.0,并推出了以“元数据”作为知识过滤器的新功能。通过利用自定义的元数据属性,元数据过滤能够提升知识库中相关数据的检索效率和准确度。过去,用户只能在庞大的数据集中进行搜索,无法根据特定需求进行筛选或控制访问,难以快速锁定最相关的信息。而在引入元数据后,相当于给数据打上标签并进行归类,大幅度提高了检索的效率和准确性。对于在 RAG(检索增强生成)场景下需…- 11

- 0

-

企业搭建大模型 RAG 知识库?该选哪个 Embedding 嵌入模型

需求:企业在搭建 RAG 知识库的时候,选择合适的 Embedding 嵌入模型很重要,Embedding 的性能决定了检索的准确性,也间接决定了大模型输出的可信度。常用模型:bge、m3e、nomic-embed-text、BCEmbedding(网易有道)。为什么需要嵌入模型计算机本质上只能处理数字运算,无法直接理解自然语言、文字、图片、音频等非数值形式的数据。因此,我们需要通过“向量化”操作…- 14

- 0

-

【停用词】NLP中的停用词怎么获取?我整理了6种方法

一、停用词介绍在自然语言处理(NLP)研究中,停用词stopwords是指在文本中频繁出现但通常没有太多有意义的词语。这些词语往往是一些常见的功能词、虚词甚至是一些标点符号,如介词、代词、连词、助动词等,比如中文里的"的"、"是"、"和"、"了"、"。"等等,英文里的"the"、…- 6

- 0

-

什么是停用词表?构建RAG系统时为什么要注意异常停用词?

停用词表在英文中叫:Stop Words List,它是一个包含常见、但通常对文本分析或自然语言处理任务 不重要的词汇 的列表。停用词表一般在信息检索、文本分类、情感分析等场景被使用。因为某些词汇其高频出现在表达具体意义时作用有限,因此被称为“停用词”。在处理文本数据时,通常会将这些停用词从文本中移除,以减少数据的稀疏性,提高处理效率,并可能提升后续分析或模型的性能。停用词出了…- 5

- 0

-

2W8000字深度剖析25种RAG变体:全网最全~没有之一

主流RAG框架可以分为以下五个主要的进化方向:成本控制型(适合初创公司)、实时互动型(适用于财经/新闻场景)、域专家类型、认知增强型、安全与合规类型。接下来,让我们详细了解一下这25种RAG变体。1. 标准RAG一个基本的RAG系统由检索模块和生成模块组成。系统会对查询进行编码,检索相关的文档块,然后为基于transformer的LLM构建丰富的提示。查询编码器:使用预训练的转换器(例如DPR)生…- 7

- 0

-

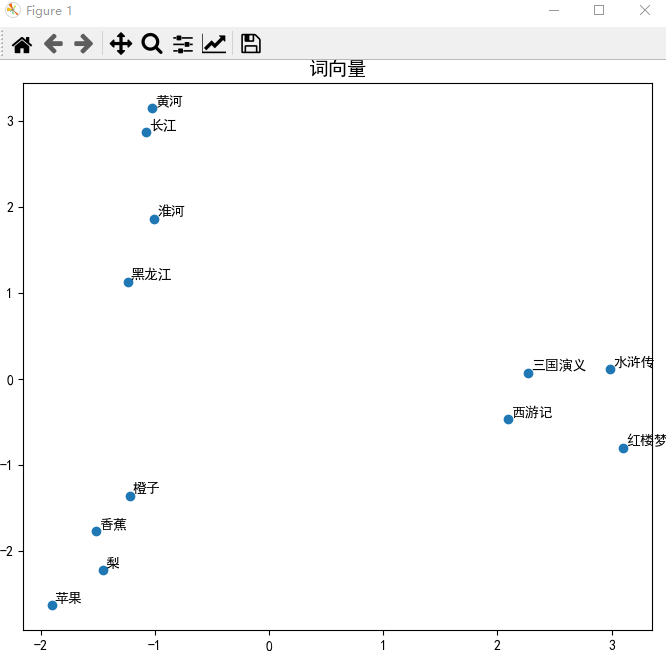

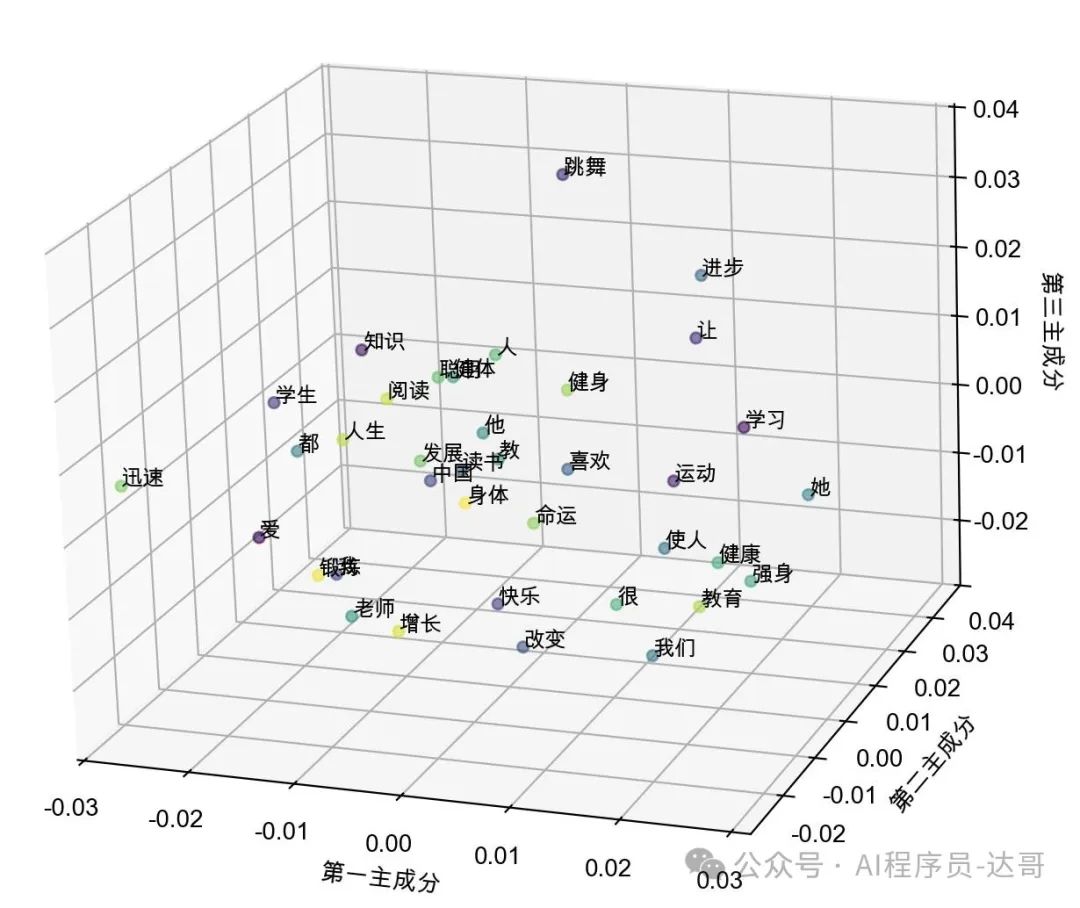

一文搞懂什么是向量嵌入Embedding?

一起来开个脑洞,如果诸葛亮穿越到《水浒传》的世界,他会成为谁?武松、宋江、还是吴用?这看似是一道文学题,但我们可以用数学方法来求解:诸葛亮 + 水浒传 - 三国演义 = ?文字本身无法直接运算,但是如果把文字转换成数字向量,就可以进行计算了。而这个过程,叫做“向量嵌入”。「为什么要做Embedding?」因为具有语义意义的数据(如文本或图像),人类可以分辨它们的相关程度,但是无法量化,更不能直接计…- 9

- 0

-

构建企业RAG系统的全面过程,遵循“Garbage in, garbage out” 原则

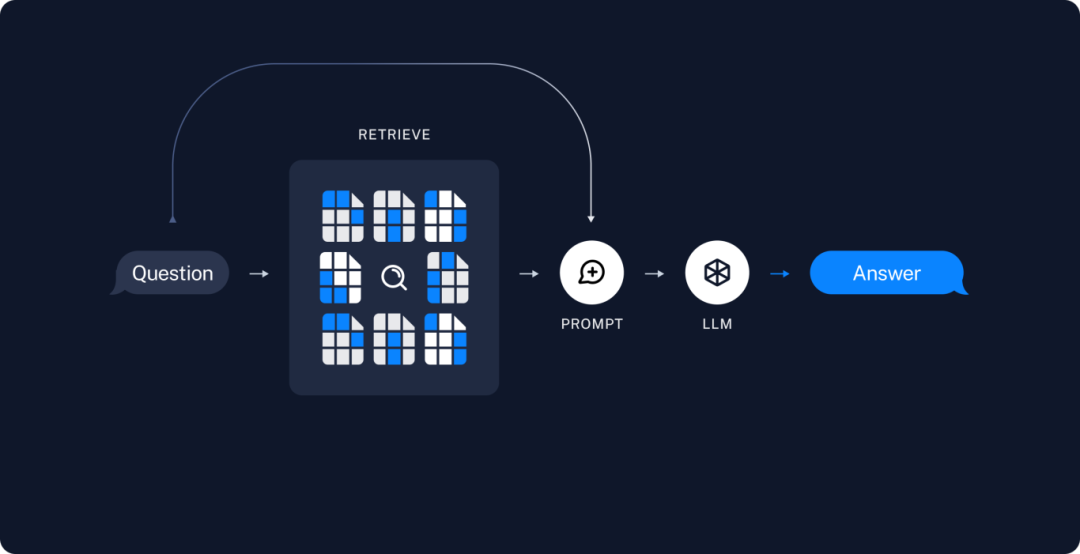

零、企业知识库治理很重要1、遵循“Garbage in, garbage out” 原则,只有确保链路每一步的数据和处理结果高质量,最终效果才会满足准确率。所以企业数据治理很重要,数据治理不科学,也就不要想结果科学了。2、RAG是当前比较确认的数据治理框架,今天展开唠唠。一、什么是RAG?检索增强生成(Retrieval Augmented Generation),简称 RAG。结合向量检索(Re…- 5

- 0

-

LangChain进阶指南:RAG实践总结

为什么要使用RAG?当下领先的大语言模型(LLMs)通过大规模数据训练来掌握广泛的普遍知识,这些知识存储在其神经网络的权重中。然而,如果要求LLM生成涉及其训练数据以外的知识(如最新、专有或特定领域信息),就会出现事实上的错误(称为"幻觉")。通过使用微调(fine-tuning)或是检索增强生成(RAG)方式都可解决这一问题。但通常使用微调通常需要耗费大量计算资源、成本高昂,…- 5

- 0

-

AISearchPro-AI智能搜索实践

01背景随着业务的不断扩展,我们的后台系统菜单项必定也会随着不断增加,这可能会给用户在寻找特定功能菜单时带来困扰。进一步复杂化的是,不同子模块或者不同业务项目的菜单名存在命名模糊或相近的现象。考虑到当前OpenAI的流行趋势,可以考虑利用 Text-Embedding 文本嵌入的方式来实现智能检索,以进一步提升用户体验和便利性。基于此场景,本文会介绍搜索实践的两种方案:1、利用LangChain,…- 4

- 0

-

Embedding、向量模型怎么选?知识库准不准还得看它

概念定义与层级关系Embedding(嵌入模型)指将非结构化数据(如文本、图像)转换为低维稠密向量的技术或过程,其核心目标是捕捉数据语义特征,例如:文本Embedding:将句子映射为1536维向量,使语义相似的句子向量距离更近;图像Embedding:将图片转换为向量,支持跨模态检索。向量模型(Vector Model)指直接使用Embedding生成的向量进行任务处理的模型,…- 20

- 0

-

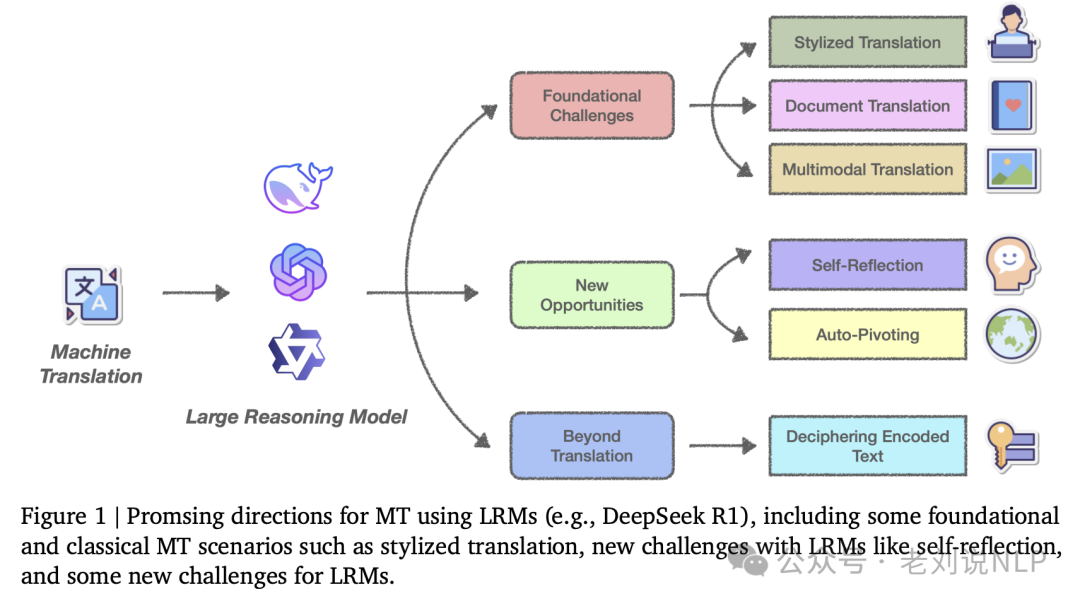

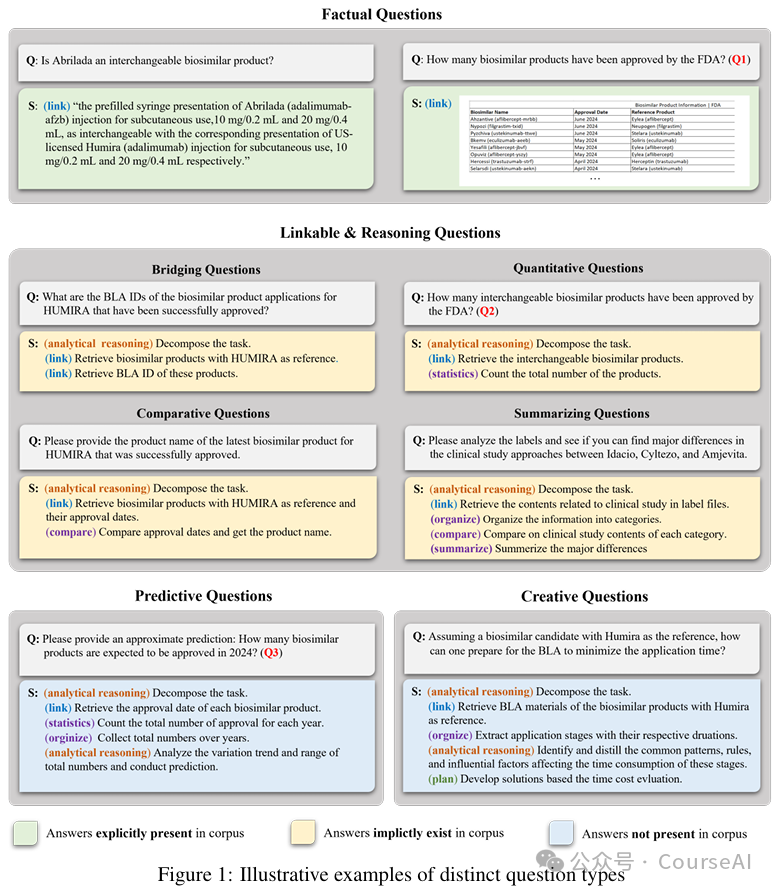

RAG中的chunk质量如何评分?HiRAG对GraphRAG的改进思路及推理大模型用于机器翻译

本文继续看RAG相关进展,三件事儿。一个是关于推理模型用于机器翻译的有趣观点,DeepseekR1这种推理模型用在翻译上会成啥样?一个是如何量化RAG中chunk的有效性?这个比较重要。一个是如何缓解GraphRAG中局部信息和全局信息存在Gap以及实体相似性不足问题?抓住根本问题,做根因,专题化,体系化,会有更多深度思考。大家一起加油。一、推理模型用于机器翻译会成啥样? 关于推理大模型…- 5

- 0

-

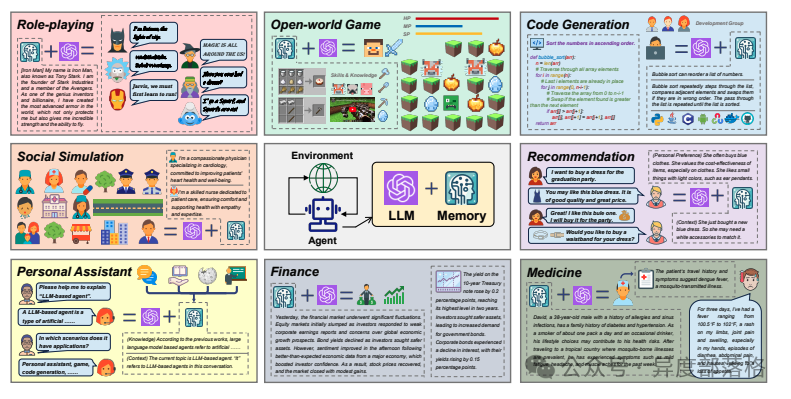

大白话讲解: Agent、 LLM 、RAG 、提示词工程

一、Agent(智能体)——AI里的"打工人"想象你有个24小时待命的虚拟员工,能自己观察环境、思考对策、调用工具完成任务,这就是智能体。和传统AI的区别:传统AI像机器,只能按固定流程执行命令;而Agent更像真人,能灵活应对复杂情况。比如,它能根据用户需求自动分解任务(比如订机票→查天气→推荐行程),还能调用数据库、计算工具等。核心能力:记性好(长期记忆+短期记忆)、会做计…- 8

- 0

-

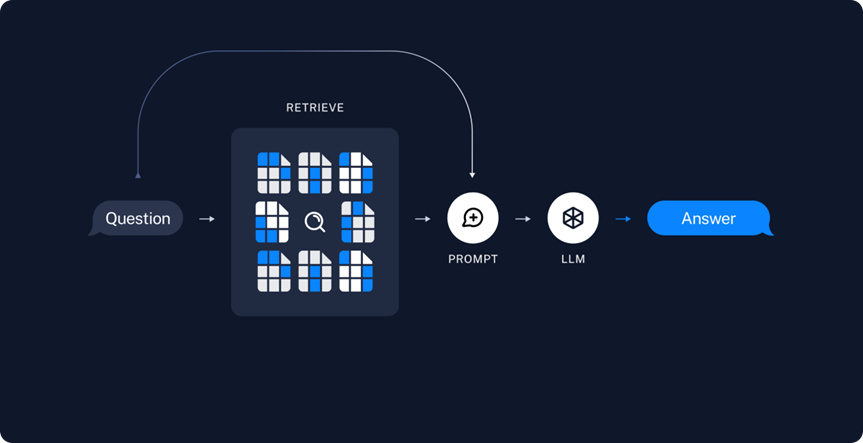

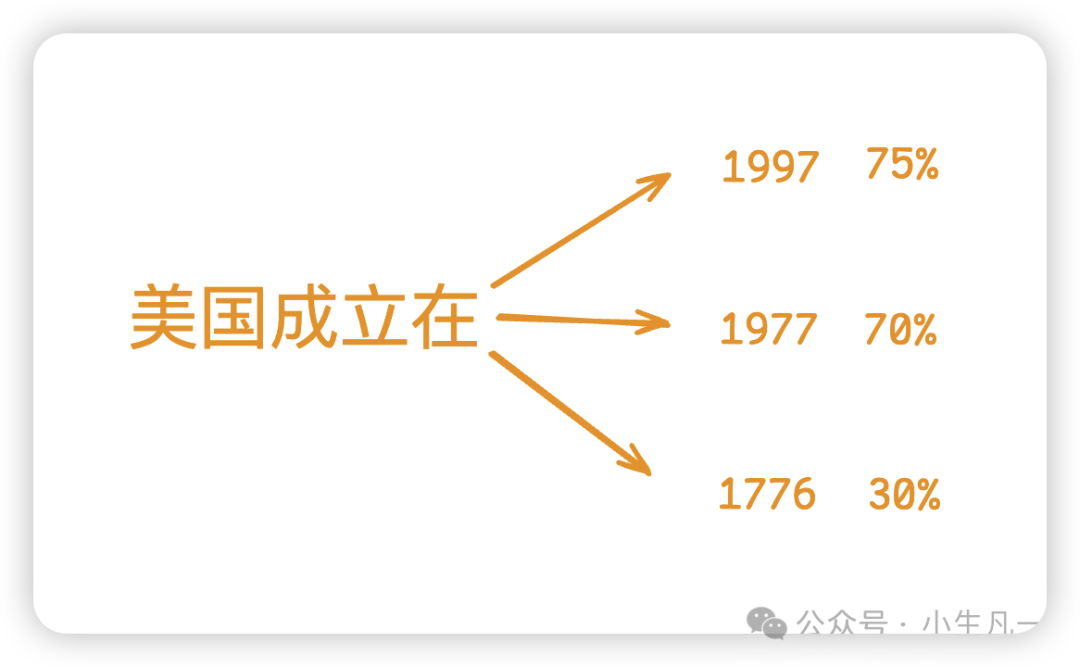

什么是RAG?大模型和RAG有什么关系?

写在前面在讲RAG之前,我们先说一个大模型的普遍现象,大家应该都用过大模型了,比如 ChatGPT、DeepSeek、豆包、文心一言等等…那么大家在用的时候其实会发现,有时候大模型会乱回答,一本正经地胡说八道,语义不同,前言不搭后语。举个例子:你问大模型,美国成立时间。大模型可能会回答:美国成立在1997年,距离现在已有400年的历史…这种现象叫hallucination,幻觉。大模型本质的就是不…- 6

- 0

-

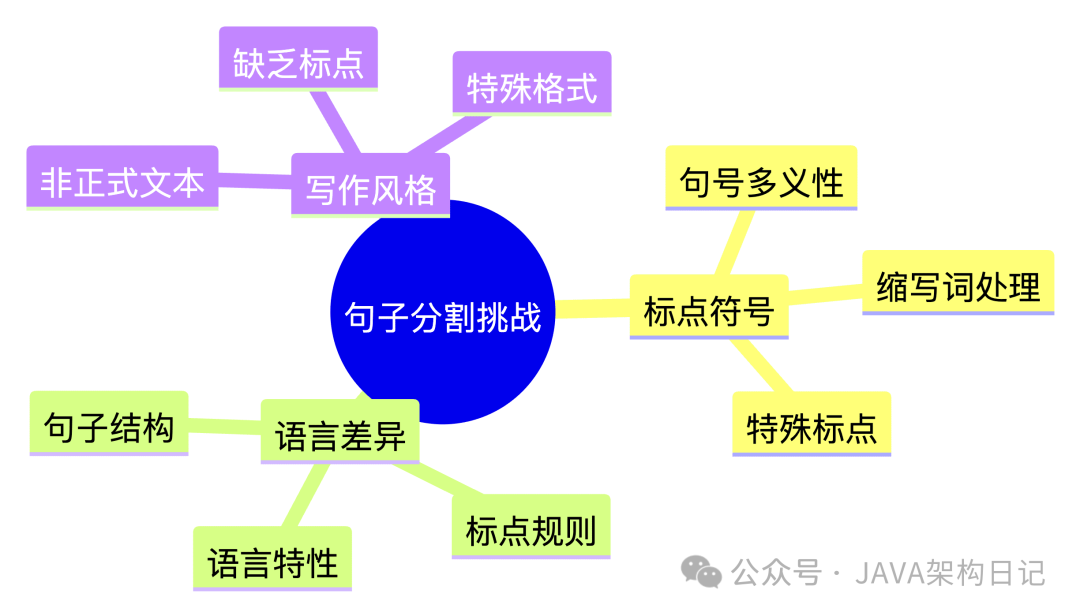

RAG效果差竟因文本切片!深入理解LangChain4J NLP方案

背景RAG 文本切片文本切片是构建高效RAG(检索增强生成)系统的关键预处理步骤:• 首先,语言模型的上下文窗口限制要求将长文本切分为语义完整的段落,确保关键信息能被完整捕获;• 其次,精准的切片策略能提升向量检索的查准率,避免因信息过载导致的语义稀释问题;• 最后,合理的切片粒度(如句子或段落级)可保持语义连贯性,为后续的上下文推理基础。这种预处理机制直接决定了RAG系统在知识召回精度和生成内容…- 8

- 0

-

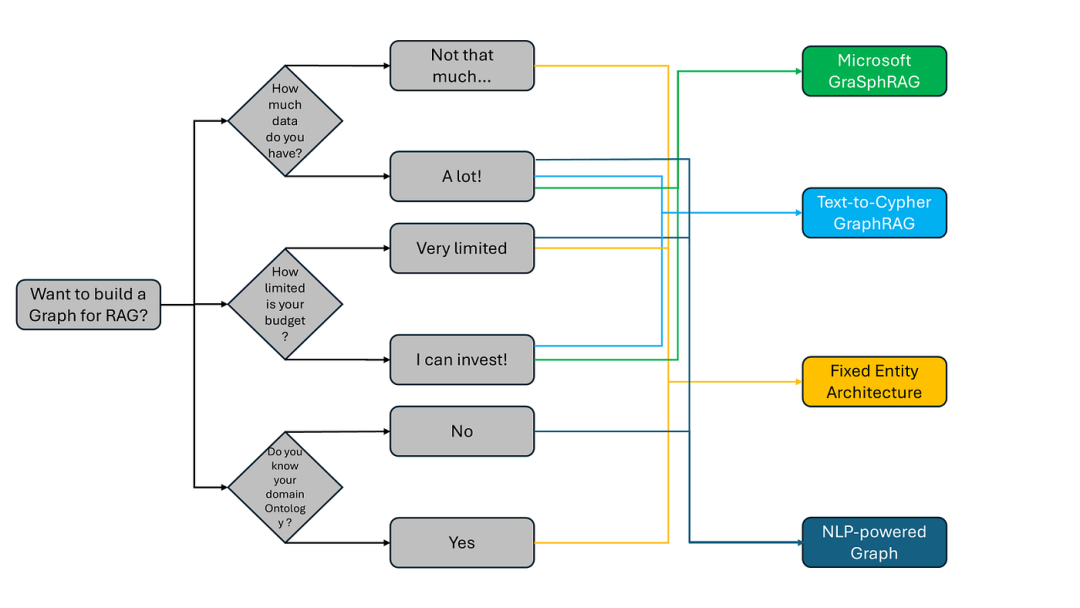

NLP+图技术:如何低成本打造高效GraphRAG应用?

利用 NLP 构建混合图,赋能 RAG 和 GraphRAG 应用本文将介绍如何利用自然语言处理 (NLP) 的强大功能,构建用于检索增强生成 (RAG) 和图 RAG (GraphRAG) 应用的混合图。什么是 GraphRAG?GraphRAG …- 6

- 0

-

使用 Ollama 本地模型与 Spring AI Alibaba 的强强结合,打造下一代 RAG 应用

01RAG 应用架构概述Cloud Native 1.1 核心组件Spring AI:Spring 生态的 Java AI 开发框架,提供统一 API 接入大模型、向量数据库等 AI 基础设施。Ollama:本地大模型运行引擎,大模型时代的 Docker,支持快速体验部署大模型。Spring AI Alibaba:Spring AI 增强,集成 DashScope 模型平台,快速构建大模…- 2

- 0

-

一文学会基于LangChain开发大模型RAG知识问答应用

RAG全称是Retrieval-Augmented Generation,即检索增强生成。通俗来讲,就是在用户提的问题的基础上,引入相关资料信息,把“问题+相关资料” 一起给大模型,让大模型在参考资料的约束或提示下回答问题而不是随意发挥,从而期望大模型生成质量更高、更准确的答案,改善大模型”幻觉“、训练数据过时、 知识范围有限等带来的负面问题。在涉及到专业领域知识或企业内部知识的应用场景中,这项技…- 3

- 0

-

GraphRAG落地难,微软工业级RAG+Agent实施方案

一、RAG面临的问题RAG系统需要处理来自不同领域的复杂数据,包括文本、表格、图表等,这些数据的格式多样,且包含大量非文本信息。现有的RAG方法在处理这些复杂数据时,存在以下问题:知识源多样性复杂RAG系统需要处理来自不同领域的多样化数据,这些数据不仅格式多样(如扫描图像、数字文本文件、网页数据等),还可能包含专业数据库。现有的RAG方法在处理这些复杂数据时,难以高效提取专业领域知识。领域专业性不…- 8

- 0

-

Embedding向量模型在RAG本地知识库中如何使用

一、背景 当我们使用检索增强生成(RAG)技术来搭建本地知识库时,Embedding 模型就如同这个图书馆的智能索引系统,能让我们快速准确地找到所需的知识。 对于刚接触这一领域的小白来说,Embedding 模型到底是什么,它在本地知识库中扮演着怎样的角色,可能还比较模糊。 …- 8

- 0

-

DeepSearch/DeepResearch中最优文本段选择和URL重排

从长网页提取最优文本段:如何利用迟分(late-chunking)算法,从长网页内容中选取最相关的信息小片段。对收集到的URL进行重排:如何利用重排器(Reranker) 让 LLM Agent 在几百个URL中聪明地选择爬取哪一个 URL?可能有人还记得我们上一篇里的结论:“在 DeepSearch 中,Embeddings 模型仅适用于诸如 STS(语义文本相似度)任务之类的查询去重,而 Re…- 6

- 0

-

大模型私有知识库如何提高准确率?切块是关键

前言RAG 就像我们做开卷考试,在回答考题之前,先翻我们准备的资料(通过检索相关文档来增强自己的能力),这样一来,答题不仅更准确,还能带上更多上下文信息,显得更有深度和针对性。在 RAG 中,我们需要提前预备知识资料,然后向量化后存到向量数据库中,在回答问题的时候,并对问题进行向量化,然后去检索我们数据库是否有相似的内容,如果相似则召回,并把召回的内容一并给到大模型(如:Deepseek),然后通…- 4

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!