-

全面介绍!多模态数据与大模型

以前,我们的机器学习模型一般都只处理一种类型的数据,比如只处理文本(翻译、语言建模)、图像(对象检测、图像分类)或音频(语音识别)。但是,想想我们人类的大脑。我们不仅仅读写文字,还可以看图、看视频,听音乐,还能够辨识各种不同的声音。所以,为了让AI更接近真实世界,处理多种类型的数据显得非常重要。OpenAI 在他们的 GPT-4V 系统简介 中提到:有人认为,把其他数据类型(比如图像输入)融入到大…- 10

- 0

-

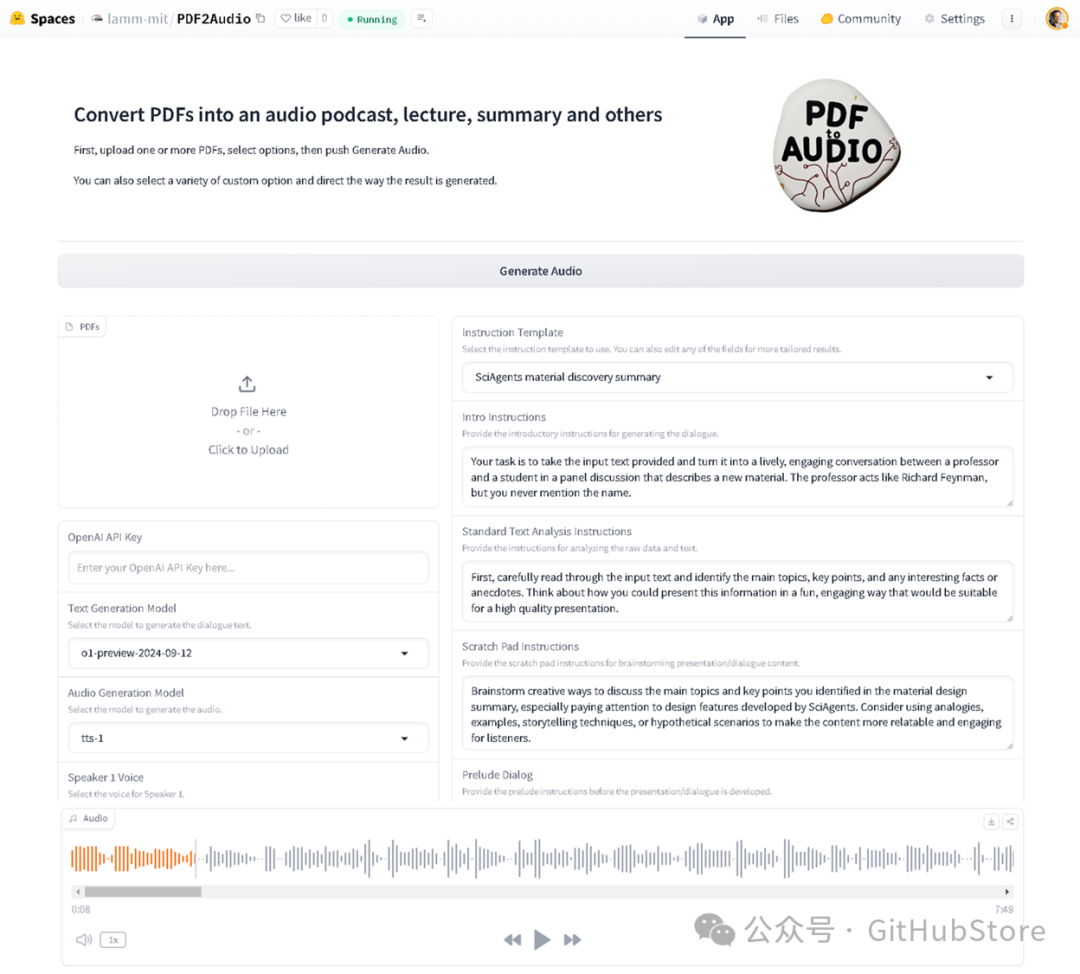

将PDF文档转换成音频播客、讲座或摘要PDF2Audio

项目简介此代码可用于将 PDF 转换为音频播客、讲座、摘要等。它使用 OpenAI 的 GPT 模型进行文本生成和文本到语音的转换。您还可以编辑草稿记录(多次)并提供具体评论或有关如何调整或改进的总体指示。特征上传多个PDF文件从不同的教学模板中进行选择(播客、讲座、摘要等)自定义文本生成和音频模型为扬声器选择不同的声音通过具体或一般性评论和/或对文本的编辑以及对模型的具体反馈来迭代草稿以进行改进…- 6

- 0

-

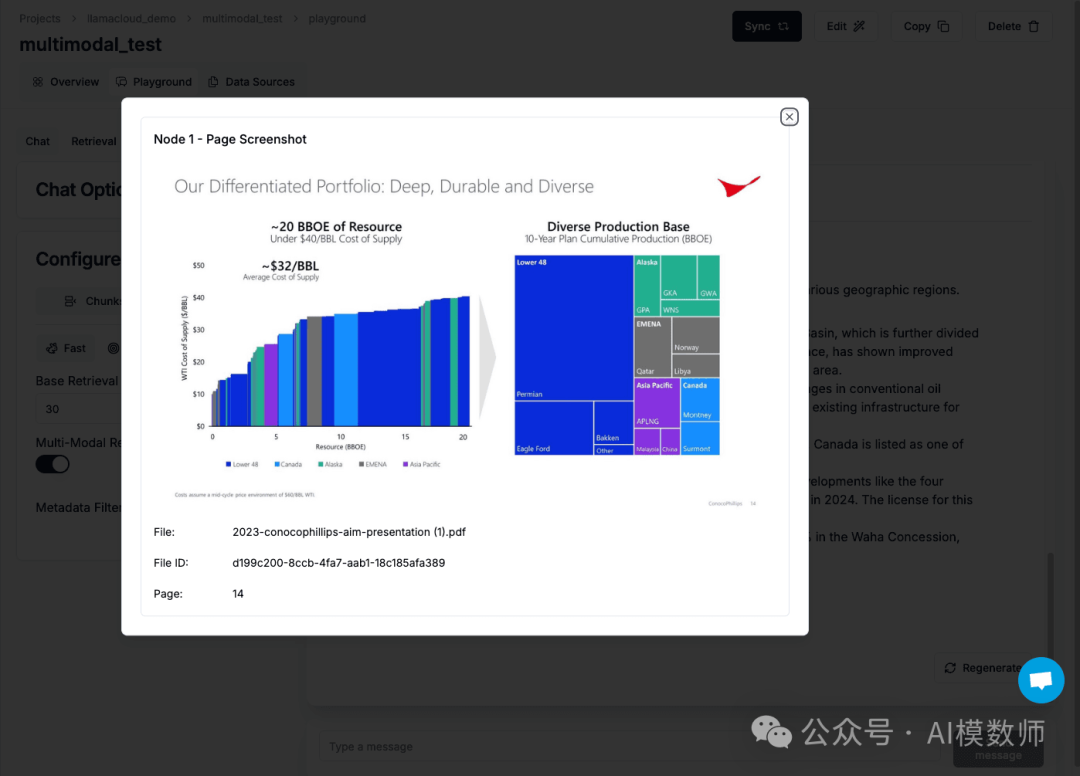

【深入浅出RAG】通过LlamaCloud打造多模态RAG

文档RAG的未来是多模态的许多实际中的文档不仅包含文本,还包含复杂的视觉元素,如图像、图表和图解。传统的RAG系统往往只关注文本。这导致文档理解能力下降,响应质量降低,幻觉率增加。多模态LLM和RAG系统可以解决这些复杂性——像Pixtral、Sonnet 3.5和GPT-4o这样的多模态LLM在文档理解方面越来越好。我们的客户要求我们提供这些功能,用于高级知识助手用例,比如生成包含图表和图像的结…- 4

- 0

-

探索阿里通义千问的 Qwen2-VL:新一代视觉语言模型本地体验实战大全

一、模型特点1. 强大的视觉理解能力任意分辨率图像识别:Qwen2-VL 可以读懂不同分辨率和不同长宽比的图片,无论图像的清晰度或大小如何,都能轻松识别。这得益于其独特的 naive dynamic resolution 支持,能够将任意分辨率的图像映射成动态数量的视觉 token,保证了模型输入和图像信息的一致性,模拟了人类视觉感知的自然方式。长视频理解:该模型能够理解超过 20 分钟的长视频,…- 6

- 0

-

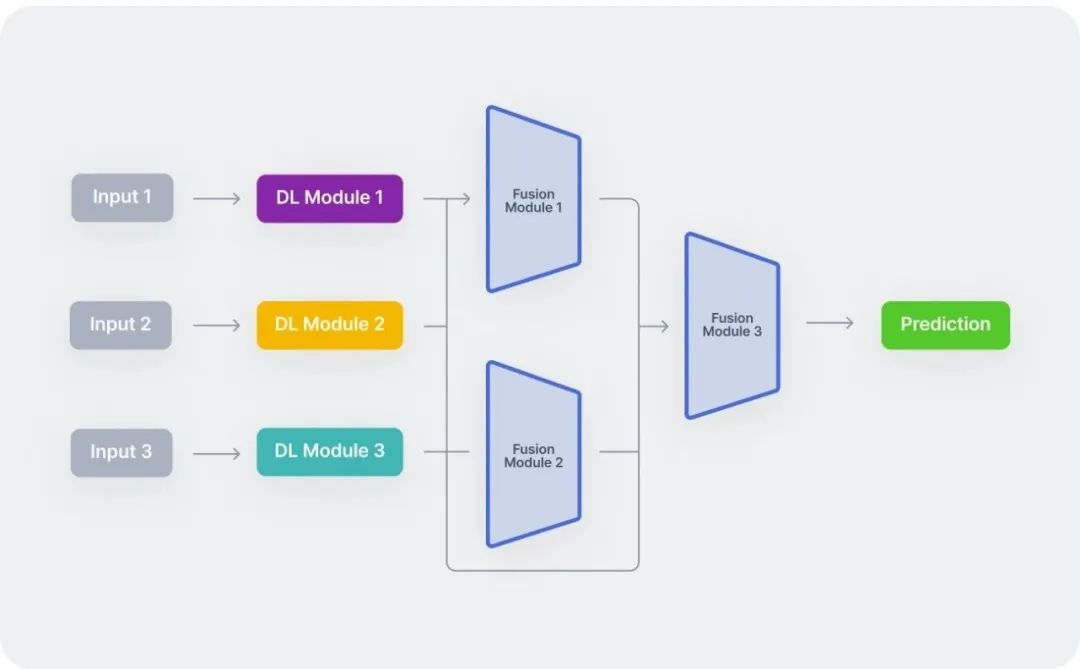

一文彻底搞懂多模态 – 基础知识

MultiModal在人工智能的不断发展中,多模态学习逐渐崭露头角,成为了一个重要的研究方向。它不再局限于单一类型的数据处理,而是将图像、文本、音频等多种信息源结合起来,为机器提供了更加丰富和多元的理解视角。接下来分四部分:传统机器学习、深度学习、优化算法、应用领域,一起来总结下多模型的基础知识。MultiModal一、传统机器学习什么是传统机器学习(Machine Learning)?传统机器学…- 5

- 0

-

忘掉Sora吧,快手最新的可灵1.5Pro让国外陷入疯狂!

快手发布了最新文生视频模型可灵1.5Pro版本,本次更新除了提升质量、光影、动作一致性、文本提示还原之外,最大亮点是能直接生成1080P影视级视频。很多国外用户认为其效果已经超过了Runway、Luma等国际一线产品。所以,他们对可灵的评价也比较简单粗暴就两个词——Insane和Amazing。值得一提的是,Runway昨天刚与好莱坞巨头狮门影业达成了技术合作,帮助他们的导演、制作人、创意人员用A…- 7

- 0

-

Ollama官方已支持MiniCPM-V 2.6模型

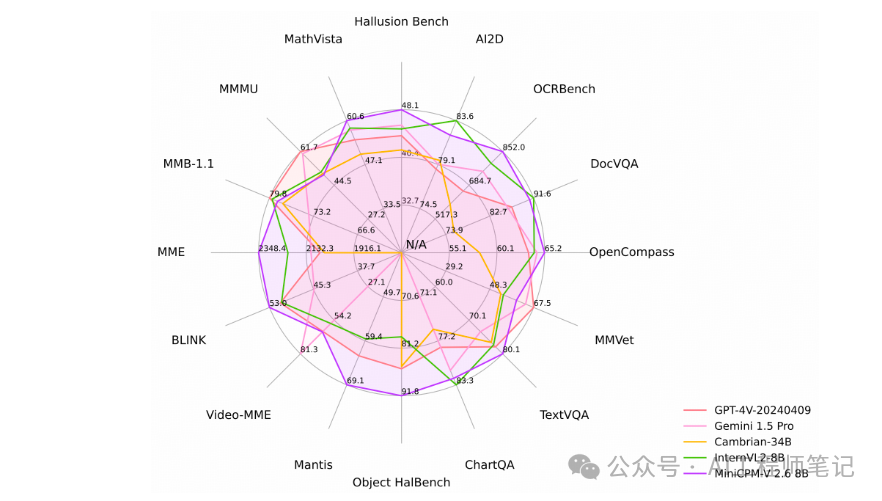

Ollama官方支持MiniCPM-V模型近日,ollama官方发布了v0.3.10版本,该版本已正式官方支持MiniCPM-V模型。新增模型:• MiniCPM-V:一个强大的多模态模型,在几个基准测试中具有领先的性能。• Yi-Coder:一系列开源代码语言模型,以少于100亿个参数提供最先进的编码性能。• DeepSeek-V2.5: DeepSeek-V2的升级版本,集成了DeepSeek…- 11

- 0

-

探索 Mini – Omni:开启语音多模态交互新征程

随着大模型技术的蓬勃发展,全球 AI 领域已经步入了多模交互的新纪元。2024 年 5 月 OpenAI 推出多模态模型 GPT4O 之后,语音文本多模态大模型的研究热度持续攀升。然而,现有的语音对话系统存在着一些亟待解决的问题。例如,很多模型无法有效地理解语音中的非文本信息,导致交互体验不够流畅和智能。同时,AI 回复迟缓的实时性问题也在很大程度上限制了语音交互系统在一些对实时性要求较高场景中的…- 5

- 0

-

探索新一代大模型代理(LLM agent)及其架构

在人工智能大模型(AI)的浪潮中,2023年我们见证了检索增强生成(Retrieval Augmented Generation, RAG)的兴起,而2024年则无疑成为了“代理”agent的元年。各大AI企业纷纷投身于聊天机器人代理的研发中,工具如MultiOn通过与外部网站的连接实现了快速增长,而框架如LangGraph和LlamaIndex Workflows则助力全球开发者构建结构化的代理…- 7

- 0

-

阿里 mPLUG-Owl3 震撼登场:通用多模态大模型的创新风暴来袭

在当今人工智能领域,多模态大模型的发展正以惊人的速度改变着我们与技术交互的方式。阿里发布的 mPLUG-Owl3 通用多模态大模型,以其在多图、长视频理解等方面的卓越表现,成为了行业内的焦点。本文将深入探讨 mPLUG-Owl3 的技术特点、实现原理以及广泛的应用场景,带您领略这一强大模型的魅力。一、mPLUG-Owl3 模型特点1、高推理效率mPLUG-Owl3 以 llava-next-int…- 11

- 0

-

Llama 3.1 Omni:颠覆性的文本与语音双输出模型

你可能听说过不少关于语言模型的进展,但如果告诉你,有一种模型不仅能生成文本,还能同时生成语音,你会不会觉得特别酷?今天咱们就来聊聊一个相当前沿的项目——Llama 3.1 Omni模型。这个模型打破了传统的文字生成边界,直接让文本和语音同时输出,实现了真正的"多模态"(multi-modal)能力。喜欢直接读论文的朋友,可以参考这里:https://arxiv.org/pdf/…- 8

- 0

-

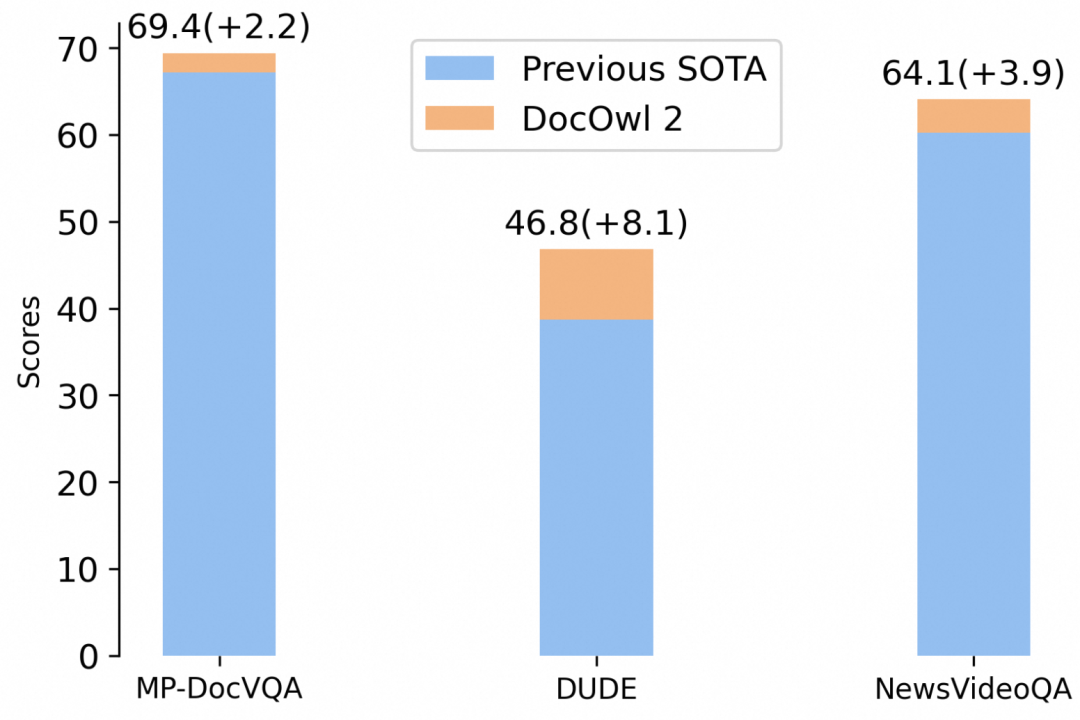

阿里8B模型拿下多页文档理解新SOTA,324个视觉token表示一页,缩减80%

高效多页文档理解,阿里通义实验室mPLUG团队拿下新SOTA。最新多模态大模型mPLUG-DocOwl 2,仅以324个视觉token表示单个文档图片,在多个多页文档问答Benchmark上超越此前SOTA结果。并且在A100-80G单卡条件下,做到分辨率为1653x2339的文档图片一次性最多支持输入60页!△单个A100-80G最多能支持文档图片(分辨率=1653x2339)的数量以及首包时间…- 8

- 0

-

Mac上运行微软最新Phi-3.5-mini大模型+开发Agent

Phi-3.5-mini[1]是微软广为人知的 Phi-3 模型的轻量级版本,旨在以无与伦比的效率处理多达 128K 个 token 的长上下文。该模型由合成数据和精心筛选的 Web 内容混合而成,在高质量、推理密集型任务中表现出色。Phi-3.5-mini 的开发用到了先进技术,例如监督微调和创新优化策略,还有近端策略优化和直接偏好优化。这些强劲的功能提升可确保出色地遵守指令和强大的安全协议,从…- 9

- 0

-

使用 Dify 和 AI 大模型理解视频内容:Qwen 2 VL 72B

接下来的几篇相关的文章,聊聊使用 Dify 和 AI 大模型理解视频内容。本篇作为第一篇内容,以昨天出圈的“黑神话悟空制作人采访视频”为例,先来聊聊经常被国外厂商拿来对比的国产模型:千问系列,以及它的内测版。写在前面最近一两周有好几位朋友线下聚的时候,聊起了端侧多模态模型,以及用端侧多模态模型做 RPA 和一些内容识别相关的业务场景。在展开聊这些内容前,我觉得或许可以先从“为个人偷懒”角度,来聊聊…- 7

- 0

-

语音识别大赛五连冠!开会就能用!

提问:5个人一起开会,随时打断、快速切换、边走边说,会议记录怎么对齐?虽说有AI记录,但在复杂的会议场景中,到底怎样实现高精准的语音识别和说话人分离?这个问题,现在已经可以解决了。近日,科大讯飞再获CHiME大赛冠军,在“会议室场景远场多人语音识别”任务中,突破了人数估计、语音重叠、远场混响、人员移动及对话风格随意等难关。把技术评测搬到会议室CHiME(Computational Hearing …- 9

- 0

-

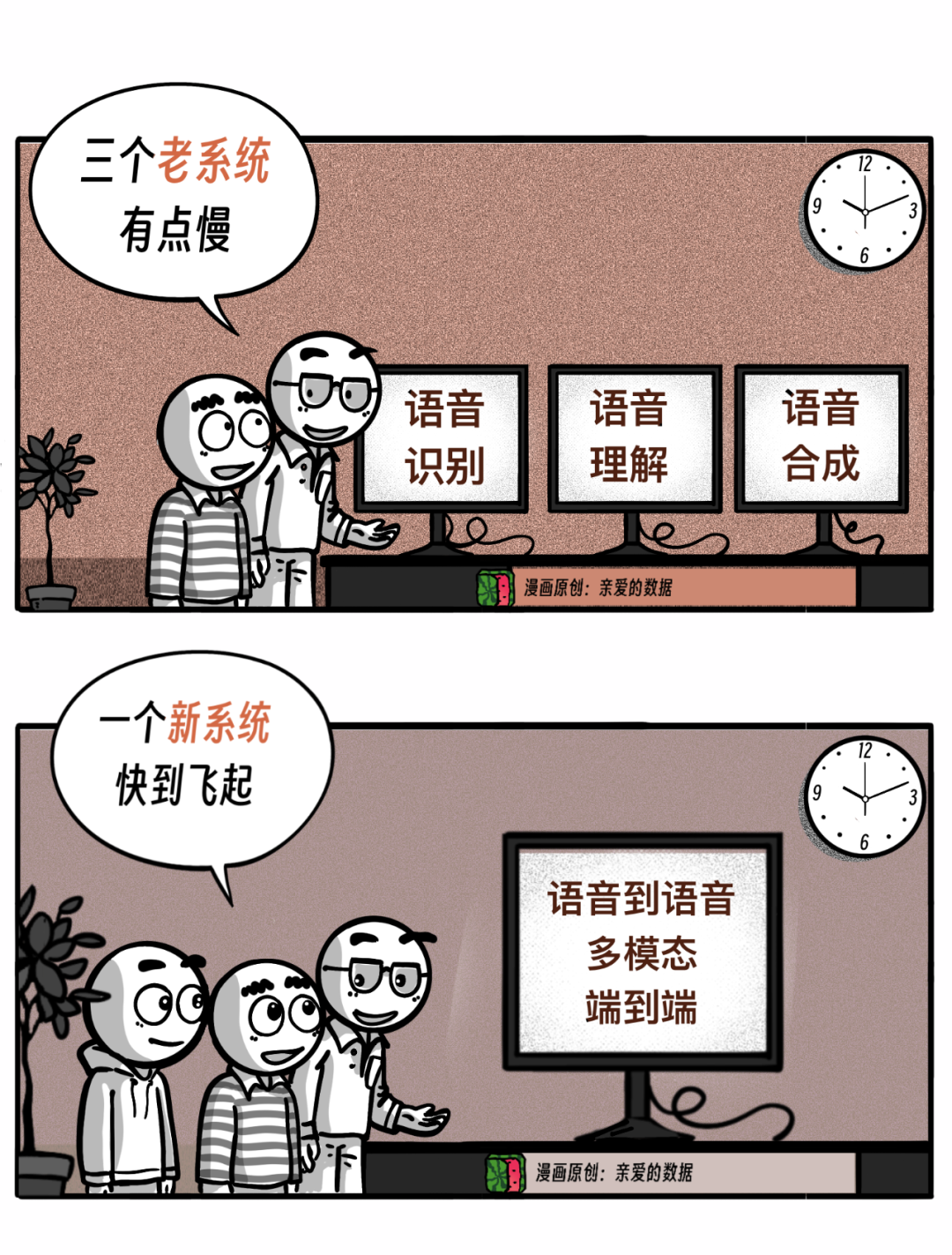

独家丨科大讯飞多模态:都说端到端好,看谁有本事先做出来

2024年8月19日那天,“星火极速超拟人”开放内测体验,我的“后援”群里有位专家,短平快点评了一句:“真不错,首个”。果然,还是CTO级别的技术大牛反射弧短。我没看透,人家结论都出来了。定定神,还有两点值得高兴高兴:第一,基础模型日趋同质化,没有新变量,可能要进入瓶颈;多模态的“多”字,能带来新机会;第二, 不是照猫画虎式的创新,GPT-4o从来没有公布实现方法,仅仅展示了成果。这意味,想实现,…- 4

- 0

-

国内首个多模型AI搜索引擎,专门为AI设计的搜索引擎

在如今信息爆炸的时代,如何搜到自己心仪的资料和信息非常重要。传统的搜索充斥着大量的广告和营销内容,使得用户识别价值信息非常困难。而且用户针对一个搜索,期望得到文字,视频,图片等多维度的信息。这也是传统搜索做不到的地方因此国内首个多模型AI搜索引擎——博查AI搜索,应运而生,目前正在公测阶段。01使用方法博查地址:https://bochaai.com/进来后页面非常干净,没有任何多余的广告或者营销…- 9

- 0

-

语音驱动嘴型与面部动画生成算法大盘点

在数字人领域,语音驱动嘴型与面部动画生成算法正发挥着越来越重要的作用。今天,就为大家分享几个目前具有代表性的算法,包括开源和未开源的。一、开源算法DeepFaceLive:这是一个功能强大的开源项目,能够实现实时的语音驱动面部动画。它利用深度学习技术,通过对大量的语音和面部表情数据进行训练,可以生成非常自然的嘴型和面部动画效果。用户可以根据自己的需求进行定制和调整,适用于各种数字人应用场景。开源地…- 28

- 0

-

如何利用视觉AI做自动化测试?–Applitools

什么是视觉AI测试?视觉测试可以理解为功能测试的一种特殊形式。通过视觉测试,断言等方式检测被测试应用或系统UI的视觉变化。而这些视觉AI解决方案可以使用视觉人工智能(Visual AI)来发现像缺失元素、扭曲布局和重叠文本这样的漏洞,这些问题常常被传统的自动化技术所忽视。本文以AI视觉测试解决方案applitools为载体进行讲解Applitools是如何工作的?测试是交互加上验证。测试用例步骤仅…- 34

- 0

-

视觉RAG:变革传统深度学习模型开发流程,开创下一代多模态视觉模型的新时代

我们相信视觉领域即将发生范式转变,从而产生计算机视觉管道 2.0,其中一些传统阶段(例如标记)将被可提示的基础模型所取代。本文深入剖析了Visual RAG(Visual Retrieval-Augmented Generation)的创新领域,揭示了它的核心价值以及它如何根本性地转变了我们对传统计算机视觉任务的处理方式。文章将从RAG的基本概念出发,深入探讨其在视觉识别、图像分析和智能监控等应用…- 10

- 0

-

Sora:大视觉模型的背景、技术、局限性

1、简介Sora 是一种文本到视频生成 AI 模型,由 OpenAI 于 2024 年 2 月发布。该模型经过训练,可以根据文本指令生成现实或想象场景的视频,并显示出模拟物理世界的潜力。与以前的视频生成模型相比,Sora 的特点是能够生成长达 1 分钟的高质量视频,同时保持对用户文本指令的遵守。Sora 的这一进展体现了长期人工智能研究使命,即为人工智能系统(或人工智能代理)提供理解运动中的物理世…- 5

- 0

-

基于Threejs的3D 互动虚拟展厅+ChatGPT 虚拟人聊天

前两天看到腾讯云媒体服务发布的一个基于web3D 技术构建的在线互动虚拟展厅,展厅的各个区域入口设有AI NPC(非玩家角色),这些AI助手基于ChatGPT,能够理解用户需求并提供专业、准确的回答,帮助用户更好地了解产品和技术。体验地址:https://trtc.io/showroom这里面很多技术细节都是之前自己做元宇宙的时候很想实现的功能,通过这个演示场景,对自己的元宇宙产品也得到…- 15

- 0

-

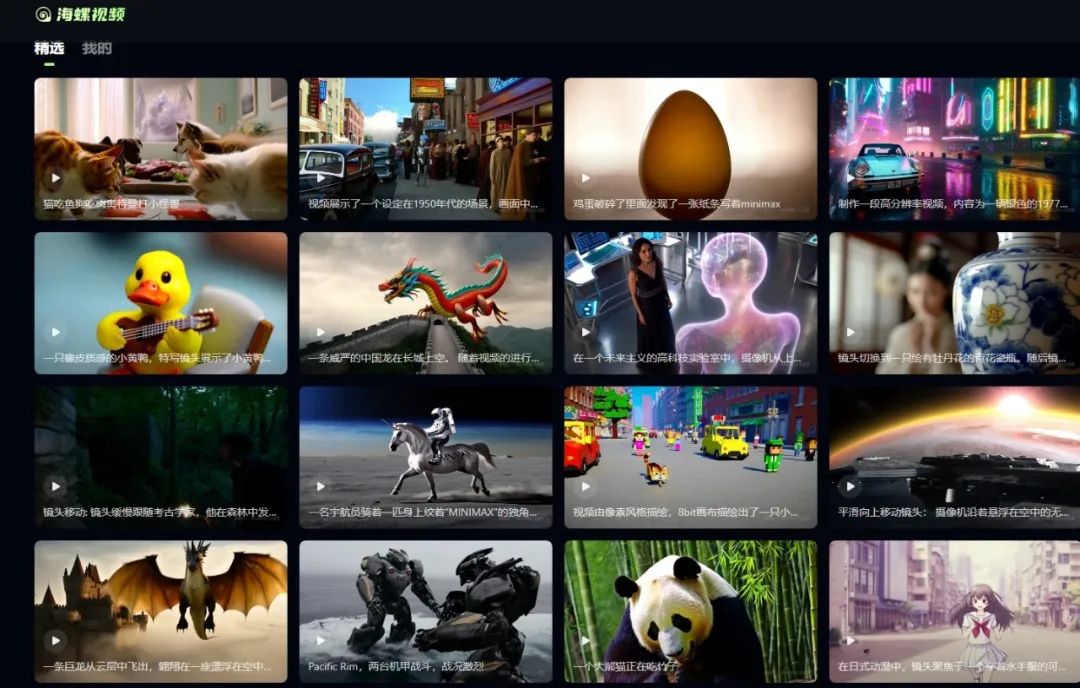

MiniMax发布AI视频生成模型:可生成6S,限时免费

MiniMax的视频生成模型终于来了。8月31日,MiniMax创始人、CEO闫俊杰在2024 MiniMax Link伙伴日活动上发布了MiniMax首款AI高清视频生成模型技术:abab-video-1。活动现场播放了自称全部由MiniMax视频模型所创作的2分钟AI短片《魔法硬币》。目前,短片《魔法硬币》已在MiniMax官方视频号上线。MiniMax称会将视频背后应用的prompt后续公布…- 14

- 0

-

火山 RTC+豆包大模型,给用户体验装上银色子弹

据相关数据显示,早在 2020 年,国内选择语音输入的用户数量已经达到 2.5 亿,使用率接近 40%,更为便捷的语音交流,已经越来越成为主流。前几年就涌现出许多深受用户喜爱的聊天室、语音房产品,而最近这一波 AIGC 浪潮之下,更是如雨后春笋,诞生了 AI 虚拟陪伴、AI 口语陪练、AI NPC、AI 游戏陪玩等等各种应用。遍地开花的产品,也激发了对更优质的 AI 语音交互的强烈需求。正如我们几…- 7

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!