-

官宣|Zilliz Cloud 建表功能大升级,更多检索类型支持,更低成本

和大家分享一个好消息,最近, Zilliz Cloud 建表功能迎来了一次重要更新。本次更新在用户界面上完整对齐了 SDK 能力,并带来了全新的交互体验,希望大家在构建数据模型时,少些繁琐,多些高效。 这次更新主要包括七个方面,接下来我们来一一介绍。 全面支持全文检索与文本匹配能力 在新版本中,全文检索会通过术语相关性对文档进行排序,显著提升 RAG 和关键词场景的准确性。它直接处理原始文本并自动…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

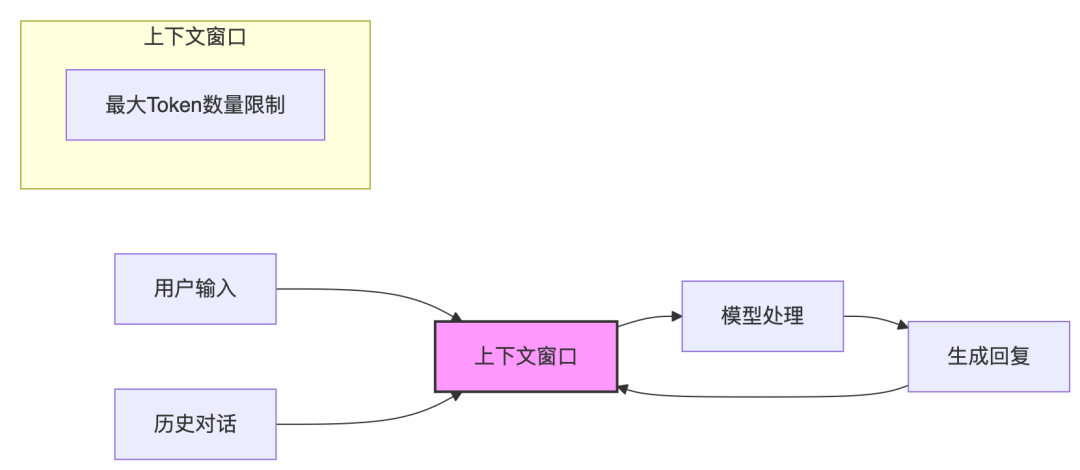

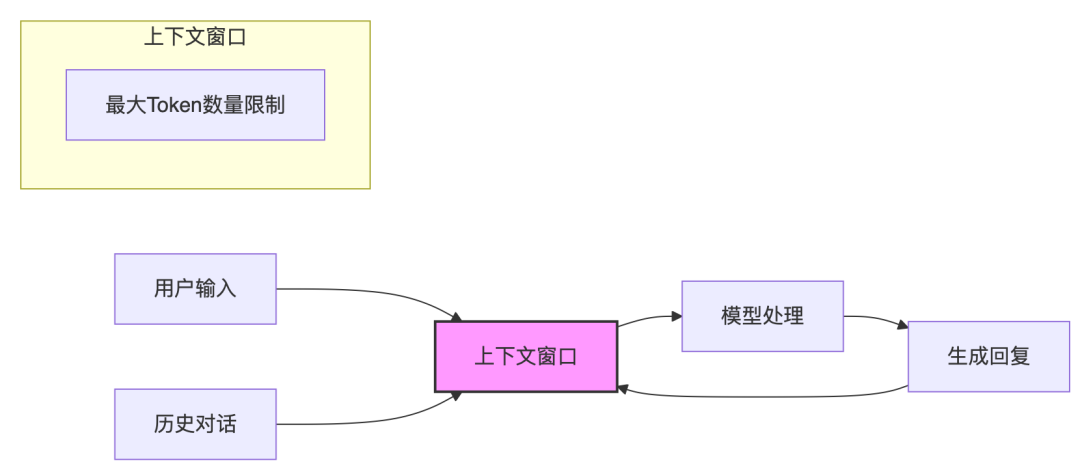

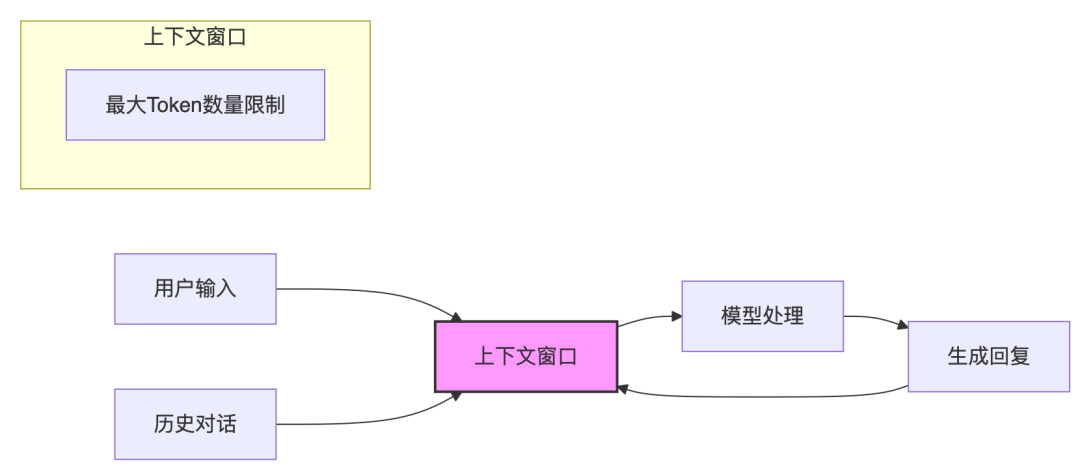

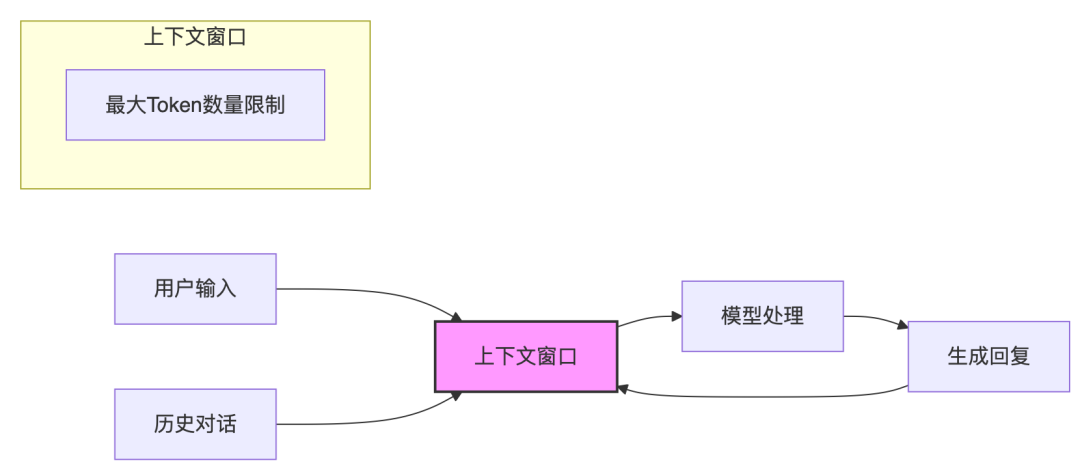

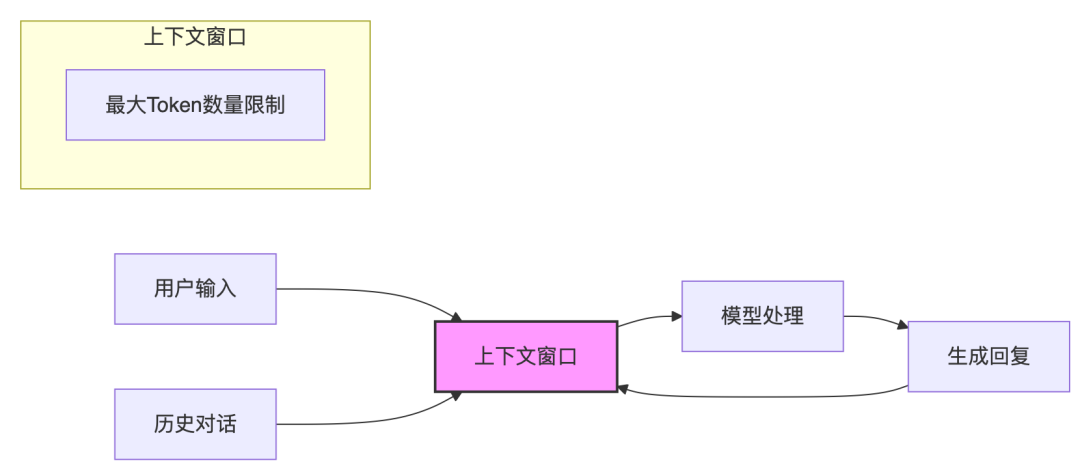

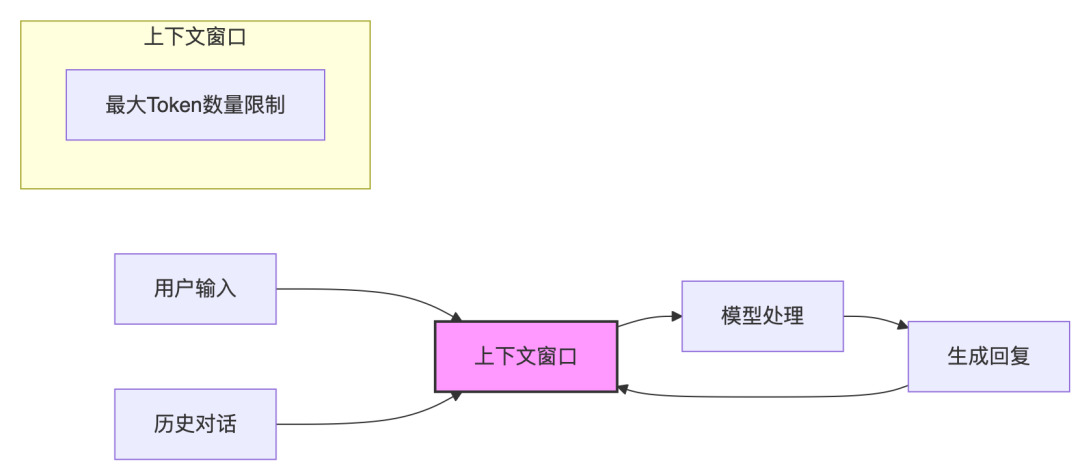

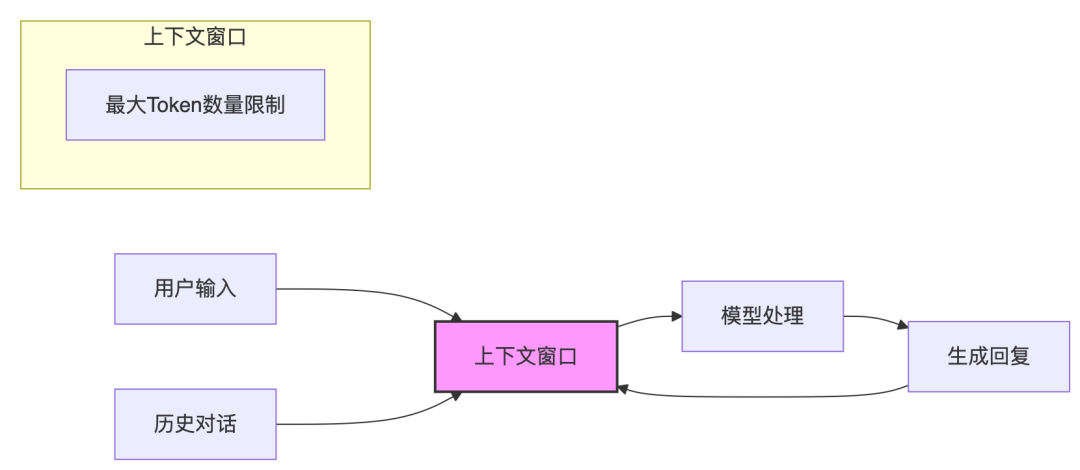

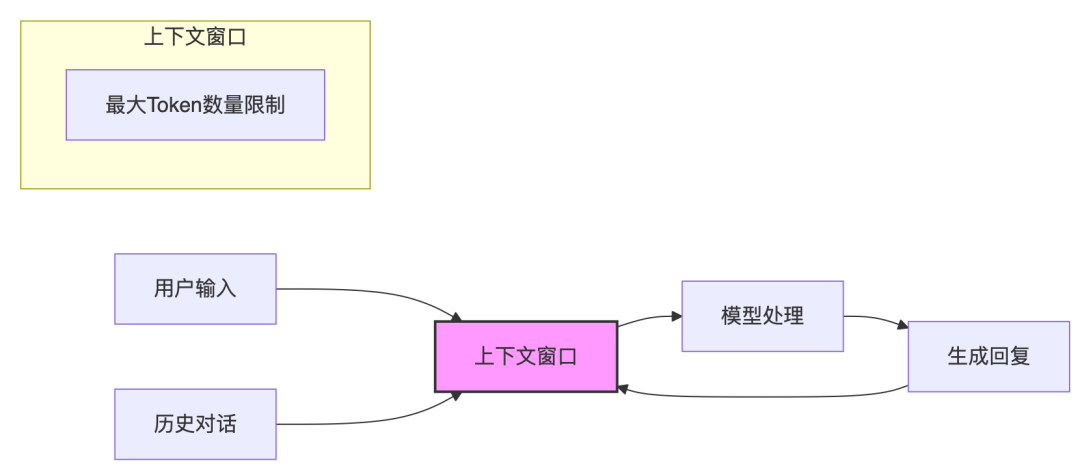

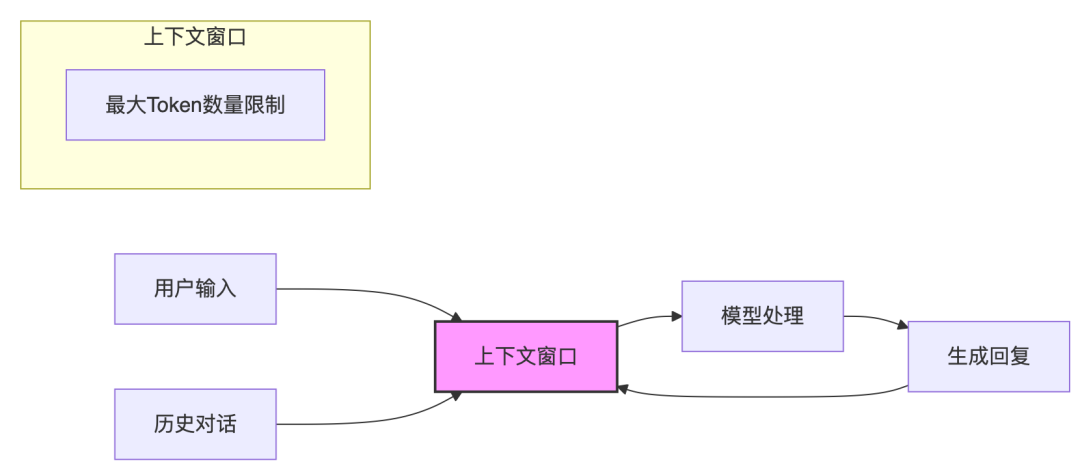

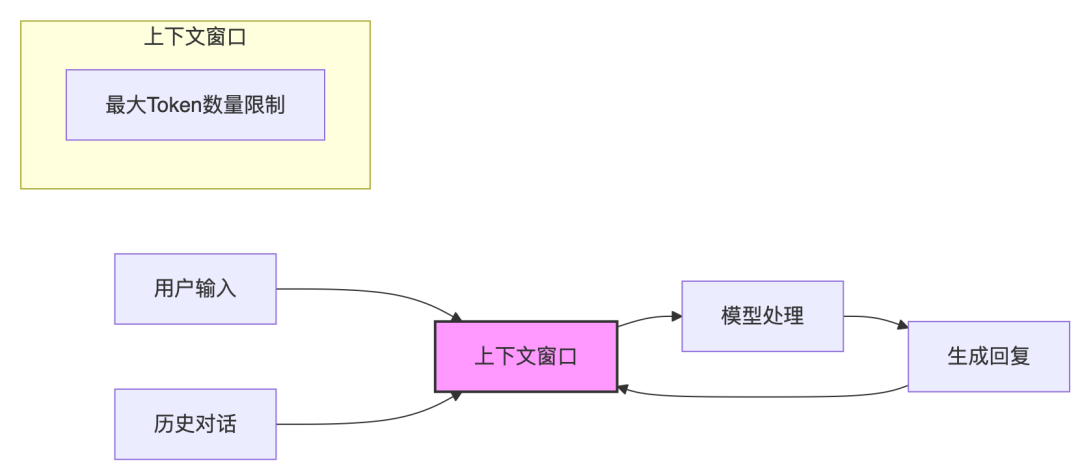

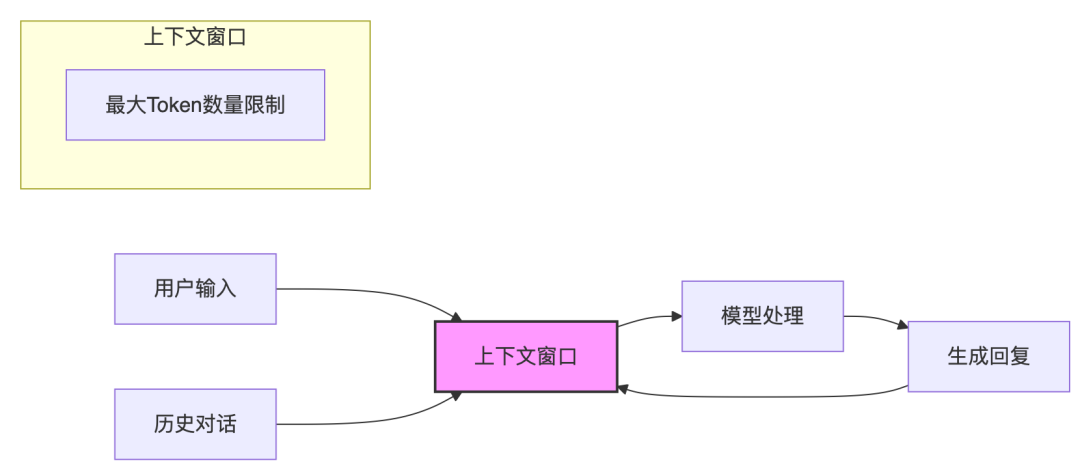

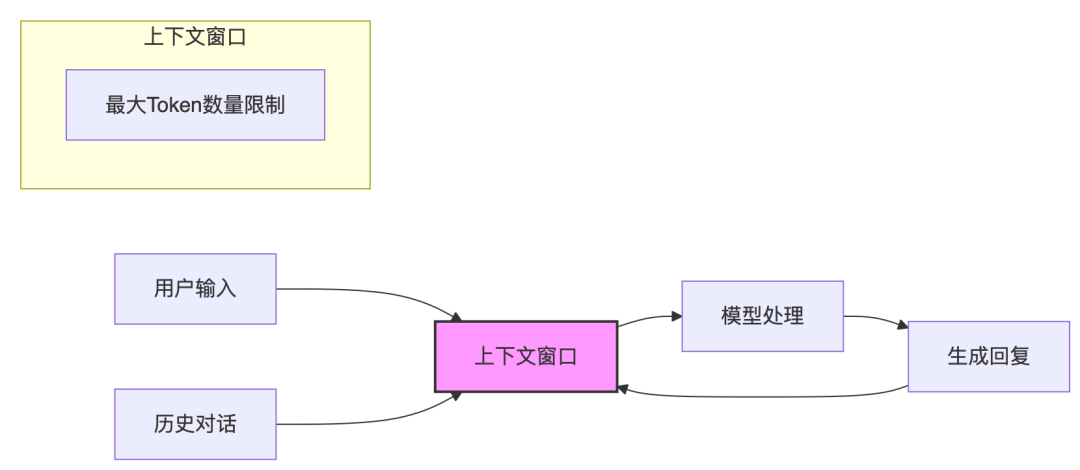

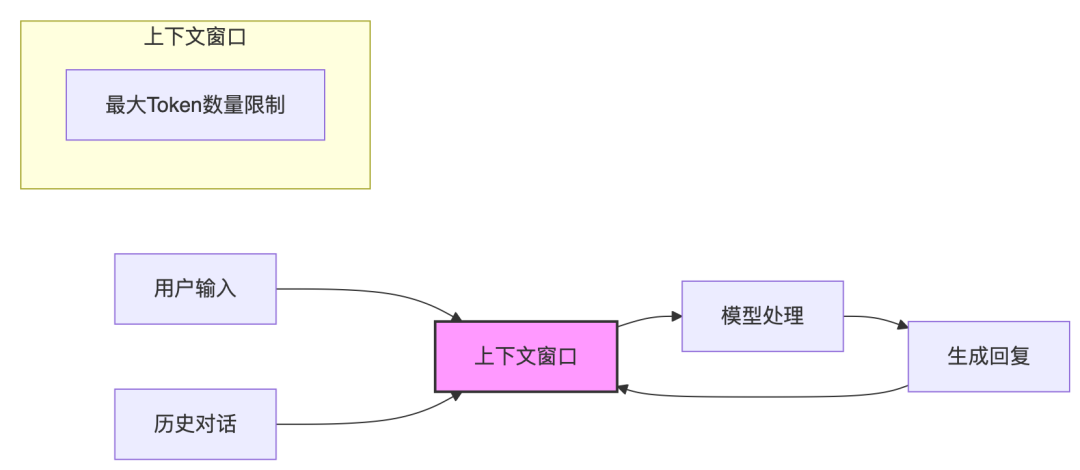

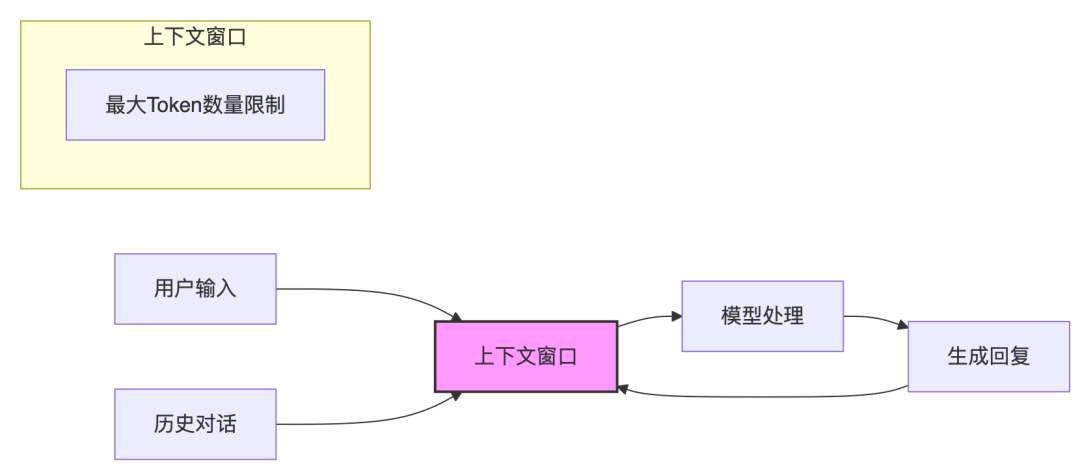

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

剖析 LLM Agent 定义及返回结构体定义

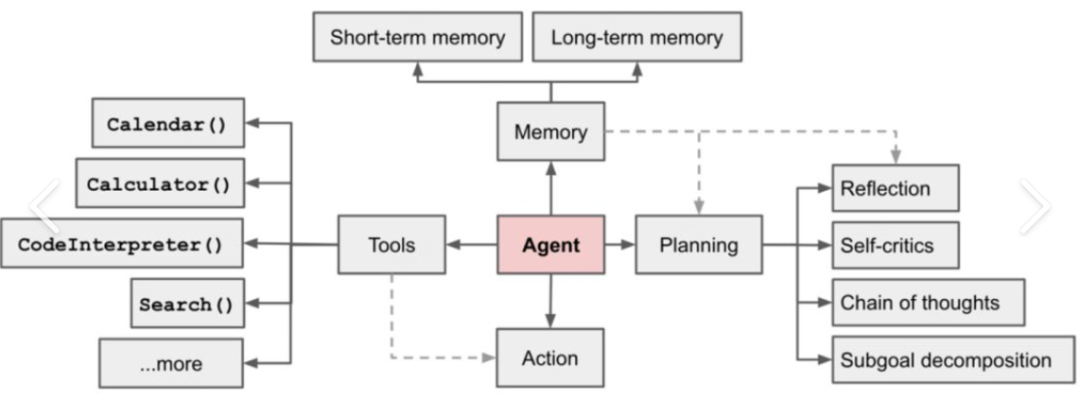

先从一段商用代码来开始本次的讨论: from typing import List, Callable, Union, Optionalfrom openai.types.chat import ChatCompletionMessagefrom openai.types.chat.chat_completion_message_tool_call import ( ChatCompleti…- 6

- 0

-

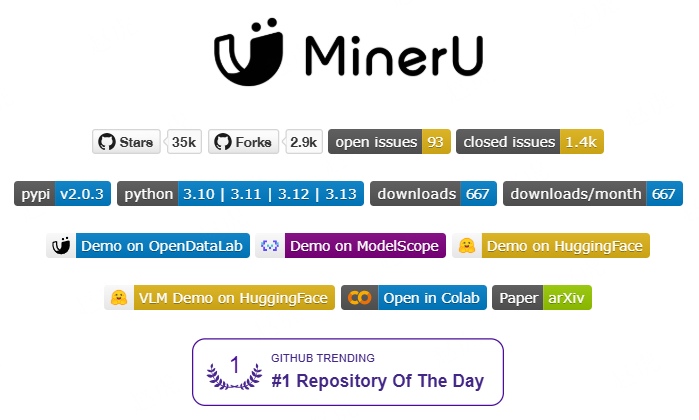

PDF文档解析–MinerU

MinerU是一款将PDF转化为机器可读格式的工具(如markdown、json),可以很方便地抽取为任意格式。A high-quality tool for convert PDF to Markdown and JSON.一站式开源高质量数据提取工具,将PDF转换成Markdown和JSON格式。主要功能 删除页眉、页脚、脚注、页码等元素,确保语义连贯 输出符合人类阅读顺序的文本,适用于单栏、…- 42

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

六个安全Agent设计模式:有效防止Prompt注入攻击

Prompt注入是当前大模型安全领域中最令人头痛的挑战之一,尤其对于那些被设计用来与外部环境交互并执行任务的智能体而言。攻击者通过在输入中嵌入恶意指令,试图操纵智能体的行为,可能导致数据泄露、未经授权的操作,甚至服务中断。 ChatGPT爆发“奶奶漏洞”,叫她“奶奶”可以实现你的愿望 最近,一篇由来自IBM、Invariant Labs、ETH Zurich、Google和Microsoft等机构…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

快速理解热门LLM大语言模型

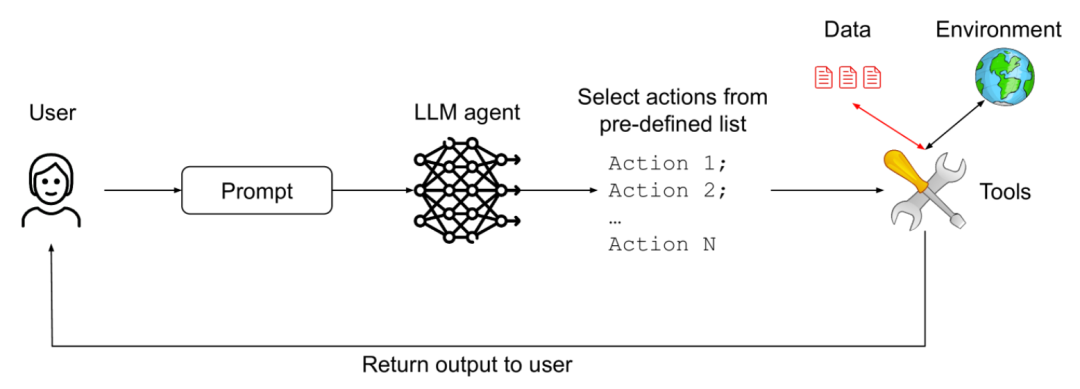

作者:masonpy 本文尽量用最简单的方式, 帮读者理解 LLM, Transformer, Prompt, Function calling, MCP, Agent, A2A 等这些基本概念. 表述时不追求绝对准确, 尽量通俗易懂. 部分内容有个人理解的成份, 内容难免疏漏, 欢迎指正. 注意:本文需要你有基本的代码阅读能力. 当然非开发阅读也不会很困难. 一. LLM (大语言模型) 本质…- 7

- 0

-

鹅厂实习生血泪贴:Agent/RAG黑科技,真相竟是这样!

作者:33号实验室/knnwang 被Agent/RAG吊打?你缺的不是智商,是这篇文章! 亲历鹅厂IEG/WXG项目实战,大三菜鸟用血泪debug记录, 撕开AI基石真面目 → 黑科技本质 = ______! 连夜肝出 「人话说明书+通关路线图」 , 即学即用!青铜连夜上分,帮助大家快速入门Agent/RAG (文章前半部分会介绍Agent,后半部分讨论RAG,最后还分享了优化RAG的一些tip…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

Figma 推出官方 MCP,真正做到了所见即所得

前段时间 MCP 爆火,其中一个最热门的服务是 非官方的 Figma MCP ——用户只需复制 Figma 链接到 Cursor,对话即可自动生成页面。 不过,这个服务对复杂页面的还原度不足。之前和该服务作者沟通过,它的处理方式是对 Figma 源文件内容进行压缩处理。一旦页面较复杂,就容易出现上下文丢失,无法高精度还原。 但是Figma官方的MCP会将变量、组件、布局等信息直接导入至 IDE,复…- 27

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 8

- 0

-

超越Gemini和Qwen!3B小模型横扫中英文文档识别,表格公式识别提升超15%

华中科技大学联合金山办公推出新一代文档解析模型MonkeyOCR!这款基于SRR(结构-识别-关系)三元组范式的创新模型,彻底颠覆了传统OCR技术的处理逻辑——既摆脱了模块化流水线的繁琐步骤,又规避了大模型全页解析的低效问题。在中文、英文及混合文档场景下,其3B轻量化模型展现出惊人实力:不仅以平均5.1%的性能优势超越主流方案MinerU,更在公式识别(+15%)和表格解析(+8.6%)等复杂任务…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

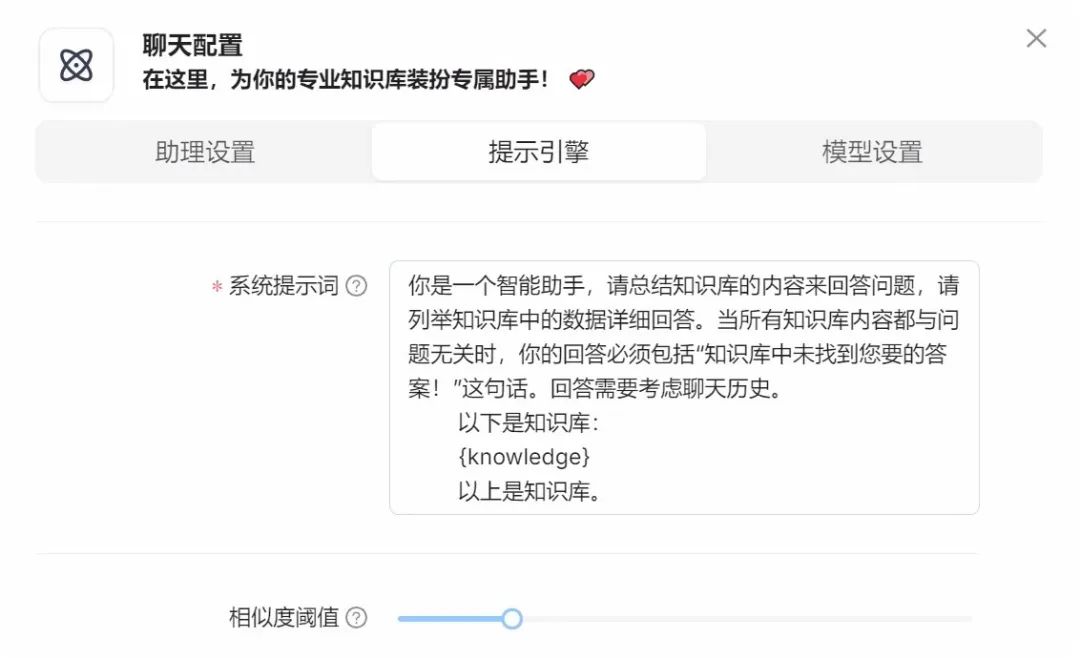

拒绝AI“一本正经地胡说八道”:我用三版Prompt驯服RAG模型的实战复盘

大家好呀,我是林生。 上周写了一篇《搭建AI知识库踩了37个坑,血泪总结这套避雷手册》里,我提了一嘴和老板汇报时,差点因为 AI 会臆构数据把项目搞黄了的小插曲。 老板当时就破防了:"什么?臆构数据?那开发人员用了虚假信息怎么办?这样大家还会信任这个系统吗?" 文章发出去后,好多朋友在后台留言说对这个“AI幻觉”的问题深有同感,想知道我是怎么具体解决的。 正好今天是周末,闲…- 5

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!