本文使用 ClinePRO 自动翻译。

原文作者:Ben Dickson

原文链接:

https://venturebeat.com/ai/why-enterprise-rag-systems-fail-google-study-introduces-sufficient-context-solution/

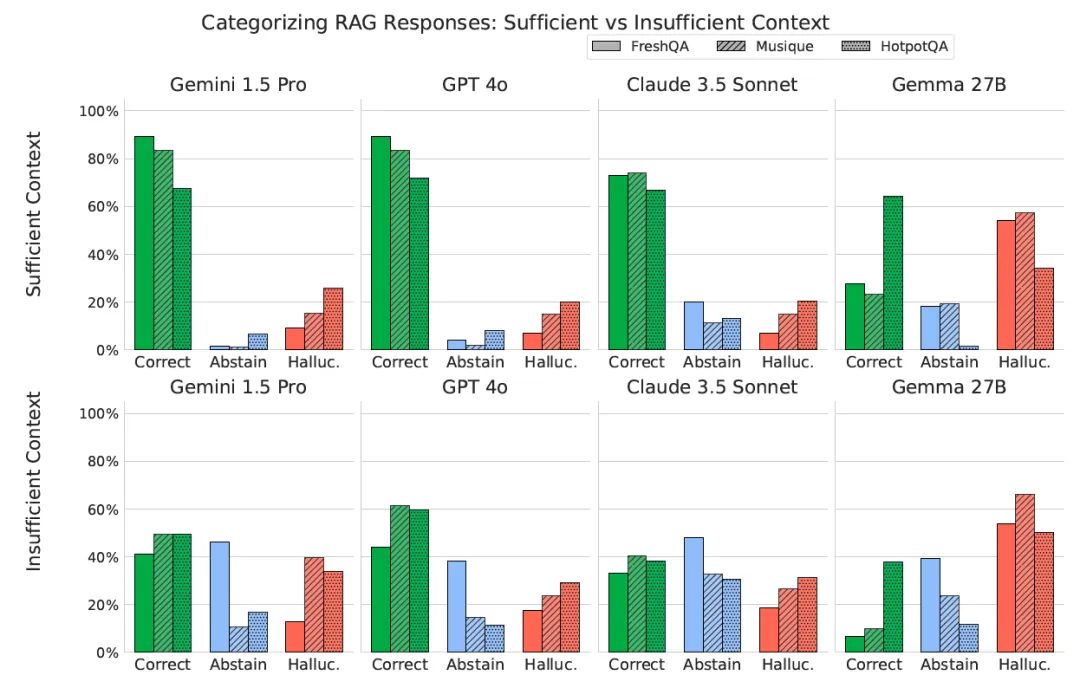

谷歌研究人员最新研究提出”充足上下文”框架,为理解和改进大语言模型(LLMs)中的检索增强生成(RAG)系统提供了新视角。该方案能精准判定模型是否具备足够信息来准确响应查询,对于构建企业级应用至关重要-这类场景中系统的可靠性与事实准确性具有最高优先级。

RAG系统的持续挑

-

可能在检索到证据的情况下仍自信地提供错误答案 -

容易被上下文中的无关信息干扰 -

或无法正确处理长文本片段中的答案提取

充足的上下文(Sufficient context)

-

充足上下文:上下文中包含提供明确答案所需的所有必要信息。 -

不充足上下文:上下文缺乏必要信息。这可能是因为查询需要上下文中未涵盖的专业知识,或信息不完整、结论不明确或存在矛盾。

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

RAG系统中大语言模型(LLM)行为的关键发现

-

填补信息空白 -

利用上下文线索(基于预训练知识)对检索内容进行合理推理 -

判断问题是否表述不明确或存在歧义,而非盲目复制上下文中的信息

降低RAG系统中的幻觉现象

将”充足上下文”应用于实际RAG系统

— END —

与数字智能体一同进化

这里有人人都能读懂的AI

微信号:szgs_AI