封面图 By 即梦

自大语言模型出现以来,所有的从业者本质上都在解决两个问题:

-

1. 提升模型的智能水平 -

2. 为模型提供上下文

场景创新、工程优化本质上都是在解决如何更优雅的给模型提供“上下文”的问题。

-

• Prompt Engineering 是上下文,“工程”的那部分就是背景信息表达的优化; -

• RAG 是上下文,把检索自你私有知识库的文本片段用来Augmentation问题; -

• DeepResearch 是上下文,把来自网络的各种文章加工到“研究需求”里; -

• MCP 是上下文,无需解释,其中的 C 就是; -

• Agent 是上下文,dify、Coze 也都是上下文……

提示词只是“需求激活器”,模型被激活后能不能把活干漂亮,取决于你提供了什么背景信息给它。

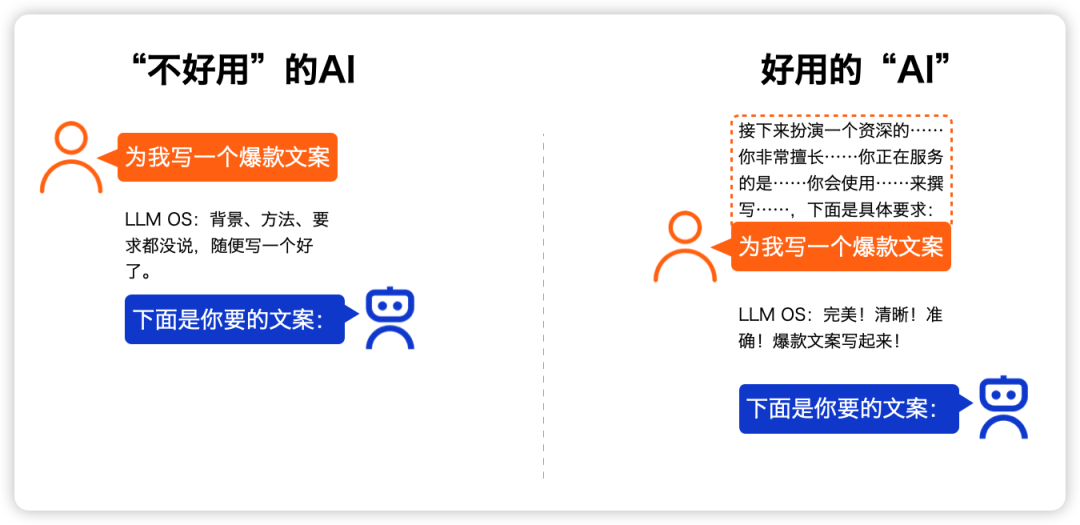

没能用好 AI 的那些“普通人”,一方面是想不到可以用 AI(场景问题),更重要的另一方面是给 AI 下达指令的时候信息给的不全(工程问题)。

类似“为我写一个爆款文案”这样的指令,就是典型的上下文“0添加”式表达。

本质上,所有 AI-Native 产品,都在做下面这件事:

拼来拼去,争的都是是场景创意和工程实现。

想要提升这两个方面的竞争力,做好下面两件事就够了:

-

1. 每天都刷一下 Product Hount TOP100 的打榜产品,当下 90% 以上都是 AI 在各种奇奇怪怪场景的应用; -

2. 每天都刷一下 GItHub Trending 的开源项目,当下 80% 以上都是各种 AI 产品开发的工程实现。

真正核心的,是你在某个场景下,如何拿到用户通过 AI 解决问题需求的「上下文」,并恰到好处的帮用户提供给 AI。

本周 Product Hount TOP1 的产品,是前网易副总裁创业开发的 AI Native 笔记工具 Remio

这笔记工具有一个很“刺激”的功能:安装了浏览器插件以后,你在浏览器上打开的所有网页,它都会默默帮你采集下来以后,同步到笔记 APP……

虽然很吓人,但是不失为一个非常好的用户上下文记录、同步和模型供给的方式。

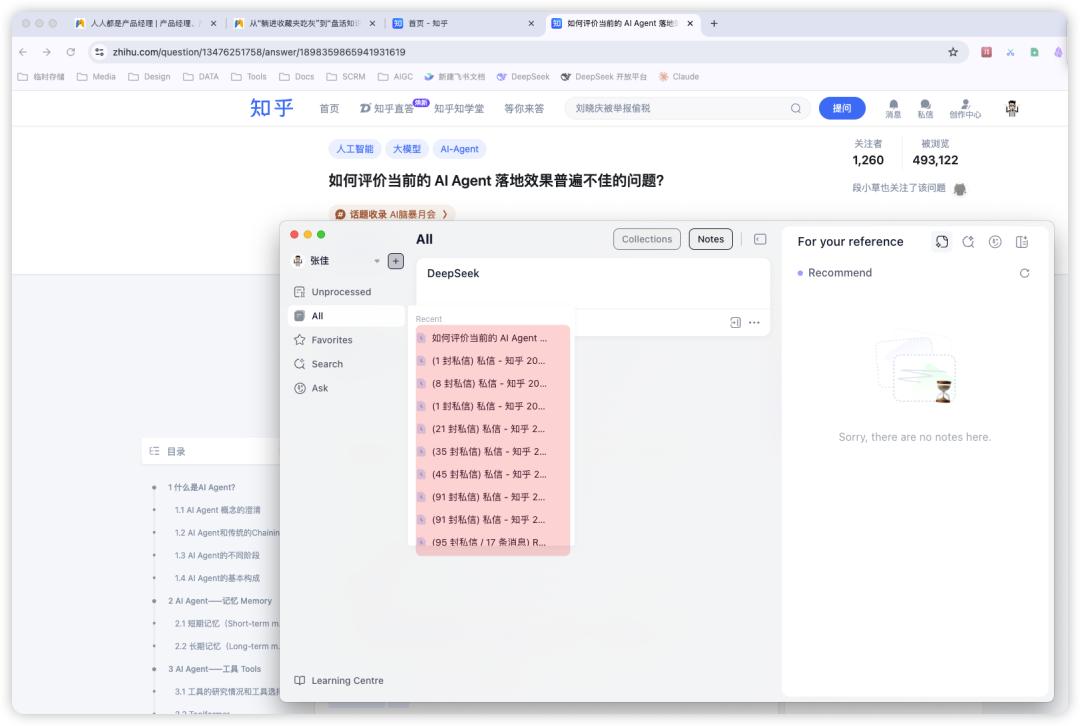

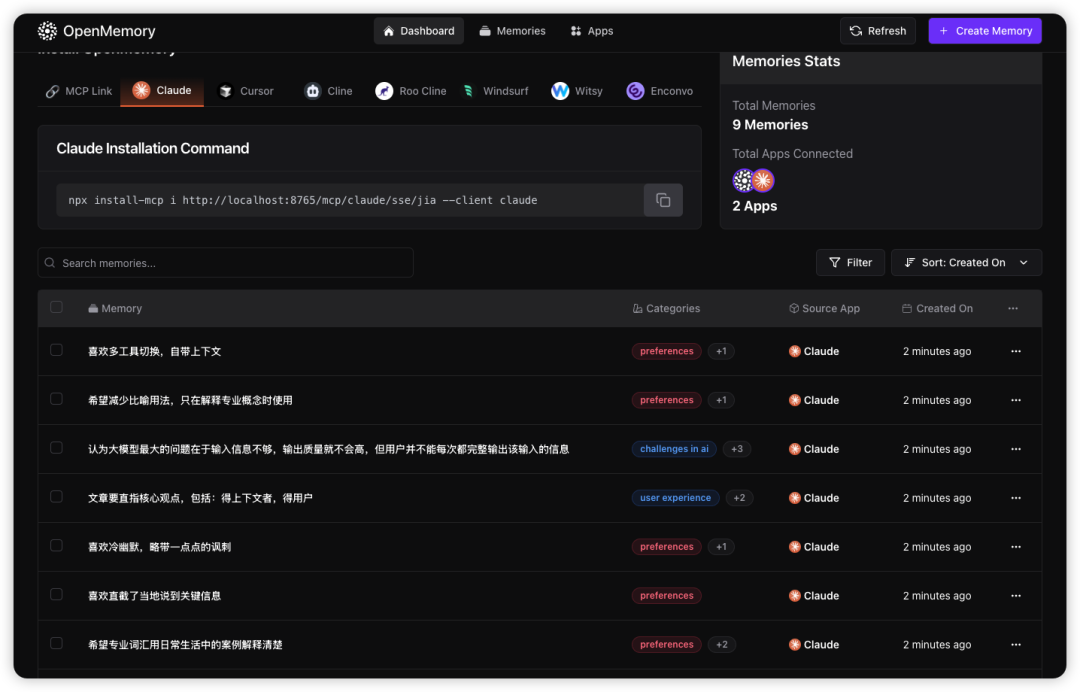

前几天,被 OpenAI 投资过的团队 mem0AI 开源了一个叫 OpenMemory 的 MCP 服务,它的核心价值是实现多 AI 应用之间的记忆共享(通过 MCP)。

你在 Claude 客户端上发过的消息,会被总结后存下来。等你再去 Cursor 里下达指令时,AI 可以从之前 Claude 里存的“记忆”里提取出相关的内容,放在上下文里。

这个场景我在很早以前的一次直播里有提过:谁能帮用户收集信息,在他们没想起来的时候自动补齐到对话里,谁就能够得到用户。

OpenMemory 并没有要用户的“上下文”,而是选择了存在用户本地。

但对更广泛的大众来说,方便比隐私更重要,毕竟不是所有人都会且愿意自己部署这么一套东西。

大模型的技术特征决定了「上下文」补齐是用好 AI 的必选项:更全面、完善的输入 = 更优质、更符合意图的输出。

只要大模型的这个技术特征不变,你接下来做的所有事情,归根到底都是更无感丝滑、稳定准确的帮用户补齐上下文。

认清楚了这个本质,很多创意的产品化,就变得很简单了。

预祝读完本文的各位,都能用 AI 赋能更多人。