我是波哥,专注于大模型/推荐系统,持续分享AI算法岗面试岗知识干货、实战项目、面试经验。

【大模型/搜广推一对一个性化项目辅导】、【大模型14周实战秋招冲刺营】详情了解可+v:Burger_AI

最近有朋友接了个活儿,帮一家挺传统的企业搞AI转型。老板雄心勃勃,点名第一个项目就要上RAG(检索增强生成),说是要盘活他们几十年积累下来的海量数据,打造个智能知识库、智能客服啥的。听着挺简单的是吧?但实际干起来,那真是痛并快乐着。

今天就借着这个项目,跟大家聊聊,真刀真枪做RAG,到底哪部分工作最难搞定,最让人头秃。别看网上教程一把一把的,什么LangChain几行代码跑通Demo,真到生产环境,坑比星星还多。

一、 万事开头难,数据这坨“史山”就够你喝一壶

你以为RAG最难的是调教大模型?Naive!我跟你说,最折腾人、最耗时、最容易让你项目卡壳的,绝对是数据! 尤其是给这种有年头的传统企业搞,那数据情况,简直是“惊喜”连连。

-

数据的“考古”与“迁徙” (Data Ingestion & Integration): -

痛点: 客户的数据那叫一个五花八门。有躺在老掉牙系统里的SQL数据库,有各个部门自己攒的Excel、Word、PPT,还有一堆扫描版的PDF合同、报告,甚至还有些打印出来又扫描回去的“古董”。想把这些散落在天涯海角的数据先“请”出来,再“搬”到一个统一的地方,那沟通成本、技术难度,简直了! -

吐槽: 为了拿到某个部门的数据接口,我硬是陪着笑脸开了N次协调会,填了N张申请表。有些系统老到连文档都没有,只能靠猜。这哪是做AI,简直是数据考古学家+外交官! -

给数据“洗澡”、“美容” (Data Cleaning & Preprocessing): -

痛点: “垃圾进,垃圾出”这话在RAG里是真理。好不容易把数据搞到手,打开一看,我的天!错别字、乱码、格式混乱、信息冗余、过时信息……要是不下狠心清洗,后面模型喂进去的都是“毒药”。 -

吐槽: 尤其是那些扫描版的PDF,OCR识别出来那叫一个“抽象”。表格错位、公式乱码是家常便饭。你知道OCR调参和后处理有多麻烦吗?为了提高那么一点点准确率,头发都掉了好几把。这部分工作,你要是觉得能一股脑灌进去就完事,那项目基本就凉了一半。 -

从“大杂烩”里提炼“真金白银” (Knowledge Text Extraction & Structuring): -

痛点: 清洗完了还不行,得从这些文本里把有用的知识点给抽出来。比如,一份几百页的报告,哪些是核心观点?哪些是关键数据?如果能建成知识图谱当然牛逼,但那工程量…… -

吐槽: 有些知识藏得特别深,得靠人工去标,或者用复杂的NLP模型去抽。这部分直接关系到后面检索能不能找到真正相关的“料”。

二、 检索:大海捞针,怎么捞得又快又准?

数据好不容易伺候明白了,接下来就是怎么让模型“找得到”、“找得对”。

-

“分蛋糕”的艺术:文本分块 (Chunking Strategy): -

痛点: 长文档得切成小块才能喂给模型。切多大?按啥切?固定长度切得简单,但容易把一句话切两半;按语义切(比如按段落)效果好,但实现麻烦。 -

吐槽: 这块儿真是反复试验。切小了,上下文不够,模型理解不了;切大了,噪音太多,还可能超了模型的“饭量”(上下文窗口)。没有万能药,只能根据客户的数据特点慢慢磨。 -

给知识“贴标签”:Embedding模型那点事儿 (Embedding Model Selection): -

痛点: 把文本块变成向量,才能做语义相似度搜索。用通用的Embedding模型还是针对客户的行业数据微调一个?这直接影响检索的准头。 -

吐槽: 通用模型在客户的专业术语上表现可能一般。想微调?高质量的标注数据从哪儿来?又是一个头疼的问题。 -

“广撒网”还要“精准捕捞” (Recall &Precision): -

痛点: 不仅要把相关的都找出来(召回率),还要保证找出来的确实有用(精确率)。光靠向量检索有时候不够使,可能还得加上关键词搜索啥的。 -

吐槽: 客户经常问:“我搜这个词,为啥相关的那个文档没出来?”或者“为啥搜出来一堆不相干的?” 这时候就得去优化检索策略,可能搞个混合搜索,再加个重排序,复杂度和计算量又上去了。

三、 生成:让AI“说人话”,还得说得对、说得好

检索到东西了,最后还得靠大模型把答案组织出来。

-

模型的“饭量”问题:上下文长度 (LLMContext Length): -

痛点: 模型能接收的上下文是有限的。要是检索出来的好东西太多,塞不进去咋办? -

吐槽: 就得想办法筛选最重要的信息喂给模型。虽然现在有长上下文模型了,但那玩意儿推理起来又贵又慢,老板的预算可不一定答应。 -

别让AI“一本正经地胡说八道” (OutputEffect Optimization & Hallucination Mitigation): -

痛点: 就算有RAG,大模型有时候还是会“自由发挥”,说点不靠谱的。怎么让它老老实实根据给的材料说话,这是个大挑战。 -

吐槽: Prompt调优那是基本功,有时候还得琢磨怎么验证它说的是不是真的,能不能把出处标出来。客户最怕AI瞎说,砸了他们招牌。 -

让AI按“规矩”办事:输出格式固定 (OutputFormat Fixing): -

痛点直击: 很多时候希望AI按固定格式输出,比如生成个JSON,或者填个表。但这事儿,AI不一定那么听话。 -

我的吐槽: 你让它输出个列表,它可能给你一段话。输出格式的控制,也是个精细活儿。

四、 面试官视角:别只停留在“Hello RAG”

顺便提一句,最近也帮着面试了几个人,发现不少简历上写着“熟悉RAG”,但一细问就露怯了。

-

问他文本分块策略,是固定长度、语义分块还是自适应?优缺点是啥?很多人就支支吾吾。 -

问他Embedding模型怎么选的,维度大小怎么定的?说不出个所以然。 -

问他用没用重排序,怎么结合BM25和向量检索?一脸迷茫。 -

问他Prompt是不是自己设计的,怎么评估命中率和幻觉问题?基本就卡壳了。

说白了,很多人可能就是用LangChain之类的框架跑通了个Demo,把文本切一切,扔进向量库就完事了。但RAG前半段的检索,本质上跟推荐系统那套“召回-排序-精排”的逻辑很像,里面的门道多着呢。后半段的生成控制,更是个细致活。如果没点算法背景,或者没正经做过搜索、推荐优化,这些深层次的问题确实很难答上来。

五、 所以,RAG最难搞定的是啥?

唠叨了这么多,要问我这个项目里RAG最难搞定的是哪部分?我还是要把票投给“数据处理”这一坨! 它是整个系统的地基,地基不稳,后面再花哨的技术都是白搭。这部分工作量大、沟通成本高、技术细节多,而且往往是最不被“看见”但又最要命的。

其次就是“检索模块的精细打磨”,怎么在海量、复杂、甚至低质量的数据里,快速、准确地找到最有用的那一小撮信息喂给大模型,太考验功力了。

当然,其他环节也各有各的难处,比如怎么让模型输出更可控、怎么建立一套靠谱的评估体系等等。做RAG,真不是搭积木那么简单,是个系统工程,需要耐心和智慧去一点点啃。

行了,今天就先吐槽到这儿。希望我这些踩坑经验,能给同样在RAG这条路上摸索的兄弟们一点启发。这活儿虽然难,但做出来能真正帮到企业,那成就感也是满满的!继续搬砖去了!

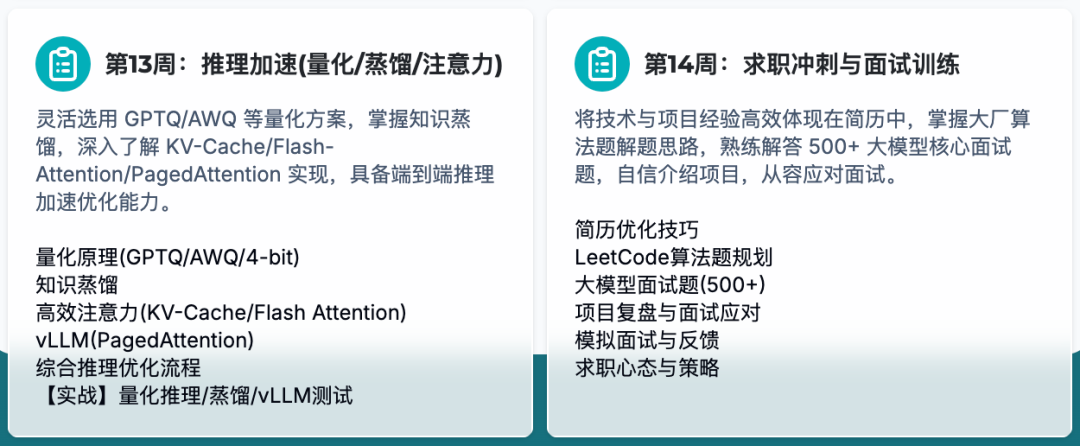

最后,和大家分享一下我们最新推出的【大模型14周实战秋招冲刺营】,报名可+v:Burger_AI

1.1对1辅导2个月,蚂蚁LLM+推荐算法offer拿下

2.CV转行推荐算法,3个月拿到3家大厂offer

3.零基础入行大模型,2个月拿到字节暑期实习

课程链接: