一、Dify 调用大模型的两种核心方式

大语言模型按部署方式分为云端API模型和本地私有化模型。Dify对两者均提供可视化配置支持,无需代码即可完成接入。

1. 云端模型(API调用)

特点:依赖第三方服务商算力,数据需传输至服务商服务器,适合快速验证和轻量级应用。

支持服务商:DeepSeek、智谱 AI、文心一言、通义千问等。

2. 本地模型(私有化部署)

特点:数据完全本地处理,需自行部署模型服务(如 Ollama),适合高隐私场景。

常用工具:Ollama、LocalAI,支持 Llama3、DeepSeek-R1 等开源模型。

3、两种模型对比

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

4、两种模型引擎服务对比

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

二、云端模型接入步骤(以 DeepSeek 为例)

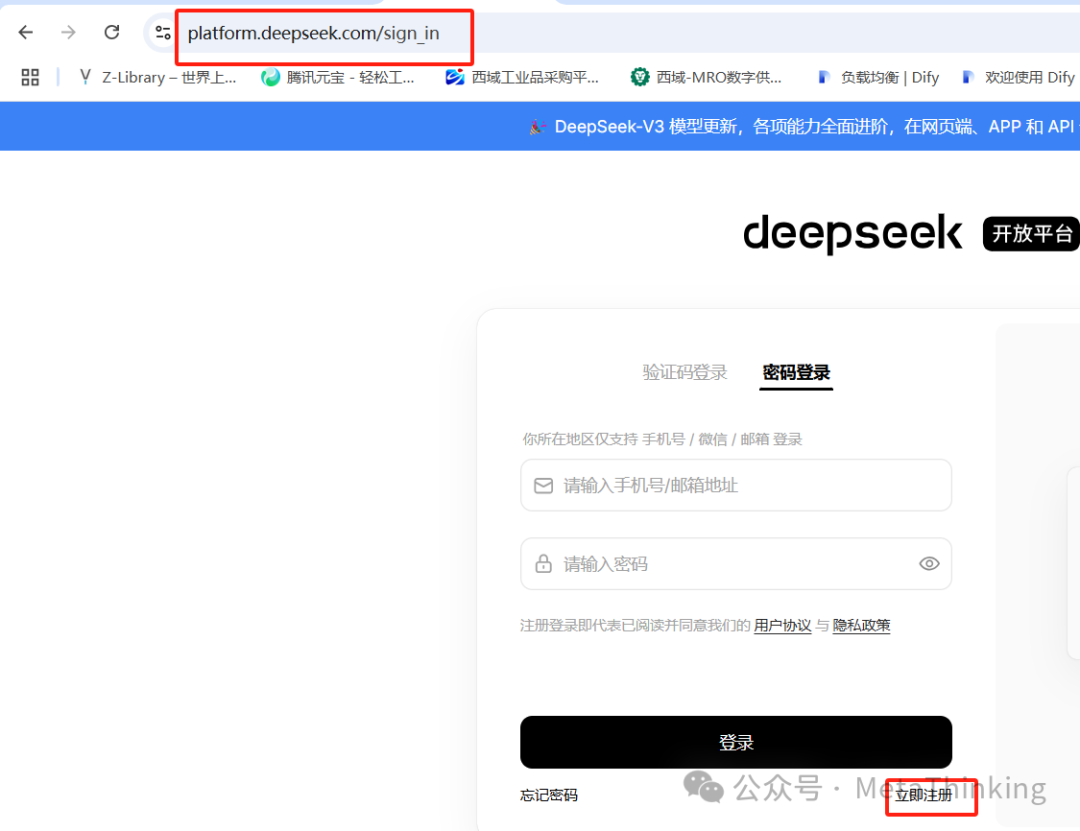

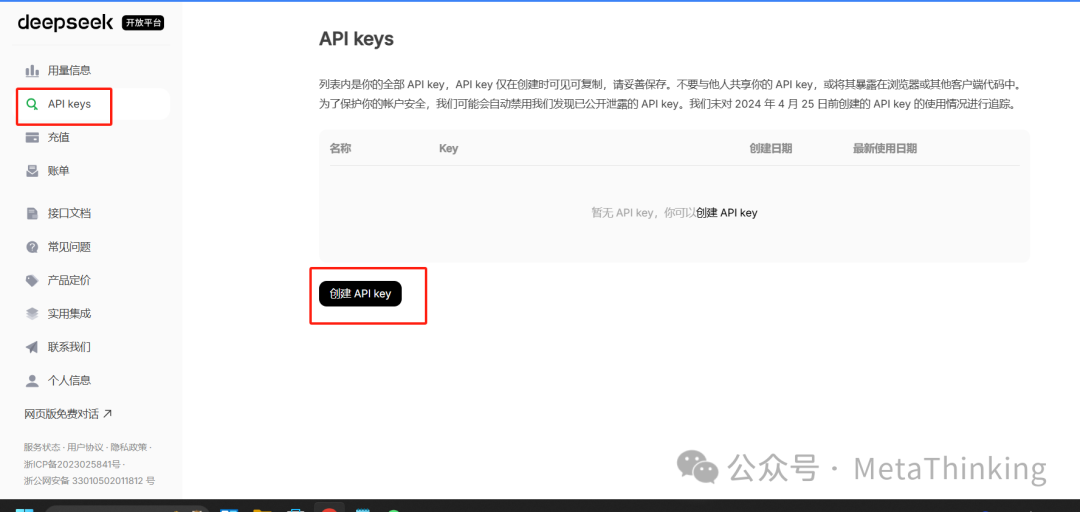

1. 注册并获取 API 密钥

访问DeepSeek官网(https://platform.deepseek.com/) → 完成注册 → 进入控制台生成API Key。

2. 在Dify中配置模型(基于OpenAI-API-compatible服务)

(1)部署Dify请参考《开启智能体和知识库探索之旅:Dify私有化部署》,没有开发经验的朋友按照步骤也可轻松完成部署。

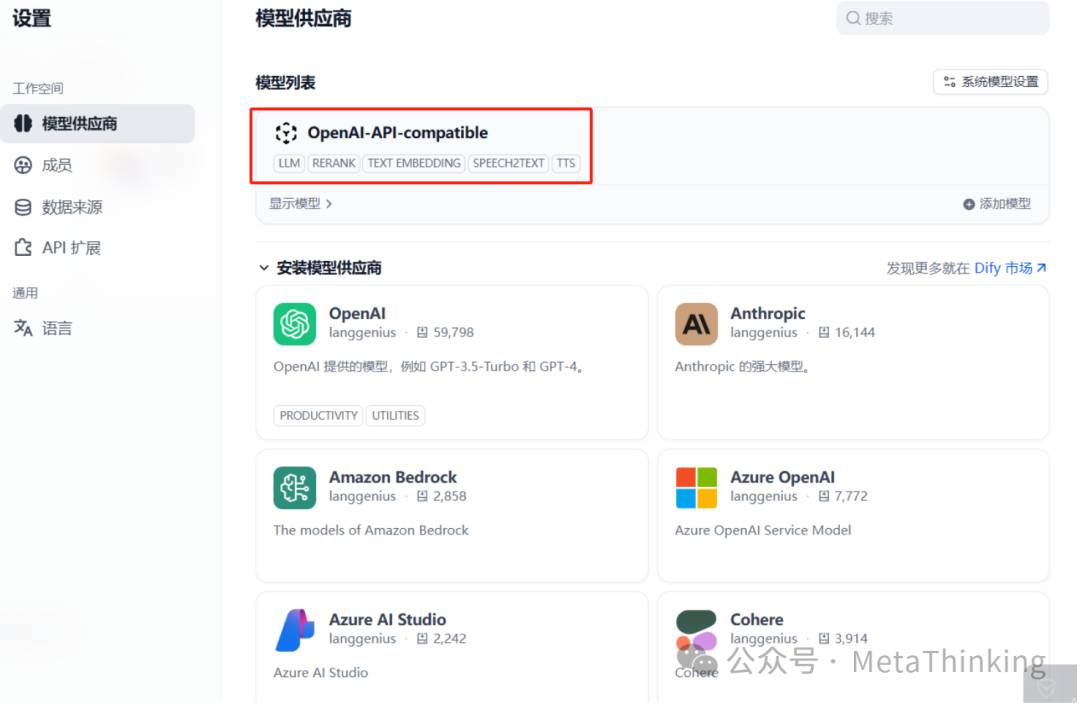

(2)安装OpenAI-API-compatible服务

-

登录Dify控制台 → 设置 → 模型供应商 → 搜索框中输入“OpenAI-API-compatible”,找到后单击“安装”

-

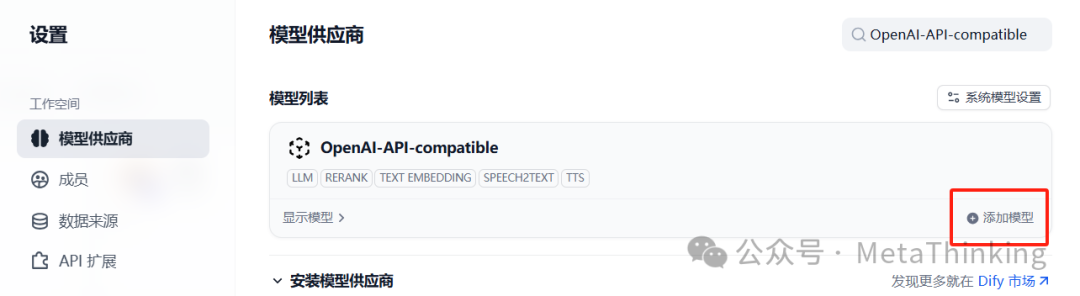

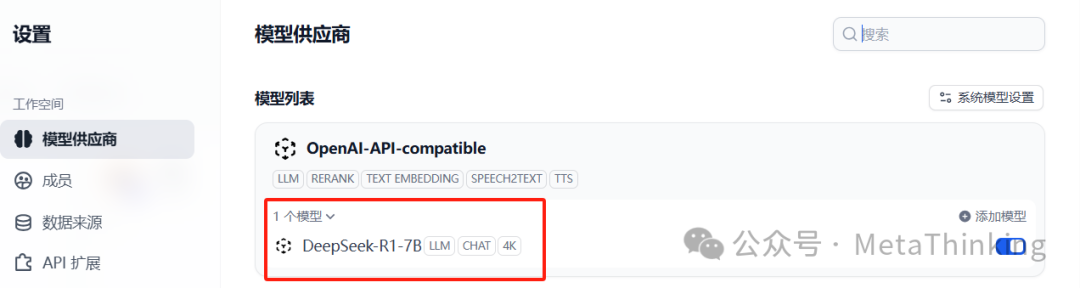

安装完后会出现在模型列表中,如下图所示:

(3)在OpenAI-API-compatible插件服务中添加模型

-

登录Dify控制台 → 设置 → 模型供应商 → 选择OpenAI-API-compatible → 单击添加模型按钮。

-

打开添加模型界面后填写参数

模型名称:自定义(如 DeepSeek-R1-7B)

API Key:复制粘贴上面创建的密钥

API Endpoint:https://openapi.coreshub.cn/v1。

-

点保存后显示出1个模型

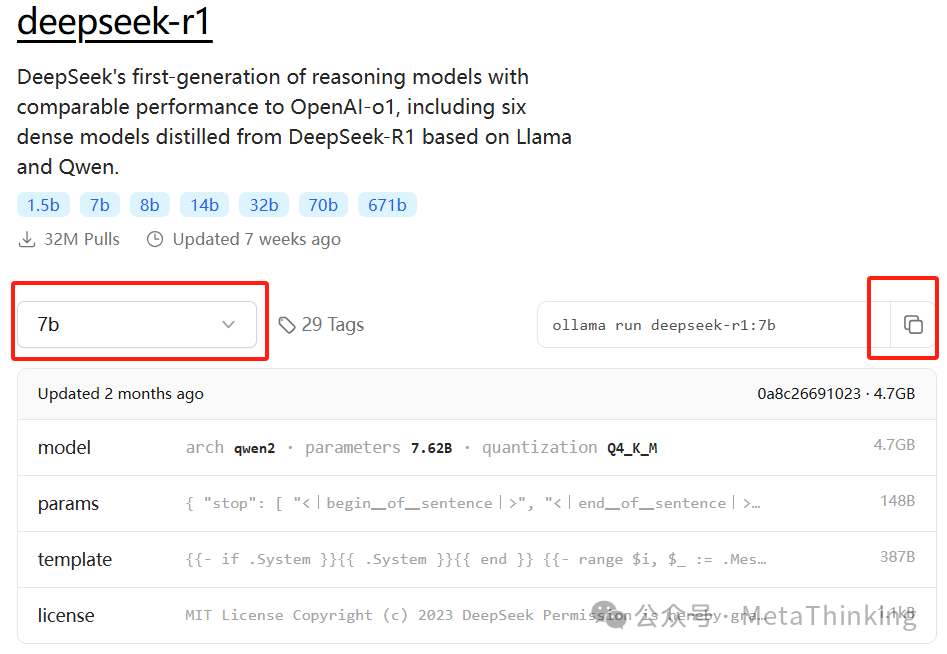

三、本地模型接入方法(基于Ollama)

Ollama虽是一个本地部署的大模型管理平台,支持在本地运行各种开源模型,但是也兼容OpenAI的API接口。

1、部署Dify请参考《开启智能体和知识库探索之旅:Dify私有化部署》,没有开发经验的朋友按照步骤也可轻松完成部署。

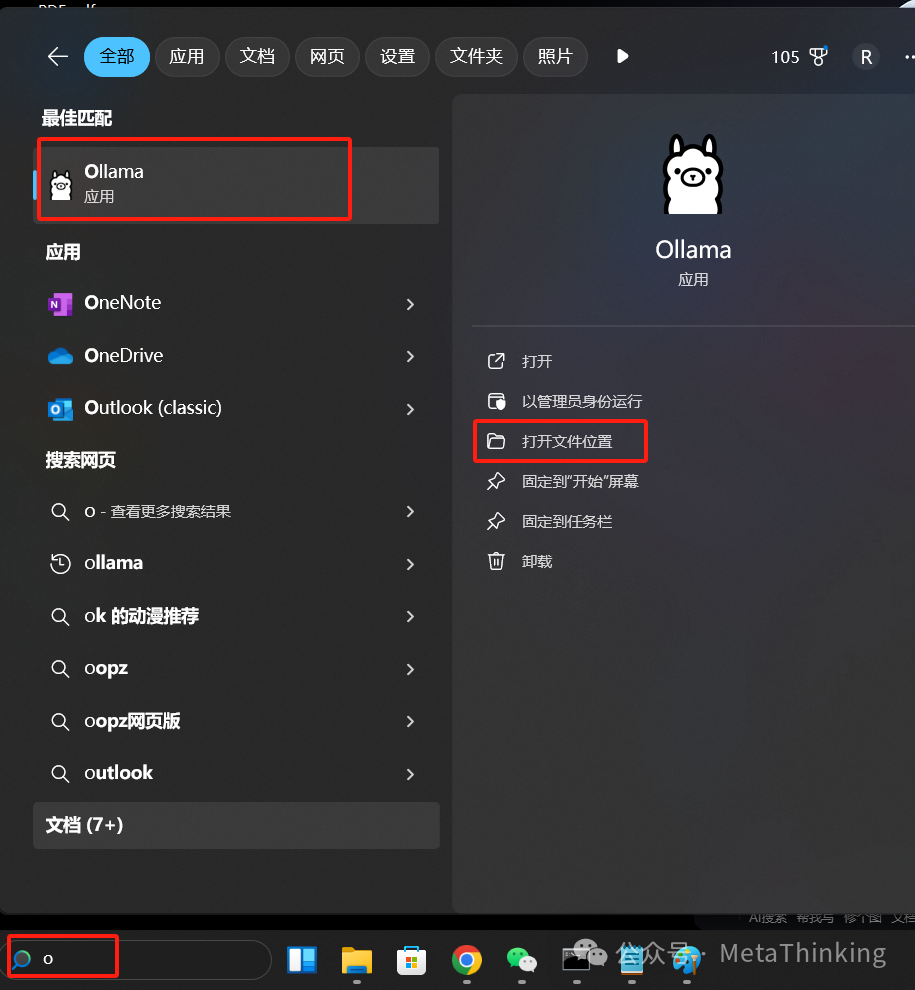

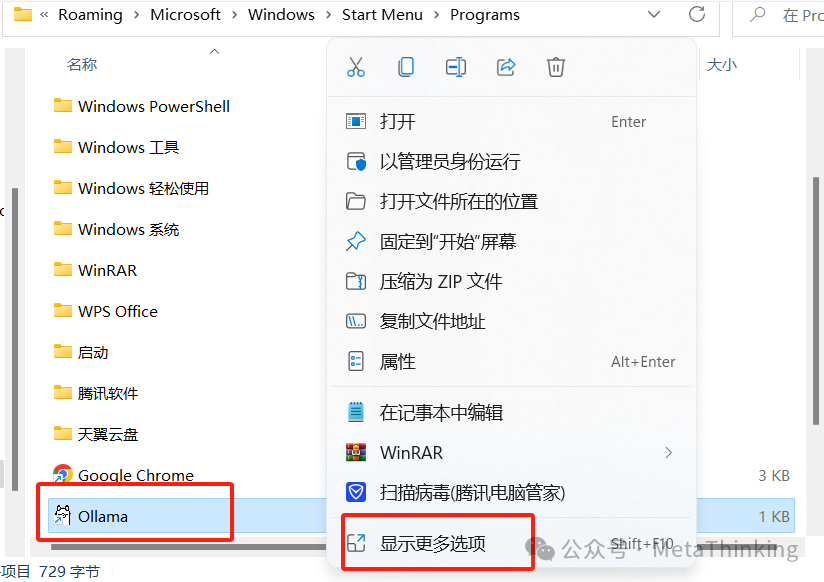

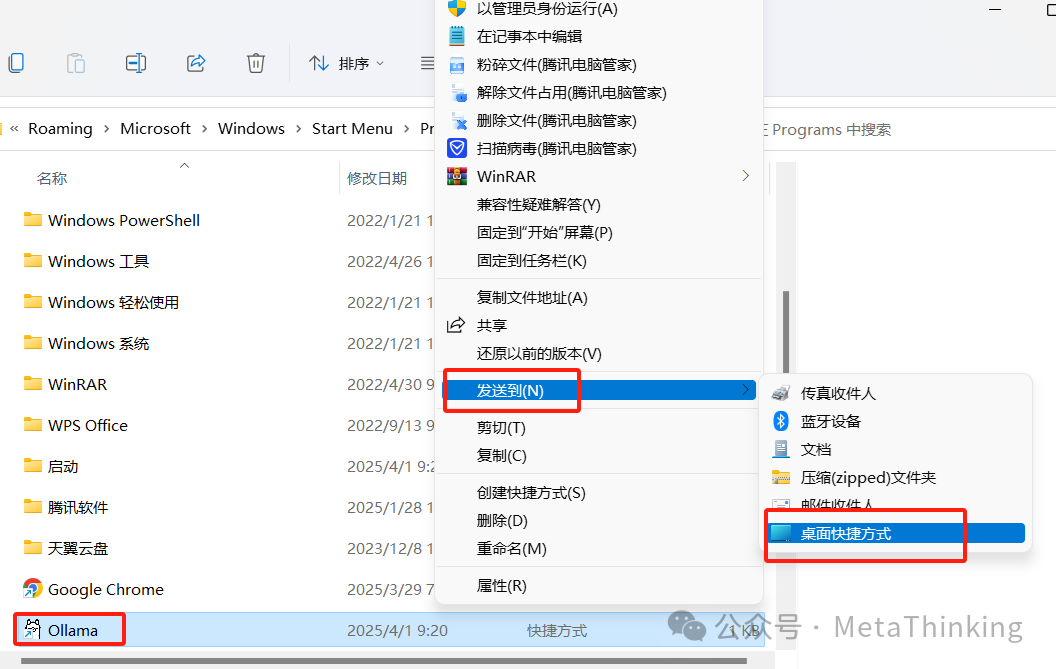

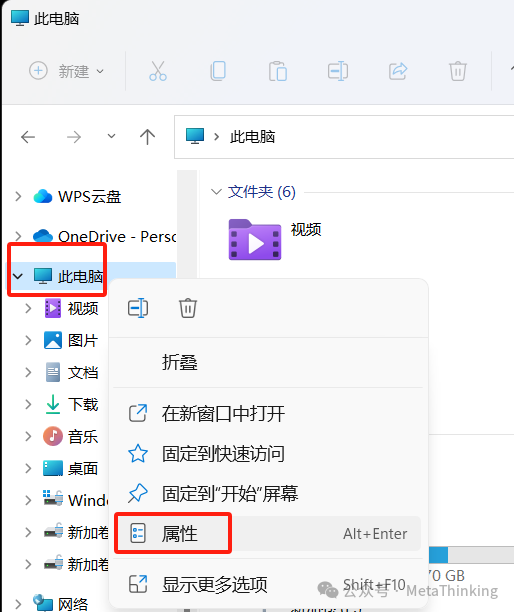

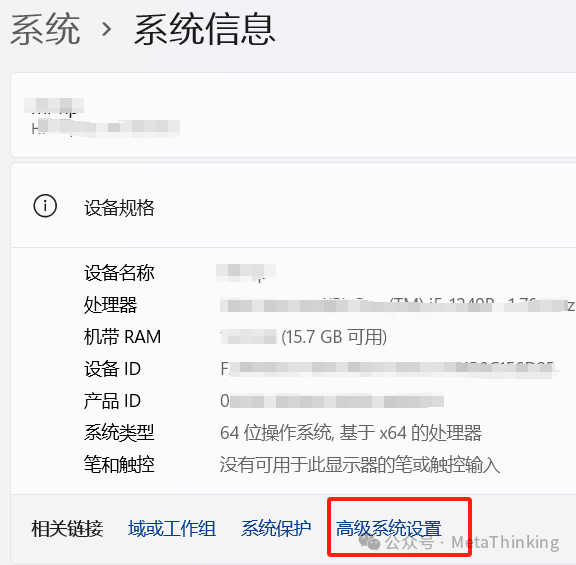

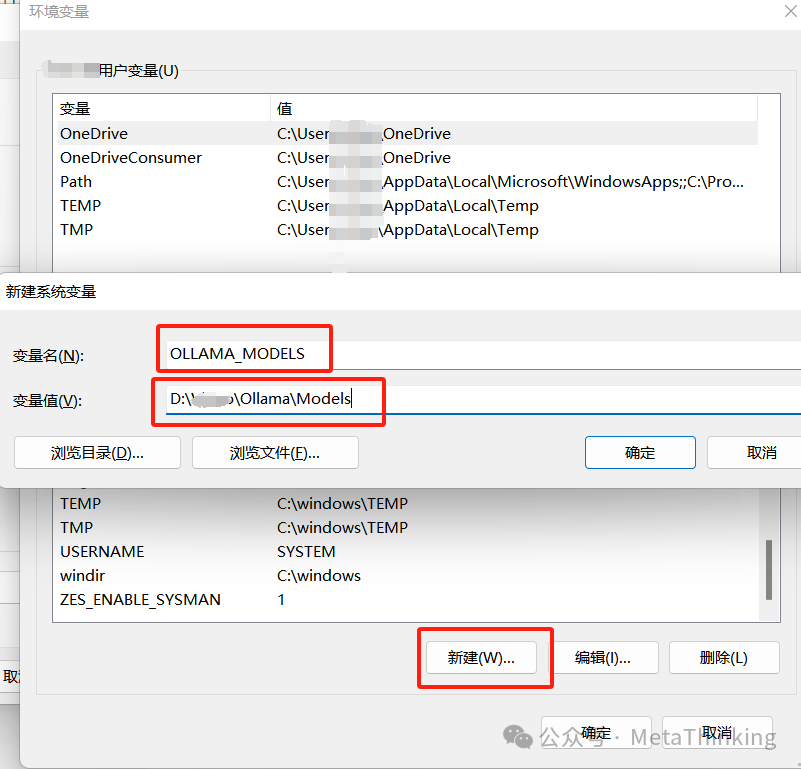

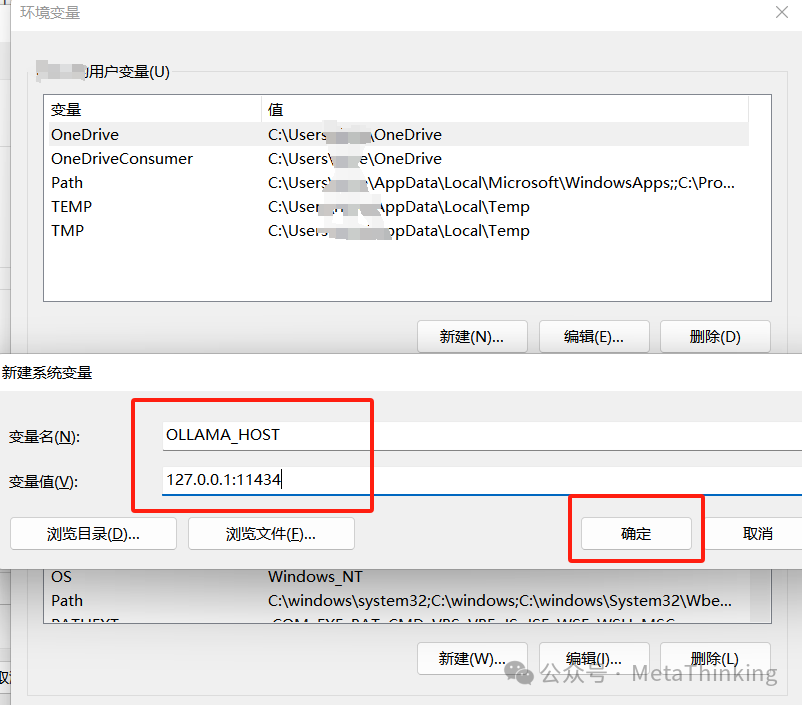

2、Windows系统中安装Ollama

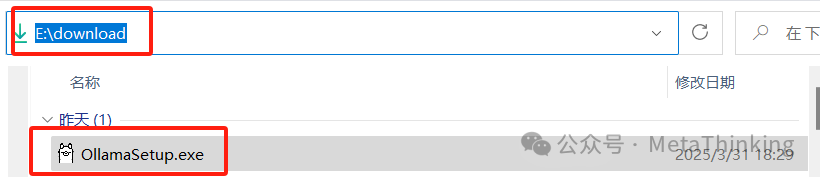

(1)打开Ollama官网(https://ollama.com/download)下载安装文件,我的电脑是windows11,我选择的是windows安装包,如下图所示,注意我的网络可能有点慢,我下载了2个小时,占用1G左右的硬盘空间。

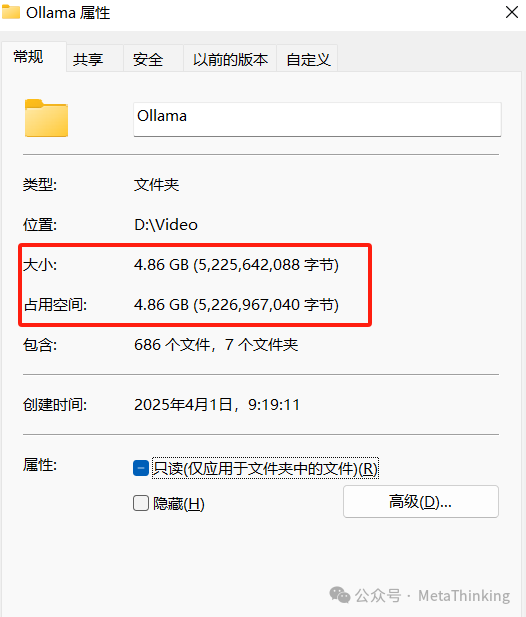

(2)这里不推荐鼠标双击安装包安装,因为这种安装方式默认安装到C盘且不能自定义安装目录,安装完后大约占用5G硬盘空间如下图所示;这里个人推荐命令安装方式,我下面会详细介绍这种方式的安装步骤,没有开发经验的也不用担心,按照下面步骤操作轻松完成安装。

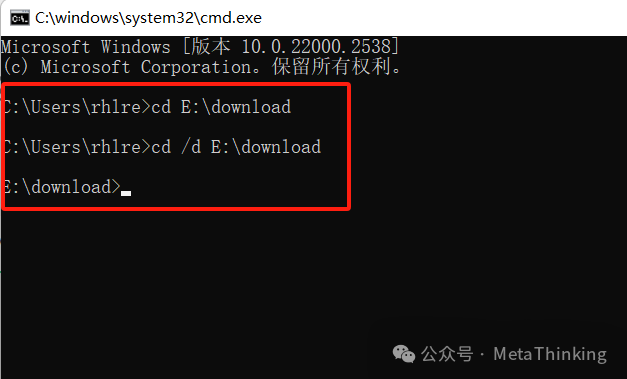

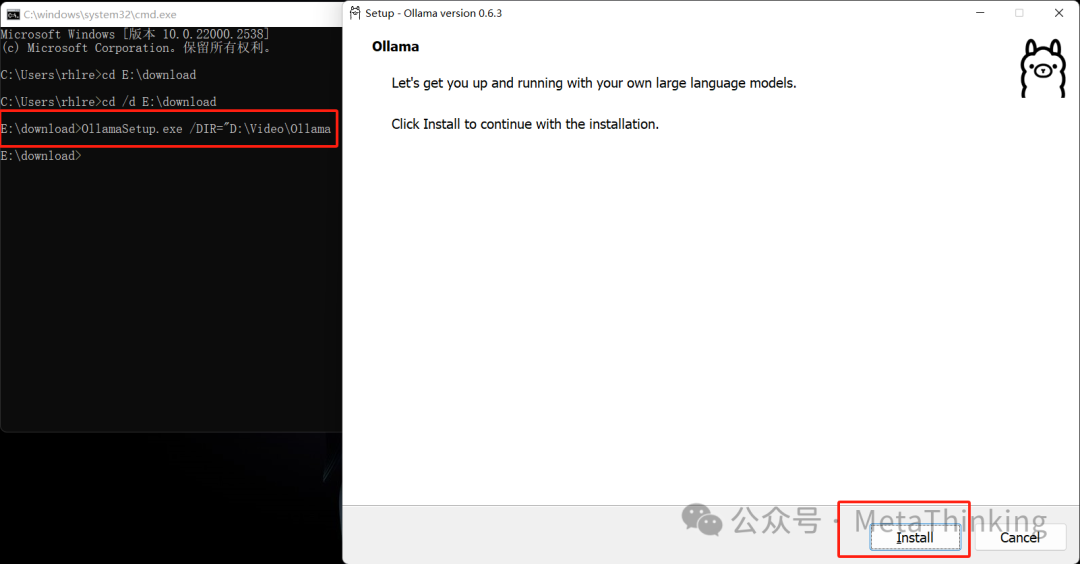

(3)按Win+R打开运行窗口,输入“cmd”后回车启动cmd,并定位到OllamaSetup.exe所下载的目录,如下图所示:

注意:“cd E:download”跳转不过去,必须输入“cd /d E:download”才能跳转到下载目录

(4)执行”OllamaSetup.exe /DIR=”D:VideoOllama”命令,DIR的值为”D:VideoOllama”,该值为Ollama的安装目录

-

重新打开一个CMD输入“ollama -v”回车,如果显示如下图所示内容,表示Ollama安装成功了。

-

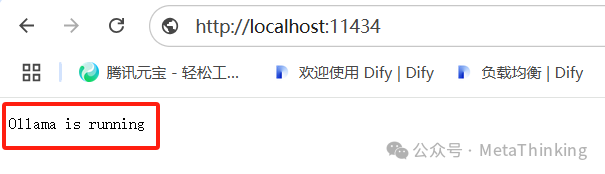

打开浏览器地址栏输入“http://localhost:11434”后回车,如果显示如下图所示内容,表示Ollama安装成功了。

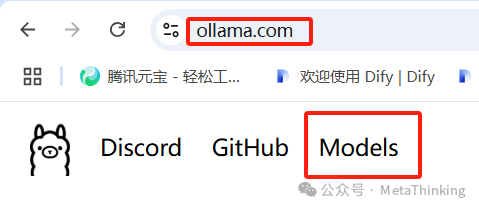

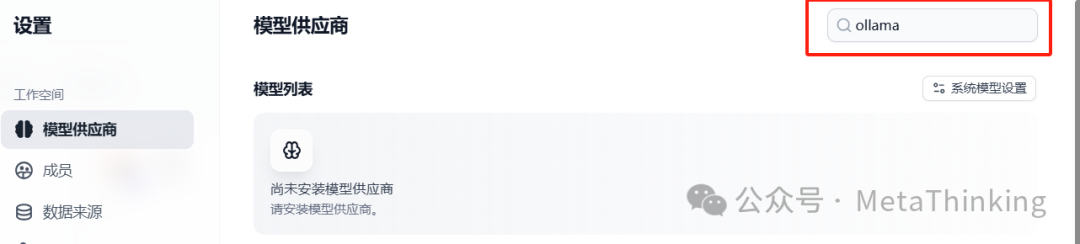

(1)Dify中安装Ollama服务插件

-

登录Dify控制台 → 设置 → 模型供应商 → 搜索框中输入“Ollama”,找到后单击“安装”

-

安装完后会出现在模型列表中,如下图所示:

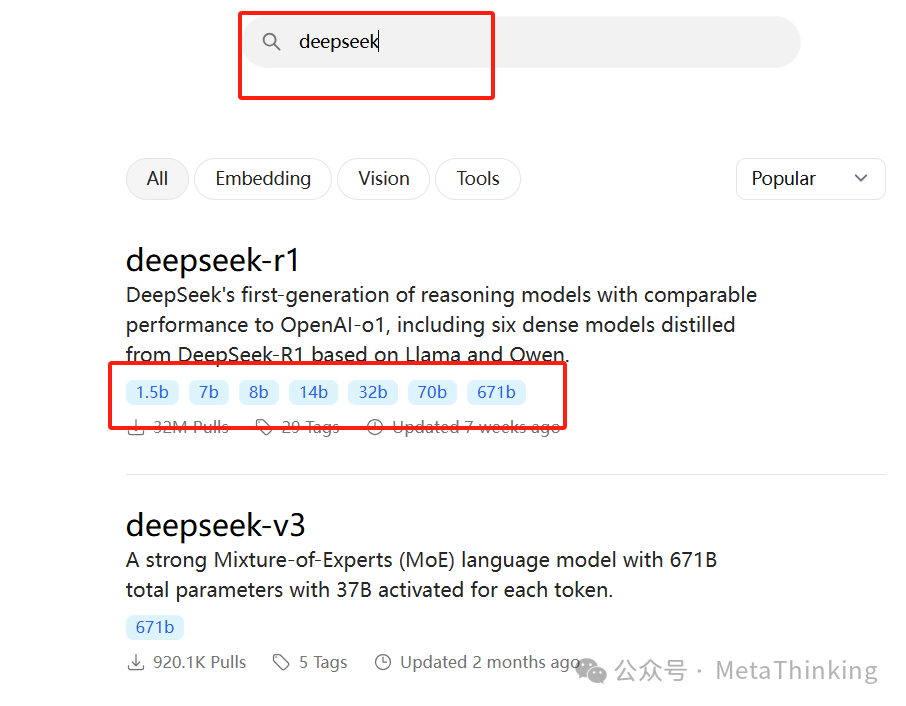

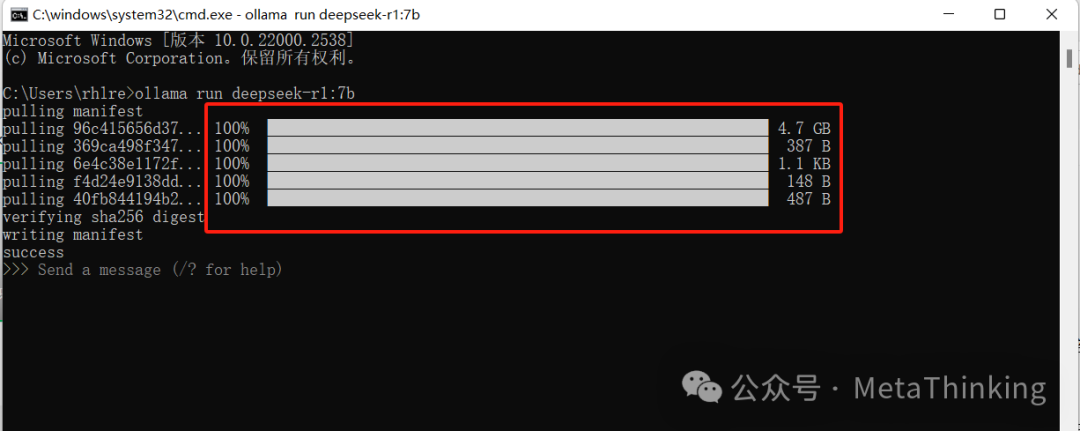

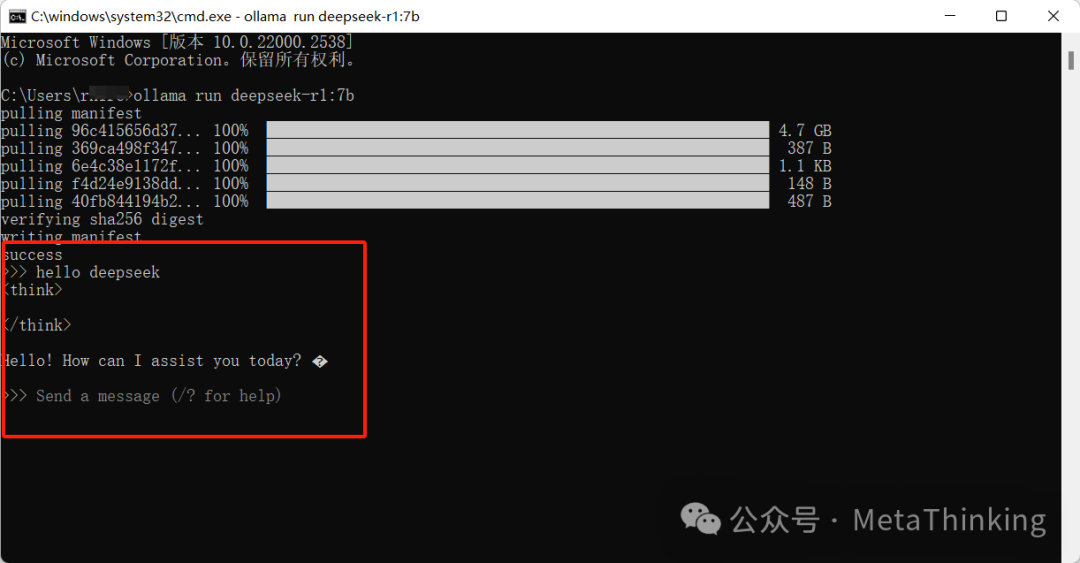

(2)在Ollama插件服务中添加模型

-

登录Dify控制台 → 设置 → 模型供应商 → 选择Ollama → 单击添加模型按钮。

-

打开添加模型界面后填写参数

模型名称:自定义(如 DeepSeek-R1-Distill-Qwen-7B)

-

基础 URL:

本地部署(http://localhost:11434)/(http://127.0.0.1:11434)

Docker部署(http://host.docker.internal:11434)

云端部署(http://203.0.113.10:11434)。

-

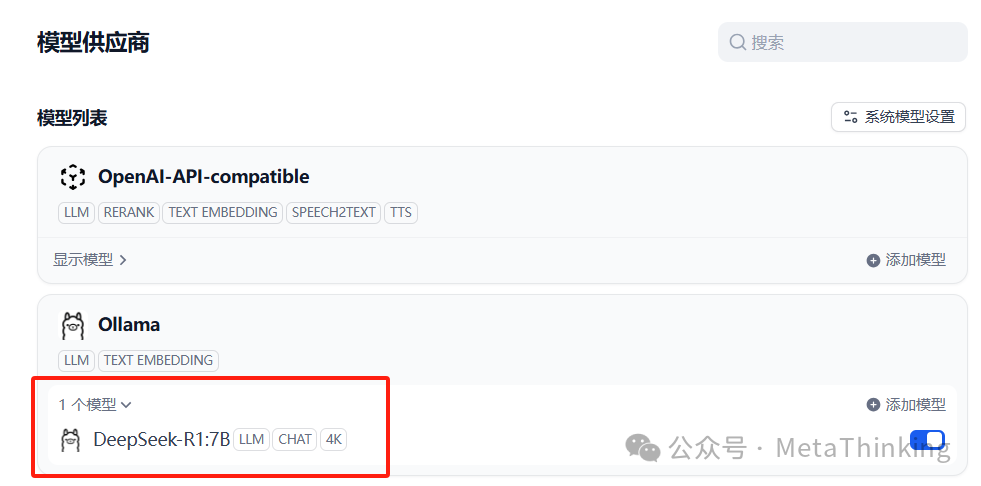

点保存后显示出1个模型

-

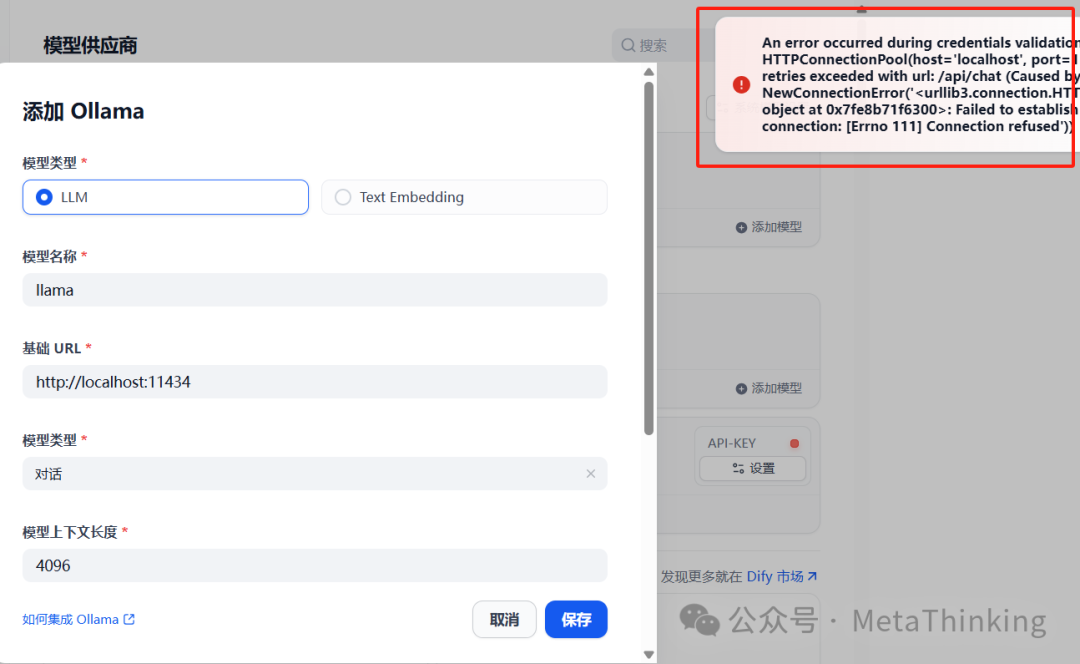

点保存后,下图是大部分人会遇到的问题,原因是因为:容器与主机网络隔离问题,即使在本地也无法访问,请根据以下操作步骤配置网络。

-

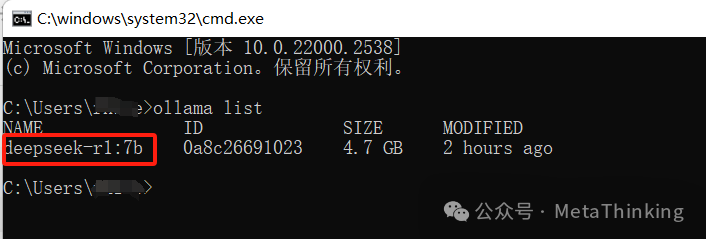

Ollama模型命名规范,名称需严格遵循 <model-name>:<tag> 格式(如 deepseek-r1:14b),Dify配置需完全匹配,如果确实不会写可以按Win+R打开运行窗口,输入“cmd”后回车启动cmd,执行“ollama list”查看Ollama已安装的模型的完整名称。

-

网络配置,Docker默认有自己的网络命名空间,

127.0.0.1或localhost指的是容器内部,而不是宿主机,Ollama默认监听127.0.0.1,使用“http://host.docker.internal:11434”实现容器访问宿主机服务。 -

添加模型填写参数如下图所示:

-

如下图所示,表示ollama配置ds大模型成功

总结:通过上述方法,即使无开发经验也能轻松在Dify中灵活调用各类大模型,Dify+Ollama部署比较简单,对硬件要求也不高,主要是Docker的安装(换国内镜像)和局域网设置可能会遇到问题。部署完个人推荐应用路径:先试云端(用DeepSeek或智谱AI的免费额度快速验证应用逻辑)再转本地(数据量增大或隐私需求提升时,通过 Ollama 部署开源模型)。