发行说明

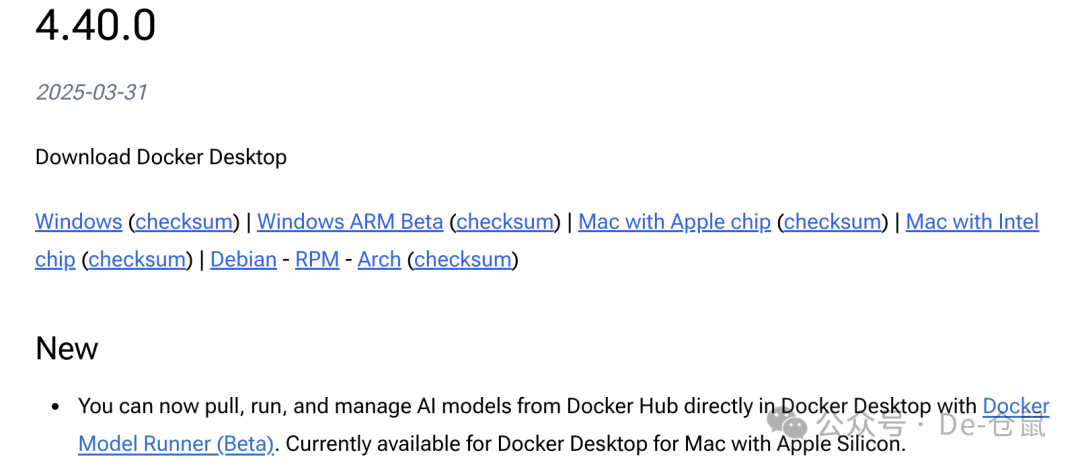

2025年3月31,Docker Desktop发布了V4.40.0,该版本重点是支持从Docker Hub提取、运行和管理 AI 模型:

Release notes :https://docs.docker.com/desktop/release-notes/

在此之前,通过Docker部署大模型,必须先运行Ollama容器,再通过Ollama容器运行大模型。

现在,直接跑大模型了,这是一个好消息。

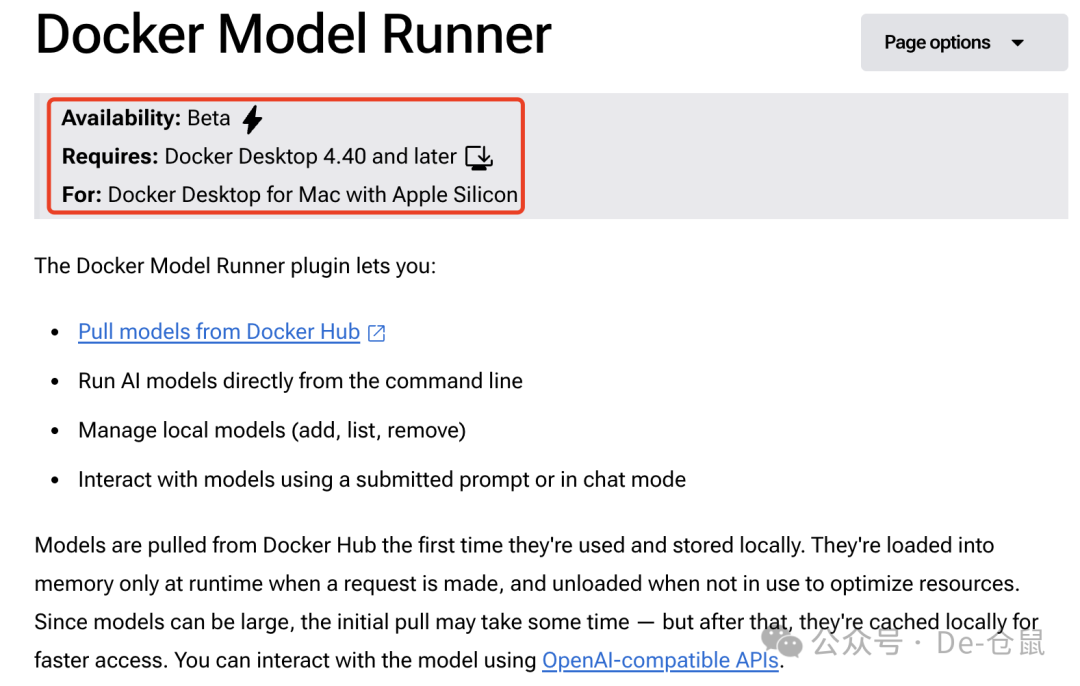

有好消息就有坏消息,坏消息是,当前只支持带有 Apple Silicon 的 Mac 版 Docker Desktop:

详细内容请查阅: https://docs.docker.com/desktop/features/model-runner/?uuid=66EBDDDD-7F8B-4743-AA27-F3BCA323736F

使用准备

安装Docker Desktop

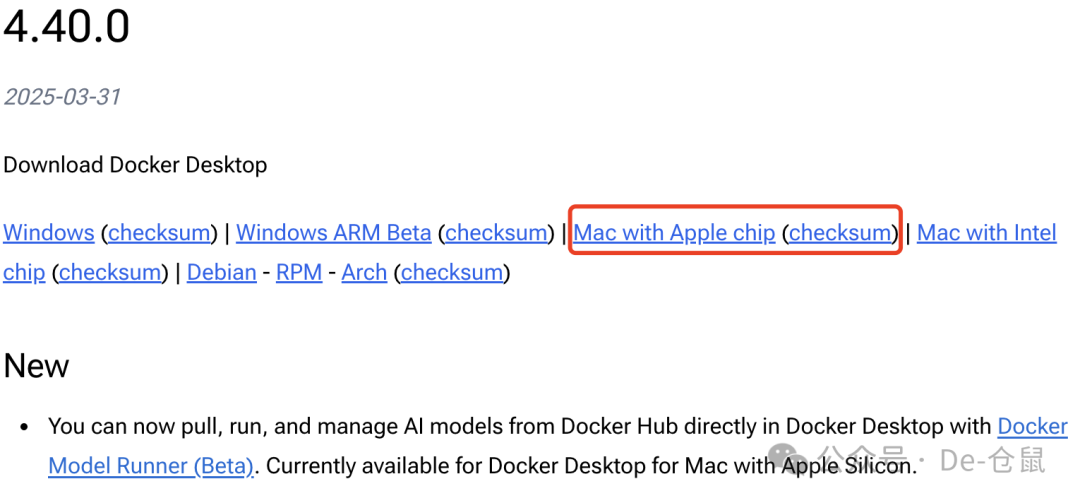

访问 https://docs.docker.com/desktop/release-notes/ 点击下载链接:

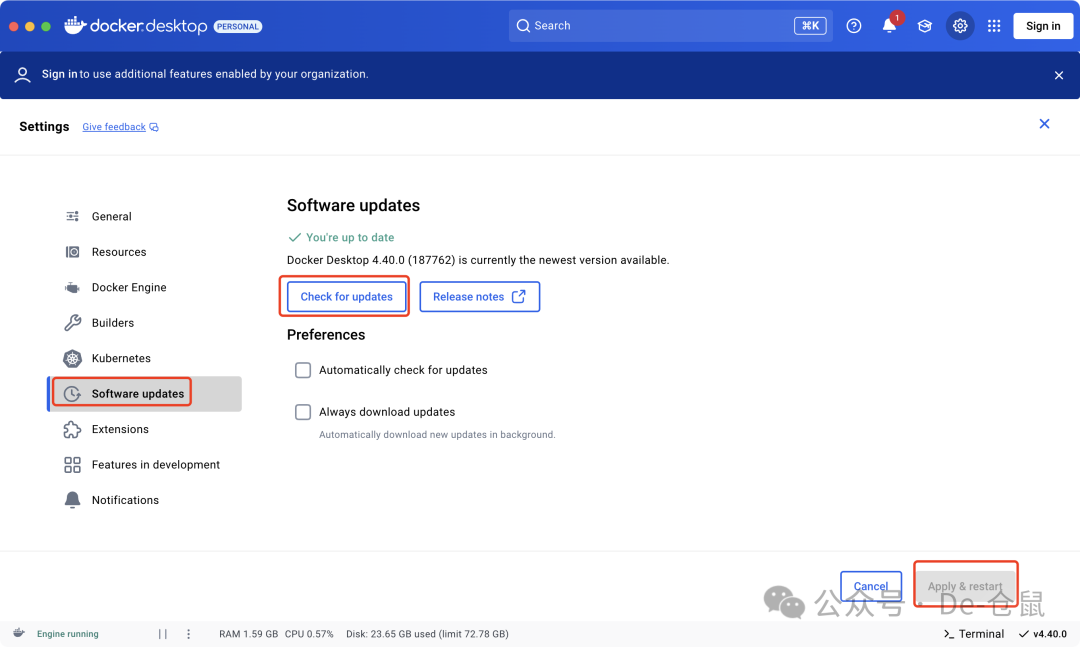

已安装过就打开Docker Desktop,找到Software updates,点击“Check for updates”:

事实上,当打开Docker Desktop也会提醒更新。

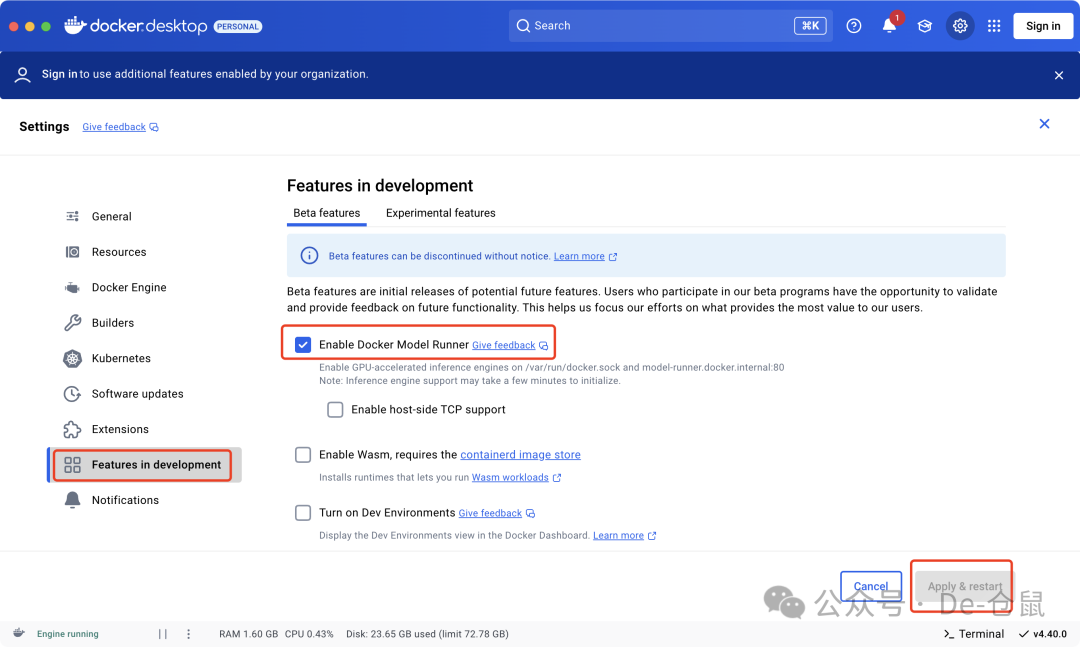

启用模型运行器

找到Features in development,勾选Enable Docker Model Runner前的复选框: 然后”Apply & restart”。

然后”Apply & restart”。

操作命令

拉取大模型

准备就绪后,在终端中执行大模型拉取命令:

docker model pull ai/deepseek-r1-distill-llama

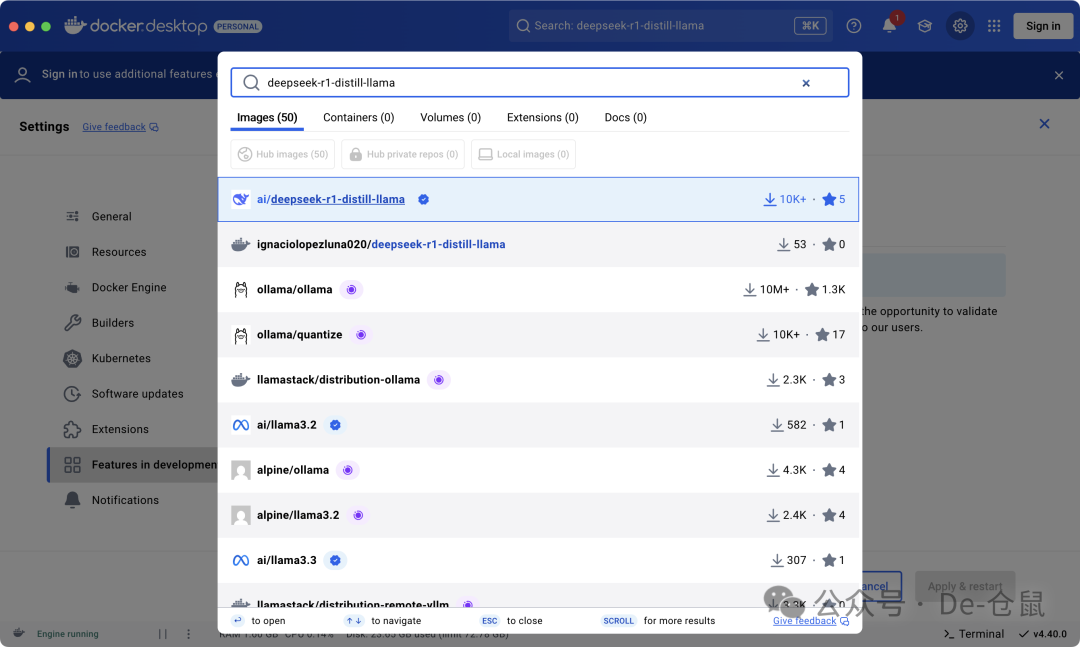

当然,也可在Docker Desktop的搜索框里查找并拉取:

目前支持拉取的大模型参考:https://hub.docker.com/catalogs/gen-ai

查看拉取的大模型

docker model list

运行大模型

-

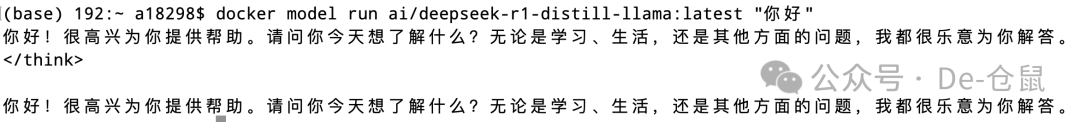

非交互式运行大模型

docker model run ai/deepseek-r1-distill-llama:latest "你好"

-

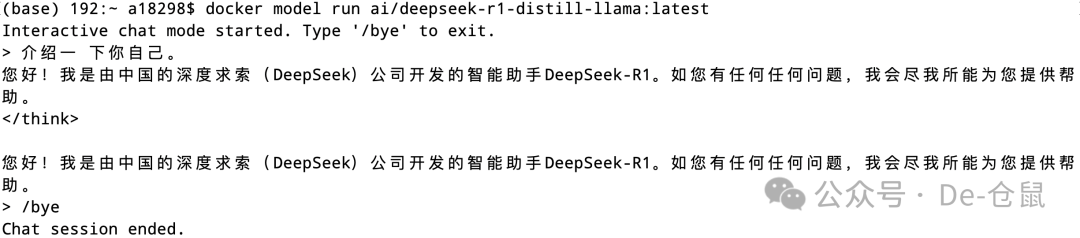

交互式运行大模型

docker model run ai/deepseek-r1-distill-llama:latest

删除大模型

docker model rm ai/deepseek-r1-distill-llama:latest

API调用

我尝试了官网说的其中2种调用方式,感觉都还行。

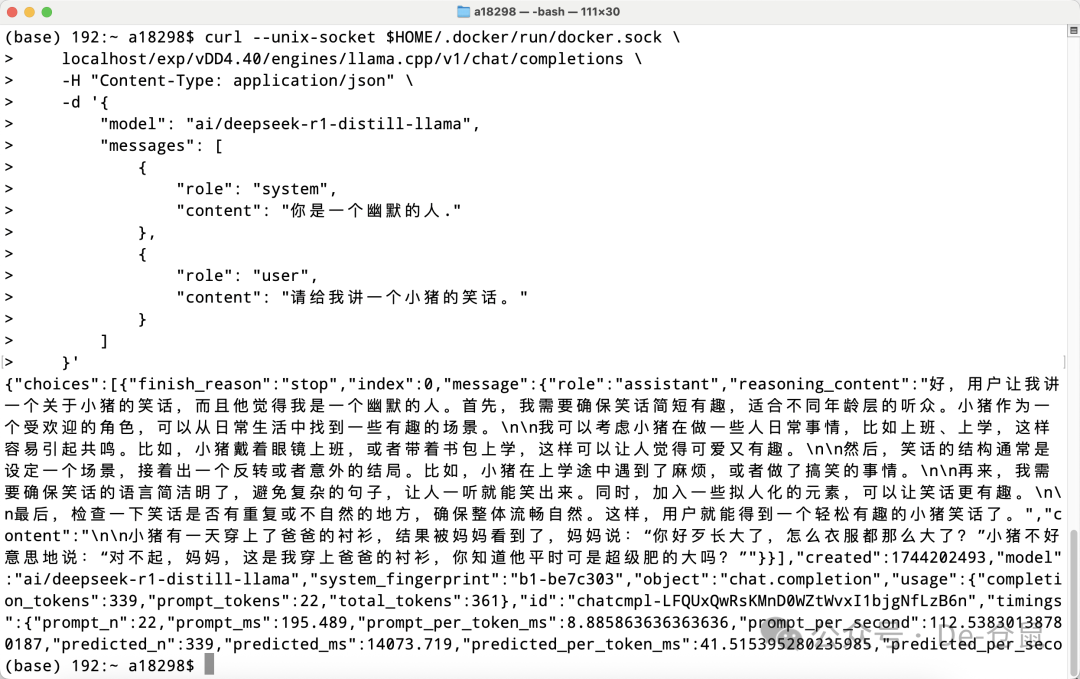

基于主机Unix 套接字

curl --unix-socket $HOME/.docker/run/docker.sock

localhost/exp/vDD4.40/engines/llama.cpp/v1/chat/completions

-H "Content-Type: application/json"

-d '{

"model": "ai/deepseek-r1-distill-llama",

"messages": [

{

"role": "system",

"content": "你是一个幽默的人."

},

{

"role": "user",

"content": "请给我讲一个小猪的笑话。"

}

]

}'

效果:

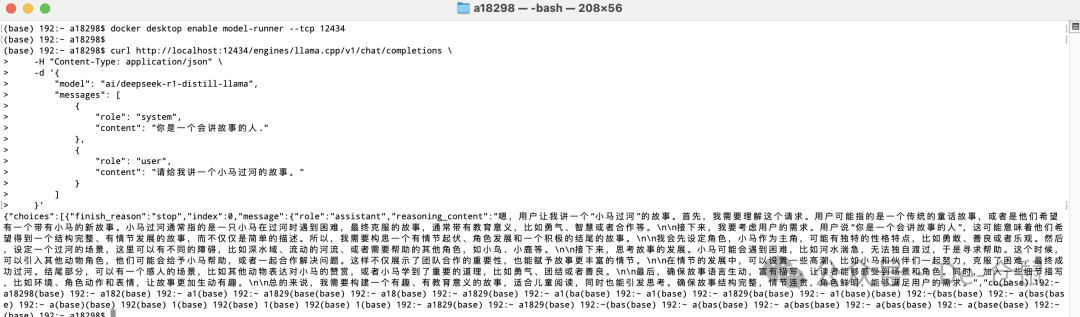

基于本机TCP端口

# 启用主机端 TCP 支持

docker desktop enable model-runner --tcp 12434

curl http://localhost:12434/engines/llama.cpp/v1/chat/completions

-H "Content-Type: application/json"

-d '{

"model": "ai/deepseek-r1-distill-llama",

"messages": [

{

"role": "system",

"content": "你是一个会讲故事的人."

},

{

"role": "user",

"content": "请给我讲一个小马过河的故事。"

}

]

}'

效果:

更多API内容,参考 https://docs.docker.com/desktop/features/model-runner/?uuid=66EBDDDD-7F8B-4743-AA27-F3BCA323736F

期待

个人认为,Docker Desktop能直接运行大模型,且可以通过curl调用大模型,要是能像Ollama一样提供一个API地址(http://127.0.0.1:11434)在其他应用上访问这个地址实现大模型的调用就好了,或者其他应用能兼容curl方式来调用也不错。