AnythingLLM[1] 是一个全栈应用程序,您可以使用现成的商业大语言模型或流行的开源大语言模型,再结合向量数据库解决方案构建一个私有 ChatGPT,不再受制于人:您可以本地运行,也可以远程托管,并能够与您提供的任何文档智能聊天。

支持 Mac, Windows, & Linux

AnythingLLM 核心功能

-

多用户实例支持和权限管理。 -

工作区内的智能体 Agent(浏览网页、运行代码等)。 -

支持多种文档类型(PDF、TXT、DOCX 等)。 -

支持聊天和查询模式:聊天模式保留先前的对话记录,查询模式则是是针对您的文档做简单问答。 -

聊天中会提供所引用的相应文档内容。 -

100% 云部署就绪,或 “部署你自己的 LLM 模型”。 -

管理超大文档时高效、低耗。只需要一次就可以嵌入(Embedding) 一个庞大的文档。比其他文档聊天机器人解决方案节省 90% 的成本。 -

全套的开发人员 API,用于自定义集成!

AnythingLLM 支持的 LLM

-

任何与 llama.cpp[2] 兼容的开源模型 -

OpenAI -

Azure OpenAI -

Anthropic -

Google Gemini Pro -

Hugging Face (聊天模型) -

Ollama (聊天模型) -

LM Studio (所有模型) -

LocalAi (所有模型) -

Together AI (聊天模型) -

Perplexity (聊天模型) -

OpenRouter (聊天模型) -

Mistral -

Groq -

Cohere -

KoboldCPP

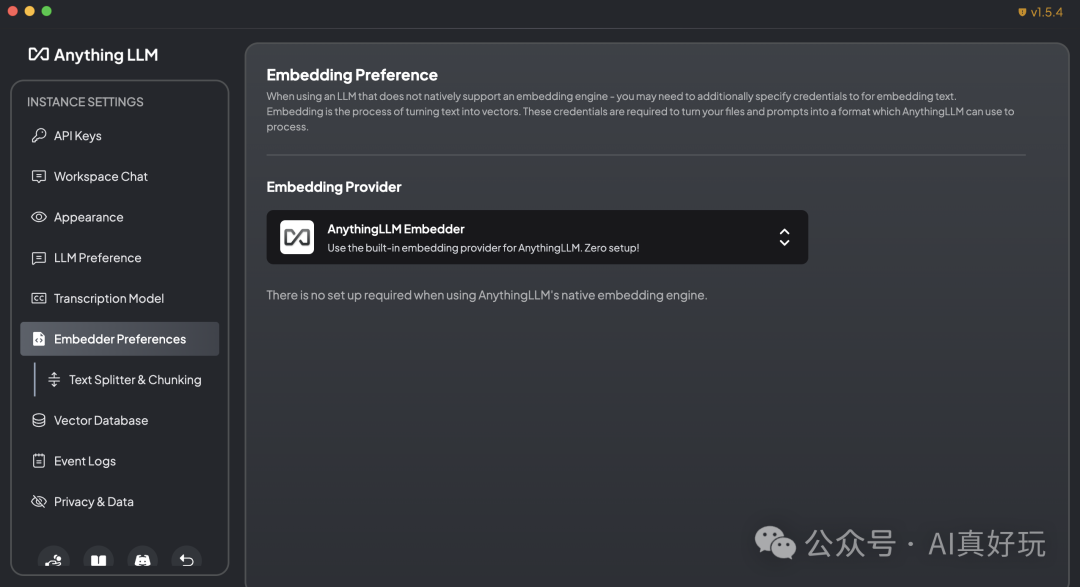

AnythingLLM 支持的嵌入模型

-

AnythingLLM 原生嵌入器(默认) -

OpenAI -

Azure OpenAI -

LocalAi (全部) -

Ollama (全部) -

LM Studio (全部) -

Cohere

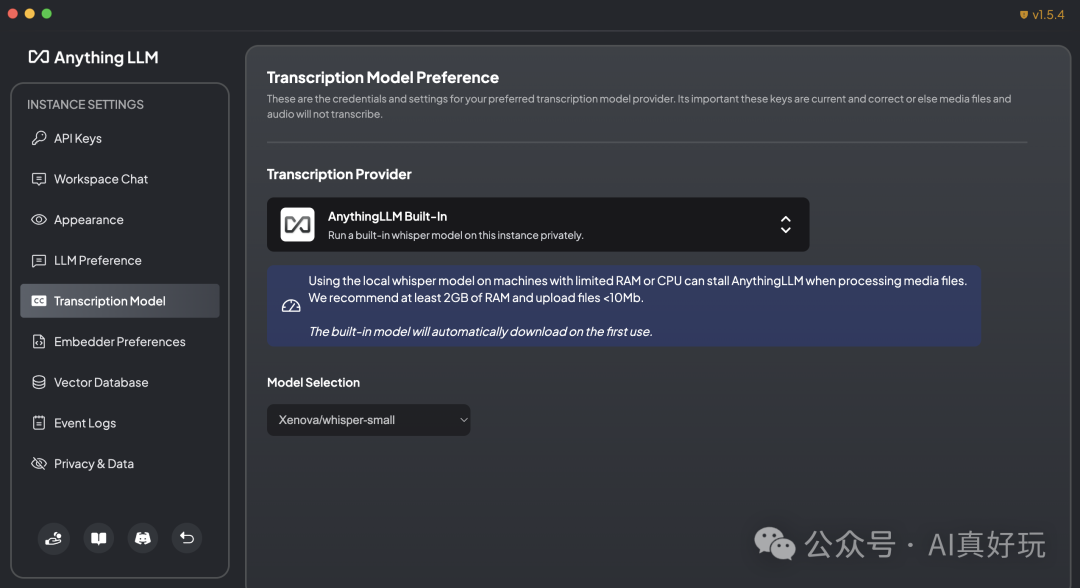

AnythingLLM 支持的转录模型

-

AnythingLLM内置(默认) -

OpenAI

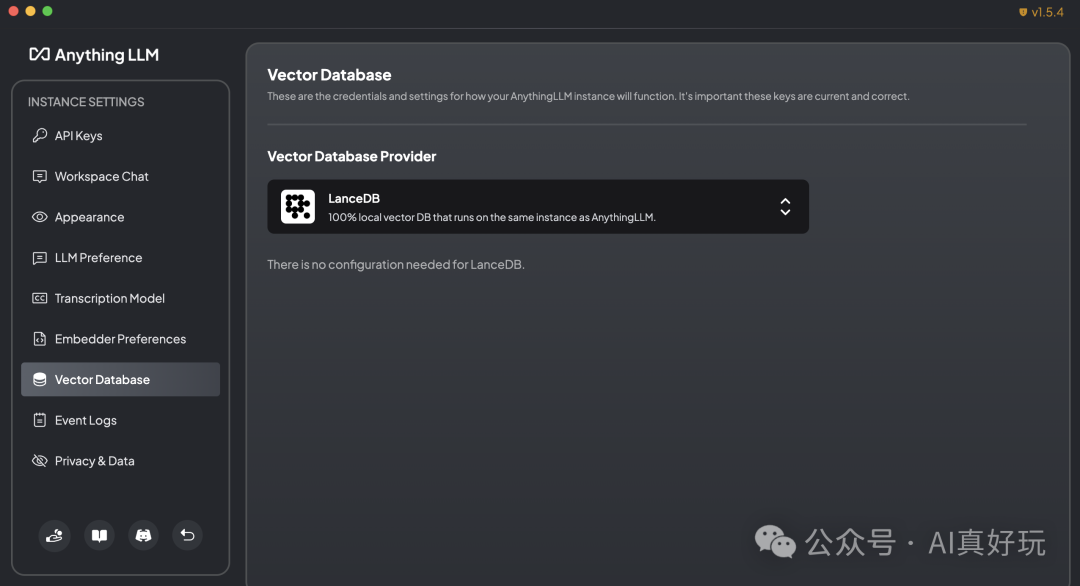

AnythingLLM 支持的向量数据库

-

LanceDB (默认) -

Astra DB -

Pinecone -

Chroma -

Weaviate -

QDrant -

Milvus -

Zilliz

AnythingLLM 仓库介绍

仓库结构

AnythingLLM 仓库由三个主要部分组成:

-

frontend: 一个 viteJS + React 前端,您可以运行它来轻松创建和管理 LLM 可以使用的所有内容。 -

server: 一个 NodeJS Express 服务器,用于处理所有交互并进行所有向量数据库管理和 LLM 交互。 -

docker: Docker 指令和构建过程 + 从源代码构建的信息。 -

collector: NodeJS Express 服务器,用于从 UI 处理和解析文档。

仓库地址:https://github.com/Mintplex-Labs/anything-llm

配置开发环境

-

yarn setup:填充每个应用程序部分所需的 .env文件(从仓库的根目录)。 -

在开始下一步之前,先填写这些信息 server/.env.development,不然代码无法正常执行。 -

yarn dev:server:在本地启动服务器(从仓库的根目录)。 -

yarn dev:frontend:在本地启动前端(从仓库的根目录)。 -

yarn dev:collector:然后运行文档收集器(从仓库的根目录)。