-

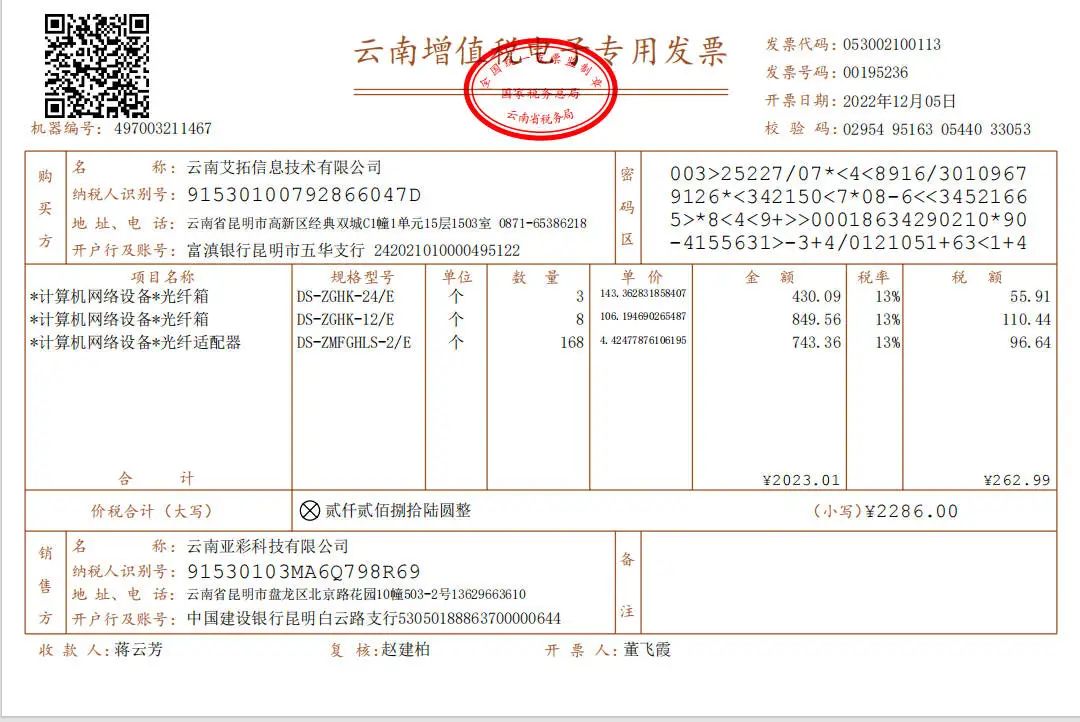

基于QwenVL2.5模型实现发票识别

提示词 准确的真实发票图片数据 提示词 "请提取发票图像中的以下信息:n" +"- 发票代码n" +"- 发票号码n" +"- 开票日期n" +"- 校验码n" +"- 机器编号n" +"- 购买方名称n" +"- 购买方纳税人识别…- 6

- 0

-

Ollama 五月更新解读:多模态、工具调用、模型思考,AI 本地化再进一步!

五月对于 Ollama 社区来说是激动人心的一个月!这个致力于让每个人都能轻松在本地运行强大AI模型的开源项目,在短短几周内接连发布了三项重大更新,极大地扩展了其功能和用户体验。如果你关注本地化 AI 的发展,或者已经是 Ollama 的忠实用户,那么这些新特性绝对不容错过。让我们一起来看看 Ollama 在这个五月都为我们带来了哪些惊喜。 重磅升级一:全新多模态引擎,让你的 AI “看”懂世界 …- 4

- 0

-

AI术语入门(下篇):Prompt、Agent、Langchain,下一站的AI地图

点击蓝字 关注我们上篇从基础开始,先理解 AI 是什么(上篇)我们从AI、LLM、大模型、多模态等核心术语入手,理了一遍基础概念。 这篇,我们继续深入,把那些在产品搭建、Agent组合和生成式AI项目中常见、但容易混淆的术语彻底讲清楚。 不只是解释“它们是什么”,更要回答这些术语背后那些你一定想问的问题: Prompt为什么有的人写得好,有的人写不出效果? Langchain和LLAMA是干嘛的?…- 5

- 0

-

人人能看懂的大模型MCP,附MCP服务实战指南

大模型(本文特指大语言模型)本来是这样一个东西:我们输入一段文字给它,它返回一段文字给我们。这就是大模型能且唯一能够做的事情。那么它又是如何做到获取天气信息、操作数据库、订机票、点外卖的?显然,背后一定借助了完成对应事情的工具,而且我们需要在大模型和工具之间建立一个桥梁。我们通过一个例子来认识这个桥梁背后的工作逻辑。假设我们开发了一个程序,这个程序就是上面所说的大模型和工具之间的桥梁。现在用户在程…- 3

- 0

-

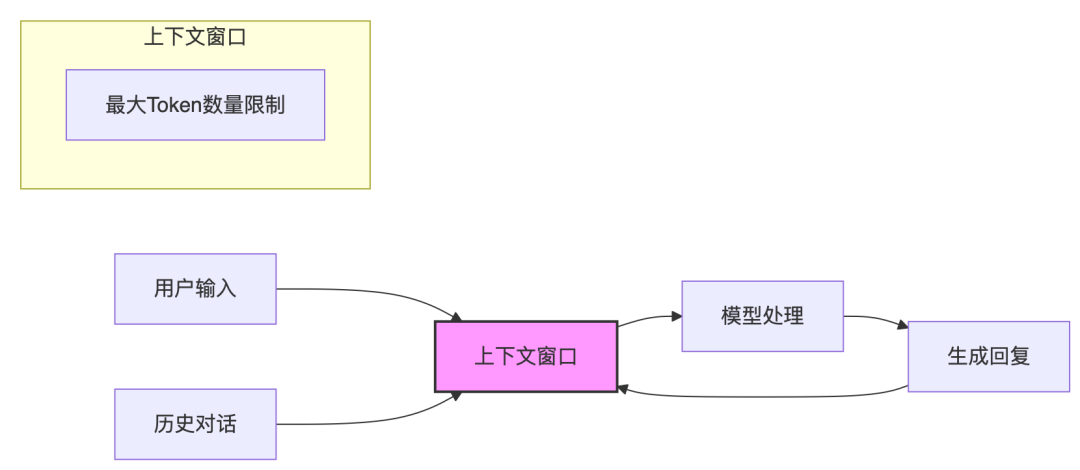

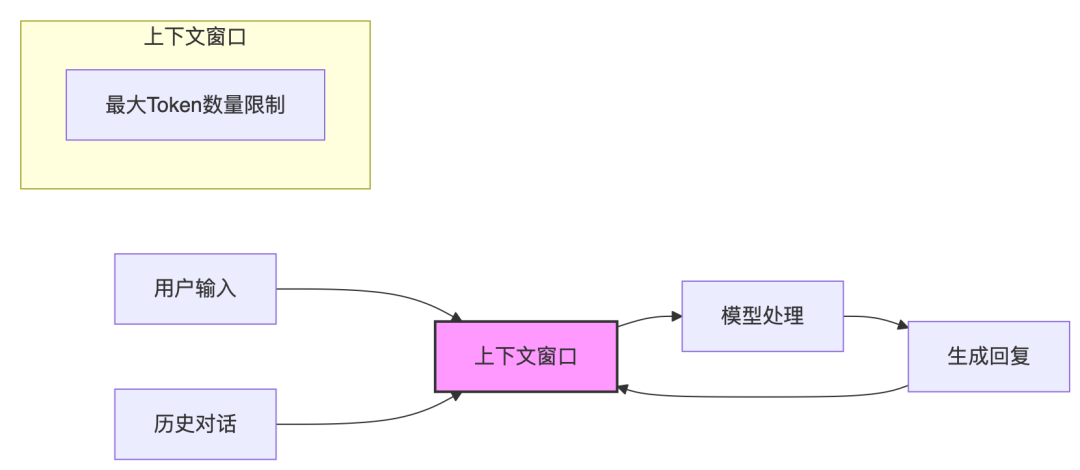

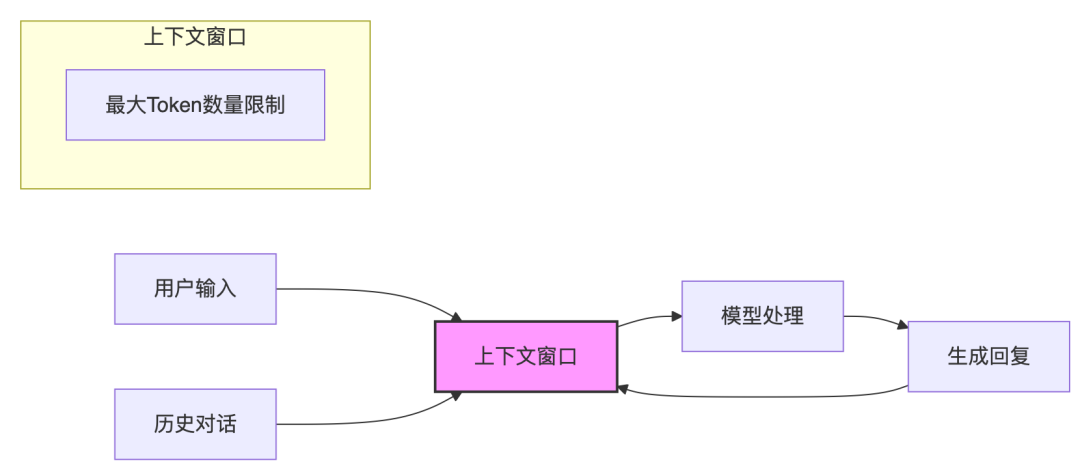

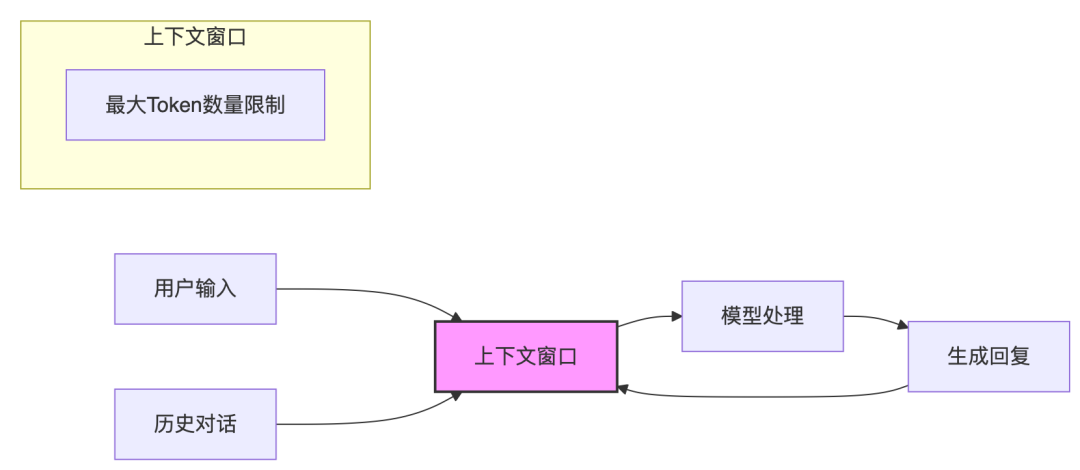

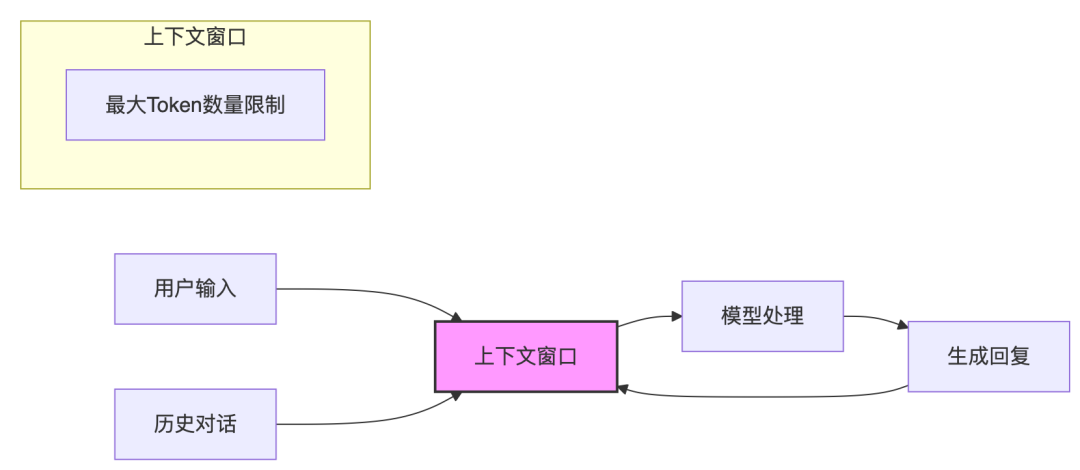

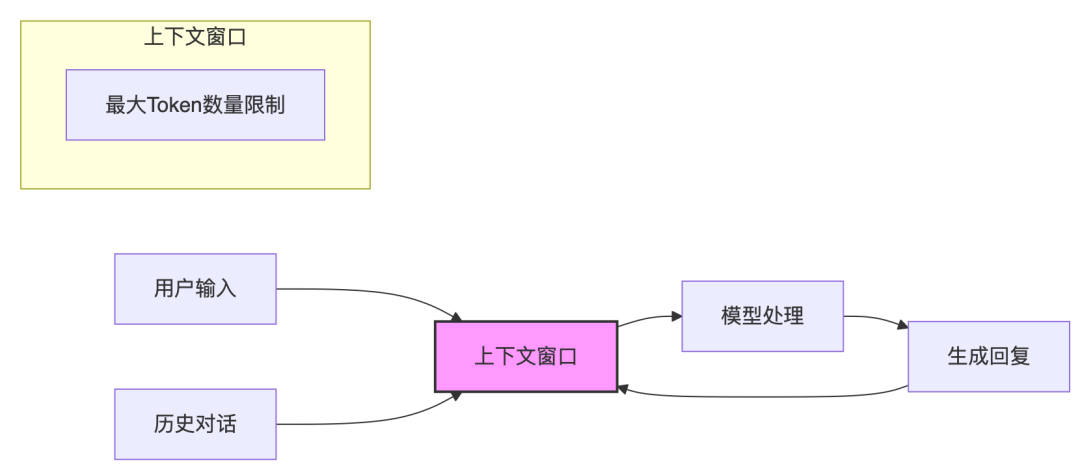

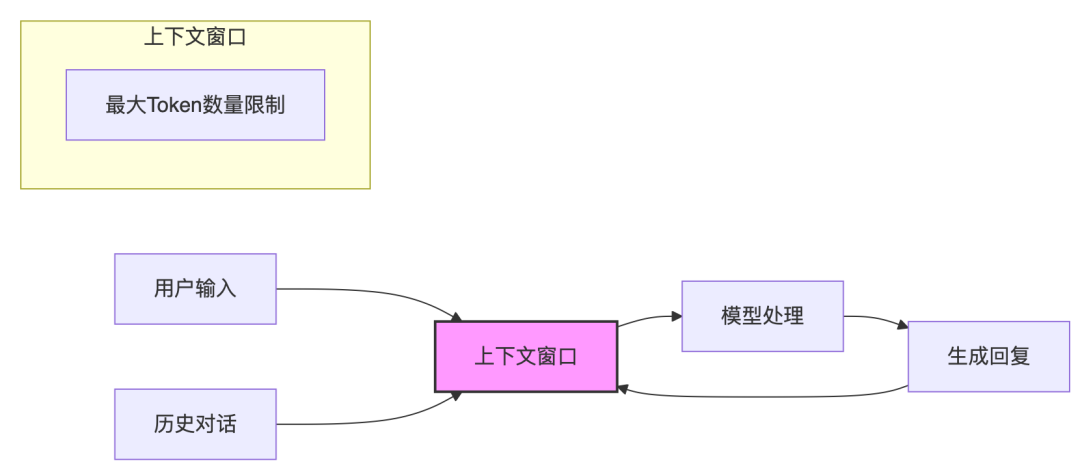

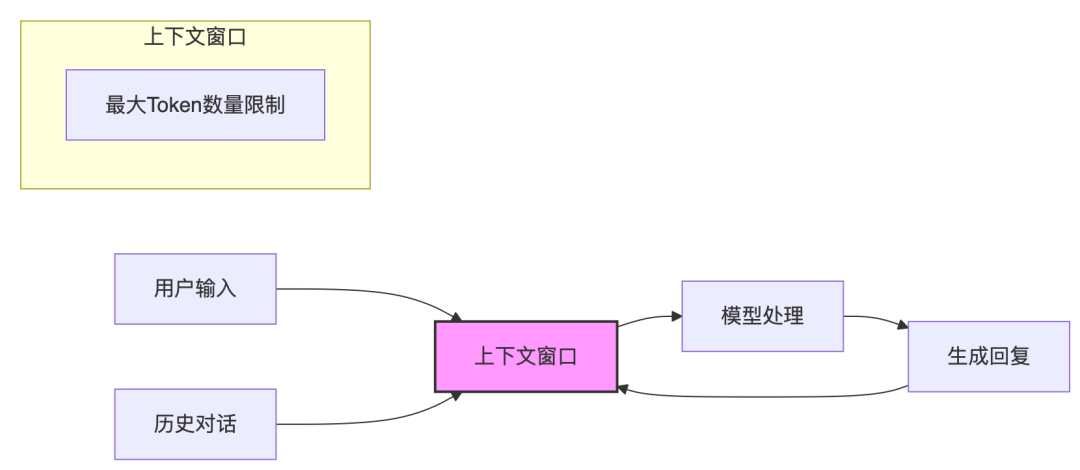

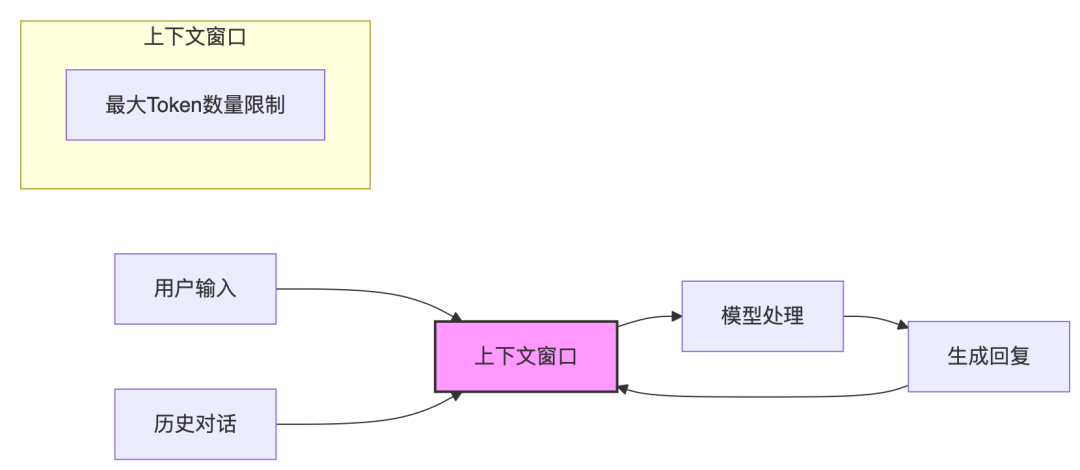

🧠 解码大语言模型的记忆力:上下文长度的前世今生

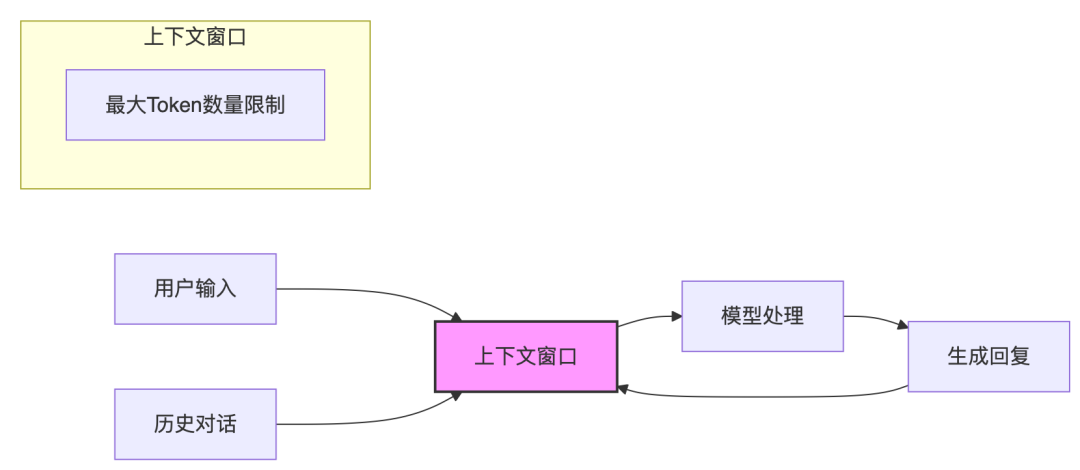

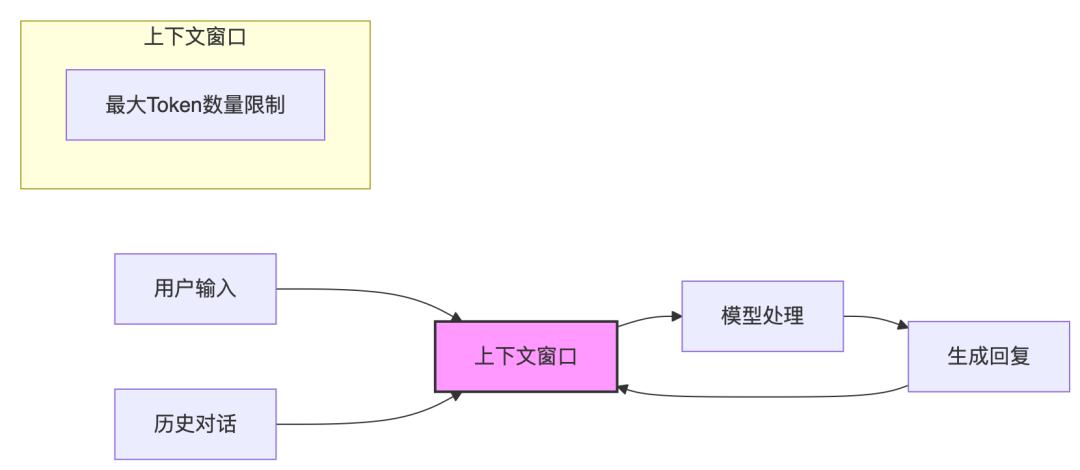

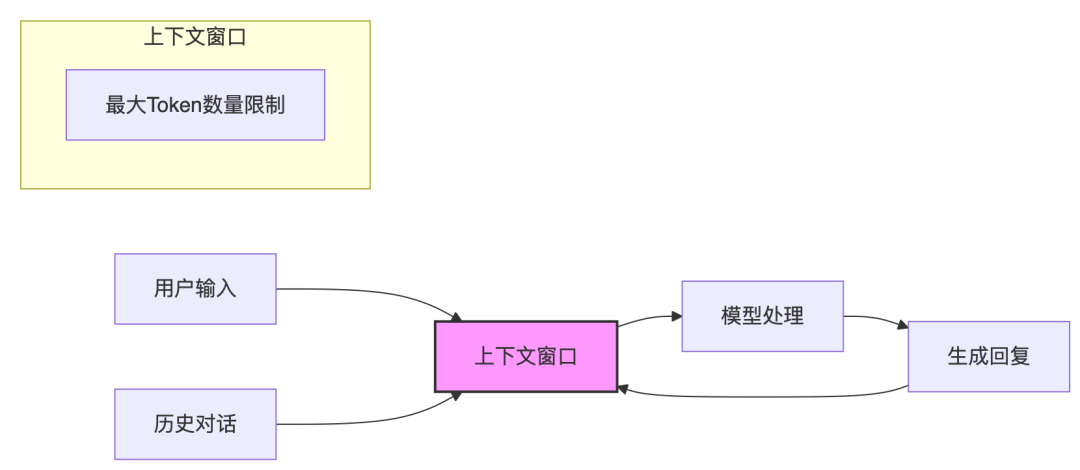

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

冒泡鸭退场,我看到了AI陪伴的下半场

AI 陪伴的上半场结束了 前几天,行业里一条消息悄然传开:阶跃星辰将收缩对冒泡鸭的投入。 这个曾以 “AI 角色互动” 为卖点、靠对话生成和情绪触碰吸引用户的 C 端产品,无声落幕了。有人说它是失败案例,也有人认为这是产品迭代的必然。 但对行业而言,这更像是一记信号 ——AI 陪伴的上半场,结束了。 过去一年,AI “情绪陪伴” 的热潮来得快,去得更快:有人在 Replika 上体验虚拟恋爱,有人…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

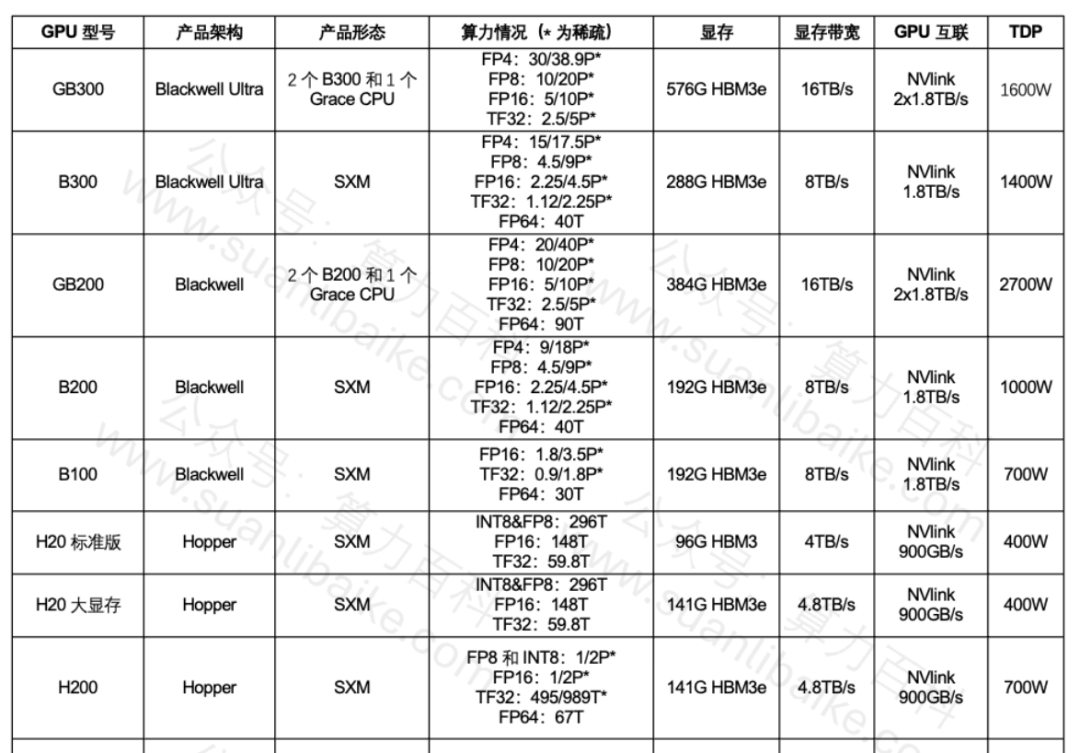

DeepSeek R2 1200B未发,大厂已在调整智算中心布局,兵马未动粮草先行!

兵马未动(DeepSeek R2 1200B未发),粮草先行(大厂重构智算中心算力布局)大厂已经掌握R2 1200B动向,已经提前布局! 特别注意:R2 1200B,虽然没发布,从大厂动作、外媒渲染以及算力百科多渠道信息交叉验证,综合判断可信度较高! Deepseek R2 相比R1总参数和激活参数近似翻倍,对智算中心影响深远,头部大厂已在调兵遣将,行动起来,他们掌握更多信息,…- 8

- 0

-

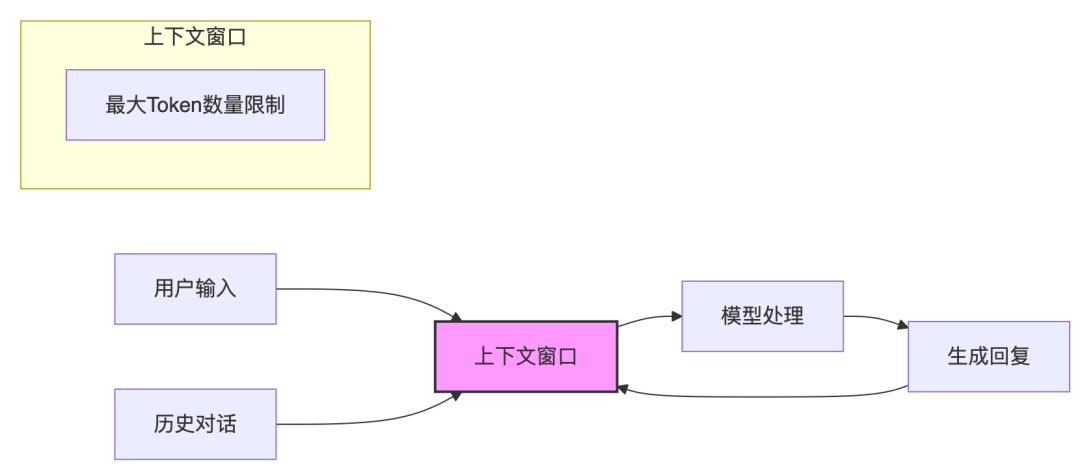

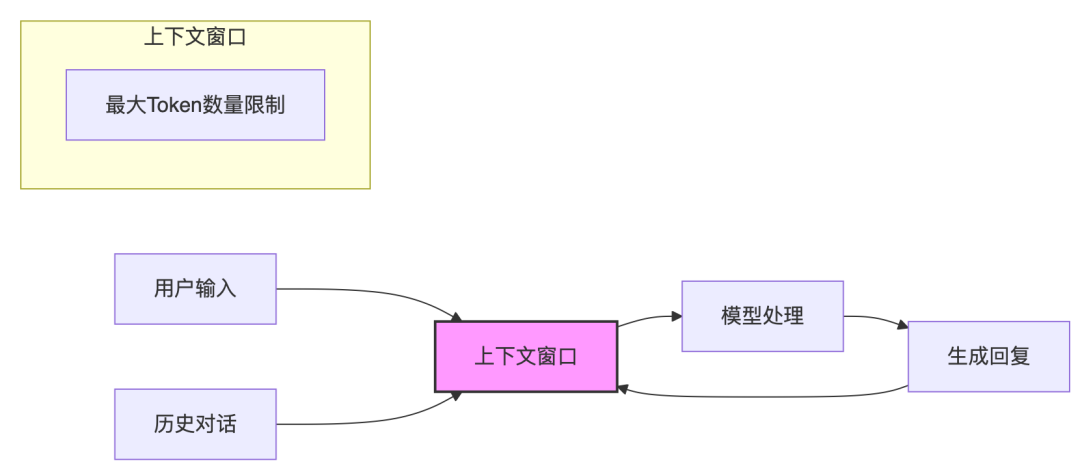

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 7

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

Agent 开发的上半场: 环境、Tools 和 Context 如何决定 Agent | 42章经

曲凯:Agent 是当下绝对的风口。关于 Agent 这个话题,我自己有一些核心在思考的问题,相信也是很多人同样会有疑问的地方。所以今天我们请来了长时间对 Agent 有研究和实操的文锋,想就这些问题展开一些讨论。 首先我想问,到底怎么定义 Agent? 文锋:我认为最好的就是 Anthropic 的定义:Agent 是让模型基于环境反馈去使用工具的一个程序。 曲凯:那你怎么看最近这波 Agent…- 5

- 0

-

AI时代的工作方式革命!Anthropic团队内部资料:如何借AI重构旧有工作方式?

官方原版PDF资料地址下载地址: https://pan.quark.cn/s/943384357363 最近,Anthropic发布了一份内部调研报告,详细记录了公司10个不同部门如何在日常工作中使用Claude Code。 这些真实案例不仅展现了AI工具的强大潜力,更重要的是,它们揭示了一个正在发生的工作方式革命。 营销团队:从2小时到15分钟 —增长营销团队的故事最让人印象深刻。 作为非技术…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

微软发布AI Agent故障白皮书,万字解读各种恶意智能体

微软发布了《AI Agent系统故障模式分类》白皮书,以帮助开发者和用户更好的理解、解决日常Agent出现的各种故障。 这些故障主要分为新型故障和既有故障两大类,并详细解读了出现这些故障的原因以及如何解决。 由于内容太多,「AIGC开放社区」就为大家介绍一些典型的恶意智能体攻击方法和原理。 新型Agent安全故障 智能体伪装 攻击者通过引入一个新的恶意智能体,使其伪装成系统中已有的合法智能体,并被…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 5

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 6

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 1

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 4

- 0

-

🧠 解码大语言模型的记忆力:上下文长度的前世今生

在与ChatGPT、Claude等大语言模型对话时,你是否好奇:它们是如何记住我们之前的对话内容的?为什么有时它们能记住很长的对话,有时却会"失忆"?今天,我们就来深入浅出地剖析大语言模型中的一个关键概念——上下文长度(Context Length)。上下文长度是什么?想象你正在和一个朋友聊天。这个朋友有一个特殊的能力:他能记住你们之间交流的最后N个字。如果你们的对话超过了N个…- 3

- 0

❯

购物车

优惠劵

搜索

扫码打开当前页

联系我们

返回顶部

幸运之星正在降临...

点击领取今天的签到奖励!

恭喜!您今天获得了{{mission.data.mission.credit}}积分

我的优惠劵

-

¥优惠劵使用时效:无法使用使用时效:

之前

使用时效:永久有效优惠劵ID:×

没有优惠劵可用!