01。

概述

02。

关键特性

-

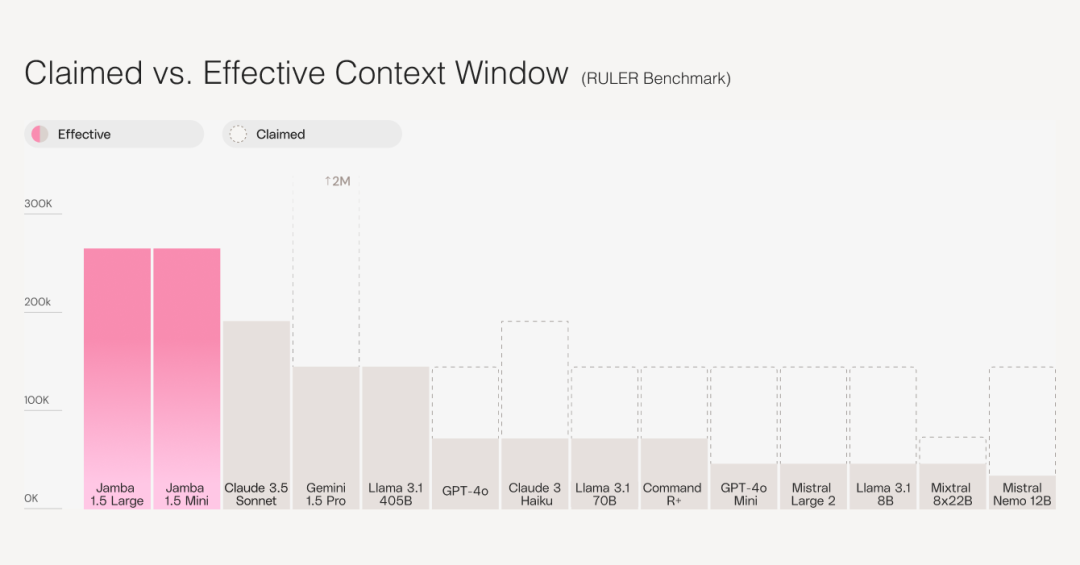

长上下文处理:Jamba 1.5模型拥有市场上最长的256K有效上下文窗口,能够提升关键企业应用的质量,例如长篇文档的摘要和分析,以及代理和增强检索生成(RAG)工作流程。

-

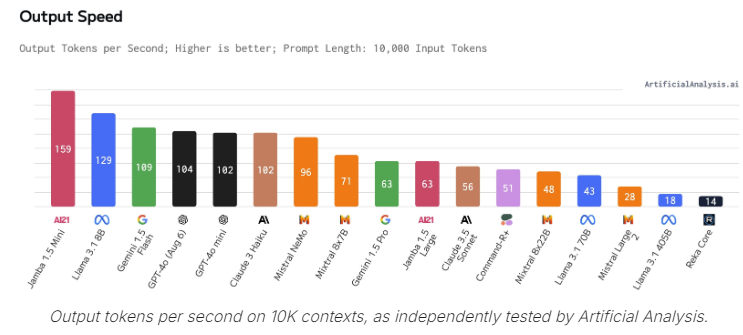

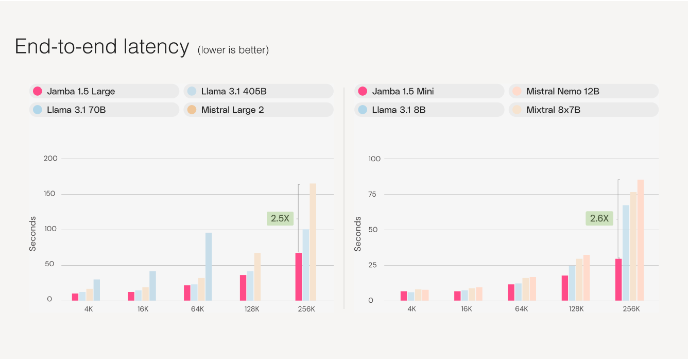

速度:在长上下文处理上速度提升至2.5倍,且在其规模类别中所有上下文长度上均为最快。

-

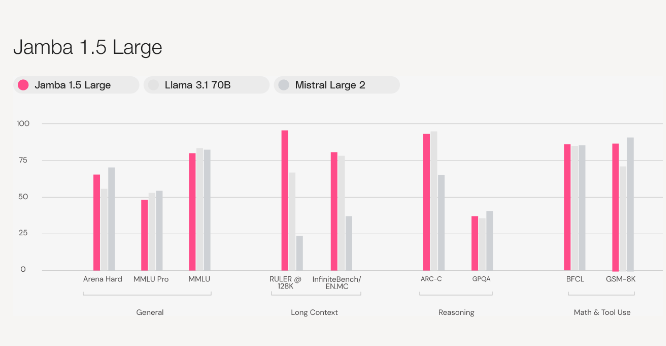

质量:Jamba 1.5 Mini在Arena Hard基准测试中得分46.1,是其规模类别中最强的开放模型,超越了Mixtral 8x22B和Command-R+等更大型模型。Jamba 1.5 Large得分65.4,超越了Llama 3.1 70B和405B。

-

多语言支持:除了英语,模型还支持西班牙语、法语、葡萄牙语、意大利语、荷兰语、德语、阿拉伯语和希伯来语。

-

开发者友好:Jamba原生支持结构化JSON输出、函数调用、文档对象处理和引用生成。

-

开放构建:两种模型均可在Hugging Face上立即下载(即将登陆领先的框架LangChain和LlamaIndex)。

-

灵活部署:除了AI21 Studio,模型还在Google Cloud Vertex AI、Microsoft Azure和NVIDIA NIM等云合作伙伴平台上可用,并将很快登陆Amazon Bedrock、Databricks Marketplace、Snowflake Cortex、Together.AI,以及支持私有本地和VPC部署。

03。

模型潜力

04。

总结语展望