好久不写微信公众号文章了,写个随笔,谈谈最近的思考。

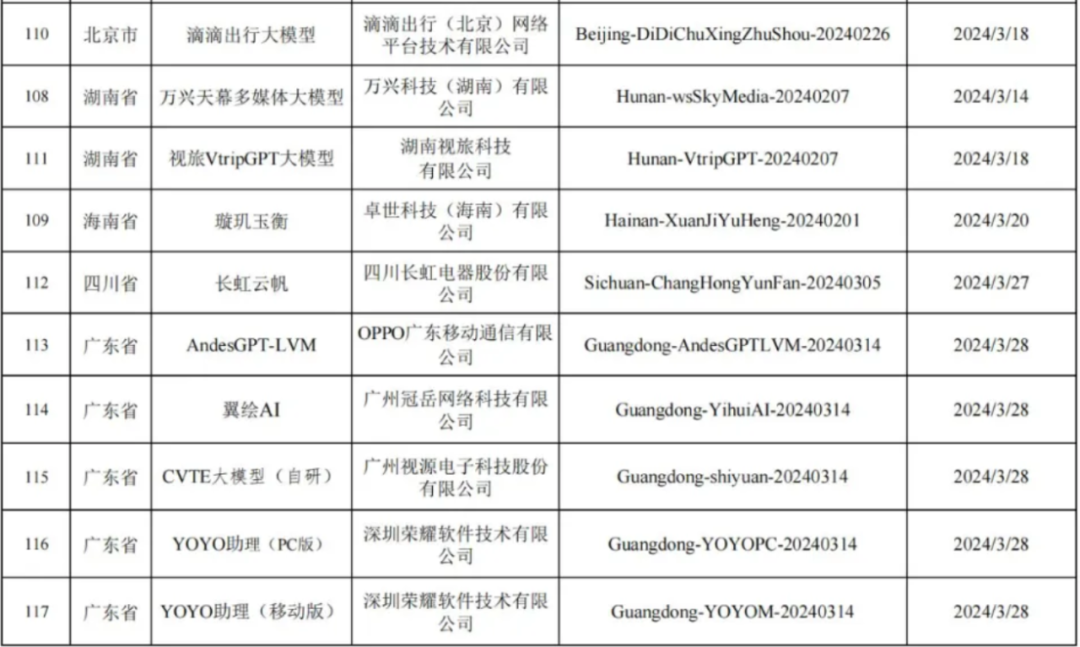

中国人工智能大模型产业,现在正在搞 “百模大战” ,根据公开媒体报道,截至2024年3月,我国共有117个大模型完成了备案。

今天看到一个最新消息,说截止 6 月份,全国共通过备案的大模型服务企业已经达到 162 家。

2024年7月4日举行的世界人工智能大会上,百度李彦宏批评了当前人工智能领域的“百模大战”,在他看来,过去这一年多来行业处在非常热闹的“卷模型”之中,一度出现了百模大战的盛况。没有实际应用的基础模型,无论开源还是闭源,都没有价值。

李彦宏是从市场价值角度来看通用大模型或者基础大模型,我换个角度,从算力规模角度来分析一下,为什么通用大模型行业将会崩溃,90%的通用大模型企业都会死掉或者退出通用大模型市场。

注意啊,这里说的是 “死掉或者退出通用大模型市场”,不是说一定会死掉,而是还有“退出市场”这个选项。

90%的通用大模型即将死掉或者退出市场,意味着通用大模型行业的大崩溃、大洗牌,大淘汰。

第一、通用大模型的参数规模将在2025-2026年达到10万亿

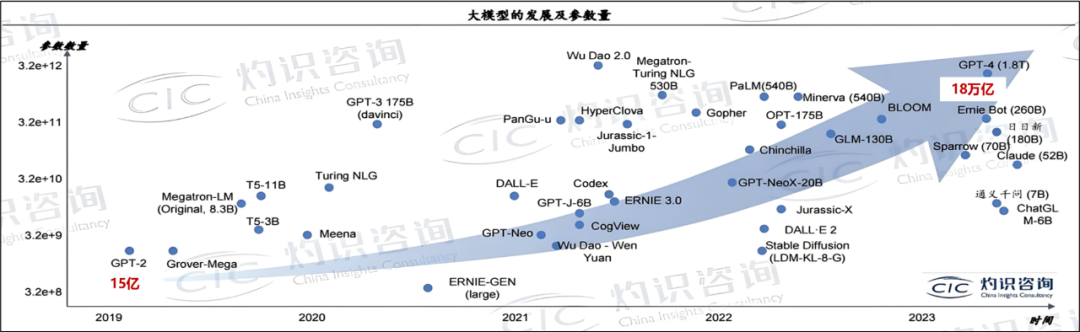

OpenAI 2019年发布GPT-2的参数是15亿,2023年发布的 GPT-4 大模型,总的参数规模已经达到1.8万亿。OpenAI首席技术官 米拉·穆拉提 透露,GPT5预计将于2025年底发布,是一个具有52万亿参数的多模态模型。

华为2024年6月最新发布的 盘古Pangu S超级大模型,参数规模达到万亿级。

7月份在上海召开的2024 世界人工智能大会,中国本土AI公司阶跃星辰发布了一个万亿参数大模型—Step-2。

阿里巴巴也发布了一个号称10万亿参数的大模型,官网介绍,M6是中文社区最大的跨模态预训练模型,模型参数达到十万亿以上,具有强大的多模态表征能力。

训练一个10万亿参数的通用大模型,需要什么条件?当然是超大规模的AI算力池。

2023年9月特斯拉建设的1万张H100 GPU集群上线。2024年5月,马斯克宣布建造超级算力工厂,规模达到10万张H100。2024年6月,马斯克宣布其投资的xAI公司计划花费90亿美元购买30万颗 Blackwell B200 GPU。

2024年3月Meta官网宣布建成2个包含2.4万张H100 GPU的集群,2024年底将再部署35万张H100,总算力计划达到60万张H100。

2024年5月中国移动宣布将商用哈尔滨、呼和浩特、贵阳的三个万卡集群,总规模近6万张GPU卡。

华为已经在规划十万卡算力池,有可能在芜湖算力中心落地。

2024年3月,英伟达发布B200芯片,拥有2080亿个晶体管,算力达到 2.25 PFLOPS ( FP16半精度 ),比2016年的 Pascal 芯片增长了118倍,是2020年A100芯片的7.21倍,是2022年H100芯片的2.25倍。可支持部署27万亿参数的大模型。

因此,在超级AI芯片层面,英伟达已经为训练十万亿参数通用大模型提供了关键能力。

那么,十万卡算力池的投资有多大呢?按照B200售价3万美元计算,10万卡算力池需要购买30亿美元的英伟达B200模组或计算卡,如果加上服务器机头、IB网卡、交换机、存储、光纤等设备和配件,预计投资需要40亿~50亿美元,大约折合300亿人民币。如果按照5年折旧,平均每年设备折旧大约60亿元。

根据报道,运行一个10万卡算力集群的能源消耗150MW/年,可计算全年电费支出超过8亿元。

所以,问题出现了,中美两国在人工智能领域的竞争,中国是不可能让步的。美国AI企业的通用大模型参数达到1000亿,中国企业跟了。美国AI企业的通用大模型参数达到10000亿,中国企业也跟了。如果美国AI企业的通用大模型参数达到10万亿,中国企业跟不跟?

中国的上百家通用大模型企业,有多少家企业的通用AI大模型,能跟到1万亿参数?有多少家企业的产品能跟到10万亿参数?

这个问题简化一下就是:你家能不能承担每年8亿元电费?

建设算力集群、运营巨型算力中心,训练通用大模型,从万亿参数的通用大模型开始,已经变成一个超级烧钱的游戏,变成了一个富豪局。

如果非要硬着头皮跟盘,购买算力把现金烧光之后,结果依然是出局。

所以本文认为,中国90%通用大模型企业是没有能力(钱)跟盘的,未来或者烧光现金出局,或者主动退出这个市场。

通用大模型行业即将大崩溃,这是一个典型的灰犀牛风险。

预测2025年,崩溃的迹象开始慢慢浮现出来,一些通用大模型公司静悄悄地不再更新版本,另一些通用大模型公司开始改变产品营销的卖点。这个时候你就知道:崩溃已经到来了。

我这篇公众号文章动笔是在7月7日,今天7月9日看到一个报道:

Anthropic首席执行官Dario Amodei表示:GPT-4o大模型训练花费约1亿美元,而目前正在开发的 AI 大模型训练成本可能高达10亿美元。未来三年内,AI大模型的训练成本将上升至100亿美元甚至1000亿美元。

好吧,虽然我支持这个观点,训练AI大模型的算力投资会越来越高,但是1000亿美元训练一个AI大模型,确实是超出我的认知了。

如果你认为上述分析的逻辑是成立的,那么新的问题出现了:

90%通用大模型企业的出路在哪里?

2024年的政府工作报告,提出加快发展新质生产力;深化大数据、人工智能等研发应用,开展“人工智能+”行动。

华为《智能世界2030》报告中指出:未来将是一个智能世界,AI应用无处不在。

李彦宏在上海世界人工智能大会上提出:没有实际应用的基础模型,都没有价值。应用的价值远比模型本身更为重要。

这些认知都是正确的。

人工智能大模型的终极目的,是服务国家,服务产业、企业、教育、医疗、矿山、制造业、农业、林业、牧业等各行各业。“人工智能+”的目标对象,就是各个产业、企业、行业的应用场景。

前阿里云CEO张勇有一句很有名的话:所有行业、所有应用、所有软件、所有服务都值得基于新型人工智能技术、基于AIGC各方面技术支撑、大模型支撑重做一遍。

因此国家经济和社会发展真正需要的,不是1万亿或者10万亿参数的AI大模型,而是AI技术、AI大模型作为一种新质生产要素,与产业、行业、企业结合,融入原有的生产力和生产关系,演进出来新的高质量生产力和生产关系,改造和提升每个产业、行业、企业。

对于90%的通用大模型企业来说,现在可能面临一种选择,就是改变发展路线,放弃通用大模型赛道,选一个对人工智能提升发展质量有需求的特定行业、企业、产业去合作,去深耕 “人工智能+行业” 、“人工智能+产业” 、“人工智能+企业”。

也许不需要搞1万亿、10万亿参数的大模型训练,就能做出来一个服务某行业应用场景、提升行业生产力的 AI行业垂域大模型,形成该行业的新质生产力,推动该行业的高质量发展。

一句话总结:放弃通用大模型,用AI服务行业发展,成为行业的新质生产力。

如何避免通用大模型行业发生大崩溃?

答案就是:90%没有那么多钱烧的通用大模型企业,放弃这个赛道,尽早进入新赛道,通用大模型行业也就不存在行业崩溃了。

第三部分、谁能坚持笑到最后

如果中国的通用大模型产业发生大崩溃,谁能坚持活下去,谁能笑到最后?

第一、企业集团有没有庞大的主营业务收入和利润,能够长期支撑N万亿参数、10万亿参数通用大模型训练所需海量算力支出?

第二、企业的通用大模型的市场转化情况如何,能不能形成足够的产业化收入,以对冲N万亿参数、10万亿参数通用大模型训练所需的海量算力支出?

一句话:要么是爸爸给钱能养活自己,要么是自己能挣钱养活自己。做不到这两点的通用大模型公司,大概率出局。

主营业务持续盈利,中国最有钱,也能为通用大模型训练持续烧钱的互联网和云计算企业:腾讯、阿里、字节、百度、华为、京东、快手。

我能想到的是:中国移动、中国电信、中国联通、国家电网…

其它还有很多知名的AI通用大模型研发公司,实在不好判断,大概的判断办法依然是:看爸爸。

因此,做通用大模型的AI创新公司,如果想要在通用大模型这条赛道上坚持跑下去,可能从现在就要开始考虑找一个富爸爸了。

找不到富爸爸的通用大模型公司,建议不要等钱都烧完了,而是从现在就要开始考虑转换赛道,进入行业垂域模型和AI应用服务市场。