MuxServe 创新性地提出了灵活的时空复用方法,通过根据模型流行度进行共存部署以及分离预填充和解码阶段,有效解决了多LLM服务中的GPU利用率问题,实现了更高的吞吐量和更稳定的服务等级。

论文介绍

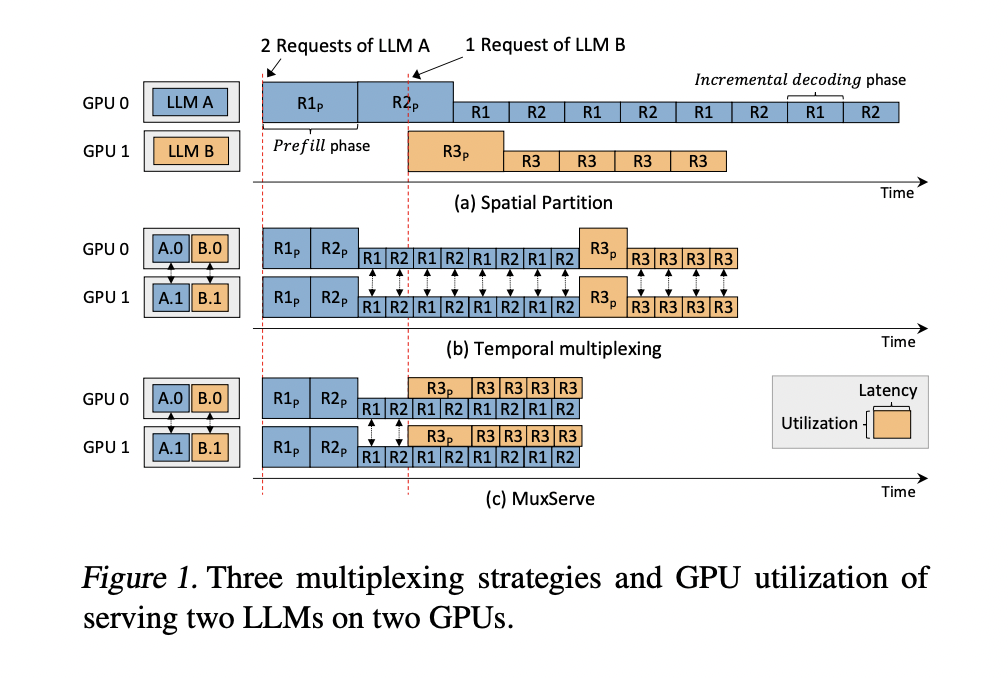

大型语言模型 (LLMs) 在 AI 行业中获得了显著地位,彻底改变了聊天、编程和搜索等各种应用。然而,高效地服务多个 LLMs 已成为终端提供商面临的一项重大挑战。主要问题在于这些模型对计算能力的巨大需求,单个 175B LLM 推理就需要八个 A100 (80GB) GPU。当前的方法,特别是空间分区,在资源利用方面需要改进。这种方法为每个 LLM 分配单独的 GPU 组,由于模型流行度和请求率的不同,导致利用率不足。因此,不太流行的 LLMs 会导致 GPU 闲置,而流行的 LLMs 则会遇到性能瓶颈,这凸显了对更高效服务策略的需求。

现有的解决 LLM 服务挑战的尝试探索了各种方法。深度学习服务系统专注于时间复用和调度策略,但这些主要针对较小的模型。特定于 LLM 的系统已经通过定制 GPU 内核、并行技术以及内存管理和卸载等优化取得了进展。然而,这些方法通常针对单个 LLM 推理。已经开发了包括时间和空间共享在内的 GPU 共享技术来提高资源利用率,但它们通常适用于较小的 DNN 作业。虽然每种方法都做出了贡献,但它们在满足高效服务多个 LLM 的独特需求方面都存在不足,这凸显了对更灵活、更全面的解决方案的需求。

来自香港中文大学、上海人工智能实验室、华中科技大学、上海交通大学、北京大学、加州大学伯克利分校和加州大学圣地亚哥分校的研究人员提出了 MuxServe,这是一种灵活的时空复用方法,用于服务多个 LLMs,解决了 GPU 利用率挑战。它将预填充和增量解码阶段分开,根据 LLM 流行度对作业进行共置,并采用优化框架来确定理想的资源分配。该系统使用贪婪放置算法、自适应批处理调度和统一资源管理器来最大限度地提高效率。通过使用 CUDA MPS 对 GPU SM 进行分区,MuxServe 实现了有效的时空分区。与现有系统相比,这种方法可将吞吐量提高 1.8 倍,标志着高效多 LLM 服务的重大进步。

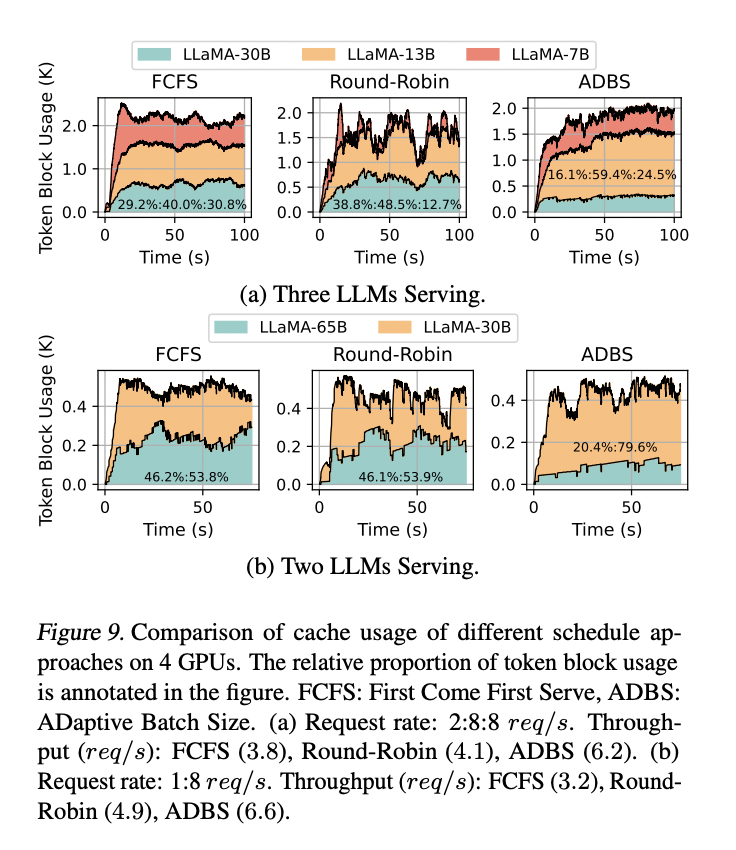

MuxServe 引入了一种灵活的时空复用方法,可以高效地服务多个 LLMs。该系统制定了一个优化问题,以找到最大化 GPU 利用率的最佳 LLM 单元组。它采用基于枚举的贪婪算法进行 LLM 放置,优先考虑计算需求较大的模型。为了最大限度地提高单元内吞吐量,MuxServe 使用自适应批处理调度算法来平衡预填充和解码作业,同时确保公平的资源共享。统一的资源管理器通过动态分配 SM 资源并为共享内存使用实施 Head-wise 缓存,从而实现高效的多路复用。这种综合方法使 MuxServe 能够有效地共置具有不同流行度和资源需求的 LLMs,从而提高整体系统利用率。

MuxServe 在合成和真实工作负载中均表现出卓越的性能。在合成场景中,与基线系统相比,它实现了高达 1.8 倍的吞吐量,并在 99% SLO 达成的情况下处理了 2.9 倍的请求。该系统的效率随工作负载分布而异,在 LLM 流行度多样化时表现出特别的优势。在源自 ChatLMSYS 跟踪的实际工作负载中,MuxServe 的吞吐量分别优于空间分区和时间复用 1.38 倍和 1.46 倍。它在各种请求率下始终保持较高的 SLO 达成率。结果突出了 MuxServe 能够有效地共置具有不同流行度的 LLMs,从而有效地复用资源并提高整体系统利用率。

这项研究引入了 MuxServe,它代表了 LLM 服务领域的重大进步。通过引入灵活的时空复用,该系统有效地解决了同时服务多个 LLMs 的挑战。其基于流行度共置 LLMs 并分离预填充和解码作业的创新方法提高了 GPU 利用率。这种方法证明了相对于现有系统的巨大性能提升,在各种工作负载场景下实现了更高的吞吐量和更好的 SLO 达成率。MuxServe 能够适应不同的 LLM 大小和请求模式,使其成为满足 LLM 部署不断增长的需求的多功能解决方案。随着 AI 行业的不断发展,MuxServe 为高效且可扩展的 LLM 服务提供了一个很有前景的框架。