Runway Gen3,在模型质量上,还是能把Luma和可灵拉开一些差距,特别是审美上。虽然也就是70分跟60分的区别,但至少,在模型质量上,确实是我认为的当今No.1。

不过,现在只上了文生视频,图生和那些可控工具还没上。

给我急急急急急急急急急急急急急急急急死了。

在我跟坤哥瞎吉尔一顿跑了快100个case之后,我决定还是偏系统性的测一下,这个系统只是比瞎跑系统一点,肯定比不过南洋理工或者上海人工智能实验室那种专业级别的测试,所以别杠我,杠就是你对= =

测试的构筑方法上,其实我之前想了蛮久的,去年我其实规划过一版测试维度,大类上有语义理解、画面细节质量、运动质量、镜头移动质量、一致性、衰减性等等。

然后比如在运动幅度上,又可以拆为:人脸五官运动质量、人物肢体运动质量、动物运动质量、刚体运动质量、流体运动质量等等。。。

写完以后我就觉得太特么扯淡了,不是这个划分扯淡,是我的人力有点扯淡。真要这么跑一遍,那我就好几天啥事都不用干了。。。

所以现在,为了达到成本与效率最优解,我就非常简单粗浅的,按风格去划分,分为:

写实风格、动画风格、科幻风格、玄幻风格、抽象风格。

每个风格里面跑10~15个prompt,每个prompt roll三遍,虽然只有文生视频,但其实也基本能看出来模型整体质量和特征了。

而写prompt这活,当然是交给AI去干了。

毕竟有公式可以套:

Prompt = 镜头语言+光影+主体描述+主体运动+场景+氛围。

然后我就让GPT根据公式和规则,给我哐哐哐的写了几吨的prompt。

再把这些prompt,扔到gen3里面跑case。

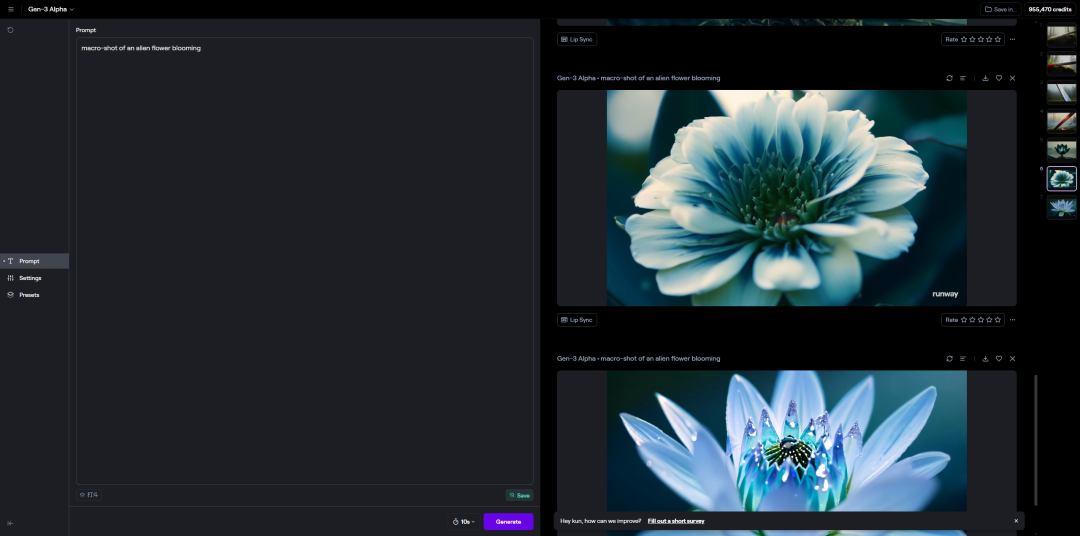

目前只能用文生视频,其他的功能都还没上。在最下面可以切换生成视频的片段长度,可选5s和10s两种。

生成速度非常的快,亲测10s的基本也就1分半就能跑出来,这个可比Luma好多了,那玩意动不动十几分钟。。。

所有的case,我也都放到飞书文档里,有兴趣想全看一遍的,对着我公众号关注后在后台私信"gen3"就能拿到链接了。

而文章碍于篇幅,我就每个风格,展示5个有代表性的case,让大家一睹为快。

(注:在gen3中生成视频我使用的都是英文,下面的是为了方便大家看所以所有prompt才都翻译成了中文)

这个问题就非常多了,肢体变形,人物消失,穿过了明明在远方的杆子,摩天大楼的细节也有问题。

3.低角度镜头,戏剧性的侧面光,一位专业厨师在繁忙的厨房里切菜,周围蒸汽弥漫,锅碗瓢盆悬挂,氛围紧张而专注。

地狱难度,涉及到切菜也就是人、刀、菜的三者交互,所以基本都跟魔法一样,不能看。

4.倾斜镜头,傍晚的街灯,一位音乐家在繁华的街角弹吉他,行人匆匆而过,商店门面上明亮的霓虹灯,氛围热闹而充满活力。

算是很能夸的一个镜头了,人物主体是非常稳定的。但是背景过于复杂,很明显的BUG就是刚开始的车开过去的时候,有个粉衣服的人是跟车合为一体的。。。

5.极限特写镜头,自然光线,一位画家的手在调色板上混合颜色,背景是画布和画架,手指上沾有颜料,氛围专注而富有创造力。

很棒的一个镜头。是能明显的感受到有因果关系的,手和笔会影响颜料,还有粘连的效果。虽然肯定没法跟现实世界比,但是已经很不错了。

总结:写实风格整体看,还是人物特写和风景最稳,一旦涉及到全景或者中景,当人物没有足够的面积空间时,肢体变形就极为严重,但是如果不涉及到人物与物体的交互,那稳定性还是非常强的。

而Runway有一说一,在光影的审美上,是真的强。毕竟电影出身,审美是真舒服。

风格倒是正常,樱花飘的也很好看,就是人物动态太少,跟写实比差太多了,基本没有任何表演可言。

2.中景镜头,夕阳余晖,一位未来派机器人和一个人类女孩,3D动画风格,走在霓虹灯闪烁的街道上,周围是全息标志和飞行汽车,城市景观中高耸的建筑,氛围鲜活且高科技。

我真不是故意吓大家才把这个传上来的,是他真的BUG的有特点,因为我跑出来好多前后不分的视频,这个就是典型代表。。。

3.高角度镜头,明亮的正午阳光,一群充满活力的玩具复活,皮克斯风格,在一个孩子色彩缤纷的卧室里,玩具车和动作人物四处移动,氛围愉快且充满活力。

奇奇怪怪的镜头,风格也不是皮克斯的典型风格,物体也都是莫名其妙的出来,最后小熊突然变成积木飞了那一瞬间我是真没绷住。

4.跟踪镜头,柔和的黄昏光,一位勇敢的少女战士,手持发光的剑,幻想动漫风格,跑过一片迷人的森林,周围是神话生物和古老遗迹,氛围史诗且冒险。

除了手上那把剑不知道是个什么玩意,也没有神话生物和古老遗迹啥的,都挺好。

5.越肩镜头,昏暗的室内灯光,一位年轻的巫师手持魔法书,中世纪动漫风格,在宏伟的图书馆中施法,书架上摆满了古老的书籍和魔法神器,氛围神秘且魔幻。

最后的那一下特效帅炸了,就是人物的脸变形了,从一个异瞳萌妹不知道是个什么玩意,而且也不是越肩视角,不过越肩视角这个就不强求了,没几个能画出来的。

总结:动画风格整体化上,其实都挺差劲的,吉卜力、3D、美漫啥的效果表现都极差,整体审美、物理动态也比写实差很多,明显感受到了数据集的不足,runway整体还是非常的偏写实和电影的。

我是有多想不开才会让AI给我跑变形金刚。但是他居然变了出来,虽然整体都很奇怪,但是至少是变了,这个prompt理解是猛的。。。

2.中景镜头,鲜艳的蓝色和银色调,两台机甲陷入史诗般的战斗,迅速交换打击并发射能量武器,四周是烟雾和爆炸的破坏性城市战场,氛围充满动感和动作感。

真的,帅炸了,我爱惨了,这打架是正儿八经会打起来的啊,真的会爆炸啊!科幻还是得runway啊!

3.跟踪镜头,昏暗的走廊,一群太空海军陆战队小心翼翼地穿过废弃的飞船,灯光闪烁和诡异的声音,氛围紧张且悬疑。

整体都很稳,氛围和质感也无敌,就是有个人出BUG卡门里了。。。

4.广角镜头,旋转的五彩斑斓的漩涡,一个流线型的时间旅行飞船快速穿过隧道,周围是光线和能量轨迹,氛围令人兴奋且超凡脱俗。

这种大特写,必然稳定的一笔,人物还有眼球表演,只能说,牛逼。

总结:没啥可说的,在科幻领域上,runway就是No.1,其他都得靠边站。我的新片子,已经开始准备了,有点兴奋的睡不着觉了。

所有的一切都很稳,除了只有三根手指,否则就是完美的。

2.越肩镜头,昏暗的火炬光,一个盗贼在黑暗地牢里撬开一扇巨大的华丽门锁,周围是古老的符号和蜘蛛网,氛围紧张且秘密。

很有趣的一个是人走过火的时候,手上真的有东西被点着了。当然BUG问题很大,门最后变成了现代门。而且顶上出来了游戏的方位条,感觉是扒了刺客信条的数据集。

3.广角镜头,月光之夜,一个覆盖着发光符文的巨型石像从密林中出现,树木摇晃,脚下的地面开裂,背景是古老的遗迹,氛围神秘且不祥。

有一种憨批巨像的即视感,除了人物丑,没啥其他的问题。

4.倾斜镜头,月光之夜,一群精灵在神圣的树林中进行仪式,发光的符文和魔法能量在他们周围旋转,古老的树木和星空,氛围神秘且敬畏。

雕像造型上非常克苏鲁魔幻的一段,最后的光效非常华丽,runway不愧是电影出身,这小特效做得一个比一个顶。

5.广角镜头,梦幻般的灯光,一座古老的城堡坐落在悬崖上,周围环绕着旋转的雾气,天空中一条龙翱翔,中世纪幻想风格,氛围壮丽且神秘。

龙的画面面积太小了,所以还是那个问题,风控变形,其他都很准,也很理解语义。

总结:玄幻相比之下,没有runway的科幻那么长板,还是会弱一些,适合做西方玄幻,中国玄幻不好测,等出图生视频了再测,效果不一定有可灵强。

这就是艺术,没啥可说的,最后有点不稳了。

3.摇摄镜头,明亮的彩色粒子旋转并汇聚成抽象的形态,营造出一种生动的运动和兴奋感。

想起了我以前用C4D做的粒子效果,妈的辛辛苦苦渲半天,还真不如这个。。。

4.跟踪镜头,流动的金属表面反射环境光,形状在移动中拉伸和弯曲,营造出一种未来主义的超现实感。

液体金属质感无敌,这以后谁尼玛还做特效啊= =

5.广角镜头,鲜艳颜色的渐变平滑融合,重叠的半透明几何图形缓慢旋转,营造出一种平静和流动的感觉。

无敌,这颜色渐变,再调调能追上苹果了。。。

总结:gen3的抽象艺术,是我完全没想到能做到这么好的程度,对AE包装这块的冲击可能会有点大,这种特效以后都不用做了,AI直出。。。